简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

Dify v1.11.0通过多模态知识库打破文本边界,GraphEngine计算引擎提升性能80%,修复SQL注入和XSS等高危漏洞,重构模型适配层支持80+种模型。此次更新标志着Dify从工具集向企业级应用引擎转型,为开发者提供构建生产级多模态应用的完整工具箱,降低AI落地合规风险。

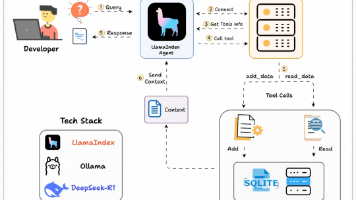

本文介绍了9个基于MCP协议的AI应用实践项目,包括本地MCP客户端、Agentic RAG系统、财务分析师、语音Agent等。这些项目展示了如何利用MCP连接各种工具和数据源,构建本地化、功能强大的AI应用,涵盖从数据处理到深度搜索的多个场景,适合个人开发者和小企业参考实践。

花了60天整理的大模型面试八股文,178页,从基础面,到进阶、LangChain、Agent、微调,以及大模型LLM面试常考题,完整总结,现在无偿分享给大家!!

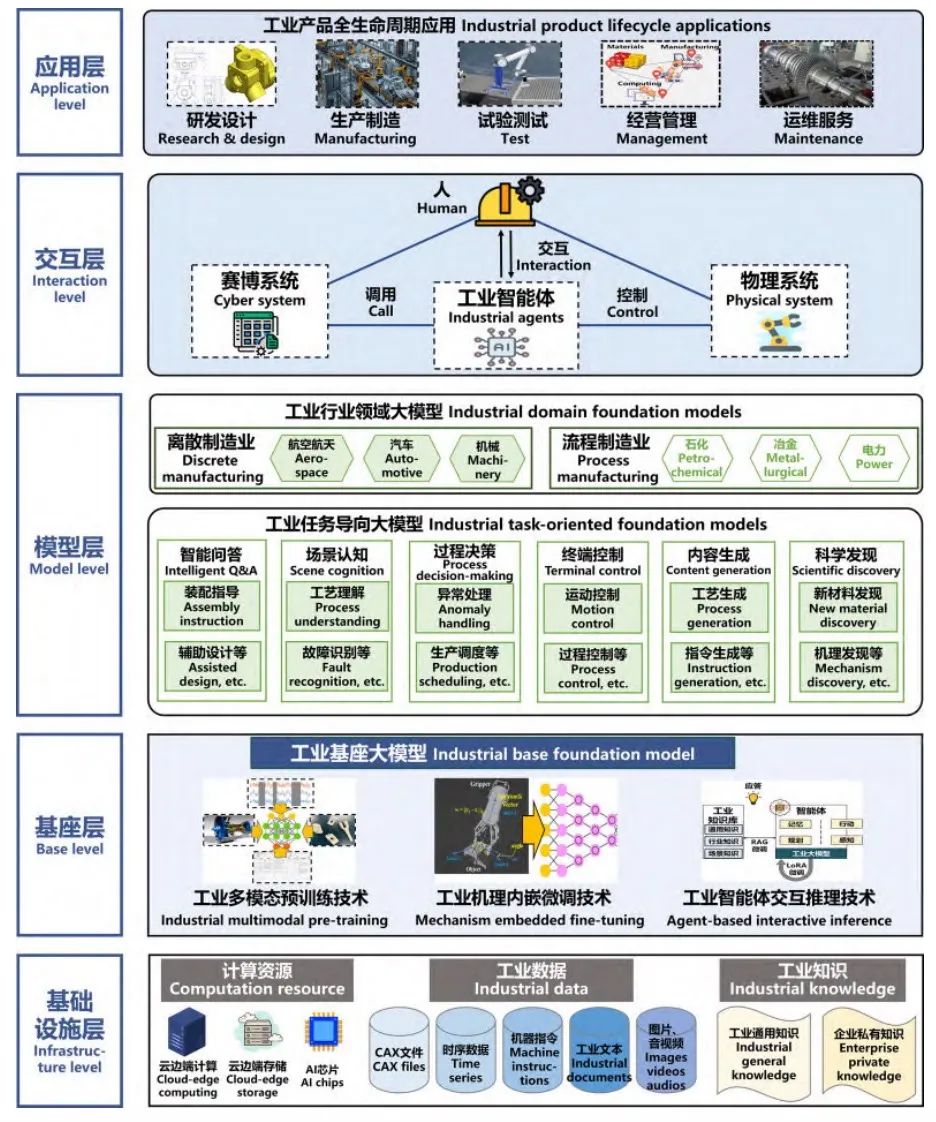

近年来,大模型(如 GPT-4o 等)凭借大规模训练数据、大规模参数、大规模算力,涌现出传统 AI 模型所不具备的强大生成能力、泛化能力和交互能力。在自然语言处理领域,大模型能够生成高质量的文本并完成复杂的对话任务;在计算机视觉领域,大模型能够实现精准的图像识别并生成高保真的图像或视频。此外,大模型还在医学、教育等专业领域展现出巨大的应用潜力,通过对领域数据的学习,提供准确的问答、诊断、预测和决策

大模型在当今人工智能领域占据着核心地位,其强大的能力正不断推动各行业的变革与创新。无论是对人工智能充满好奇的初学者,还是希望在该领域深入发展的专业人士,掌握大模型相关知识和技能都至关重要。以下为你详细介绍 2025 年从零基础入门到精通大模型的学习路线。

文章探讨了AI教育产品的五大价值破局点:学习科学理论可视化、个性化学习、知识通俗化、教育资源普惠化、教师角色转型。同时提出五大落地避坑指南:警惕AI幻觉、保障数据安全、避免思维退化、重构评估体系、防止二次数字鸿沟。核心观点是AI应作为"新自行车"辅助而非替代人类教育,通过人机协同模式,提升教育效率的同时培养人的批判性思维和创造力,最终实现技术服务于人的成长的教育本质。

本文详细介绍了11种大模型参数高效微调方法,包括前缀调优、提示调优、P-Tuning v2、LORA及其衍生方法(DyLORA、AdaLORA)、QLORA、OA-LORA、LongLORA、VeRA和S-LORA。这些方法通过冻结预训练模型参数,仅优化少量特定参数,显著减少计算和存储资源消耗,同时保持模型性能,为不同规模和应用场景的模型微调提供了多样化的解决方案。

文章阐述了大模型面临的三大痛点:知识脱节、幻觉难消、成本失控,指出单纯增加参数已无法解决这些问题。RAG技术通过检索增强生成解决知识来源问题,MoE技术通过混合专家模型实现能力扩展而不爆算力。两者结合形成天然组合,使大模型从"会说话"升级为"能干活",并成为Agent技术的基础。未来大模型的竞争将从参数规模转向系统架构。

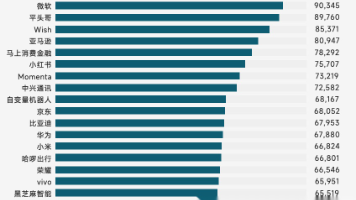

2025年的程序员招聘市场,正在上演一场比剧本更魔幻的现实。成都某公司的招聘启事上写着 “会调教AI写Java代码者优先” ,深圳科技园出现了按小时结算的“程序员灵活用工中心”。脉脉发布的《2025年度人才迁徙报告》显示,高薪岗位TOP20的平均月薪均超过6万元,其中AI研发岗占据大半,同时AI科学家/负责人岗位以平均月薪127225元位居榜首。而另一边,初级Java开发岗位的薪资已从2023年的

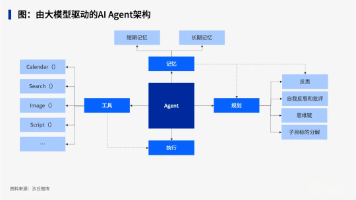

本文分析了AI Agent在企业落地中的三大困境:模型本身问题、工程化难度被低估、安全合规要求高。提出破局之道不是打造更聪明的通用Agent,而是构建工程化完备、业务深度融合、具备企业级安全能力的Agent平台。以金蝶苍穹Agent平台为例,介绍了其内置业务模板、开放技术标准、私有化部署和安全管控等解决方案,指出通用与企业级Agent面向不同需求,未来企业级平台在Agent协同中将发挥更大价值。