简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。作为一名热心肠的互联网老兵,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解

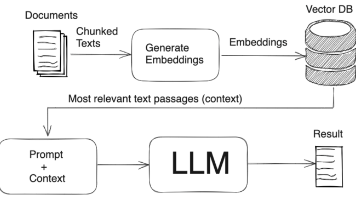

所以笔者认为,应该是it或者业务部门构建企业的数据集后,先embdding到向量数据库内,在给大模型的提示中,写明,让大模型根据检索数据回答。

大模型的本地加载和提供API接口已经完成了,接下来就是embedding 数据库了,请看RAG项目第二集:知识图谱embeddings向量数据库。

在大模型落地的众多路径中,RAG(检索增强生成)是几乎“最值得掌握”的一项技术。它将知识库与大模型结合,让模型不仅“知道”,还能“答得准、说得清”。

GLM-4-9B 是智谱 AI 推出的最新一代预训练模型 GLM-4 系列中的开源版本。在语义、数学、推理、代码和知识等多方面的数据集测评中, GLM-4-9B 在各项能力上均表现出卓越的能力。

在本文中,我们对DMs的安全性进行了全面的综述,重点关注针对DMs的各种攻击和防御方法。

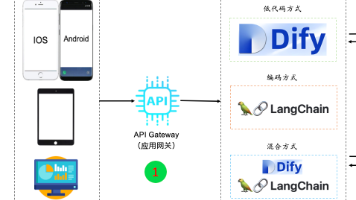

多数场景下,企业开发AI应用常面临:接入或扩展企业已有业务系统并加入AI功能;接入三方系统或AI应用;从0构建AI应用并接入已有业务数据。

本篇分享笔者将深入对比当前最流行的10大Agent开发框架,从核心特性到适用场景,为大家梳理清晰的学习路径和选型指南!

不同于传统软件开发通过编程与算法构建的确定性逻辑,AI 时代的应用构建以面对自然语言编程、上下文工程为核心特征,将复杂业务逻辑与决策过程下沉至模型推理环节,从而实现业务的智能化自适应。

LlamaIndex 中接口基本上调用的是 OpenAI,如果想想调用自定义模型可以吗?答案当然是可以的。经过查找找到了自定义大语言模型的简单抽象基类 class CustomLLM(LLM)。