简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

pytorch分布式训练卡住,显卡占用100

pytorch分布式训练卡住,显卡占用100

qemu-system-aarch64开启user用户模式网络连接

编译qemu源码实现虚拟机开启user用户模式网络连接

ffmpeg将多个yuv文件编码为MP4视频文件

ffmpeg将多个yuv文件编码为MP4视频文件

编译支持 RKmpp 和 RGA 的 ffmpeg 源码

编译支持RKmpp和RGA的ffmpeg源码

移远通信SC200L芯片Linux平台摄像头应用开发

移远通信SC200L芯片Linux平台摄像头应用开发

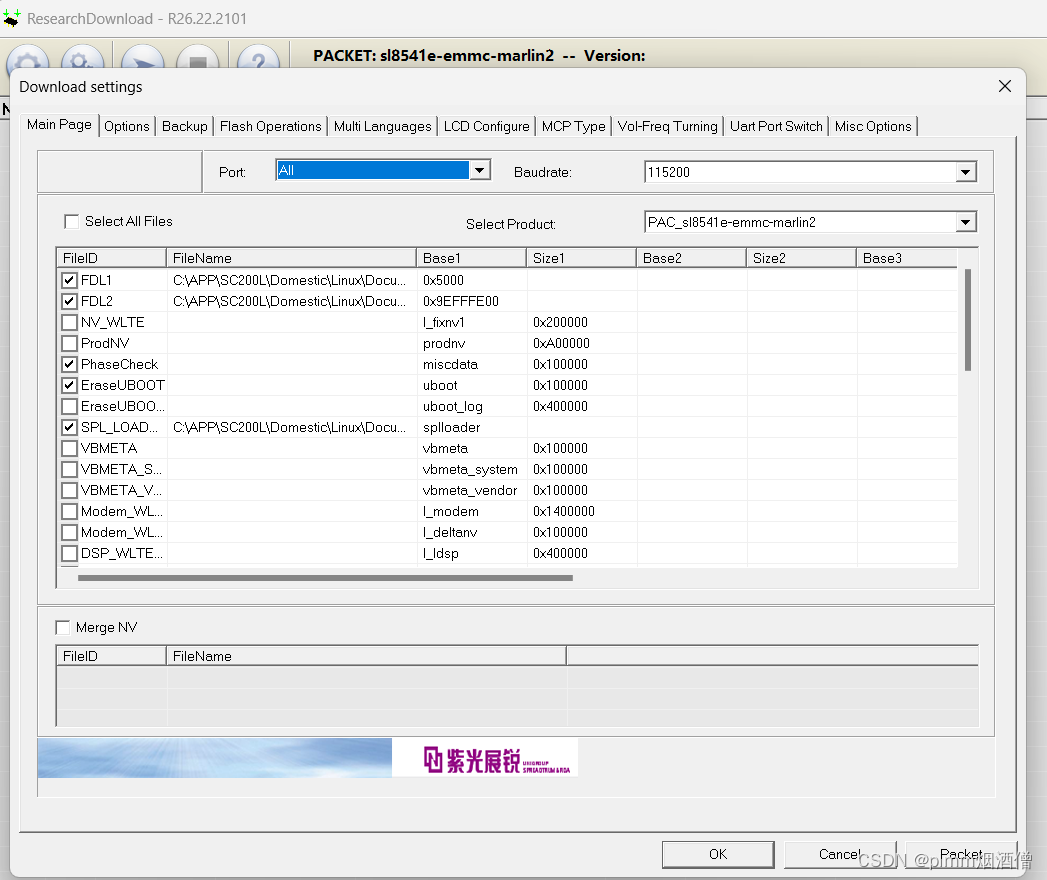

移远通信SC200L(紫光展锐sl8541e)芯片进入烧录模式

移远通信SC200L(紫光展锐sl8541e)芯片进入烧录模式

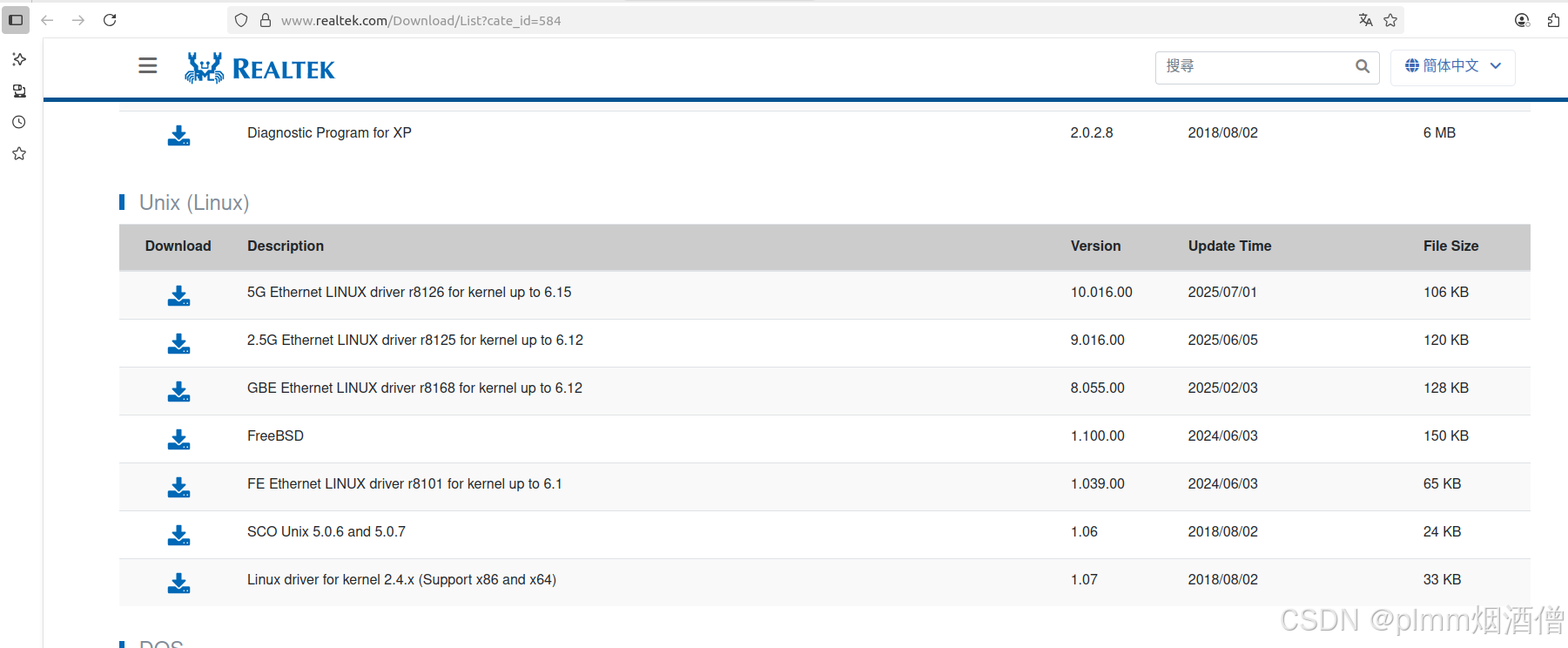

ubuntu 安装 RTL8192EU 驱动报错 Unknown symbol in module, or unknown parameter (see dmesg)

摘要:服务器升级内核后出现有线网卡和USB无线网卡驱动问题。有线网卡通过官方脚本快速解决,但无线网卡驱动安装持续报错。经排查发现缺少cfg80211模块依赖,安装linux-modules-extra包后问题解决。文章记录了这一故障排除过程,提醒注意内核升级时的模块依赖问题。

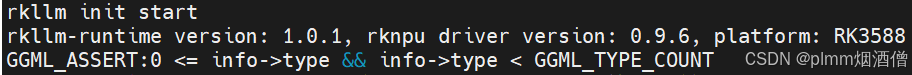

RKLLM大模型部署,没有输出的问题

RKLLM大模型部署,没有输出的问题

《微信小程序demo开发》第二部分-基于云函数的邮箱发送

本文介绍了微信小程序开发中使用云函数和SMTP发送邮件的完整流程。首先需在微信公众平台注册账号并完成小程序备案,然后创建云函数模板工程,配置云开发环境。通过Node.js环境安装nodemailer包实现邮件发送功能,详细说明了SMTP服务开启和授权码获取方法。接着编写云函数代码并上传至云端,更新表单JS逻辑实现邮件内容提交。最后将代码上传至管理平台等待审核上线。文章为小程序开发者提供了从云函数配

FFmpeg链接时报错 undefined reference to av_frame_free

FFmpeg链接时报错 undefined reference to av_frame_free