简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

环境信息:Hadoop 2.7.2+HBase 1.2.2现象:下午前端的同事使用scan查询HBase数据,代码执行到Table.getScanner(scan)方法时卡住了,无法返回结果直到超时,查看控制台,出现如下报错:java.lang.NoClassDefFoundError:org.apache.hadoop.hbase.util.ByteStringer问题分析:...

说到HBase数据压缩,在HBase中有两种方式可以达到该目的,一个就是column family的compress,HBase支持none/snappy/lzo/lz4/gz等几种压缩方式来压缩数据,最后降低数据总量的大小;另一个是data block 的encoding,通过对data block中的KeyValue中key的相同部分进行处理来减少存储的占用,目前支持prefix/diff/f

前言随着大数据和人工智能行业的发展与成熟,各个行业各种业务场景下OLAP(联机分析处理)的需求越来越强;人工智能中的NLP(自然语言识别)的发展为文本分析以及全文检索带上了一个新的台阶,在这种背景下,作为上述两种需求的集大成者的elasticsearch的应用越来越广泛,elasticsearch中存储的数据也越来越多,在elasticsearch给我们带来很多便利的同时也带来了很多问题:查询数据

环境信息:CentOS 6.5现象:同事启动程序发现端口被占用,netstat查看之后发现如下现象:发现端口处于FIN_WAIT1状态以及CLOSE_WAIT状态,无法释放问题分析:FIN_WAIT1以及CLOSE_WAIT状态的原理以及产生的原因大家自行baidu,下面就说下怎么解决上述问题,释放端口FIN_WAIT1:1、sysctl -a |grep tc...

需求来源:客户现场redis内存飙升,由于无法远程连接客户现场环境,进而分析redis的内存中占用较大的key,无法进行问题精确定位,所以需要一个组件或者方法来查看redis内存占用大的key的列表,进而定位问题解决方案:依赖:redis持久化的rdb文件,以及开源的Redis Data Reveal(rdr)组件rdb文件:该文件有两个来源:redis配置的持久化策略,定期会生成一个rdb文件,

原文链接:https://blog.csdn.net/AaronLau_love/article/details/72864963 左侧栏,我的计算机,选择需要克隆的虚拟机,右键,管理->克隆点击下一步,选择虚拟机中的当前状态(如果有快照也可选择快照,方法是右键虚拟机,快照->拍摄快照),下一步,选择创建完整克隆(克隆一份独立的系统出来,需要较大的系统空间),填写虚拟机

前言说到elasticsearch,大家第一反应就是他是一款NOSQL数据库,既然是NOSQL数据库,则生产环境上必定是集群,由很多台服务器共同搭建而成。按照常理,分布式集群从搭建模式上分为中心化模式,即有主节点和从节点之分,即部分节点有成为主节点的资格,其余节点则只能是从节点,如Hadoop,HBase;另外一种模式是去中心化模式,即所有节点的角色都一样,任何一个节点都有可能成为主节点,如Zoo

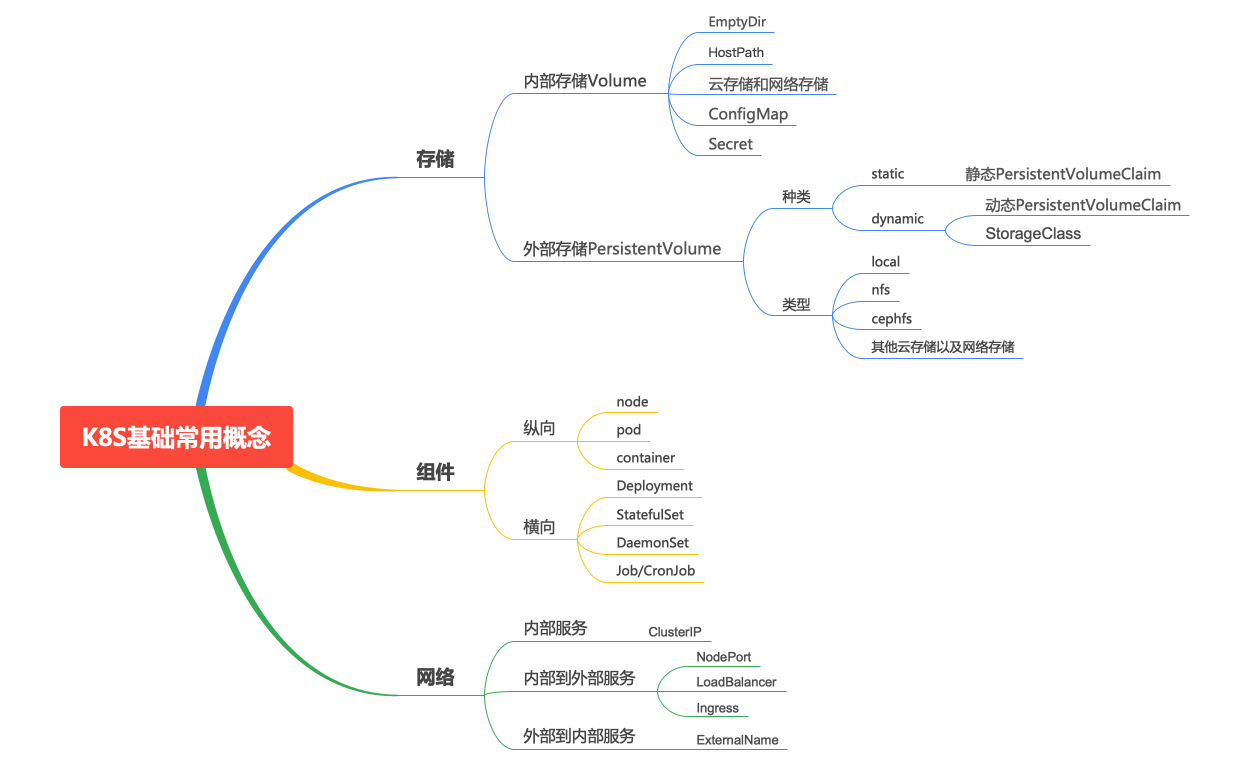

前言在刚开始接触到K8S的时候,曾经遇到了一个卡住我两天的一个问题,情况就是我要创建一个三节点的zookeeper,但是创建后发现只有两个节点能够正常调度,有一个节点总是无法调度,如下图所示:当时一直通过日志想了解到底是哪里的问题,结果后来经高人指点才知道是K8S的亲和性以及污点造成的。具体的原因是zookeeper的yaml文件中由于亲和性的配置,导致zookeeper的实例一个节点上只能有一个

前言久闻K8S大名,受限于docker知识的欠缺,所以对K8S的探索一直处于逡巡不前的状态,这一拖就是好久,最近这段时间公司准备上K8S集群了,我被安排来负责这件事情的推进。终于有幸可以真正学习下K8S,一睹K8S的芳容了。由于之前缺乏必要的docker相关知识的储备,加上K8S本身内容复杂庞大,所以在学习的过程中费了很大的劲,走了很多弯路才勉强将基本流程搞通,能跑起来一整套服务,下面就根据我的学

Sealos 是一个 Go 语言开发的简单干净且轻量的 K8S 集群部署工具,Sealos 能很好的支持在生产环境中部署高可用的 K8S 集群。以上就是我这次去客户现场操作生产环境 K8S 的一点心得和经验,后续有新的内容我还会继续分享。这次的经历再次印证了只有在生产环境下真实的分析和解决问题,才会更深刻的学习知识并积累相关的经验。文章到这里就结束了,最后路漫漫其修远兮,大数据之路还很漫长。