简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

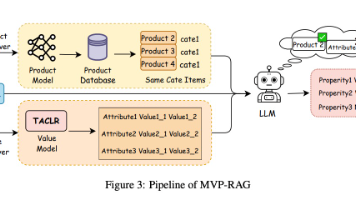

本文提出MVP-RAG框架,创新性地融合多级检索与生成技术,显著提升电商属性识别的准确率与泛化能力。实验表明,该方法在工业级数据集上F1值达92.1%,较基线模型提升15.8%,尤其对OOD属性识别率提升20%。该技术已成功部署于闲鱼平台,每日处理千万级商品属性提取任务,为电商AI领域提供了可复用的技术范式。

你是不是是不是也遇到经历过这种崩溃时刻:让大模型写份报告,结果引用了不存在的研究;用RAG做知识库问答,答案驴唇不对马嘴;辛辛苦苦标注的数据,训练出的模型却频频"幻觉"……现在,这些头疼问题有了新解法——正式开源!这款被业内称为"AI数据质检官"的工具,直接把RAG幻觉检测精度干到94.6%,还能一键搞定50+项数据质量评估指标。

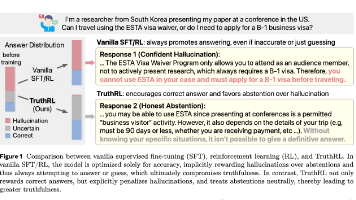

TruthRL:用强化学习打造"知之为知之"的诚实AI 斯坦福团队提出TruthRL框架,通过三元奖励机制革新大型语言模型的真实性优化。该研究突破性地将模型回答分为正确、不确定和错误三类,给予差异化奖励(+1/0/-1),激励模型在知识边界内准确回答,超出范围时诚实弃权。实验表明,该方法在四大知识基准测试中平均降低28.9%的幻觉率,提升21.1%的真实性,且在不同规模模型和检

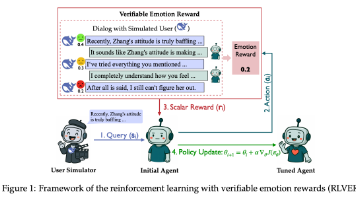

腾讯混元团队提出的RLVER框架首次实现了基于可验证情感奖励的强化学习,将Qwen2.5-7B模型的共情能力从13.3分提升至79.2分(Sentient-Benchmark),性能比肩GPT-4o和Gemini 2.5 Pro等顶级商用模型,同时保持数学和代码能力不衰退。

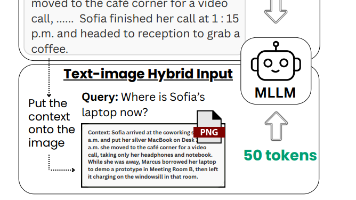

摘要:本文提出一种新颖的文本压缩方法,通过将长文本渲染为图像输入多模态大语言模型(如GPT-4V),显著减少token使用量而不损失性能。实验表明,在RULER长文本检索和CNN/DailyMail摘要任务中,这种"文本即图像"的方法能节省约50%的token,同时保持准确率。该方法无需模型微调,利用视觉编码器将图像转换为高效视觉token,为长文本处理提供了实用解决方案。核心

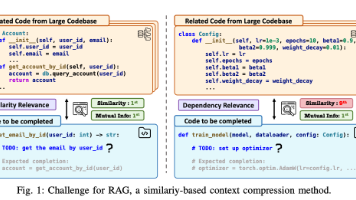

论文标题: LongCodeZip: Compress Long Context for Code Language Models 作者: Yuling Shi, Yichun Qian, Hongyu Zhang 发表年份: 2025 摘要: LongCodeZip提出了一种专为代码大模型设计的双阶段压缩框架,有效解决长代码上下文处理中的计算成本高、关键信息淹没和窗口限制问题。通过粗粒度压缩(函

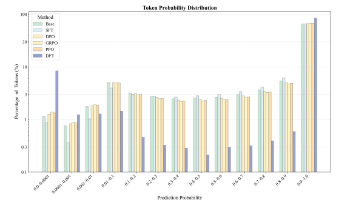

我们提出了一种简单且具理论依据的改进方法——动态微调(DFT),以解决大语言模型监督微调(SFT)在泛化能力上逊于强化学习(RL)的问题。

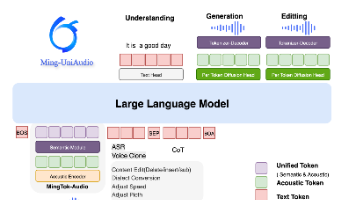

摘要: 开源项目Ming-UniAudio突破AI音频技术壁垒,实现语音识别、合成与自然语言编辑的统一。其核心创新包括:1)首个兼顾理解与生成的Tokenizer(MingTok-Audio),语音质量评分达4.21;2)单一模型支持ASR/TTS任务,方言识别错误率低至9.8%;3)首创自然语言指令编辑功能,可精准修改语音内容。项目提供全流程Demo,支持5分钟快速部署,开发者可通过Huggin

摘要:StreamCap是一款支持40+国内外直播平台的开源录制工具,可自动监控并录制抖音、B站、Twitch等平台的直播内容。该工具操作简单,支持多格式输出、定时录制、消息推送等功能,还能通过Docker部署实现24小时云录制。完全开源免费的特性使其成为留存直播内容的理想解决方案,未来还将加入AI剪辑等进阶功能。 (150字)

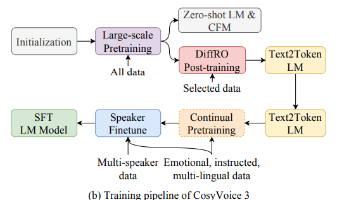

在我们之前的工作中,我们介绍了一个可扩展的流式语音合成模型CosyVoice 2,该模型集成了大型语言模型(LLM)和分块感知流匹配(FM)模型,并实现了低延迟双向流式语音合成和人类水平的质量。尽管取得了这些进展,但CosyVoice 2在语言覆盖范围、领域多样性、数据量、文本格式和后训练技术方面仍存在局限性。