简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

在用DolphinScheduler把mysql中的数据导入到hive中的有关报错

本文针对的错误是(1)用shell设计sqoop脚本把数据从mysql导入到hive和(2)直接用sqoop把数据从mysql导入到hive。

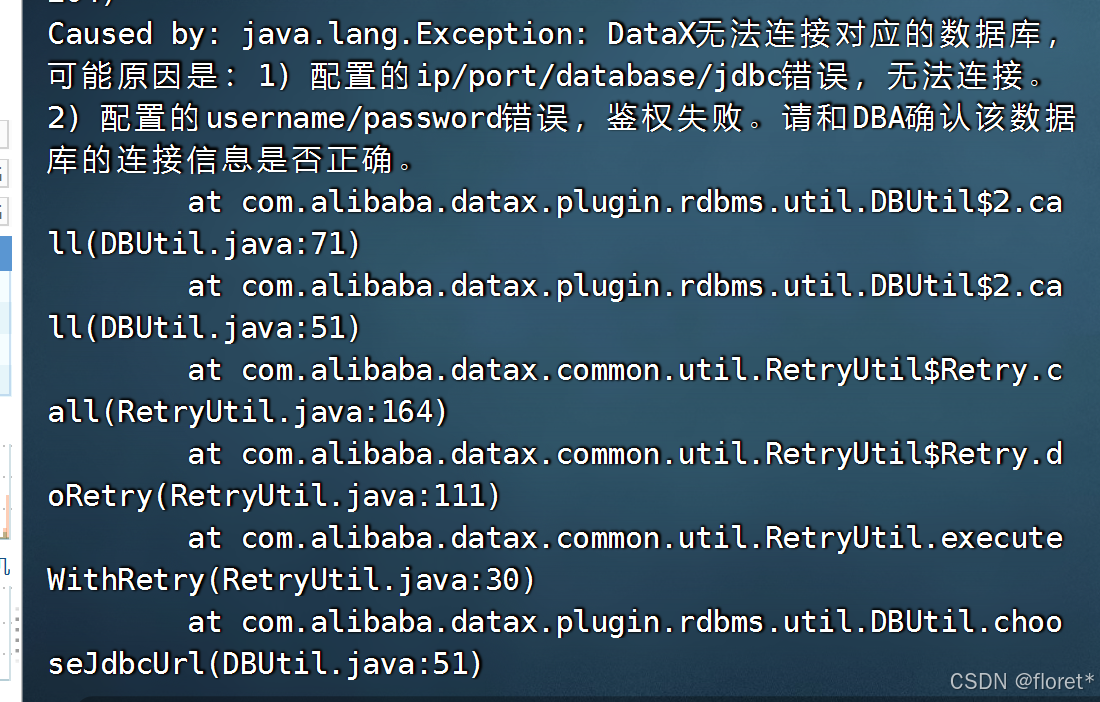

Caused by: java.lang.Exception: DataX无法连接对应的数据库,可能原因是:1) 配置的ip/port/database/jdbc错误,无法连接。2) 配置的usern

用datax把mysql中的数据导入到hive时报如上错误 ,在检查账号密码以及数据库都正确的情况下,仍然报以上错误。拷贝一份mysql的驱动包即可。

阿里云(FAILED: ODPS-0130071:[12,1] Semantic analysis exception - column view_count in source has incom)

可以看出是由于数据类型导致的,这里count之后数据类型为bigint。有两种解决方案,一种是重新建表,数据类型为bigint。另一种是用cast进行数据类型的转换。在执行插入语句时,出现了如下错误。查看我们的建表时数据类型为int。

WARN UnstructuredStorageReaderUtil - 您尝试读取的列越界,源文件该行有 [1] 列,您尝试读取第 [2] 列, 数据详情[2024-09-2426\N\N]2

{"message":"您尝试读取的列越界,源文件该行有 [1] 列,您尝试读取第 [2] 列, 数据详情[2024-09-24\u000126\u0001\\N\u0001\\N]","record":[{"byteSize":19,"index":0,"rawData":"2024-09-24\u000126\u0001\\N\u0001\\N","type":"STRING"}],"type

到底了