简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

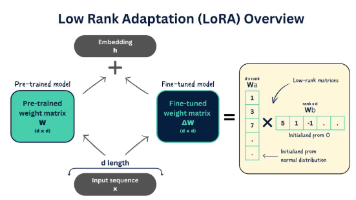

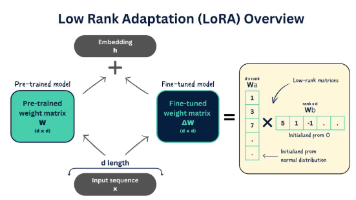

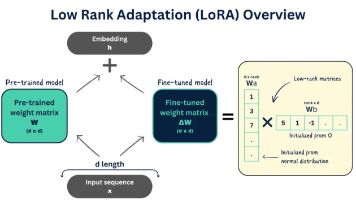

LoRA(低秩适应)是一种高效微调大模型的技术,通过训练少量额外参数(适配器)来赋予大模型新能力,而无需修改原始参数。相比全量微调,LoRA具有显存占用低、训练速度快、存储成本小等优势。技术实现包括冻结原模型、注入低秩矩阵、训练适配器、合并权重等步骤。文章提供了使用LoRA微调千问模型的完整代码流程,涵盖环境准备、数据格式化、参数配置、训练实施等环节,并强调数据质量比数量更重要。该技术特别适合个人

敏感属性分组方式最小样本量要求实际最小样本量性别男 / 女 / 其他≥100男: 7,842女: 7,438年龄组≥100<18: 1,205≥65: 4,203民族汉族 / 少数民族≥50汉族: 13,982少数民族: 1,298医保类型职工医保 / 居民医保 / 自费≥100职工: 8,945居民: 5,234自费: 1,101居住地区城区 / 郊区 / 农村≥100城区: 10,234郊区:

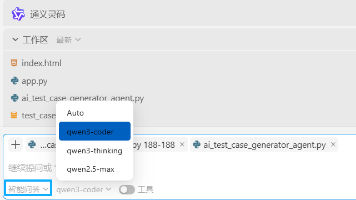

通义灵码提供三种AI交互模式:智能问答(纯咨询)、文件编辑(精准代码修改)和智能体(全自动任务执行)。模型选择建议:Qwen3-Coder专攻代码开发,是智能体模式的核心驱动;Qwen3-Thinking擅长复杂逻辑推理;Qwen2.5-Max作为通用备选。开发者最优组合:日常使用Qwen3-Coder+智能体模式实现端到端开发,精修代码时切换文件编辑模式,解决复杂算法问题则选用Qwen3-Thi

AI偏见指人工智能系统对特定群体(如性别、种族等)产生系统性不公平对待的现象。在医疗领域,AI偏见可能导致诊断不公、治疗延误等严重后果。测试重点在于发现不同群体间的性能差异(如诊断准确率差距14%),而非功能错误。调优流程包括:定位偏见根源(数据/算法/部署层面)、选择策略(数据重采样/公平性约束)、验证效果。推荐使用AIF360、Fairlearn等工具进行偏见检测和修正。医疗AI测试工程师需平

AI偏见是指人工智能系统在决策过程中对特定群体(如性别、种族、年龄等)产生系统性不公平对待的现象。测试工程师需重点关注四大偏见类型:数据偏见、算法偏见、部署偏见和交互偏见。测试方法包括群体公平性测试、对抗样本测试和影子测试,核心指标需监控统计均等性、机会均等性等差异是否超过5%阈值。企业应建立完整的AI偏见测试流程,从需求分析到持续监控。测试工程师凭借用户视角和系统思维优势,在AI伦理测试领域具有

LoRA(低秩适应)是一种高效微调大模型的技术,通过训练少量额外参数(适配器)来赋予大模型新能力,而无需修改原始参数。相比全量微调,LoRA具有显存占用低、训练速度快、存储成本小等优势。技术实现包括冻结原模型、注入低秩矩阵、训练适配器、合并权重等步骤。文章提供了使用LoRA微调千问模型的完整代码流程,涵盖环境准备、数据格式化、参数配置、训练实施等环节,并强调数据质量比数量更重要。该技术特别适合个人

LoRA(低秩适应)是一种高效微调大模型的技术,通过训练少量适配器参数实现模型定制,无需修改原模型。与QLoRA(量化版LoRA)相比,LoRA显存占用中等、训练较快,QLoRA通过4-bit量化显著节省显存但速度略慢。HuggingFace的peft库集成了LoRA技术,提供便捷的微调工具。对千问模型微调时,需配置LoRA参数(如秩r)、准备数据,并使用Trainer进行训练。训练后可合并适配器

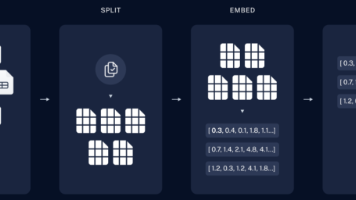

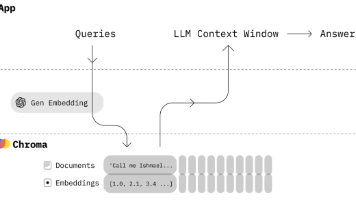

摘要:本文介绍了一种结合本地ChromaDB和千问(Qwen)模型的RAG(检索增强生成)技术方案,用于精准生成测试用例。该系统分为知识准备和用例生成两个阶段:首先将项目文档分割、向量化后存入ChromaDB;当用户提出需求时,系统先检索相关文档片段,再结合千问模型生成符合业务规则的测试用例。该方法有效解决了大模型的"幻觉"问题,确保测试用例基于最新业务逻辑。文中还提供了核心实

本文提出一个基于RAG架构的个人知识库问答系统方案。系统包含知识库构建和智能问答两个阶段:在构建阶段,使用LangChain加载各类文档,通过文本分块(推荐500字符大小)和开源中文嵌入模型(如BAAI/bge-small-zh)将文档转化为向量存入ChromaDB;在问答阶段,结合语义检索和LLM生成答案,支持多路召回和结果重排序优化检索效果。文章强调合理设置分块大小、选择适配中文的嵌入模型以及

ChromaDB是一款专为AI应用设计的开源向量数据库,通过简单API实现语义搜索功能。其核心特点包括:1)存储高维向量而非结构化数据;2)基于相似性搜索而非精确匹配;3)擅长处理非结构化数据。架构包含客户端、集合(类似表)、向量、文档和元数据等核心组件。使用时需注意:选择适合的嵌入模型、合理设计元数据、采用持久化存储模式。典型应用场景包括RAG系统、智能推荐等,能有效提升AI应用的语义理解能力。