简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

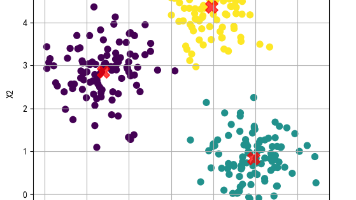

K-means是一种经典的无监督聚类算法,通过迭代优化将数据划分为K个簇,使簇内样本相似度高。算法流程包括初始化中心点、样本分配、中心点更新等步骤,目标是最小化簇内平方误差。其优点是简单高效,但对初始中心敏感且需预设K值。文章通过Python代码演示了K-means在模拟数据上的应用,包括数据处理、聚类实现和结果可视化,并分析了算法的优缺点。

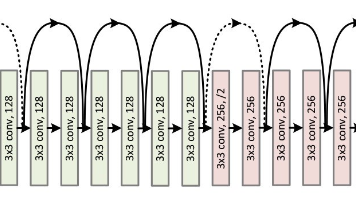

ResNet(Residual Network)由何恺明等人在 2015 年提出,荣获了当年 ImageNet 挑战赛的冠军。其主要创新在于 残差学习(residual learning),通过残差块(residual block)解决了深层网络中梯度消失和退化问题

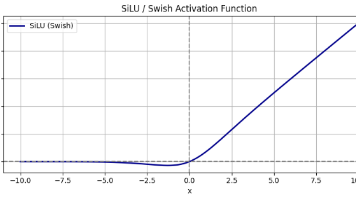

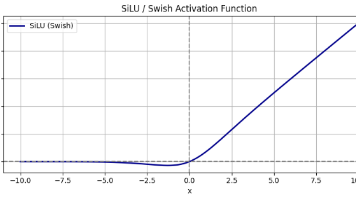

本文总结了当前常见的激活函数,并将其分类为经典基础函数、改进型函数和新一代函数。经典基础函数包括ReLU、Sigmoid、Tanh和Softmax,这些函数在神经网络中广泛应用。改进型函数如LeakyReLU、PReLU和ELU,通过引入参数或调整负值处理方式,解决了经典函数的一些问题。新一代函数如SiLU、Swish、GELU和Mish,具有更平滑的梯度和更强的非线性表达能力,适用于深层网络和复

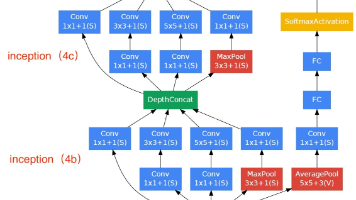

卷积神经网络(CNN)的基础网络架构包括多个经典模型,每个模型都有其独特的特点和应用场景。LeNet-5是最早的卷积网络,适用于轻量设备,但已不常用于目标检测。AlexNet是深度CNN的启蒙,虽然已淘汰,但引入了ReLU激活函数和Dropout正则化等技术。VGG网络结构简单,参数多,常用于目标检测,但不适合轻量设备。GoogLeNet/Inception通过多分支结构实现高效计算,适合目标检测

本文总结了当前常见的激活函数,并将其分类为经典基础函数、改进型函数和新一代函数。经典基础函数包括ReLU、Sigmoid、Tanh和Softmax,这些函数在神经网络中广泛应用。改进型函数如LeakyReLU、PReLU和ELU,通过引入参数或调整负值处理方式,解决了经典函数的一些问题。新一代函数如SiLU、Swish、GELU和Mish,具有更平滑的梯度和更强的非线性表达能力,适用于深层网络和复