简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

李飞飞的World Labs融资2.3亿美元引爆AI圈,世界模型技术成为新风口,谷歌、英伟达等巨头纷纷布局。世界模型通过模拟物理规律和环境变化,赋予AI"脑内推演"能力,区别于传统大模型的数据驱动模式。该技术已在自动驾驶、机器人控制和科研仿真等领域展现潜力。随着AI行业快速发展,预计2025年人才缺口将达1000万,掌握世界模型等前沿技术将成为职业新机遇。

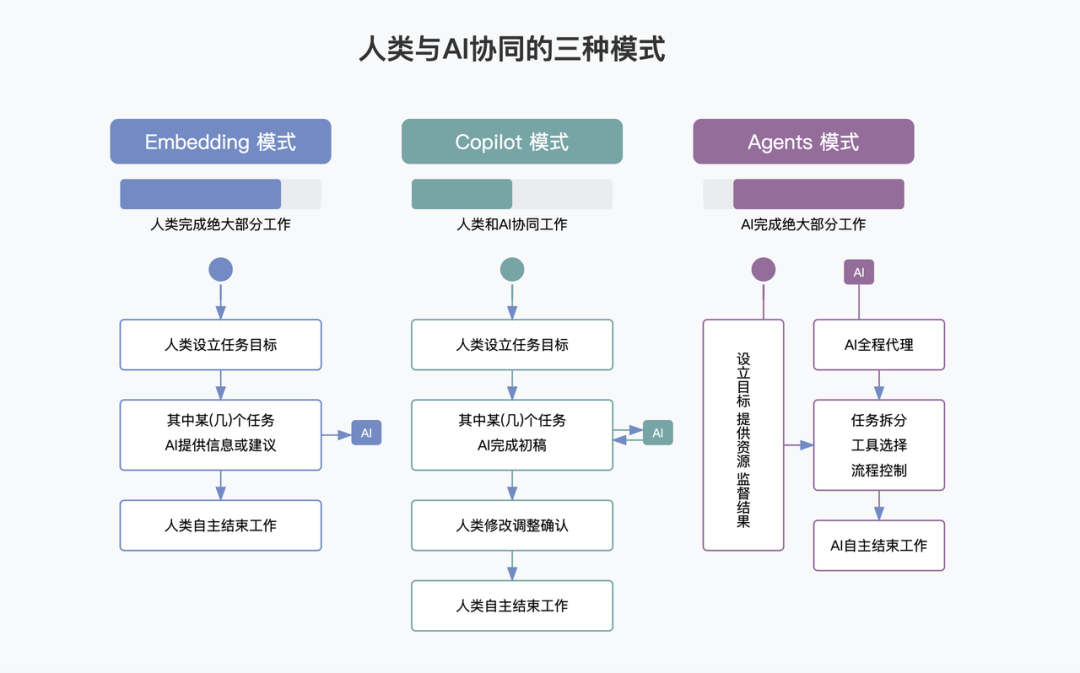

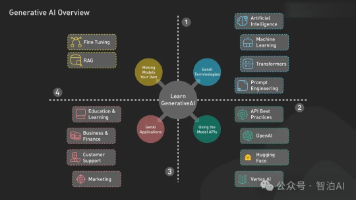

三种模式的变化过程从完全依靠到慢慢放手,这三种模式说明人使用 AI 时想法的改变:**Embedding 模式**:人做主要工作,AI 帮忙(我做你看)**Copilot 模式**:人和 AI 一起做(我们一起做)**Agent 模式**:AI 自己做,人看着(你做我看)这说明 AI 能力变强了,人也更相信 AI 了。从“不敢让 AI 做”到“敢让 AI 做”,这是技术和心理都在进步的结果。

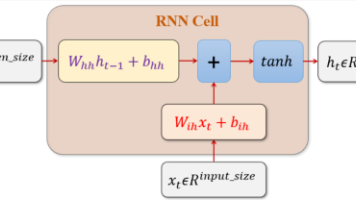

本文系统介绍了循环神经网络(RNN)的核心原理与应用特点。首先对比RNN与传统神经网络的差异,重点阐述RNN通过记忆机制处理时序数据的独特优势,并举例说明其在自然语言处理中的序列建模能力。文章详细解析了RNN模型结构,包括时间展开图、权重参数计算和变长输入处理机制,并延伸介绍双向RNN的改进结构。最后通过心电信号分类实例,演示了RNN参数设置和特征提取过程,为理解LSTM等进阶模型奠定基础。文中还

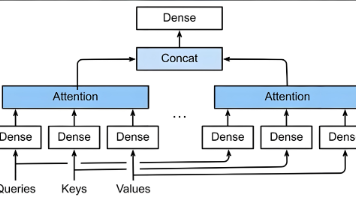

本文介绍了自注意力机制这一神经网络创新架构。首先阐述了其与传统模型的不同之处在于能够捕捉输入序列内部的动态关联。其次详细讲解了两种注意力评分函数(加性注意力和缩放点积注意力)的计算原理及适用场景。最后深入解析了多头注意力机制,说明了其通过多个注意力头并行计算来提取更丰富特征的方法,并提供了完整的PyTorch实现代码。文章还指出AI大模型发展迅速,相关人才缺口巨大,建议读者把握机遇学习这一前沿技术

AI大模型引领技术革命,但因果推理成为关键挑战。文章剖析了人工智能的两大框架:基于关联的模型易受混淆因素干扰,而因果推理框架能更准确揭示变量间真实关系。当前AI发展面临核心矛盾——大数据环境下的不可控数据生成过程与传统因果推理的小数据可控需求。作者提出"识别因果结构-构建因果模型-优化决策机制"的方法体系,并介绍潜在结果框架和功能因果模型等理论工具。随着AI行业人才缺口扩大,掌

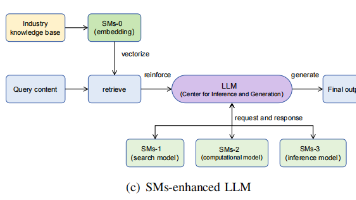

本文提出Sentosa LLM框架,通过融合大模型与小模型的优势解决工业智能维护中的关键挑战。该五层架构整合了大模型的语义理解与小模型的精准计算能力,并创新性地采用中间表征、知识桥接等技术实现高效协同。在通信机房节能与储能电站故障检测两个案例中验证了框架的有效性,显著提升了预测精度与决策可解释性。研究为工业智能维护提供了新的技术路径,推动了该领域向更智能、可靠的方向发展。

欧洲的一些领先公司,如法国的Mistral、德国的Aleph Alpha以及许多其他规模较小的企业,正在以低廉的价格在AI竞赛中崭露头角。“政客”新闻网欧洲版当地时间1月29日指出,有关 DeepSeek 的消息,在欧洲可能意味着完全不同的东西:这是一个可喜的信号,表明欧洲自己的AI产业有机会在全球AI军备竞赛中与美国这样的国家力量相抗衡。DeepSeek发布的大模型DeepSeek-R1,用更低

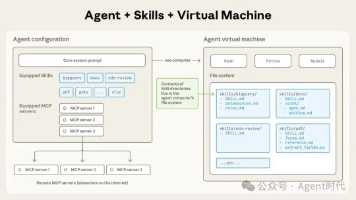

摘要: Anthropic发布Agent Skills开放标准,微软、GitHub等巨头迅速采用,OpenAI也悄然兼容。该标准以模块化文件夹为核心,通过"渐进式披露"机制优化AI能力调用。这是Anthropic三个月内第二次将核心技术开源,延续其通过开放标准构建行业基础设施的战略。当前Anthropic以32%份额领跑企业AI市场,该标准可提升跨平台技能复用性,降低企业AI部

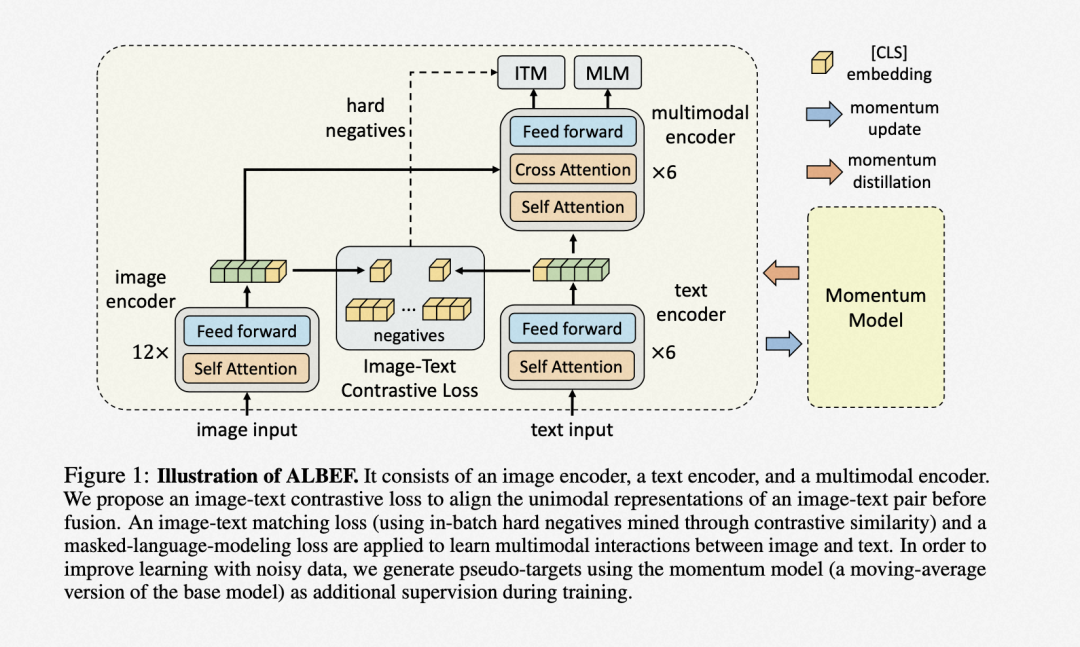

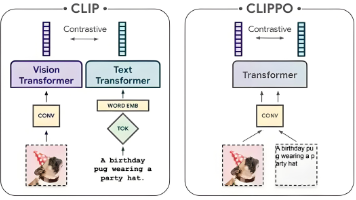

摘要:CLIP是由OpenAI开发的多模态预训练模型,通过对比学习将图像和文本映射到共享的嵌入空间,使语义相近的内容向量距离更近。它由图像编码器(ResNet/ViT)和文本编码器(Transformer)组成,使用InfoNCE损失优化图文匹配。CLIP可直接应用于图文检索、零样本分类,或作为特征提取器支持扩散模型(如Stable Diffusion)和多模态大模型(如LLaVA)。其训练基于4

此外,EVA模型还通过一种名为MaskImage Modeling的任务在更大数据集上进行了训练,它将遮蔽部分的图像与CLIP模型对应位置的输出进行比对,从而在保持语义学习的同时,也能让模型学习到几何结构。在零样本设置中,研究者选择涵盖不同任务的数据集,将其分为保留集(held-in)和留出集(held-out),在前者上进行调整后,在后者上评估模型的零样本性能。典型的多模态大型语言模型(MLLM