简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

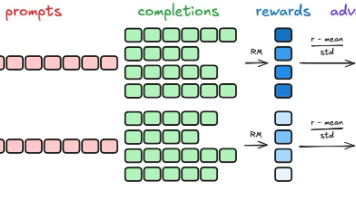

本文介绍了GRPO算法,一种简化版的PPO强化学习算法。文章从强化学习基本概念讲起,详细推导了GRPO的目标函数和优势函数计算方法。GRPO通过简化优势函数计算,保持算法有效性的同时提高了计算效率,更适合作为大模型强化学习的入门算法。

文章探讨Prompt工程向AI素养的演变,强调2026年后关键不是"会用AI",而是能否为选择负责。AI素养包含工具使用、批判性思考和明确价值边界三层。未来Prompt将向角色设计、技能管理、人机共创和组织标准发展。无论技术如何进步,保持清醒思考和对责任的担当是人与AI共存的关键。

本文基于2025年企业级AI落地实践,分析了RAG工程复杂性、本地化部署挑战及AI项目长期维护的特殊性。指出当前国内企业AI仍以Workflow为核心的Copilot形态为主,制约因素不仅在于模型能力,更在于数据分散、组织结构等系统性问题。强调AI不是快速交付的功能,而是需要长期治理的能力系统。

本文详细介绍了利用AI助手(如Codex、ChatGPT)进行零代码开发应用程序的完整工作流。文章以开发简约日程软件为例,阐述了从确定需求与技术栈、规划与Spec、开发与调试到测试与发布的四个关键步骤。特别强调在AI时代,开发者应专注于培养"解决思路"和"宏观架构设计能力",而非单纯编码技术。同时提醒开发者需了解AI Agent的基础知识,如上下文管理和盲区识别,以有效驾驭AI开发工具,提高开发效

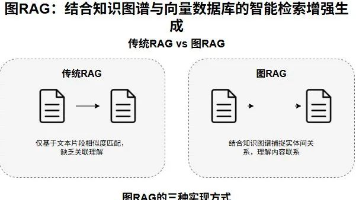

文章介绍图RAG技术如何结合知识图谱与向量数据库提升大模型回答质量。通过电商推荐案例对比三种方法:向量检索部署简单但存在"上下文污染";知识图谱结果可解释但构建复杂;混合方法兼具两者优势,既保证检索速度又提高推荐精度,使AI从"关键词匹配"进化为"智能顾问"。

我整理了一套Android面试题合集,除了以上面试题,还包含【Java 基础、集合、多线程、虚拟机、反射、泛型、并发编程、Android四大组件、异步任务和消息机制、UI绘制、性能调优、SDN、第三方框架、设计模式、Kotlin、计算机网络、系统启动流程、Dart、Flutter、算法和数据结构、NDK、H.264、H.265.音频编解码、FFmpeg、OpenMax、OpenCV、OpenGL

Transformers是一种神经网络架构,广泛应用于自然语言处理NLP任务,如翻译、文本分类和问答系统。它们是在 2017 年发表的开创性论文 "Attention Is All You Need "中引入的。将Transformers想象成一个复杂的语言模型,通过将文本分解成更小的片段并分析它们之间的关系来处理文本。然后,该模型可以对各种查询生成连贯流畅的回复。

为了能够方便大家快速学习Flutter, 这里整理了Flutter学习路线图以及《Flutter Dart 语言编程入门到精通》&《Flutter实战:第二版》帮助大家配置相关环境,学习Flutter 的基本语法以及最后的项目实际利用。Dart语言是Flutter的开发语言,所以我们需要掌握Dart语言的基础知识,由于内容过多,截图展示的目录及部分内容,完整文档领取方式扫描下方二维码即可免费获取!

Retrofit`可以节省老一套网络请求写那么多代码的冗杂为开发者提供了相对简单的请求方案作为安卓目前最流行的网络请求框架,确实名不虚传.

2026年AI行业从狂热转向理性,大模型竞争焦点从参数规模转向推理能力与应用。五大核心趋势:大模型转向更小型专用;智能体爆发(40%企业将嵌入AI员工);世界模型理解物理规律;具身智能进入工业场景;能源瓶颈与治理挑战加剧。从业者面临战略抉择:通用vs垂直,自建vs API,单点突破vs生态布局,这些选择将决定未来竞争位置。