简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

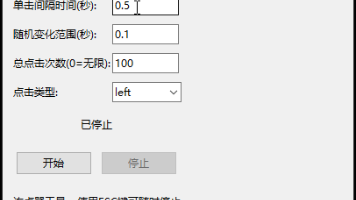

本文介绍了使用DeepSeek开源大模型辅助开发Python连点器的完整流程。首先通过提示词让DeepSeek生成基于tkinter和autopy的GUI连点器代码,具备设置点击间隔、次数、随机变化等功能。然后指导如何用PyInstaller将程序打包为Windows可执行文件,包括配置build.spec文件、安装依赖项、添加图标等步骤。最终生成可独立运行的AutoClicker.exe,无需P

SkCoder通过引入“代码草图”这一中间表示,巧妙地桥接了自然语言需求与最终程序代码之间的鸿沟。其“检索-草图-编辑”的三段式框架,成功模拟了人类开发者“参考、借鉴、修改”的代码复用行为,为数据驱动的自动代码生成提供了新的范式。概念创新:提出了“代码草图”作为代码生成的结构化引导,使生成过程更具可控性和结构性。性能突破:在多个基准上取得了显著的性能提升,证明了该框架的有效性和通用性。启发未来:为

BIG-Bench(Beyond the Imitation Game Benchmark)是一个由谷歌发起的大型社区合作项目,旨在全面评估和推广大规模语言模型的能力边界。该项目历时两年完成,汇集了来自132个机构的442名研究人员,共同创建了包含204项多样化任务的基准测试集。BIG-Bench的命名寓意"超越模仿游戏",不仅是对图灵测试的致敬,更是对语言模型能力评估范畴的大胆拓展,试图突破传统

BigQuery数据集是CodeGen模型训练过程中使用的关键数据源,它包含了从GitHub代码库中提取的大规模多种编程语言数据。具体来说,这个数据集包含1192亿个token,覆盖了C、C++、Go、Java、JavaScript和Python等多种主流编程语言。该数据集在CodeGen训练流程中扮演着承上启下。

WMT2014 全国机器翻译研讨会及其评测任务,不仅是我国机器翻译领域一年一度的学术盛会,更因其高质量的标准数据集而成为了国际机器翻译研究的一个重要里程碑和基准点。它既记录了统计机器翻译方法的成熟与辉煌,也见证了神经网络机器翻译技术的初步崛起和后来的颠覆性突破(如Transformer)。直到今天,WMT2014的数据集仍在被广泛用于评估新模型的能力。可以说,要想了解现代机器翻译的发展历程,WMT

在特定任务微调前,通过海量无标注数据预先训练的基座模型,其目标是学习通用特征表示(如语言规律、视觉结构)。

给定两个非零向量A和BABA⋅B∣A∣∣B∣∑i1nAiBi∑i1nAi2∑i1nBi2AB∣A∣∣B∣A⋅B∑i1nAi2∑i1nBi2∑i1nAiBiA · B表示向量的点积‖A‖和‖B‖表示向量的欧几里得范数(模长)结果范围在[-1, 1]之间。

在当今信息爆炸的时代,视觉丰富文档(Visual-rich Documents)如学术论文、商业报告、技术手册等已成为知识传递的主要载体。这些文档通常包含文字、表格、图表和复杂布局等多种元素,传统的单一模态检索方法难以充分挖掘其价值。面对这一挑战,阿里巴巴通义实验室联合中国科学技术大学和上海交通大学推出了ViDoRAG(Visual Document Retrieval-Augmented Gen

是由普林斯顿大学与北京大学联合研发的创新框架(2025年2月发布),通过与,显著提升大语言模型在复杂推理任务(如数学竞赛)中的性能与效率。。