简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

vLLM深度解析摘要 vLLM是一款专为高性能大模型推理设计的开源引擎,核心采用PagedAttention技术(借鉴操作系统分页思想)优化显存管理,显著提升吞吐量(比HuggingFace快2-24倍)。其特点包括: 连续批处理技术提升GPU利用率 兼容OpenAI API接口 支持主流开源模型 与Ollama对比: vLLM适合企业级高并发场景(需NVIDIA GPU) Ollama更适合个人

vLLM深度解析摘要 vLLM是一款专为高性能大模型推理设计的开源引擎,核心采用PagedAttention技术(借鉴操作系统分页思想)优化显存管理,显著提升吞吐量(比HuggingFace快2-24倍)。其特点包括: 连续批处理技术提升GPU利用率 兼容OpenAI API接口 支持主流开源模型 与Ollama对比: vLLM适合企业级高并发场景(需NVIDIA GPU) Ollama更适合个人

Ragas是一个专业的大语言模型(LLM)应用评估工具包,提供端到端的解决方案。它能自动生成测试数据,支持多维度评估指标(如准确性、相关性、忠实度等),并与LangChain等主流框架无缝集成。Ragas解决了传统评估方法的主观性、测试数据匮乏等问题,通过数据驱动的方式持续优化LLM应用性能。其核心功能包括智能测试数据生成、批量评估执行、以及生产环境下的性能追踪。开发者可以快速安装并通过Pytho

MiniMind是一个开源的大语言模型训练框架,提供从预训练到推理的全流程解决方案。本文解析其预训练流程的核心技术:1)采用余弦退火学习率调度平衡收敛与精度;2)混合精度训练结合float16前向计算与float32梯度管理加速训练;3)梯度累积技术突破显存限制;4)基于NCCL的分布式训练实现多GPU并行。框架通过模块化设计(参数解析、数据加载、训练循环等)支持高效训练,并确保实验可复现性(随机

摘要 本文提出了一种通过模型蒸馏技术,在保持任务效果的同时降低推理成本的解决方案。以物流信息抽取任务为例,使用Qwen3-235B大模型生成训练数据后,对Qwen3-0.6B小模型进行微调。方案采用魔搭社区的ms-swift框架简化微调流程,仅需单条命令即可完成。实验结果显示,微调后的小模型准确率从14%提升至98%,且响应速度更快、成本更低。方案详细介绍了数据准备、模型微调、效果验证的全流程,并

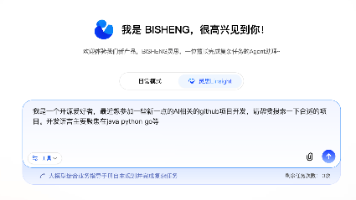

BISHENG灵思是毕昇开源的通用AI Agent,采用创新的AGL(Agent指导语言)框架,将业务专家知识注入AI系统。它能处理复杂任务如文档写作、信息搜集等,具备专家级品味和多智能体协作能力。演示案例中,灵思帮助用户搜索热门AI开源项目,通过多轮交互优化查询条件,整合GitHub和网络搜索结果,最终生成结构化报告。该工具通过自然语言引导Agent执行任务,支持专家知识注入和持续优化,适用于旅

PyTorch深度学习房价预测项目摘要 本项目基于PyTorch框架构建了一个多层感知机(MLP)模型,用于预测加州房价。项目从数据预处理、特征工程到模型训练和优化提供了完整解决方案。数据集包含47,439个训练样本和31,626个测试样本,涵盖41个房屋特征。 核心亮点: 采用5层神经网络架构(33→256→128→64→32→1),包含批标准化和Dropout层 实现特征筛选、缺失值处理、异常

摘要 本文提出了一种通过模型蒸馏技术,在保持任务效果的同时降低推理成本的解决方案。以物流信息抽取任务为例,使用Qwen3-235B大模型生成训练数据后,对Qwen3-0.6B小模型进行微调。方案采用魔搭社区的ms-swift框架简化微调流程,仅需单条命令即可完成。实验结果显示,微调后的小模型准确率从14%提升至98%,且响应速度更快、成本更低。方案详细介绍了数据准备、模型微调、效果验证的全流程,并

本文详细解析了MiniMind框架的监督微调(SFT)全流程,主要内容包括: 整体流程概述:从初始化到模型评估的完整训练流程,包括参数解析、模型加载、数据准备、训练循环等关键步骤。 核心技术实现: 对话模板处理:将原始对话转换为ChatML标准格式 损失掩码机制:仅对助手回复部分计算损失 预训练模型加载:支持标准模型和MoE架构切换 专用损失计算:应用损失掩码并保持MoE辅助损失 数据格式规范:采

MiniMind是一个开源的大语言模型训练框架,提供从预训练到推理的全流程解决方案。本文解析其预训练流程的核心技术:1)采用余弦退火学习率调度平衡收敛与精度;2)混合精度训练结合float16前向计算与float32梯度管理加速训练;3)梯度累积技术突破显存限制;4)基于NCCL的分布式训练实现多GPU并行。框架通过模块化设计(参数解析、数据加载、训练循环等)支持高效训练,并确保实验可复现性(随机