简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

令x表示prompt,y表示response,策略πθ针对tokent输出的概率分布为ptpt1pt∣V∣πθ⋅∣xytsoftmaxTzt1∣V∣表示整个词表的大小,zt∈RV是logitsT∈R是解码温度。那么tokent的熵为Ht−j1∑∣V∣ptjlogptj2。

深度网络的公理归因Axiomatic Attribution for Deep Networks一、简介本文研究的问题是,将深度网络的预测结果归因到输入的特征中。本文确定了两条归因的基本公理:Sensitivity和Implementation Invariance,并基于这两个公理设计了一种新的归因方法,称为积分梯度法(Integrated Gradients)。该论文之前的许多归因方法并不完全

说明:主要参考Francois Chollet《Deep Learning with Python》;代码运行环境为kaggle中的kernels;数据集IMDB、IMBD RAW以及GloVe需要手动添加# This Python 3 environment comes with many helpful analytics libraries installed# It is d...

本文来自于《Theory of Deep Learning》,主要是对神经正切核(NTK)理论进行介绍。这里主要是补充了一些基本概念以及部分推导过程。作为软件工程出身,数学不是特别好,有些基础知识和推导步骤没办法一次补足。若有机会,后续会逐步补全缺失的部分。设X1,…,XnX_1,\dots,X_nX1,…,Xn为nnn个独立的随机变量,且XiX_iXi的边界为[ai,bi][a_i,b

from bs4 import BeautifulSoup一、修改tag的名称和属性soup = BeautifulSoup('<b class="boldest">Extremely bold</b>','lxml')tag = soup.btag<b class="boldest"&a

深度网络的公理归因Axiomatic Attribution for Deep Networks一、简介本文研究的问题是,将深度网络的预测结果归因到输入的特征中。本文确定了两条归因的基本公理:Sensitivity和Implementation Invariance,并基于这两个公理设计了一种新的归因方法,称为积分梯度法(Integrated Gradients)。该论文之前的许多归因方法并不完全

SIMVLM:基于弱监督的简单视觉语言模型预训练《SIMVLM:Simple Visual Language Model Pre-training with Weak Supervision》论文地址:https://arxiv.org/pdf/2108.10904.pdf?ref=https://githubhelp.com一、简介基于Transformer\text{Transformer}

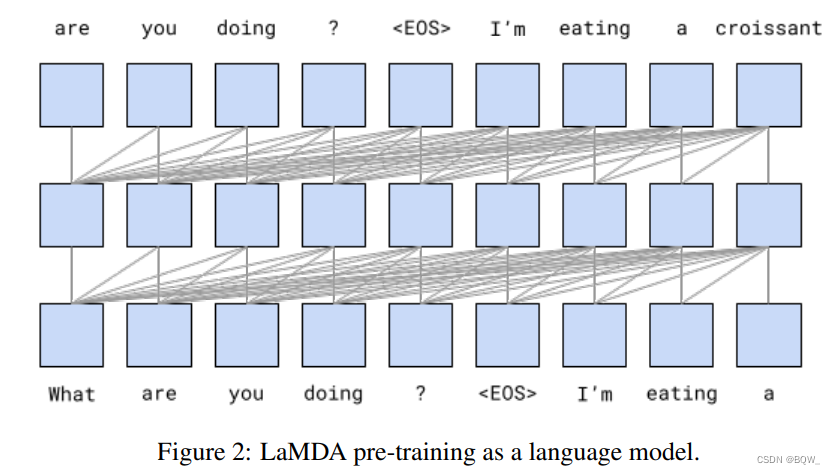

语言模型的预训练是自然语言处理中非常有前景的研究方向。预训练会使用无标注的文本,能够结合大规模数据集和大模型来实现更好的效果或者新的能力。例如,GPT-3是一个在大规模无标注文本上训练的175B参数模型,并展现出令人影响深刻的few-shot learning能力。对话模型(大语言模型最有趣的应用之一)成功利用了Transformers表示文本中长距离依赖的能力。与通用语言模型类似,对话模型也

近些年来,随着大型预训练语言模型的兴起,人们对开发式语言生成越来越感兴趣。之所以开放式语言生成效果令人印象深刻,除了架构的改善和大量的无监督训练数据,更好的解码方式也扮演着重要的角色。本文对不同的解码方法进行了简单的介绍并展示如何使用库进行实现。以下所有的功能都是用于自回归语言生成。

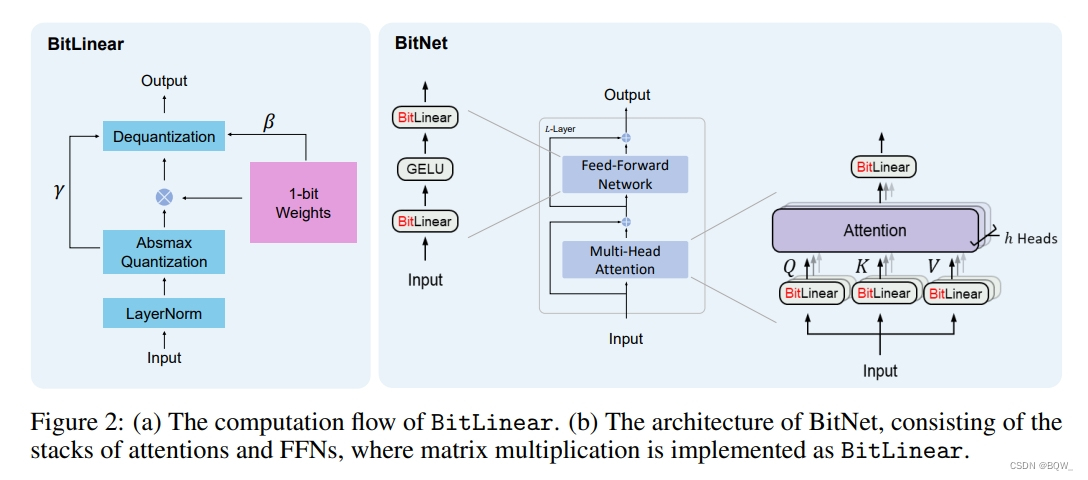

语言模型的规模不断扩大,这对部署带来了巨大的挑战。本文设计了一种可扩展且稳定的1-bit Transformer架构来实现大语言模型,称为BitNet。具体来说,使用BitLinear作为标准nn的替代品。实验结果表明BitNet能够显著减少存储占用和能力消耗,并且与最先进的8-bit量化和FP16 Transformer能力相当。此外,BitNet也表现出了类似于全精度Transformer的