简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

大模型量化技术通过减少模型参数的精度,显著降低了模型的存储和计算需求,同时尽量保持模型性能。不同的量化方法(如PTQ、QAT、QAF)和量化粒度(如逐层、逐通道)可以根据具体需求选择,以实现模型的高效部署。AWQ(Activation-aware Weight Quantization)和AutoAWQ是基于激活感知的权重量化技术,主要用于在不显著损失精度的情况下,将大型语言模型(LLM)的权重压

所以昨晚,DeepSeek在DeepSeek-V3之后发布了另一个革命性的模型,即DeepSeek-R1和我的孩子,这看起来是一个重大的发布,因为这个模型在几个基准测试中已经超越了OpenAI-o1,即SOTA推理模型。例如,在推理基准测试中,DeepSeek-R1-Distill-Qwen-32B的表现优于DeepSeek-R2-Zero-Qwen-34B,这表明对于较小的模型来说,蒸馏是一种更

PPO(Proximal Policy Optimization)和DPO(Direct Preference Optimization)是两种不同的优化算法,分别应用于强化学习和基于人类反馈的模型微调。奖励模型(Reward Model)的设计直接影响策略优化的效果,尤其是在复杂任务或需要人类偏好的场景中(如对话生成、机器人控制)。DPO 将奖励函数隐式地编码到策略优化中,通过理论推导证明其等价

训练一个7B参数的大模型,显存需求大约为120-144 GB。实际需求可能因实现和硬件不同而有所变化。使用来训练模型可以显著减少显存占用,因为 BF16 每个参数仅占用2 字节(16 位),而不是 FP32 的 4 字节。使用BF16训练一个 7B 参数的大模型,显存需求大约为88-106 GB。相比 FP32 的 120-144 GB,BF16 可以节省约 25-30% 的显存。

随着大型语言模型的发展,以ChatGPT为首,涌现了诸如ChatPDF、BingGPT、NotionAI等多种多样的应用。公众大量地将目光聚焦于生成模型的进展之快,却少有关注支撑许多大型语言模型应用落地的必不可少的Embedding模型。本文将主要介绍为什么Embedding模型在大语言模型中十分重要、当前主流的Embedding训练方法,以及我们关于Embedding模型初步探索的一些思考。

指令微调是引导语言模型落地、构建高性能对话模型的关键一步。针对目前开源的指令数据集质量低、覆盖领域少、数据信息不透明等问题,智源研究院推出了千万级指令微调数据集Infinity Instruct。该数据集今年6月发布,近日完成了新一轮迭代,包括Infinity-Instruct-7M基础指令数据集和Infinity-Instruct-Gen对话指令数据集。Infinity-Instruct-7M包

在这篇博客中,我们探索了向量嵌入的复杂世界,从传统的稀疏和密集形式到创新的学习稀疏嵌入。我们还研究了两个机器学习模型——BGE-M3和Splade——以及它们如何工作以生成学习到的稀疏嵌入。使用这些复杂嵌入来细化搜索和检索系统的可能性,为开发直观且响应迅速的平台开辟了新的可能性。请继续关注未来的帖子,展示这些技术的实际应用和案例研究,展示它们对信息检索标准的影响,承诺重新定义信息检索标准。

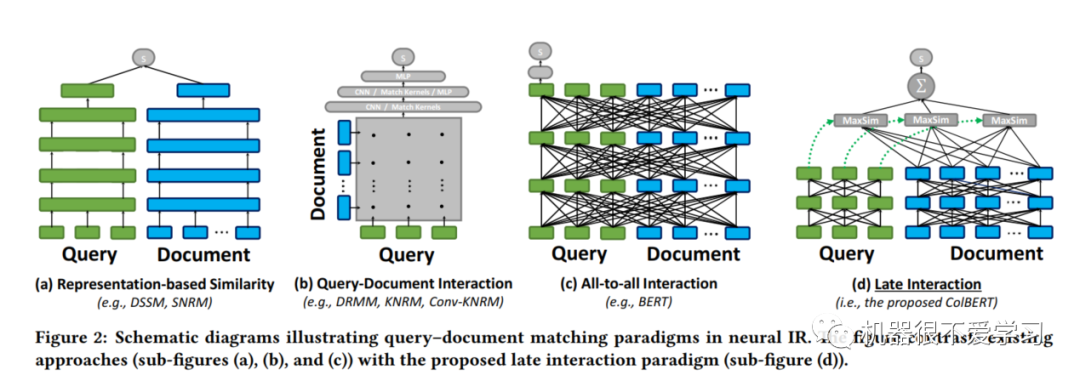

ColBERT使用了"延迟交互"来计算query与doc的相似度。具体来说,就是对query与doc分别编码之后,使用简单且有效的模块来评估相似度。:分别将query-doc使用编码器进行编码,得到两者表示向量之后,使用相似度计算函数,例如余弦距离,来算出query-doc相似分数。典型代表:DSSM、SRNM。:很明显上述模式的缺点是没有充分利用query与doc之间的交互(分别将query与d

专家混合器是一种集合方法,将整个问题分解为多个子任务,并在每个子任务上对一组专家进行训练。在这篇文章中,我们将讨论专家混合器(MOE)架构是什么,MOE模型的内部工作原理,以及它与现有模型架构有何不同。随着神经网络架构变得越来越复杂,处理不同数据、处理各种响应以及最小化处理能力和时间,专家混合模型将占据主导地位。根据这个,门控网络将每条输入路由到特定的专家层。门控网络和专家层是同时训练的,使得门控