简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

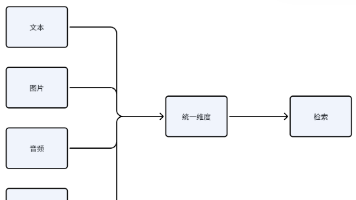

本文详细介绍了多模态RAG系统的两种实现方式:间接表示法(通过文本模态表示其他模态数据)和直接表示法(将不同模态映射到统一向量空间)。文章还探讨了多模态融合(早、中、晚期融合)和跨模态对齐(显式、隐式对齐)等关键技术。多模态RAG需要专门的多模态Embedding模型,能够充分利用不同模态间的互补性,是未来AI发展的重要方向。

文章详细介绍了检索增强生成(RAG)技术的四个演进阶段:从Naive RAG确立基本范式,到Advanced RAG引入精细化优化,再到Modular RAG追求架构灵活性,最终Agentic RAG实现自主决策与智能化。RAG技术从简单的"知识搬运工"逐步进化为能够进行复杂推理的"智能决策者",未来将向多模态、实时化和可信AI方向发展。

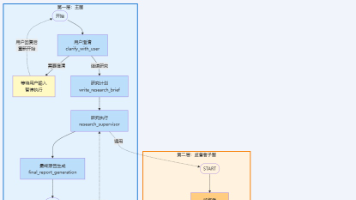

本文深入解析Open Deep Research项目的多Agent架构设计,采用三级分层嵌套结构:主图负责整体流程编排,监督者子图实现任务分解与委派,研究者子图执行具体研究。通过LangGraph的子图复用和异步并行机制,实现职责分离与高效协作,为构建复杂多Agent系统提供了优秀范例。

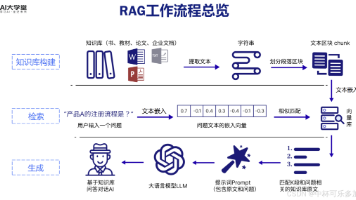

RAG技术通过结合大型语言模型的生成能力与外部知识库,实现了可靠的知识闭环。文章详细解析了RAG系统的四大工作流程(查询解析、文档检索、信息整合与回答生成),深入探讨了三大核心组件(数据预处理、嵌入技术、向量存储),并介绍了高级优化策略如HyDE和重排序技术。最后提出了RAG系统的评估体系和未来发展方向,为开发者提供了从理论到实践的完整指南。

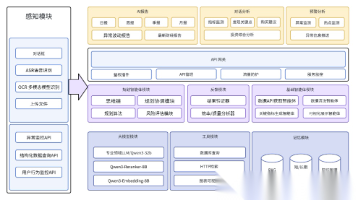

文章介绍了AI Agent系统的六大核心模块:感知、决策规划、执行、专业大模型、记忆管理和反馈系统。这些模块协同工作形成完整智能闭环,使AI Agent能够感知环境、自主决策、执行任务并持续进化。通过金融数据分析智能体的案例展示了具体实现,并讨论了模块化、边缘智能融合等未来趋势。

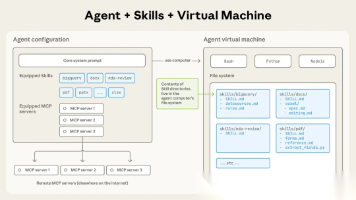

Anthropic发布Agent Skills开放标准,定义智能体"能力"单元,与MCP工具、A2A协作形成互补。其渐进式披露特性解决上下文限制,结合LLM与确定性代码执行。通过将业务流程打包成可复用技能,降低经验注入大模型的技术复杂度。Agent Skills标志着智能体开发从单体架构向微服务、组件化转型,未来竞争将围绕能力单元生态展开,为AI世界定义"操作系统层"和"包管理协议"。

文章介绍如何利用AI智能体、MCP协议和n8n零代码平台构建营销自动化工作流。通过MCP协议,营销人员可直接访问AppsFlyer数据;结合n8n平台,可快速搭建自动化投放报告和成本预警两大核心工作流,无需依赖开发团队。这些工具帮助节省时间,提高效率,实现数据驱动的营销决策。

大模型技术正从"泛化对话"向"深度业务嵌入"转变,企业级Agent成为核心战场。企业需要可本地部署、高度定制化的智能体架构,而非通用聊天机器人。作者分享三天搭建企业级Agent的实战经验,提供面向新手的教程。展望未来,多模态Agent和自主规划系统将更受重视,开发者应将大模型学习纳入长期建设,掌握AI时代话语权。

大模型技术正从"泛化对话"向"深度业务嵌入"转变,企业级Agent成为核心战场。企业需要可本地部署、高度定制化的智能体架构,而非通用聊天机器人。作者分享三天搭建企业级Agent的实战经验,提供面向新手的教程。展望未来,多模态Agent和自主规划系统将更受重视,开发者应将大模型学习纳入长期建设,掌握AI时代话语权。

本文详解AI智能体搭建方法,从入门到进阶,包括四步创建流程、个性化设置、知识库运用和指令迭代技巧。文章强调将AI视为协作者而非工具,根据场景选择适合的大模型,并提供多个国内免费平台推荐。无需编程基础,即可打造专属AI助手,提升工作效率。建议收藏实践,通过日常使用掌握AI技能。