简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本案例共包含4个实验步骤。(1)本地数据集上传到数据仓库Hive。(2)Hive数据分析。(3)Hive,MySQL、HBase数据互导。(4)利用R进行数据可视化分析。实验整体的流程如下:将数据源抽取到HDFS存储;通过Hive清洗、处理和计算原始数据;HIve清洗处理后的结果,可以存入Hbase或者其它数据库中例如MySQL。

本文主要介绍了深度学习的基础知识和操作,包括数据操作、数据运算、数据预处理。最后复习了循环神经网络(RNN)和长短期记忆网络(LSTM)。在数据操作部分,详细讲解了张量的基本操作,如创建、形状调整、元素总数计算、初始化和元素赋值。数据运算部分则包括了张量的算术运算、连结、逻辑运算和求和。文章还介绍了广播机制和索引切片的使用方法。数据预处理部分,通过使用pandas库对CSV文件中的数据进行读取、处

生成对抗网络(GANs)目的是生成数据,而循环神经网络(RNNs)常用于生成数据序列。目前已有研究用RNN进行音乐生成,但多使用符号表示。本论文中,作者研究了使用对抗训练生成连续数据的序列可行性,并使用古典音乐的midi文件进行评估。作者提出C-RNN-GAN(连续循环生成对抗网络)这种神经网络架构,用对抗训练来对序列的整体联合概率建模并生成高质量的数据序列。通过在古典音乐midi格式序列上训练该

本文深入探讨了深度学习中的数学基础,特别是微积分在优化和泛化中的作用。文章首先回顾了微积分的历史和基本概念,包括逼近法、导数、微分和积分。接着,文章详细讨论了深度学习中的优化问题,包括损失函数的最小化和模型的泛化能力。文章还介绍了自动微分技术,这是深度学习框架中用于加速求导过程的关键技术。最后,文章通过一系列示例,展示了如何使用自动微分技术来计算梯度,包括非标量变量的反向传播、分离计算以及处理Py

这周主要学习了机器学习的一些基础知识,比如:机器的基本概念、training三步骤,并在最后进行了总结。此外,还学习了深度学习的知识,了解了sigmoid函数和ReLU函数这两个重要的激活函数,并且学习了深度学习的三个步骤。最后观看视频完成了pytorch的环境配置,并了解到了dir()与help()这两个对pytorch学习最为重要的函数。机器学习实际上并没有我们想象中的那么复杂,其实际上就是寻

生成对抗网络(GANs)目的是生成数据,而循环神经网络(RNNs)常用于生成数据序列。目前已有研究用RNN进行音乐生成,但多使用符号表示。本论文中,作者研究了使用对抗训练生成连续数据的序列可行性,并使用古典音乐的midi文件进行评估。作者提出C-RNN-GAN(连续循环生成对抗网络)这种神经网络架构,用对抗训练来对序列的整体联合概率建模并生成高质量的数据序列。通过在古典音乐midi格式序列上训练该

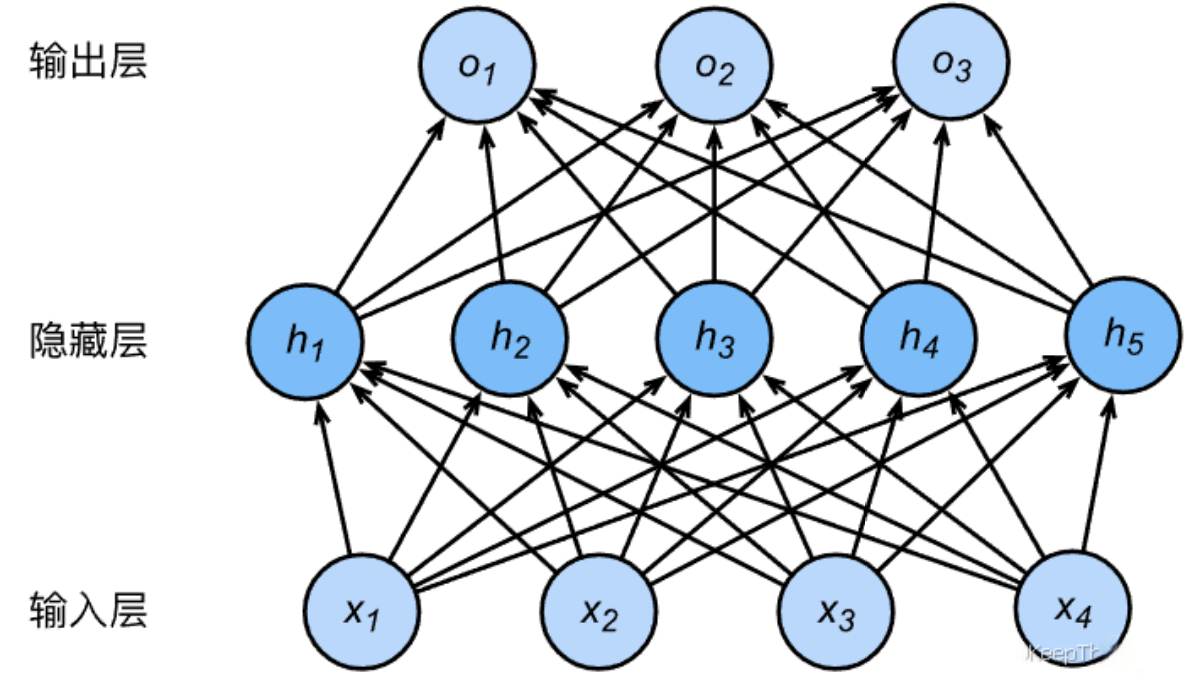

本周的周报主要对机器学习的核心概念和实践应用进行了复习和学习,本周复习了神经卷积网络(CNN)的基础知识,包括CNN的工作原理、卷积层、池化层以及它们在图像识别中的应用。在动手深度学习中,学习了了线性回归、softmax回归和多层感知机(MLP)的基本概念和实现,并通过代码示例展示了如何使用PyTorch框架来实现这些模型。此外,还讨论了过拟合问题及其解决方案,如权重衰减和丢弃法,并以Kaggle

本文深入探讨了深度学习中的数学基础,特别是线性代数的核心概念。文章从标量、向量、矩阵和张量的定义和性质出发,逐步介绍了它们在深度学习中的应用。通过详细的代码示例和数学公式,本文展示了如何进行基本的算术运算、矩阵操作、点积、范数计算等关键操作。文章还讨论了降维技术,包括求和和平均值计算,以及它们在数据压缩和特征提取中的重要性。

本文主要介绍了深度学习的基础知识和操作,包括数据操作、数据运算、数据预处理。最后复习了循环神经网络(RNN)和长短期记忆网络(LSTM)。在数据操作部分,详细讲解了张量的基本操作,如创建、形状调整、元素总数计算、初始化和元素赋值。数据运算部分则包括了张量的算术运算、连结、逻辑运算和求和。文章还介绍了广播机制和索引切片的使用方法。数据预处理部分,通过使用pandas库对CSV文件中的数据进行读取、处

本文详细介绍了统计学习中的基本概念和算法,包括监督学习和无监督学习的区别、线性回归模型、K-means聚类算法、决策树、集成学习(包括Boosting和Bagging)以及贝叶斯定理及其在机器学习中的应用。