简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

大型复杂模型场景测试瞄准中大型制造企业的复杂设计需求,为构建更复杂的模型,评测组将YL-777 电梯实训装置、智能装配生产线、睿抗机器人工程三个复杂模型组合到一起,组建三合一模型进行极限环境下的显卡性能测试,三合一模型总计包含零部件数量约2.1万个,型文件总大小1.5G,含大量高精度曲面、关联特征与运动信息,对显卡图形处理能力与显存容量要求极高。从三合一模型的载入速度看,RTX PRO 4000、

这些库和模型由全新 NVIDIA RTX PRO™ 服务器和 NVIDIA DGX™ Cloud 提供支持,可帮助开发者在任何地方开发物理精确的数字孪生,在仿真中捕捉和重建现实世界,生成用于训练物理 AI 模型的合成数据,并构建理解物理世界的 AI 智能体。NVIDIA Cosmos Reason 是一款面向物理 AI 和机器人开发的全新开源、可定制的 70 亿参数推理 VLM,可让机器人和视觉

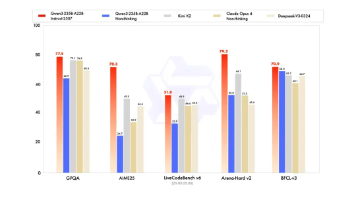

今天,给大家分享 Kimi-K2 的表现,这可是一个1T大小的模型,说人话就是有1万亿个参数,拿给所有地球人平分,人均也有150个,是迄今为止,我测试过的最大的模型。,时延也仅0.18秒,不算差,但是,注意,随着并发用户的增加,时延上升明显,当并发用户达到。时,时延已经高达22秒,几乎是 DeepSeek V3 的两倍,而吞吐率也仅有。看到如上的数据,不说大家也猜到了,知识库应用的性能应该更差。如

全力支持企业低成本快速部署 DeepSeek

7月26日,扣子(Coze)宣布开源其核心产品:零代码开发平台CozeStudio和调试工具CozeLoop。

上影昊浦社区建设涉及上海科技影都 AI 创制生态中心、上影制作一站式服务平台、高科技影棚群、数字后期制作板块、青年人才公寓及社区配套。赞奇科技作为上影昊浦合作伙伴之一,在等方面展开合作,共同推动了包括等多个核心项目落地。上影昊浦智慧产业社区实拍图。

DeepSeek R1 32B的企业私有化部署场景,推荐 4卡 RTX 5000 Ada 机型,性能和成本效益方面表现出色,满足企业级应用的高并发需求。

该智能体依托 Qwen3 基础大模型研发构建,且内置 Qwen VL 视觉模型能力,使 DGX Spark 能够解析图像信息,以自然语言与用户交流图片内容,回答问题并执行逻辑推理,结合其。一体化多模态交互,集成视觉、语音与信息展示能力于统一的交互界面中,用户可在与形象自然互动的过程中,同步完成聆听讲解、观看图像等内容交互,实现高效整合的沟通流程。具备逼真的面部表情、口型、眼神及肢体动作,消除传统纯

来说,即使是压力最大的知识库应用或智能体应用,能达到50个并发用户的同时,保持较好的用户体验,应该说性价比远超 DeepSeek V3 了。顾名思义,235B总参数达到235B,同样,只能在H20或A100这样的机器上才能运行。,这也是阿里这阵子发布的杆把子模型了,其 benchmark 表现超过了 DeepSeek 及 Kimi K2。(以下称480B),今天,我为大家继续带来新的评测,这次,介

前段时间我们使用单台 DGX Spark 测试了模型性能。今天,我们通过一根 200 Gbps 带宽的 QSFP 线缆,看看性能如何。整体测试下来,单用户生成速度为,但预填充速度还不错,单用户可达。