简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

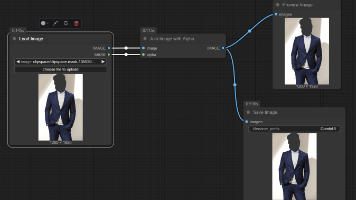

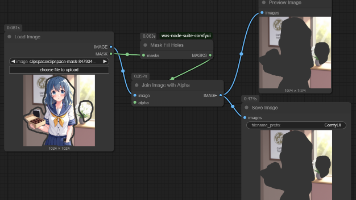

进行图像超分辨时,进行到调用SDXL绘图时报错。尝试在默认设置基础上进行以下设置,依旧报错。,重新启动ComfyUI解决。修改ComfyUI启动脚本。Windows便携版。

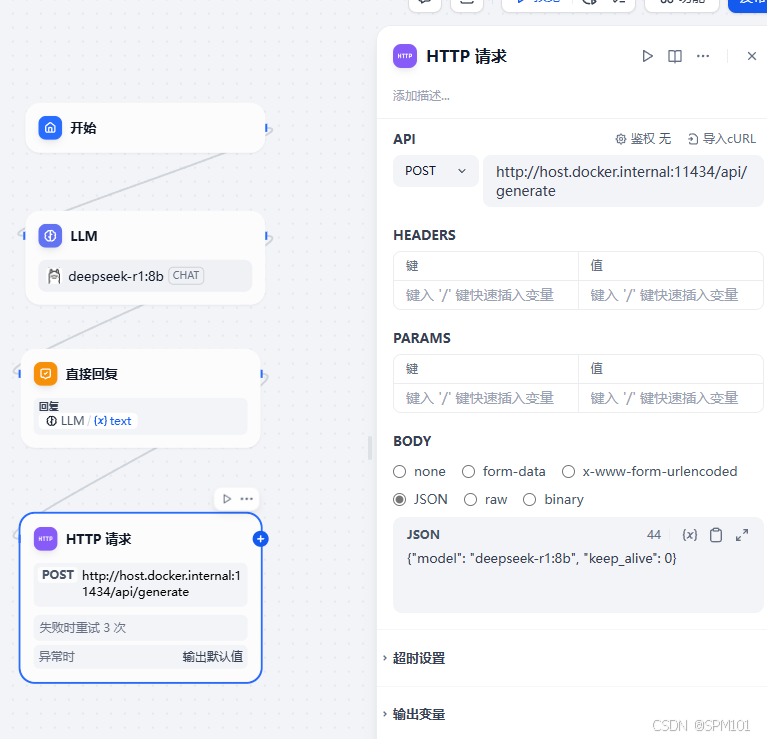

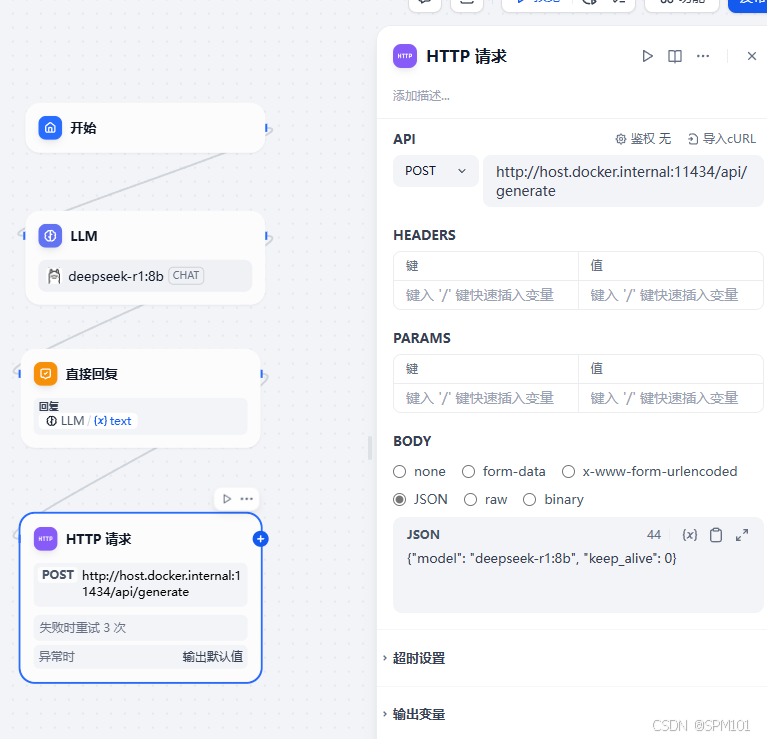

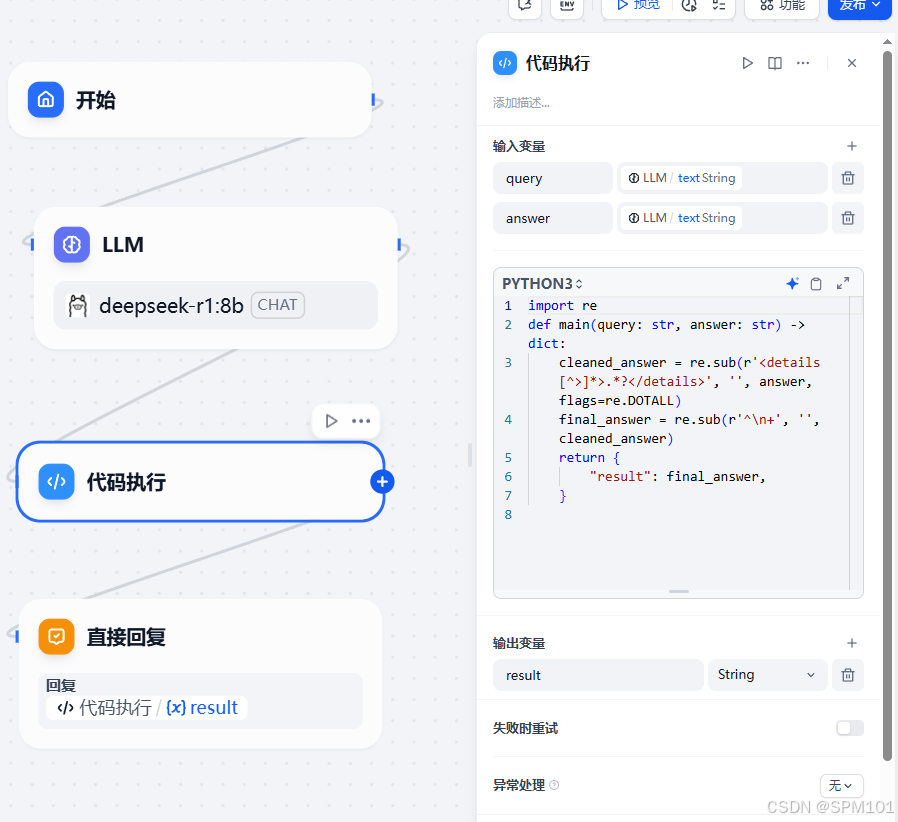

博主希望在同一台主机上部署Dify+Ollama+Deepseek和AI绘图ComfyUI,在编写Dify文生图工作流中,Deepseek生成文本后立刻执行AI绘图。此时Ollama并未卸载Deepseek模型,内存和显存依旧有占用,这会影响AI绘图速度,所以通过HTTP请求的方式联系Ollama卸载模型。因为博主的Dify是在docker容器中运行,所以Ollama地址要用host.docker

隐藏前:有下拉列表可以点击查看工作流。1.进入工作流选择”监测“隐藏后:下拉列表被隐藏。

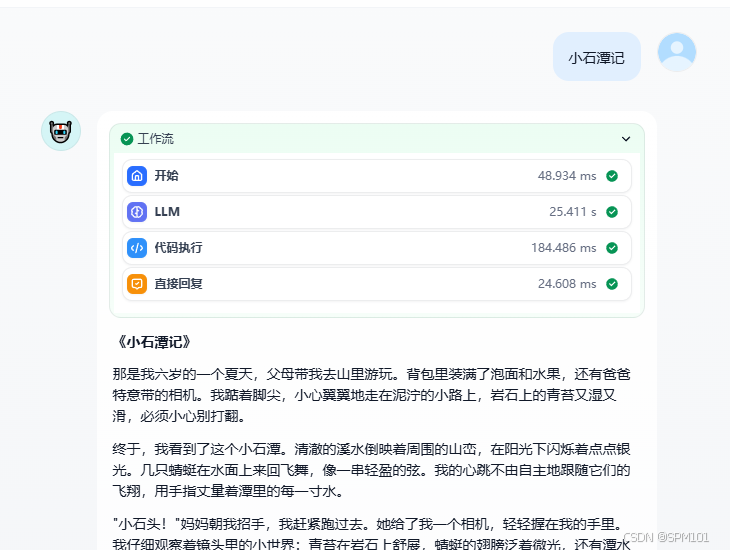

选择代码执行节点的返回值result(注:直接回复节点只有在Dify创建空白应用时选择”Chatflow“非”工作流“才有这个节点,即多轮对话流)该方法缺点:没有流式输出答案,即打字机效果,会直接呈现所有答案,也许这种效果刚好满足你的需求hhh。

5*.同理,在docker-compose.yaml文件中也能搜索到"UPLOAD_FILE_SIZE_LIMIT"和”NGINX_CLIENT_MAX_BODY_SIZE",如果修改完.env后重启docker容器依旧未生效,则docker-compose.yaml文件也要做同步参数修改并重启docker容器。4.在.env文件中搜索“NGINX_CLIENT_MAX_BODY_SIZE”,数值

示例:在内置Mask Editor中描绘外轮廓,或根据GitHub项目指引手动安装。注意轮廓必须为闭合的。

5*.同理,在docker-compose.yaml文件中也能搜索到"UPLOAD_FILE_SIZE_LIMIT"和”NGINX_CLIENT_MAX_BODY_SIZE",如果修改完.env后重启docker容器依旧未生效,则docker-compose.yaml文件也要做同步参数修改并重启docker容器。4.在.env文件中搜索“NGINX_CLIENT_MAX_BODY_SIZE”,数值

博主希望在同一台主机上部署Dify+Ollama+Deepseek和AI绘图ComfyUI,在编写Dify文生图工作流中,Deepseek生成文本后立刻执行AI绘图。此时Ollama并未卸载Deepseek模型,内存和显存依旧有占用,这会影响AI绘图速度,所以通过HTTP请求的方式联系Ollama卸载模型。因为博主的Dify是在docker容器中运行,所以Ollama地址要用host.docker