简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

文章目录逻辑回归的损失函数以MLE角度理解交叉熵以信息论角度理解交叉熵信息熵K-L散度(相对熵)交叉熵(Cross Entropy)推导逻辑回归损失对参数的梯度使用逻辑回归实现乳腺癌数据集二分类逻辑回归的损失函数有两种方式可以推导出二分类交叉熵损失函数,一个是通过极大似然估计法,另一个则是信息熵。以MLE角度理解交叉熵参考之前如何推导多元线性回归的损失函数,我们可以总结一下这个思想:那就是,一个预

文章目录逻辑回归以及为什么叫逻辑回归从sigmoid函数引出逻辑回归的统计学模型:伯努利分布线性回归模型的通式:广义线性模型指数族分布逻辑回归以及为什么叫逻辑回归逻辑回归虽然名字里有回归(logistic regression),实则它是个二分类算法。从sigmoid函数引出同多元线性回归一样,逻辑回归也具有它的函数表达式:hθ(x)=g(θTx)=11+e−θTxh_{\theta}(x)=g\

贝叶斯滤波详解贝叶斯滤波的用途(Bayesian Filtering):贝叶斯滤波理论的应用可谓十分广泛。我们知道,在机器人运动过程中,有两个方面的信息来源,一个是通过我们实际控制机器人的运动路线(状态方程)和机器人传感器观测的实际信息(观测方程)来估计自身的位姿,但实际上,无论是状态还是观测都不可避免的存在噪声。假如机器人单方面的仅通过状态方程或观测方程来估计自身位姿,这样一来随着时间的不断推移

文章目录逻辑回归的损失函数以MLE角度理解交叉熵以信息论角度理解交叉熵信息熵K-L散度(相对熵)交叉熵(Cross Entropy)推导逻辑回归损失对参数的梯度使用逻辑回归实现乳腺癌数据集二分类逻辑回归的损失函数有两种方式可以推导出二分类交叉熵损失函数,一个是通过极大似然估计法,另一个则是信息熵。以MLE角度理解交叉熵参考之前如何推导多元线性回归的损失函数,我们可以总结一下这个思想:那就是,一个预

1)核心库与统计:Numpy、Scipy、Pandas、StatsModels。(2)可视化:Matplotlib、Seaborn、Plotly、Bokeh、Pydot、Scikit-learn、XGBoost/LightGBM/CatBoost、Eli5。(3)深度学习:Tensorflow、PyTorch、Keras。4)分布式深度学习:Dist-keras/elephas/spark-...

文章目录前言1.VGG1.1改进:1.2 PyTorch复现VGG191.2.1小Tips:1.2.2 打印网络信息:2.Inception(GoogLeNet)2.1改进(Inception v1)2.2.2改进(Inception v2)2.2 PyTorch复现Inception v1:2.2.1 网络的整体框架:2.2.2 各层的参数情况:2.2.3 pytorch复现Inception基

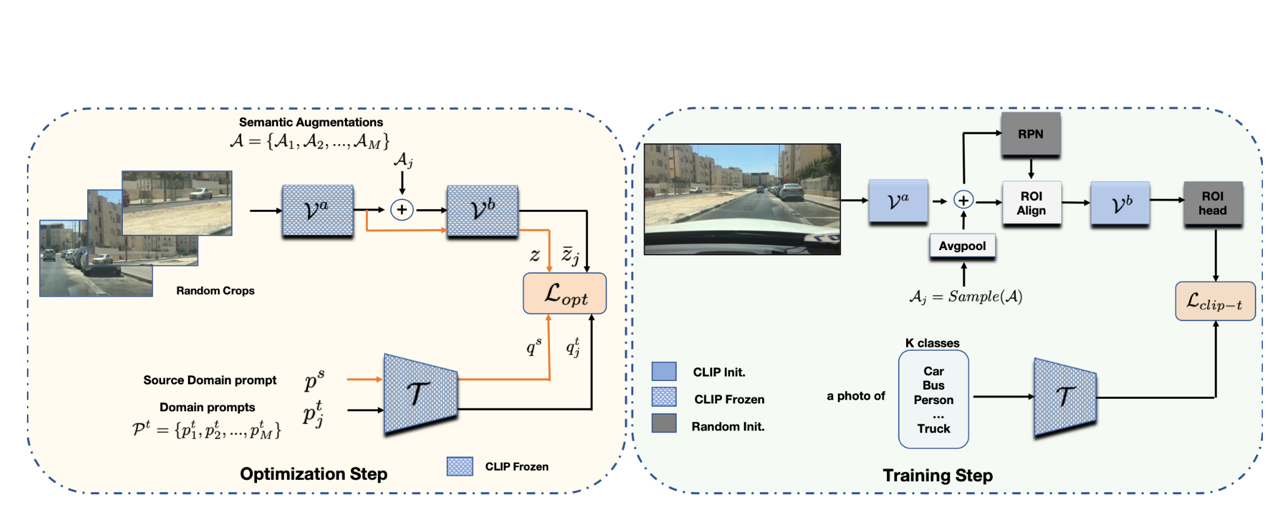

Single Domain Generalization (SDG) tackles the problem of training a model on a single source domain so that it generalizes to any unseen target domain. While this has been well studied for image clas

包含完整基于pytorch的从数据集定义、网络模块定义再到训练,验证,测试的整个流程,适合小白入门深度学习和pytorch

文章目录单目相机标定(基于Python OpenCV)1.上期填坑2.单目相机标定2.1 数据采集2.2 角点提取2.3 参数求解2.4 参数评估(重投影误差)2.5 相机位姿(棋盘位姿)可视化2.6 同Matlab标定结果比较单目相机标定(基于Python OpenCV)1.上期填坑在开始本篇博客之前,先填一下上一篇博客【计算机视觉】基于ORB角点+RANSAC算法实现图像全景拼接的坑(不算填吧