简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

leetcode刷题笔记java版leetcode热题 HOT 100题目分类221. 最大正方形【方法1】动态规划221. 翻转二叉树【方法1】使用队列按层遍历二叉树【方法2】递归遍历二叉树高频知识点leetcode热题 HOT 100题目分类分类题号二叉树226动态规划221221. 最大正方形【方法1】动态规划状态转移方程:定义dp[i][j]为以(i, j) 为有下角的正方形的最大边长,有

问题开发过程中,我们可能遇到一次merge多个commit的情况,在merge之前我们做测试的时候发现某次提交有问题,这时候我们又不想新提一个commit来解决这个问题,这时候该怎么办?解决方法git log 查看历史提交A---B(有bug)----C----D---E发现 B 提交有bug,我们想要直接修改B,但是又不想多增加F提交;或者我们想修改B提交的commit信息。git rebase

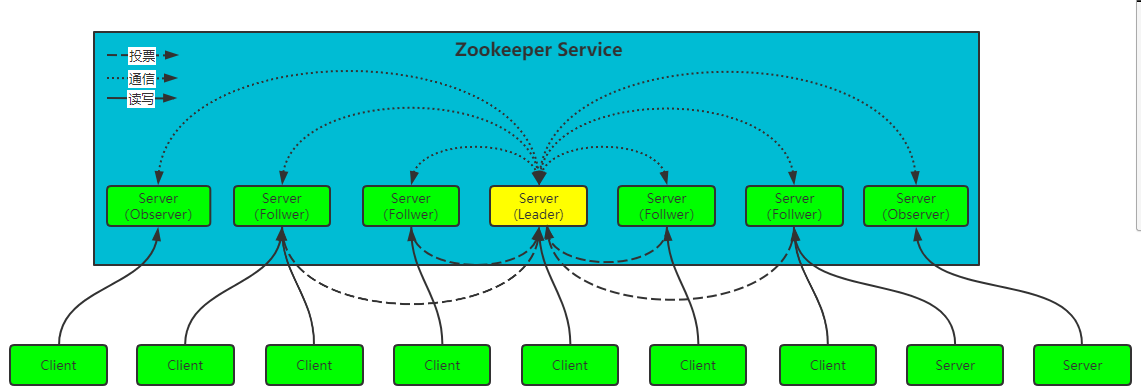

【项目地址】 从零开始学习springmvc如果觉得有用可以关注一下公众号:码字不易,求赞求关注zookeeper的基本概念一、Zookeeper1、Zookeeper是什么?2、Zookeeper的作用3、Zookeeper的特性4、Zookeeper的架构5、 数据模型和分层命名空间5.1 命名空间5.2 节点类型(Znode)5.3 事件机制(监听通知机制,Watcher)5.3.1 Wat

通过JVM的这些选项:Xms/Xmx/PermSize/MaxPermSize可以牵扯出很多问题,比如性能调优等。说明:以下转载没经过实践。Java JVM虚拟机选项Xms/Xmx/PermSize/MaxPermSize(转)经验实例(参考):设置每个线程的堆栈大小。JDK5.0以后每个线程堆栈大小为1M,以前每个线程堆栈大小为256K。更具应用的线程所需内存大小进行调整。在相同物理内存下,减小

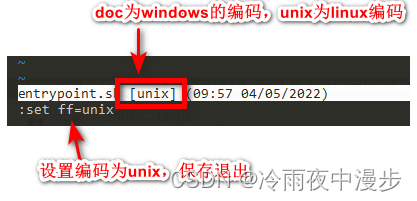

报错信息standard_init_linux.go:228: exec user process caused: no such file or directory排查点在Dockerfile中使用了启动脚本entrypoint.shENTRYPOINT ["entrypoint.sh"]但是由于启动脚本entrypoint.sh实在Windows环境下编写的,文件编码方式不是unix,所以无法

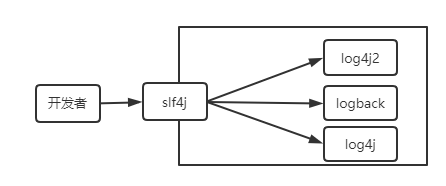

一、log4j2插件plugins简介Log4j 1.x 允许对指定的大多数配置声明的类属性进行扩展,例如想要自定义模板匹配器需要通过代码来扩展PatternLayout类功能。而log4j2的目的是使这样的功能扩展变得更容易。在 Log4j 2 中,通过在类声明上添加@Plugin注解来声明一个自定义插件。在初始化期间,Configuration将调用PluginManager来加载内置的 Lo

之前已经介绍了通过和工具来消费数据。下面介绍SpringKafka消费数据的方式——kafka消息监听器。Kafka的消息监听一般可以分为:1.单条数据监听;2.批量数据监听。是的消息监听器接口,也是一个函数式接口,利用接口的方法可以实现消费数据。基于此接口可以实现单条数据消息监听器接口、多条数据消息监听器接口、带ACK机制的消息监听器和MessageListenerGenericMessageL

zk报错:java.lang.IllegalStateException: Expected state [STARTED] was [LATENT]原因:客户端使用时没有start而直接调用了其他方法解决办法:public CuratorFramework getCuratorFramework() throws InterruptedException {RetryPolicy retryPo

报错信息INFO[main-SendThread(localhost:12181):ClientCnxn$SendThread@959] - Socket connection established, initiating session, client: /xxxxxx:38806, server: localhost/xxxxx:12181INFO[main-SendThread(local