简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

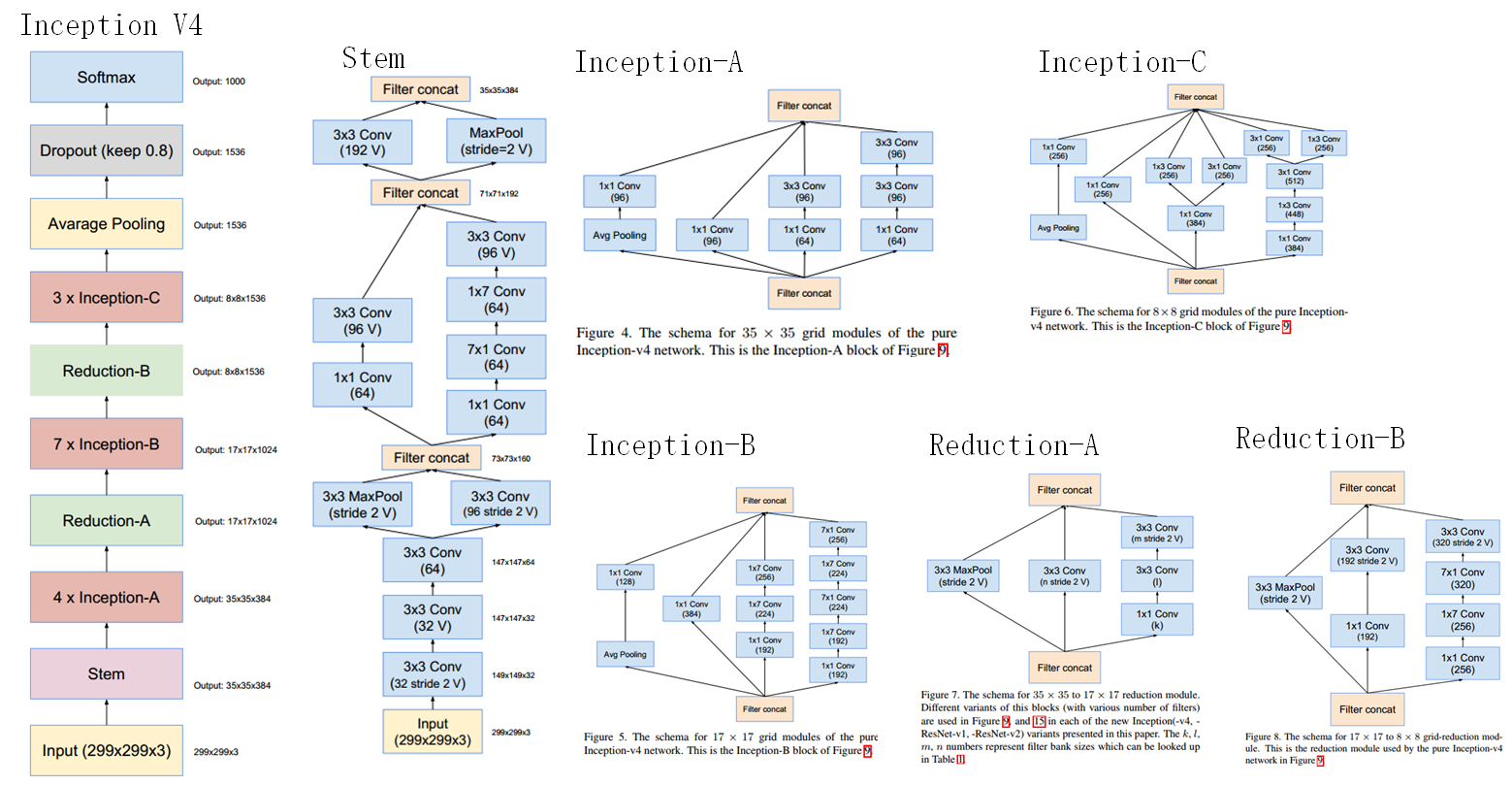

【深度学习】Inception模型结构解析,关键词:Inception-v1、v2、v3、v4、Inception-ResNet-v1、Inception-ResNet-v2

推荐系统中不得不说的 DSSM 双塔模型 - 知乎 (zhihu.com) 深度语义匹配模型DSSM及其变体CNN-DSSM, LSTM-DSSM - 知乎 (zhihu.com) (19条消息) 图解Transformer+DSSM_transformer dssm是啥_a flying bird的博客-CSDN博客

最近,本人在优化深度神经网络模型时发现为了减少预测标签值和真实标签值之间差距,不仅仅需提高模型本身的性能,还关乎于标签值标准化、数据集划分、模型超参数等一系列初始设定。其中后两项的实验内容俗称“炼丹”,很多研究人员已经炉火丹青,运筹帷幄,唯独标签值标准化容易被人忽略。一个优秀的标准化方法不仅能提高模型训练的稳定性,加速收敛,还能增强模型测试性能,可谓是中流砥柱。现有模型训练大多默认选用 Stand

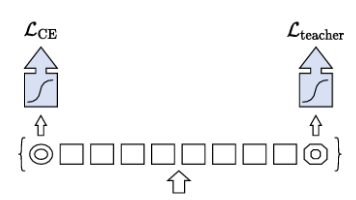

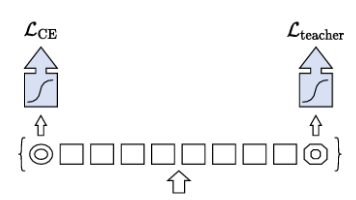

DeiT(Data-efficient Image Transformer)是由Facebook AI和索邦大学联合提出的高效视觉Transformer模型,通过引入注意力蒸馏(distillation through attention)机制显著提升了训练效率。相关资源包括:1)论文与源码(arXiv:2012.12877,GitHub开源);2)技术解析文章(51CTO/CSDN等平台详解模型

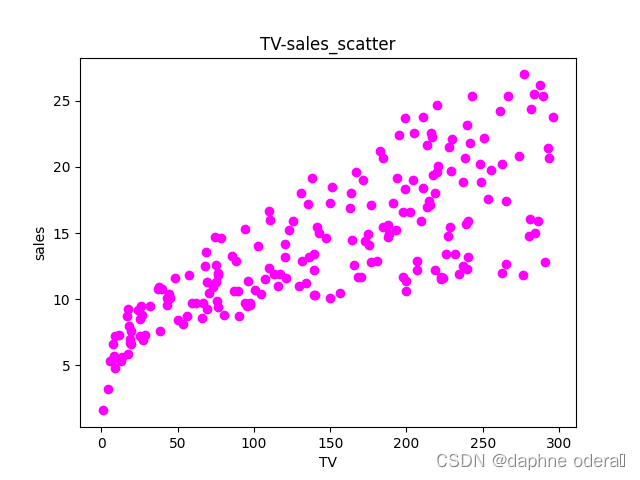

请建立多元回归模型分析电视媒体、广播媒体以及报纸媒体的广告投入与产品销售额之间的模型,并对模型进行预测、评估及优化

引用:python往mysql数据库中写入数据和更新插入数据 - 小学弟- - 博客园 (cnblogs.com)

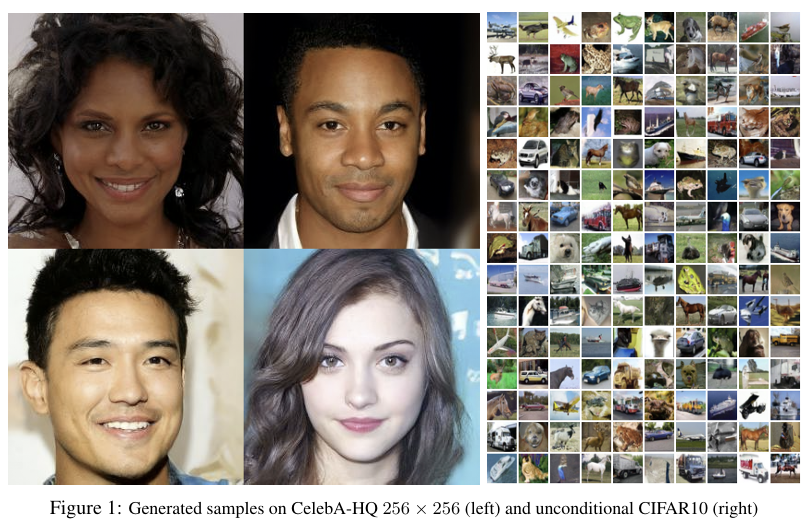

扩散模型是生成建模领域的前沿方法,通过逐步加噪和去噪过程实现高质量数据生成。其核心包括前向扩散(将数据扰动为噪声)和反向扩散(学习去噪),相比GAN具有更好的训练稳定性和生成效果。该模型已广泛应用于图像、语音等多模态任务。相关论文发表于UCBerkeley和OpenAI(arXiv:2006.11239)。学习资源包括知乎、博客园等平台的技术解析文章,涵盖原理推导、代码实现及经典论文导读。

DeiT(Data-efficient Image Transformer)是由Facebook AI和索邦大学联合提出的高效视觉Transformer模型,通过引入注意力蒸馏(distillation through attention)机制显著提升了训练效率。相关资源包括:1)论文与源码(arXiv:2012.12877,GitHub开源);2)技术解析文章(51CTO/CSDN等平台详解模型

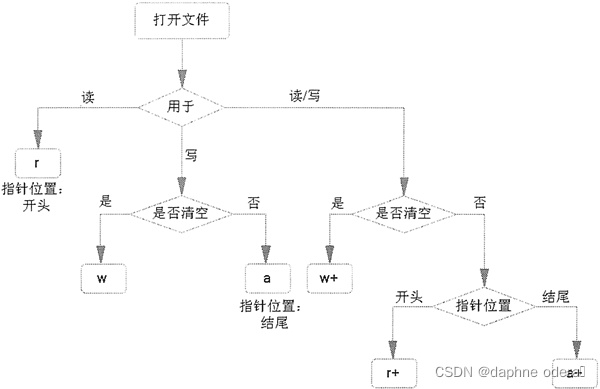

在训练模型前,根据模型文件存放地址判断文件是否存在,当文件不存在时,通过os.mknod()方法创建空文件,然后系统会报错,解决方法是 使用open("xxxx",mode = "w",encoding=None)

===============================================================Character Meaning--------- ---------------------------------------------------------------'r'open for reading (default)'w'open for writin