简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

大模型的尺度扩展定律告诉我们:『LLM的性能会随着模型的参数量、模型的训练量、模型的训练数据量的增加而增加』。训练存在尺度扩展定律,测试也存在尺度扩展定律,实践告诉我们在推理时候增大计算量,往往可以获得模型性能收益。那么在给定了计算预算的前提下,如何安排预算才能达到最好的模型效果呢?

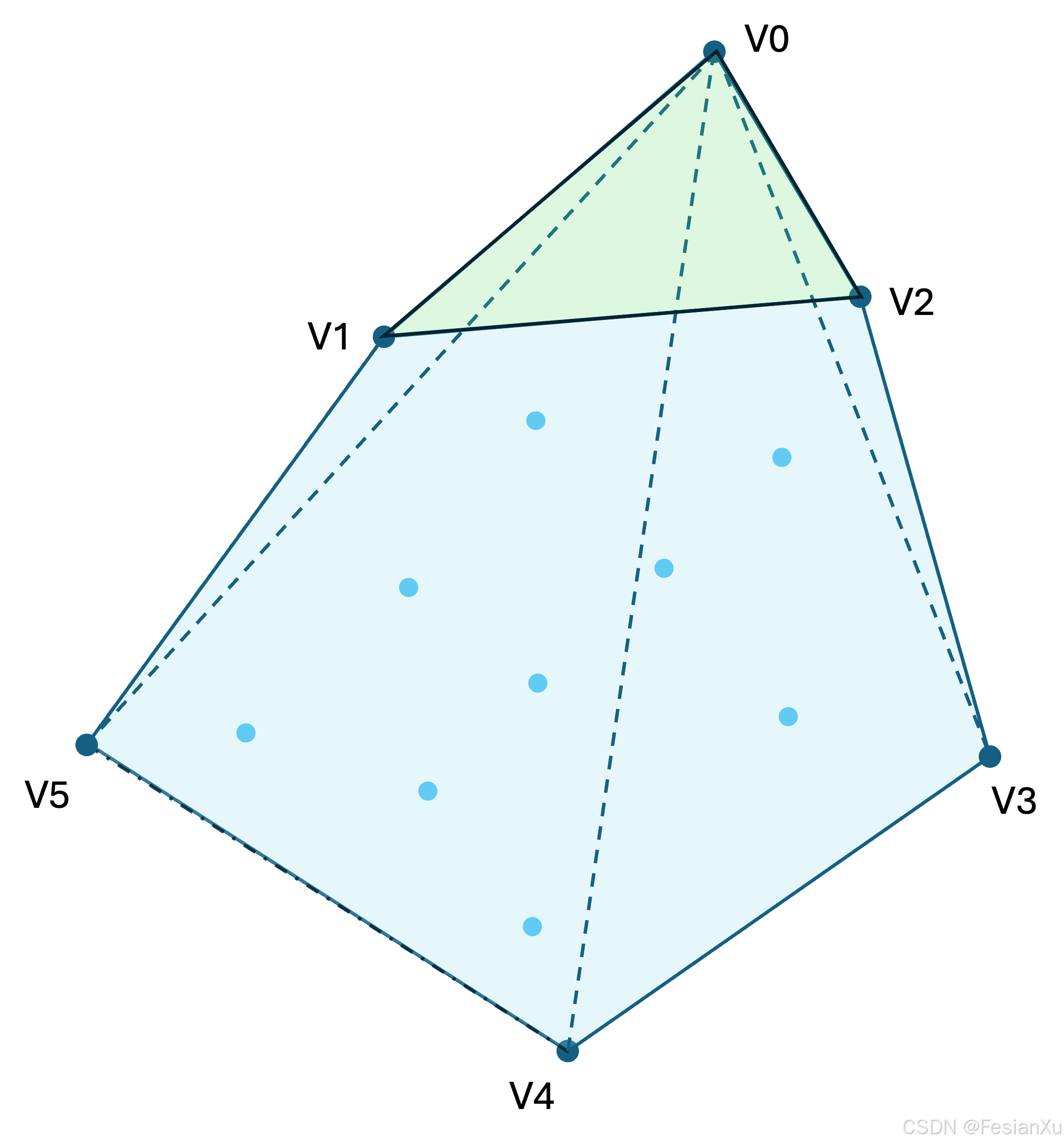

(Interpolation)得到,在世界多胞体之内的知识,只要提供了世界多胞体的节点集合(也可以认为是整个世界的最小知识集合),我认为是可以通过大模型去学习然后内插得到其他知识的,最终大模型得以建模整个世界多胞体,我把这个大模型称之为。此处,我假设世界大模型是没法进行。的真子集,其组成的世界多胞体,如Fig 1的蓝色区块所示(此处为了绘图方便,用二维图形代表多胞体),可以认为是整个世界的知识边界

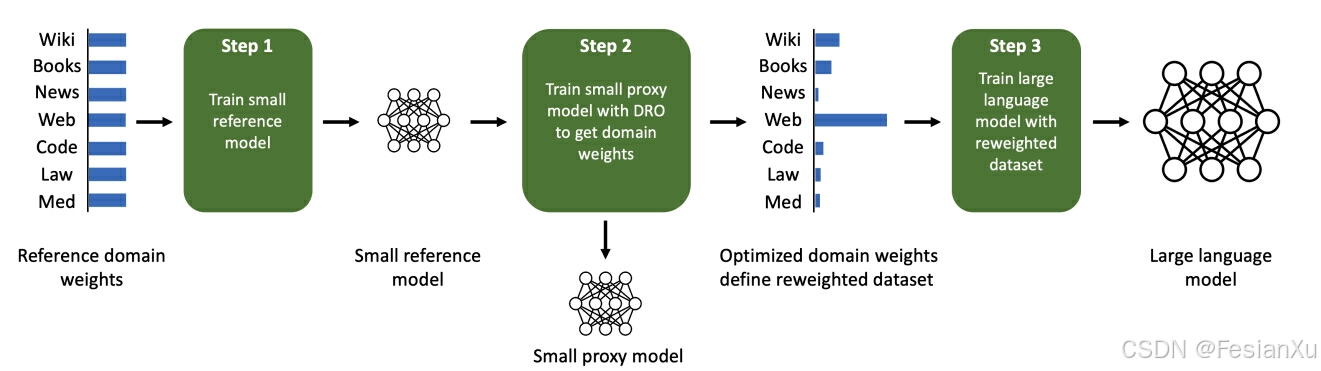

LLM的预训练是决定其底座能力的至关重要的步骤,其预训练数据通常会包含有多种领域的数据,如何调整不同领域的数据配比(可以理解为采样频率)是极其重要的大模型预训练研究点。本文介绍DeepMind提出的一种基于代理模型去估计最佳数据配比的方法,

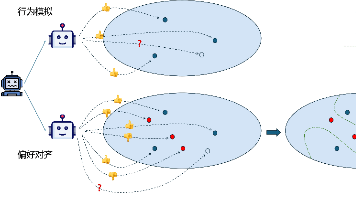

本文探讨了大语言模型(LLM)训练中的偏好对齐方法,重点介绍了直接偏好优化(DPO)和近端策略优化(PPO)两种方法。偏好对齐通过对比正负样本(如奖励模型筛选或人工标注)优化模型回答质量,避免仅依赖行为模拟(SFT)导致的泛化不足问题。DPO通过引入初始模型约束和Bradley-Terry偏好模型,稳定训练过程并防止奖励劫持。实验表明,无约束优化易生成无意义回答,而DPO结合KL散度约束能有效提升

Verifier 可以是一个独立的模型或模块,也可以是一个简单的规则检查器。Reward Model 通常是一个独立的模型,用于对模型的输出进行评分。

On-policy方法(如PPO)在LLM和RLHF中主要用于需要实时生成文本的场景,虽然训练稳定,但采样效率较低Off-policy方法(如DPO)则更适合利用历史数据进行高效训练,尤其在大规模数据和异步训练场景中表现出色选择哪种方法取决于具体的应用场景和资源限制。

conv2d(input,filter,strides,padding,use_cudnn_on_gpu=None,data_format=None,name=None)input是一个4d输入[batch_size, in_height, in_width, n_channels],表示图片的批数,大小和通道。filter

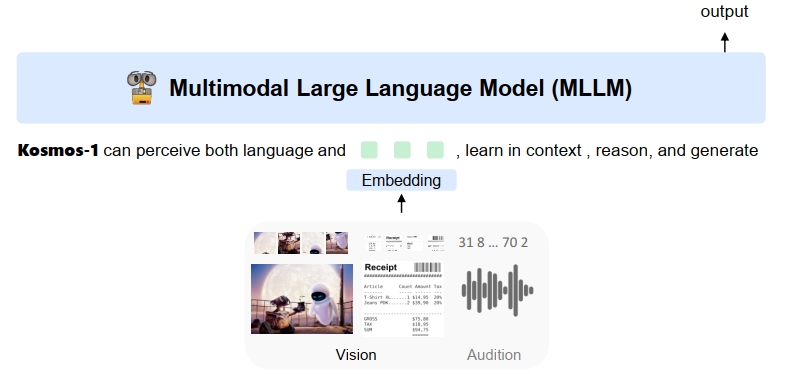

kosmos 构建一个通用接口的多模态大语言模型

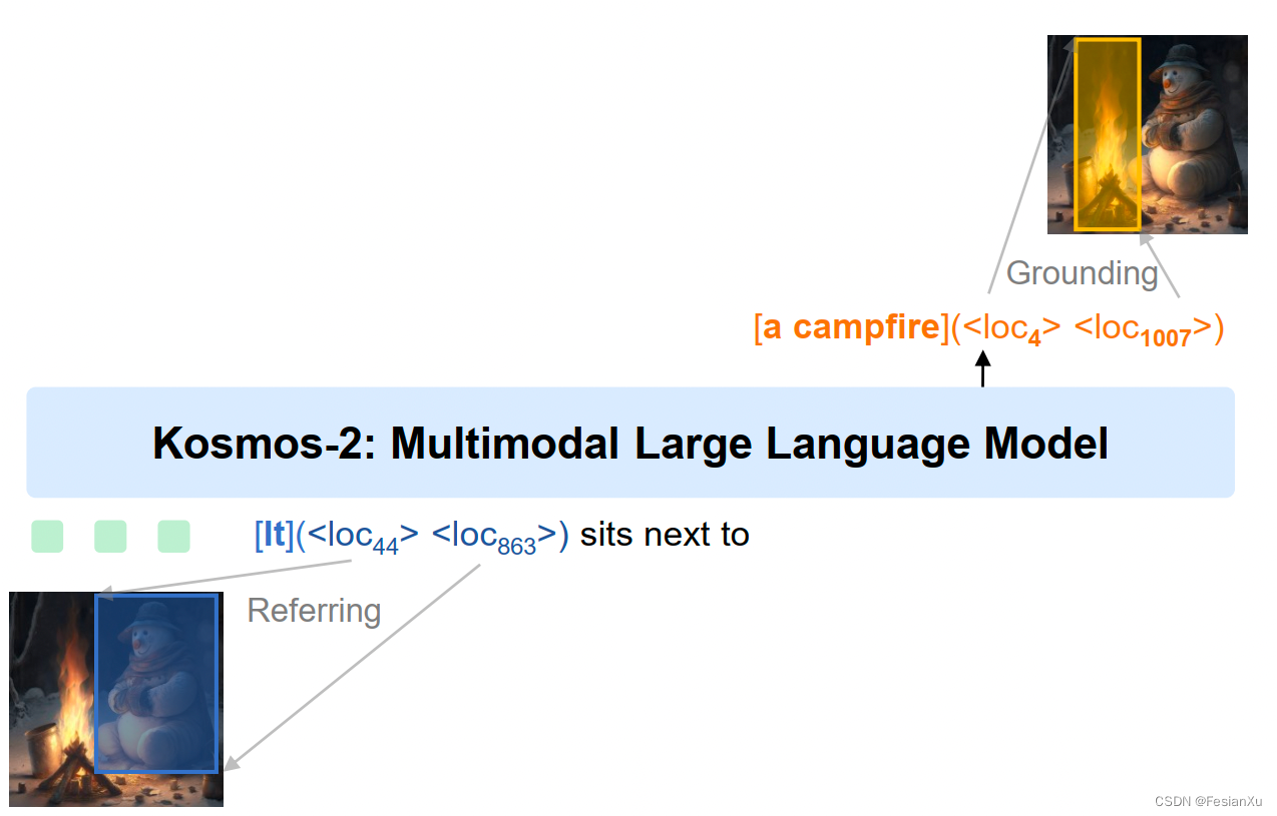

kosmos-2:一种提供了基准和指代能力的多模态大语言模型

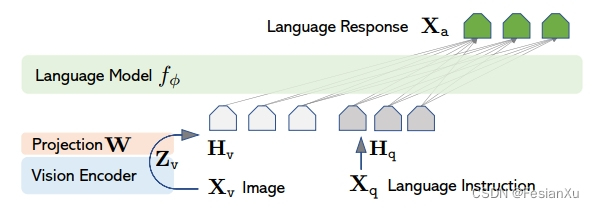

如何将已预训练好的大规模语言模型(LLM)和多模态模型(如CLIP)进行融合,形成一个多模态大语言模型(MLLM)是目前很火热的研究课题。本文将要介绍的LLava是一个经典的工作,其采用了指令微调的方式对MLLM进行训练,笔者在此笔记,希望对诸位读者有所帮助。