简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

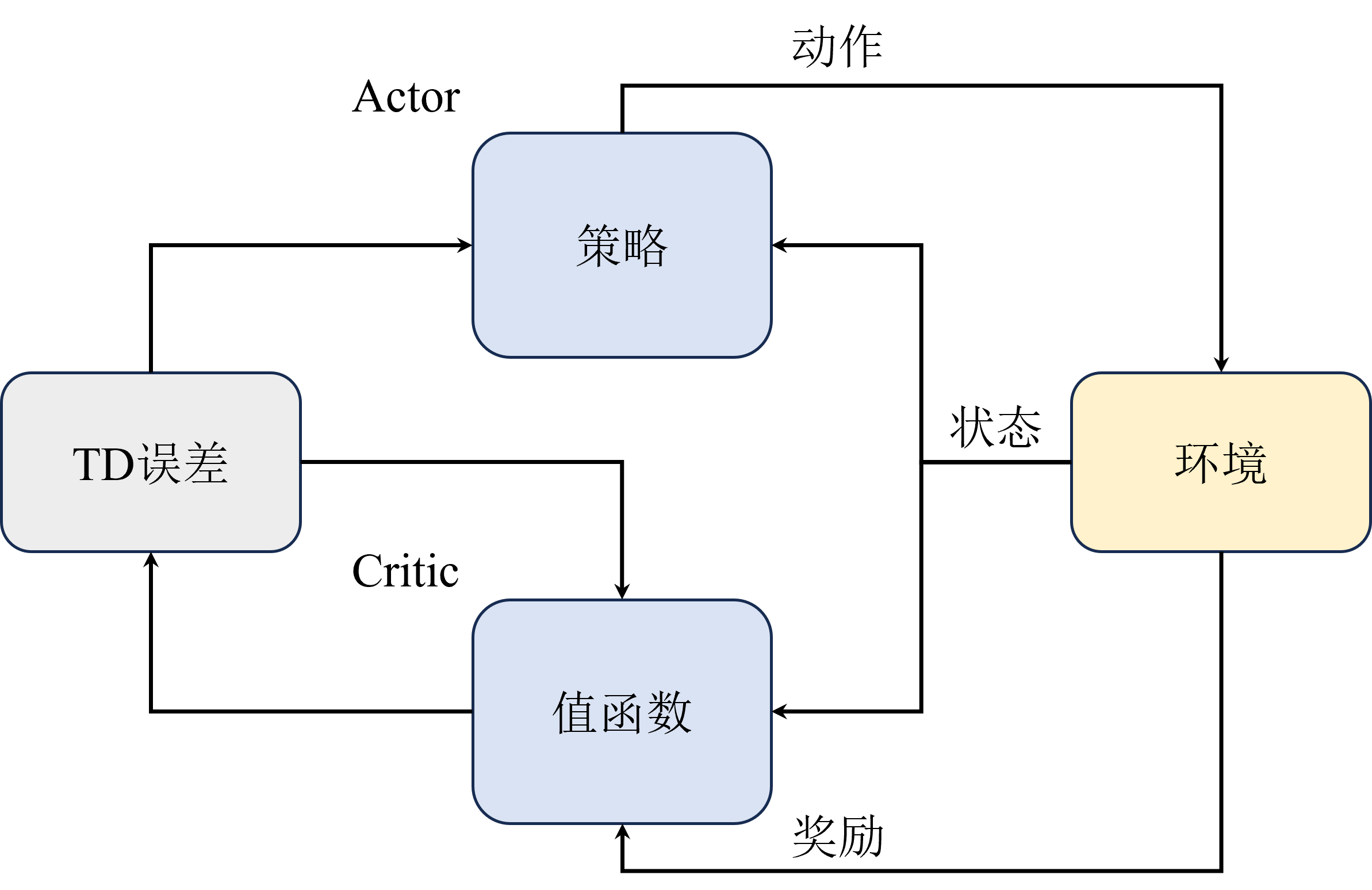

相比REINFORCE算法,为什么A2C可以提升速度?A2C增加了Critic组件用于估计状态价值,这样Actor可以利用Critic提供的价值信息来更新策略,使得学习过程更加高效。A2C、A3C是on-policy的吗?A2C算法是on-policy的,因为它根据当前策略生成的样本来更新这个策略,这意味着它评估和改进的是同一个策略。A3C算法虽然采用了异步的更新机制,但它本质上仍然是on-pol

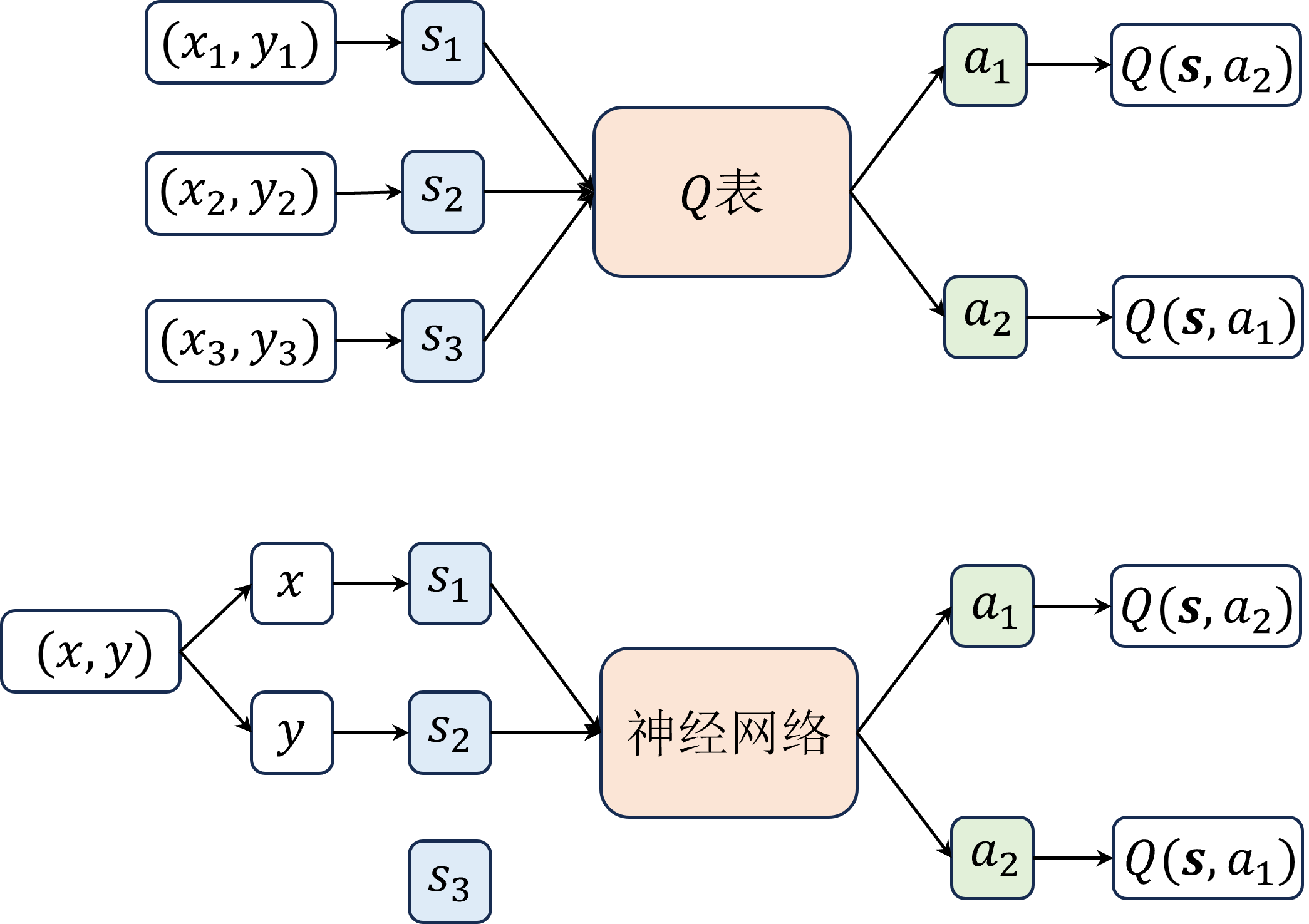

Dueling DQN修改的是网络结构,算法中在输出层之前分流( dueling )出了两个层,如图所示,一个是优势层,用于估计每个动作带来的优势,输出维度为动作数一个是价值层,用于估计每个状态的价值,输出维度为 1。在传统的DQN中,选择和评估动作的Q值使用相同的网络,这可能导致在某些状态下对某些动作的Q值被高估,从而影响学习的稳定性和最终策略的质量。经验回放:通过存储代理的经验(状态,动作,奖

本文介绍了Transformer及其衍生模型BERT、Sentence-BERT和GraphCodeBERT的核心原理与应用。Transformer通过自注意力机制实现并行处理,成为大模型基础架构。BERT在此基础上采用双向编码器和预训练任务(MLM和NSP),提升语言理解能力。Sentence-BERT通过孪生网络结构优化句子向量表示,实现高效语义相似度计算。GraphCodeBERT则专为代码

CatBoost 是由俄罗斯搜索巨头 Yandex 于 2017 年开源的机器学习库,其名称来源于 “Category” 和 “Boosting” 的组合,旨在高效处理类别特征的梯度提升算法。支持类别特征:无需对类别特征进行独热编码,直接处理类别数据,避免数据膨胀。对缺失值的鲁棒性:无需特殊预处理即可直接处理缺失值。防止过拟合:内置多种正则化手段,减少梯度偏差和预测偏移,提高模型的准确性和泛化能力

本文旨在展示如何利用langchain快速封装自定义LLM,从而突破现有环境下对OpenAI API Key的依赖。通过langchain的LLM类或现有项目的类继承,再修改特定的回调方法即可实现更加个性化和灵活的LLM应用,推动项目快速进展。

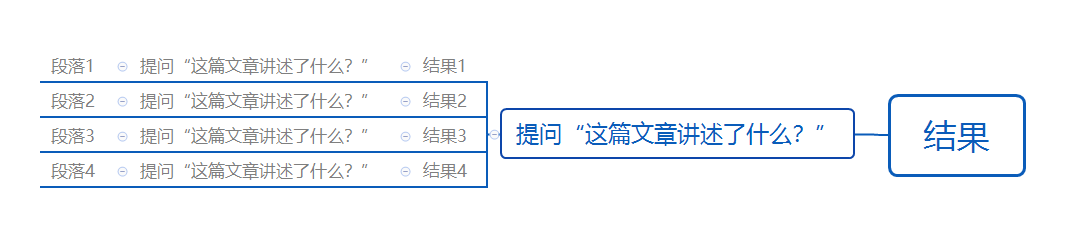

在使用llama_index进行内容提炼、文章总结时,我们可以通过设置不同的ResponseMode来控制生成响应的结果。

【Datawhale AI 夏令营】第四期 基于2B源大模型RAG 的三体问答,特点:手工文档切块、调优。

HTTPS 协议:大多数现代浏览器只允许在 HTTPS 协议或localhost上使用摄像头和麦克风等硬件设备。如果你在开发环境中使用 HTTP,可能会遇到为undefined的问题。建议在开发和生产环境中都使用 HTTPS。你可以使用ngrok或serveo.net等工具将本地服务器暴露为 HTTPS 服务。权限问题:在调用时,需要处理用户拒绝权限请求的情况。可以通过捕获错误并提示用户检查权限设

首先,我们需要创建一个自定义的 LLM 类来封装大语言模型的调用。CustomLLM,@property通过以上步骤,我们实现了一个基础的 LLM 工具调用和 RAG 系统。执行基础的数学运算查询数据库解析和检索 Markdown 文档回答基于知识库的问题你也可以基于这个框架,根据自己的需求扩展更多功能。

TraeAgent创新性地将确定性工具链与大模型结合,解决了AI编程中的关键难题。其核心突破在于:1)采用基于精确字符串匹配的编辑工具,通过"唯一性匹配"机制确保代码修改的准确性;2)构建代码知识图谱(CKG)实现结构化检索,结合传统Bash工具完成文本检索,形成混合检索策略。这种设计将LLM定位为"决策者",而将易错操作交由确定性工具执行,有效降低了AI编