简介

该用户还未填写简介

擅长的技术栈

可提供的服务

技术咨询

语料安全:解决“垃圾进,垃圾出”的问题,确保模型“学得好”。推理安全:解决“学好也会变坏”的问题,确保模型“用得好”。

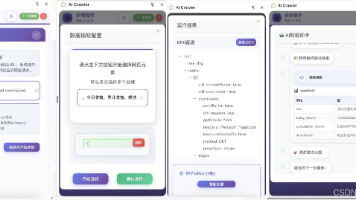

【摘要】互金公司随着AI发展面临爬虫需求激增与资源排期问题。现有低代码平台虽降低门槛,但仍需用户掌握数据提取技能。为此拟开发智能爬虫插件,通过大模型技术完全消除XPath等专业需求,使非技术用户也能轻松采集数据,提升平台易用性和覆盖范围。该方案将结合现有平台与AI能力,实现零代码操作体验。

本文介绍了如何使用预训练深度学习模型进行监督微调(Supervised Fine-Tuning, SFT),以优化模型在特定任务上的表现。微调过程涉及在有标签的数据集上训练模型,通过最小化预测结果与真实标签之间的差异来调整模型参数。关键步骤包括选择合适的数据集、设置训练参数(如学习率、批次大小、训练轮数等),以及使用特定的微调技术(如LoRA)。此外,文章还详细说明了如何通过命令行参数配置训练过程

摘要:国产昇腾910B AI芯片采用7nm EUV制程,集成32个达芬奇核心,FP16算力达376 TFLOPS,超越英伟达A100。搭载64GB HBM2e显存,支持8卡并行,能效比提升40%。应用覆盖自动驾驶(性能提升2倍)、大模型推理(Qwen-72B吞吐>3500 tokens/s)及工业质检(精度99.5%)。软件生态支持PyTorch/TensorFlow迁移,国产化适配率超60%。相

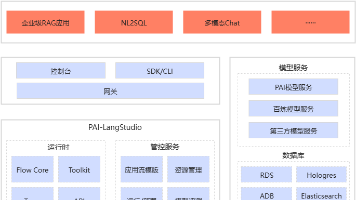

大模型应用开发(LangStudio)是依托PAI产品和阿里云其他云产品能力构建的面向企业级用户的大模型应用开发平台。该平台采用直观的交互式开发环境,简化了企业级大模型应用的开发流程,同时提供了灵活的可编程能力、实时调试能力与链路追踪的能力,让您在构建大模型应用时可对整体性能进行评估与优化。通过一键部署到PAI-EAS,您可以将开发好的大模型应用部署至生产环境提供API服务。

linux CentOS 7.9 安装 ffmpeg 6.0

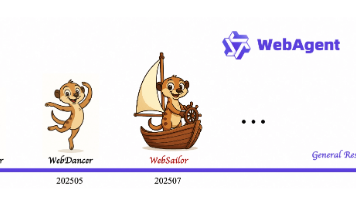

摘要: 阿里巴巴通义实验室开源WebSailor网络智能体,突破复杂信息检索任务的技术瓶颈。其核心创新包括: 三级任务体系(基础检索→多跳推理→跨域关联)和数据模糊化技术,提升模型应对不确定性的能力; DUPO强化学习算法动态优化训练,推理效率提升3倍; 开源标杆性能:BrowseComp-en准确率12%(开源首次破10%),中文任务接近闭源领先水平。 应用覆盖模糊查询、企业获客、科研辅助等场景

OpenDataLab 团队致力于构建 AI 开放数据生态,推动数据要素对大模型领域全面赋能。OpenDataLab 是上海人工智能实验室的大模型数据基座团队打造的数据开放平台,现已成为中国大模型语料数据联盟开源数据服务指定平台,为开发者提供全链条的 AI 数据支持,应对和解决数据处理中的风险与挑战,推动 AI 研究及应用。数据集中心支持多元数据管理,数据中心提供公开数据集的展示、检索和下载等,同

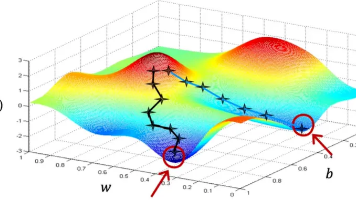

本文系统性地介绍了神经网络的基本原理及其发展历程。从最简单的线性函数开始,逐步阐述了如何通过激活函数构建非线性神经网络,并详细解释了前向传播、反向传播和梯度下降等核心概念。文章还探讨了过拟合问题及其解决方案,包括正则化和Dropout等技术。最后,重点讲解了Transformer架构及其核心的注意力机制,说明了大模型如何通过预测下一个词来实现各种应用。全文通过层层递进的方式,帮助读者深入理解神经网