简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

正值立春,万物复苏。在 AI 算力需求持续井喷的当下,阿里云瑶池数据库举行“Tair KVCache 商业化暨开源发布会”,宣布正式推出面向大模型推理的缓存加速方案——Tair KVCache。此次发布会以“Cache 新春|击穿显存墙,开启算力新生”为主题,重磅开源了核心组件 Tair KVCache Manager 及高保真仿真工具 Tair KVCache HiSim,并正式上线了 Tair

正值立春,万物复苏。在 AI 算力需求持续井喷的当下,阿里云瑶池数据库举行“Tair KVCache 商业化暨开源发布会”,宣布正式推出面向大模型推理的缓存加速方案——Tair KVCache。此次发布会以“Cache 新春|击穿显存墙,开启算力新生”为主题,重磅开源了核心组件 Tair KVCache Manager 及高保真仿真工具 Tair KVCache HiSim,并正式上线了 Tair

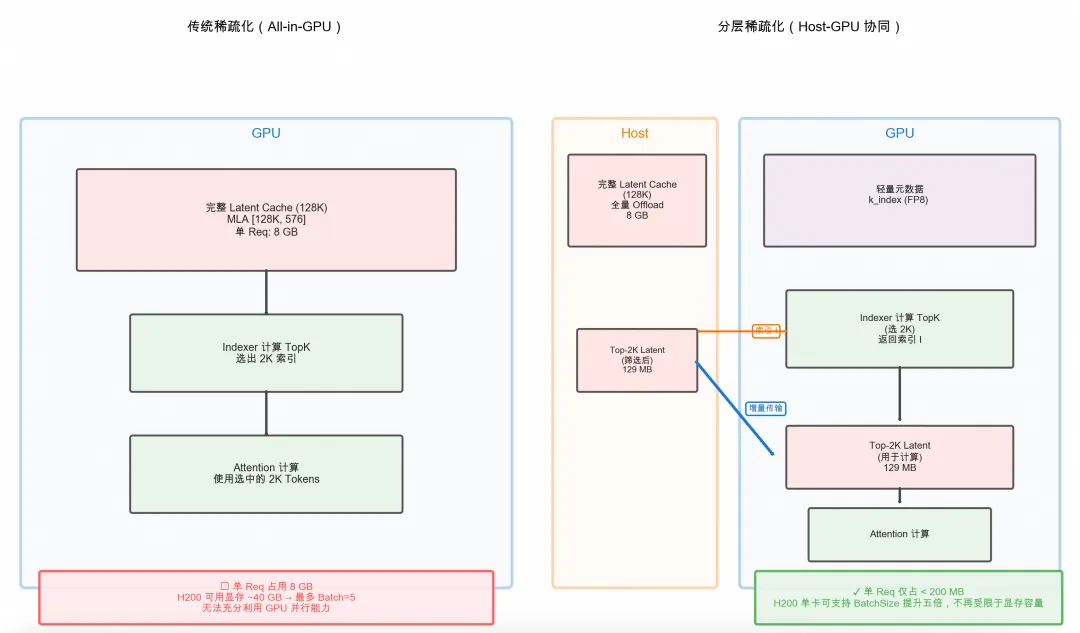

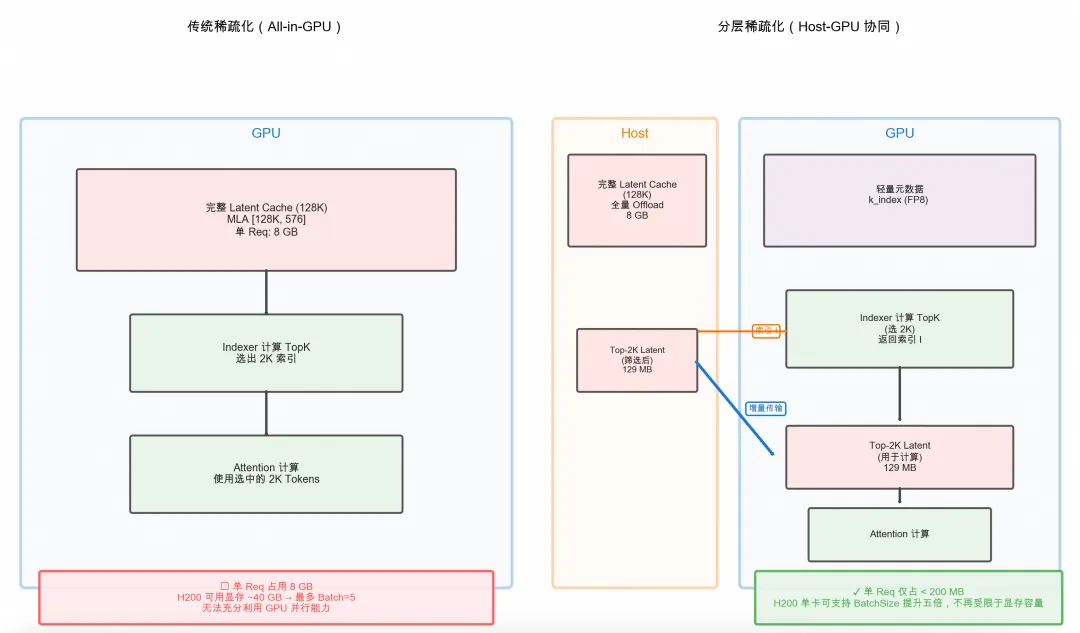

和 DeepSeek-V3.1 相比,DeepSeek-V3.2 的架构改动是在继续训练过程中引入了 DeepSeek Sparse Attention(DSA)。DSA的原型设计由两部分进行构成,Lightning Indexer(闪电索引器)和 Fine-grained Token Selection Mechanism(细粒度 Token 选择机制)。其首先通过一个轻量级的索引器,进行快速筛

和 DeepSeek-V3.1 相比,DeepSeek-V3.2 的架构改动是在继续训练过程中引入了 DeepSeek Sparse Attention(DSA)。DSA的原型设计由两部分进行构成,Lightning Indexer(闪电索引器)和 Fine-grained Token Selection Mechanism(细粒度 Token 选择机制)。其首先通过一个轻量级的索引器,进行快速筛

Tair KVCache 是阿里云推出的面向大语言模型推理场景的缓存加速服务,基于分布式内存池化和分级缓存体系,解决显存墙与带宽瓶颈问题。为万亿参数模型的高效推理提供技术保障,推动 AI 算力进化与规模化应用。

本文系统剖析面向智能体推理的 KVCache 技术演进,针对传统机制在长上下文、多轮决策与多智能体协同中的状态膨胀、持久化缺失和缓存孤立三大瓶颈,介绍阿里云 Tair KVCache 团队联合 SGLang 社区推出的 HiCache 分层缓存体系。该方案通过显存-内存-3FS 多级卸载与全局共享,实现缓存命中率提升至80%,TTFT 降低56%,推理 QPS 翻倍,支撑智能体时代的大模型高效推理

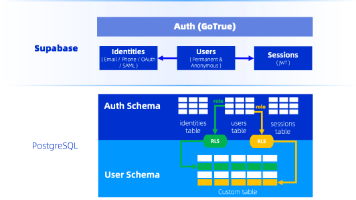

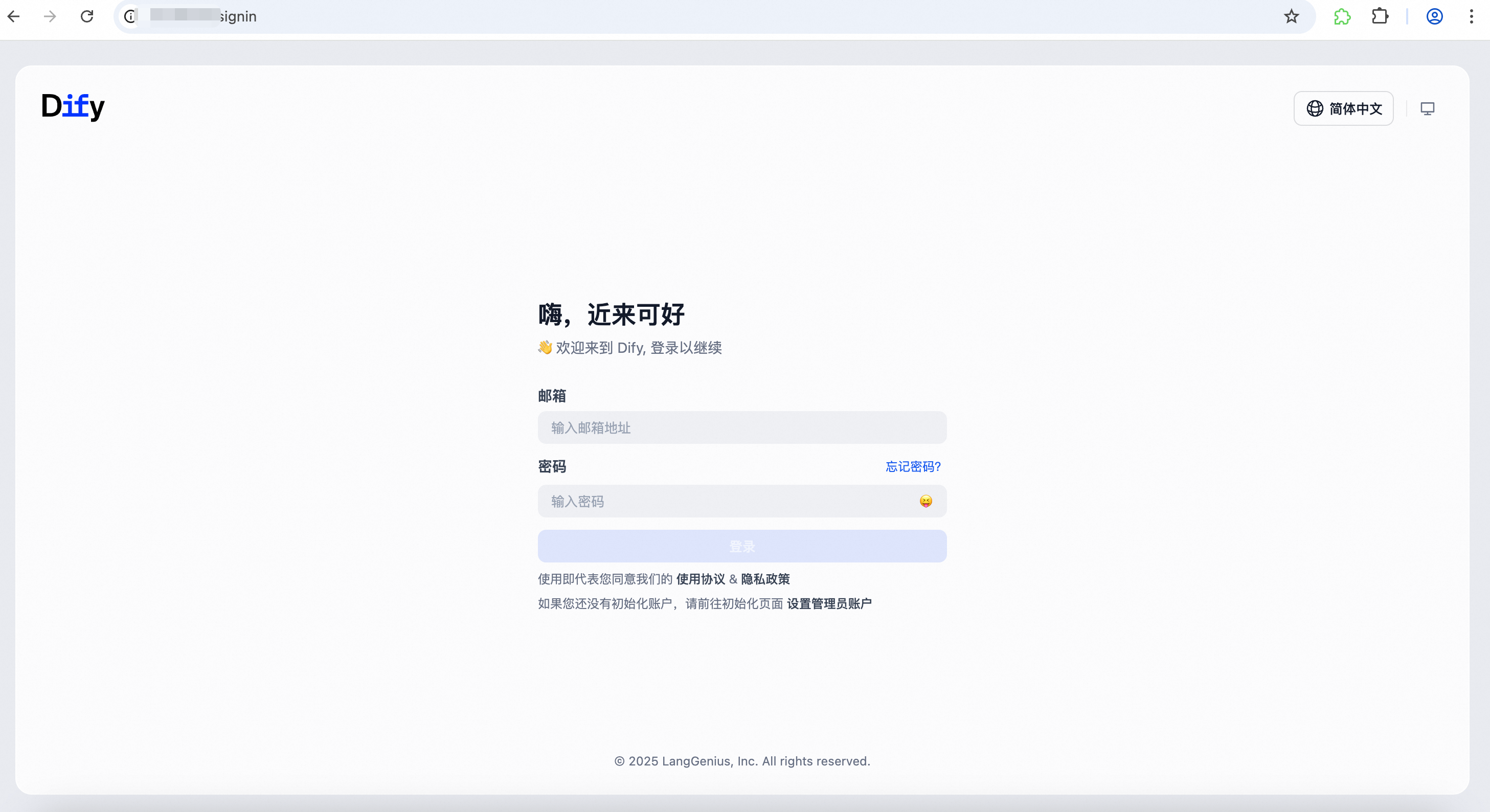

本文介绍如何使用Dify、云原生数据仓库AnalyticDB PostgreSQL版的Supabase和LLM构建一个AI客服系统,帮助在线服装店高效处理售后咨询、订单查询和个性化回复。通过结合Dify的工作流能力、Supabase的实时数据存储与LLM的自然语言理解能力,实现快速自动化响应,显著减轻人工客服压力并提升客户满意度。

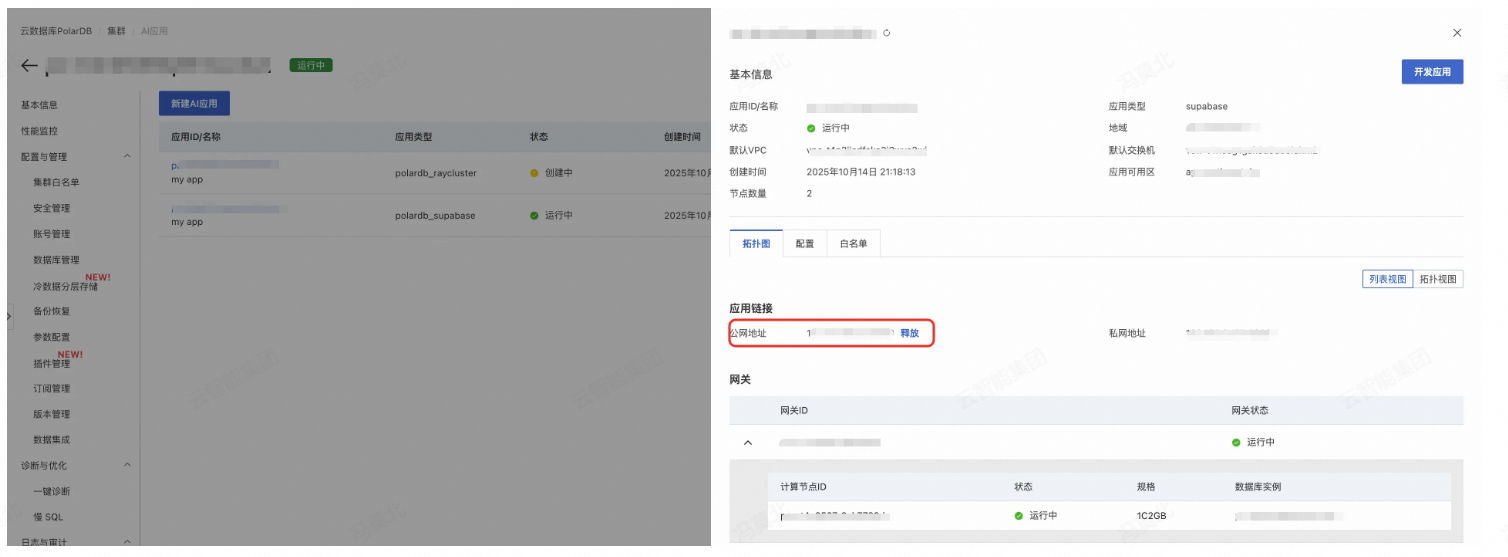

VibeCoding是AI驱动的编程新范式,开发者通过自然语言描述需求,由AI完成全栈开发。结合Qoder与PolarDB Supabase MCP Server,可填补前后端断层,实现高效全栈应用生成,显著降低开发门槛,提升非专业者的开发效率。

用户完成任务后需点击“领取奖品”按钮,并前往积分商城,请于7日内在“待领取积分”处点击“一键领取”,逾期积分将失效无法领取。2、在活动结束后,我们将在所有成功完成全部任务的用户中随机抽取3名幸运用户,每人赠送德尔玛加湿器1台,前30名完成全部任务的用户还可获得保温杯1个,主办方将在2025年12月26日前通过社区站内信通知获奖用户具体领奖方式。4、获得积分后奖励后有效期为7天,请于7日内前往积分商

本文通过一个 Agentic RAG 应用的完整构建流程,展示了如何借助 RDS Supabase 快速搭建具备知识处理与智能决策能力的 AI 应用,展示从数据准备到应用部署的全流程,相较于传统开发模式效率大幅提升。