简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

欢迎关注公众号【】【此前,我们一同探寻了词嵌入的基础概念与相关技术的冰山一角,今天,让我们继续深入这片知识的海洋,从 3.2 Static Embeddings(静态嵌入)部分开始,进一步挖掘词嵌入技术的奥秘。

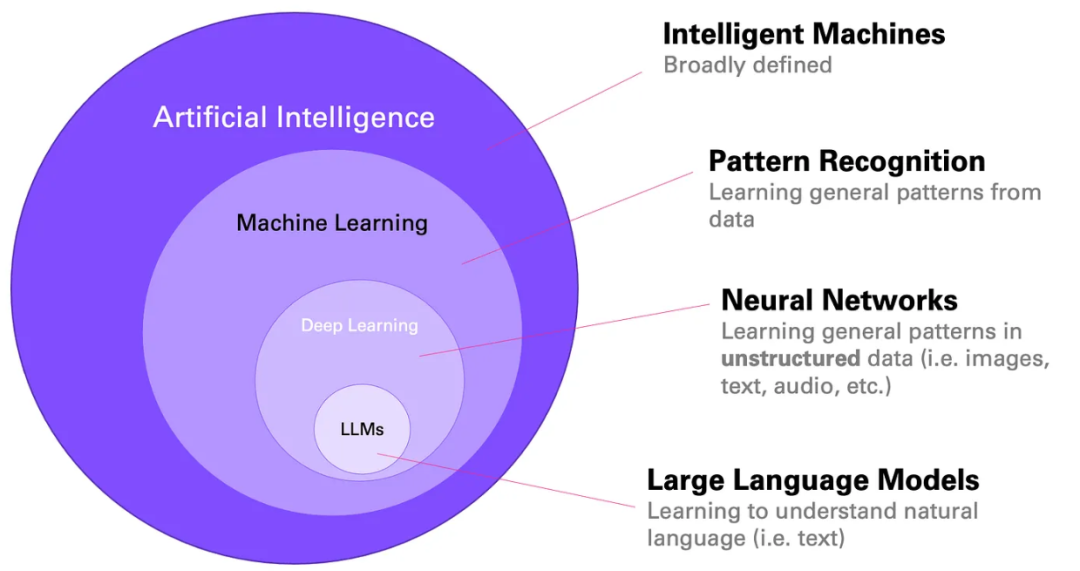

在自然语言处理(NLP)和人工智能(AI)的浩瀚星空中,大语言模型(Large Language Models, LLMs)如同一颗璀璨的新星,正在改变我们与语言、与机器交互的方式。本章将带您踏上一段探索之旅,揭示大语言模型的发展历程、独特魅力及其在现实世界中的多彩应用。

*?**(如果你还不知道,它的表现确实非常出色。只需粘贴一份文档,然后让它生成摘要即可。要理解其中的原因,我们需要考虑训练数据的情况。事实上,人们经常会对文本进行摘要——无论是在互联网上、研究论文中、书籍中,还是其他地方。因此,一个在这些数据上训练出来的 LLM 也学会了如何进行摘要。它学会了抓住主要观点,并将它们压缩成一段简短的文本。请注意,当生成摘要时,完整的文本其实是 LLM 的输入序列的一

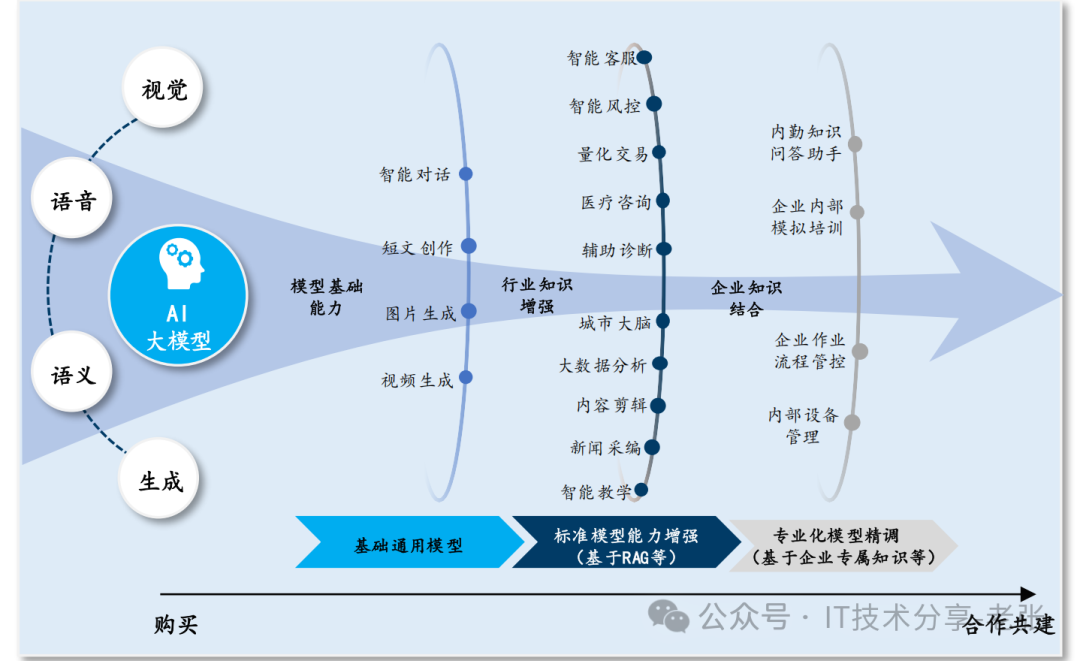

AI大模型指具有。

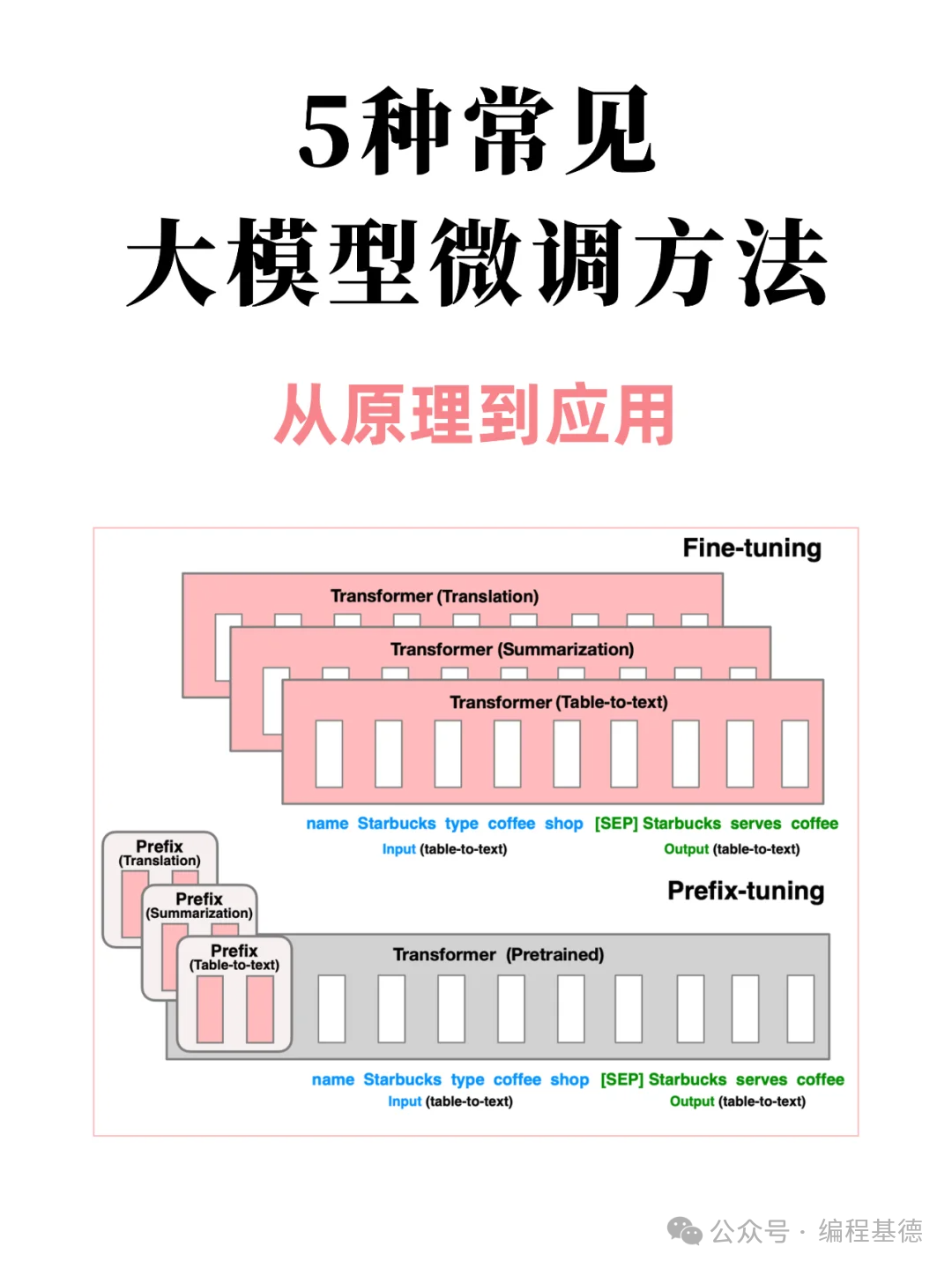

1️⃣ LoRA:轻盈低秩,微调新风尚LoRA,作为大模型微调领域的璀璨新星,以其独特的低秩逼近技术闪耀登场。通过在模型层间巧妙添加低秩矩阵,LoRA不仅精准捕捉任务精髓,还极大减轻了计算与存储负担。无需大刀阔斧,细微调整间尽显智慧光芒。2️⃣ Adapter-Tuning:小巧适配器,任务转换高手想象一下,给庞大的预训练模型装上一个个小巧的“适配器”,它们就是Adapter-Tuning的精髓所

哈喽,大家好,我是木易巷~随着人工智能技术的迅猛发展,自然语言处理(NLP)成为了热门话题。在众多NLP模型中,科大讯飞星火认知大模型成为了一个备受瞩目的新秀,今天我们来了解一下这个由科大讯飞公司开发的人工智能模型~(内测方法在文末)!5月6日,讯飞星火认知大模型终于揭开了神秘的面纱。在此次发布会上,科大讯飞董事长刘庆峰和研究院院长刘聪现场测试了星火大模型的七大核心能力,并发布了基于该大模型的教育

是一个支持在、和上本地运行大语言模型的工具。它允许用户非常方便地运行和使用各种大语言模型,比如模型等。用户只需一行命令就可以启动模型。主要特点包括:跨平台支持、、系统。提供了丰富的模型库,包括、等1700+大语言模型,可以在官网中直接下载使用。支持用户上传自己的模型。用户可以将等地方的格式模型导入到中使用。也可以将基于等格式的模型转换为格式后导入。允许用户通过编写配置文件来自定义模型的推理参数,如

本文介绍了如何使用PyTorch的Torchtune库进行大型语言模型(LLM)的微调。Torchtune提供了一套简单、灵活、高效的工具和框架,使得研究人员和开发者能够轻松地对LLM进行调试、训练和部署。文章详细介绍了Torchtune的设计原则、核心概念和主要特性,并通过一个完整的实例演示了如何使用Torchtune微调LLaMA-2-7B模型。此外,文章还介绍了两种参数高效的微调方法:LoR

1、列出本地可用的模型列表:ollama list2、启动模型:ollama runmodel_name3、查看模型信息:ollama showmodel_name4、删除指定模型:ollama rmmodel_name2 部署AnythingLLM2.1 下载安装打开官网地址:https://anythingllm.com/desktop,根据自己的系统选择下载的版本。默认路径安装,或者修改默认

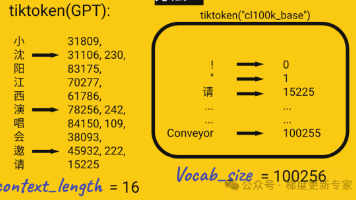

大模型学习可以理解为训练一个猴子,行业内人士称训练的过程是炼丹,这也有一定的道理,因为大模型学会哪些知识都是不可控的,需要多次尝试,需要一定的运气成分在里面。大模型学习知识的本质,其实就是把文本转换成的数字,写入大模型的词汇表里,词汇表是个大型的空间矩阵,空间矩阵每个维度(列),就是代表了某个词的一个含义,比如:苹果有水果和手机等多种含义。大模型学习过程就是通过训练,把现实世界的词汇含义,映射到此