简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

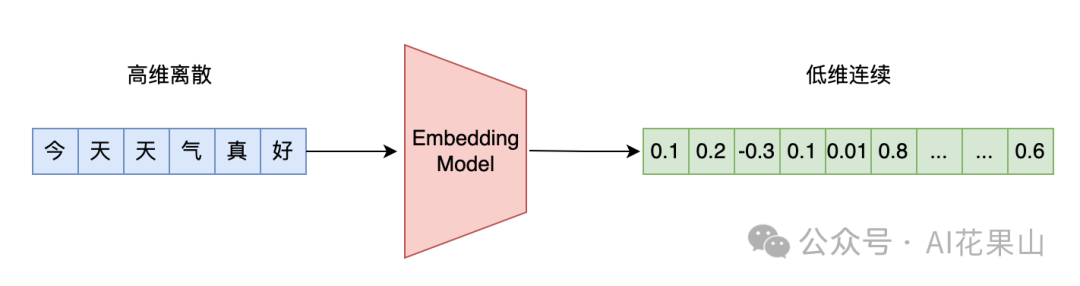

万物皆可 Embedding。在推荐系统、自然语言处理和计算机视觉等领域,Embedding 是一个非常重要的概念。Embedding 的本质是一种将高维稀疏数据转换为低维稠密向量的技术,通过这种转换,能够捕捉数据中的语义或特征关系。具体来说,Embedding 用一个多维稠密向量来表示事物的多维特征,从而在一个连续的向量空间中刻画事物之间的相似性和差异性。这种表示方式不仅提高了计算效率,还增强了

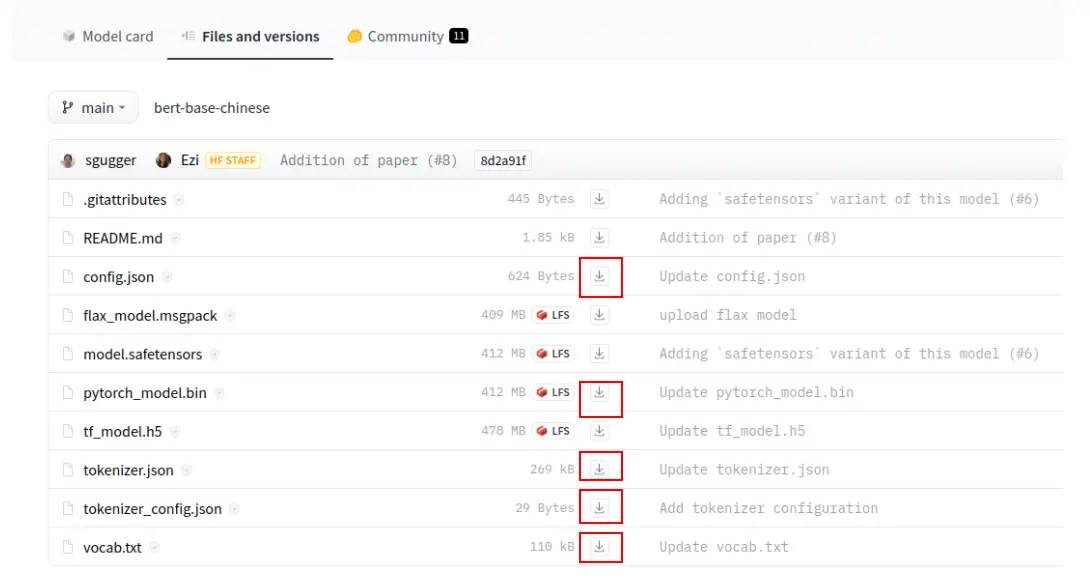

本节的中文实体链接针对的是一个中文实体的全称和简称的链接,即输入一对候选的中文名称预测他们是否是一对全简称,比如**“奥林匹克运动会”和“奥运会”是正样本**,而**“奥林匹克运动会”和“亚运会”则是负样本。该任务本质上是文本二分类,输入是一对中文文本,而Bert的输入也是**形式的一对文本,因此引入Bert预训练模型再结合本任务特定的全简称正负样本进行微调。预训练模型类似一个人已经学习了语言的基

本文详细对比分析了torchtitan、megatron、xdit、vllm等9个主流大模型训练/推理/RL框架,包括其核心特点、优势与局限性。文章从分布式训练、并行策略、资源管理等角度深入剖析各框架设计理念,并结合实际应用场景提供选择建议,为大模型开发者提供全面的技术参考和实践指导。

在当今科技飞速发展的时代,人工智能(AI)已经不再局限于科幻小说的幻想,而是成为我们日常生活中不可或缺的一部分。OpenAI这样的组织正引领着这场技术革命,特别是其背后的大型语言模型(LLMs)。同时,在软件开发领域,JavaScript作为一门多才多艺的语言,通过Node.js这一平台,正以前所未有的方式融合前端、后端乃至AI应用,展现其“一勺烩”的魅力。接下来,让我们深入探讨这两个前沿领域的发

然而,微调模型存在一个显明问题,其“幻觉”现象较基础模型更为严重,生成的回答常包含许多与事实不符的内容,影响实际应用的可靠性。其次,RAG支持更为复杂的查询方式,能够处理多层次和多维度的问题,不依赖单一的关键词匹配。由此可见,为提高政务AI系统的可靠性,除了确保回答的准确性外,还需加强其可解释性,以帮助用户理解每个回答的依据,此举亦有助提升系统的透明度和信任度。很多人学习大模型的时候没有方向,东学

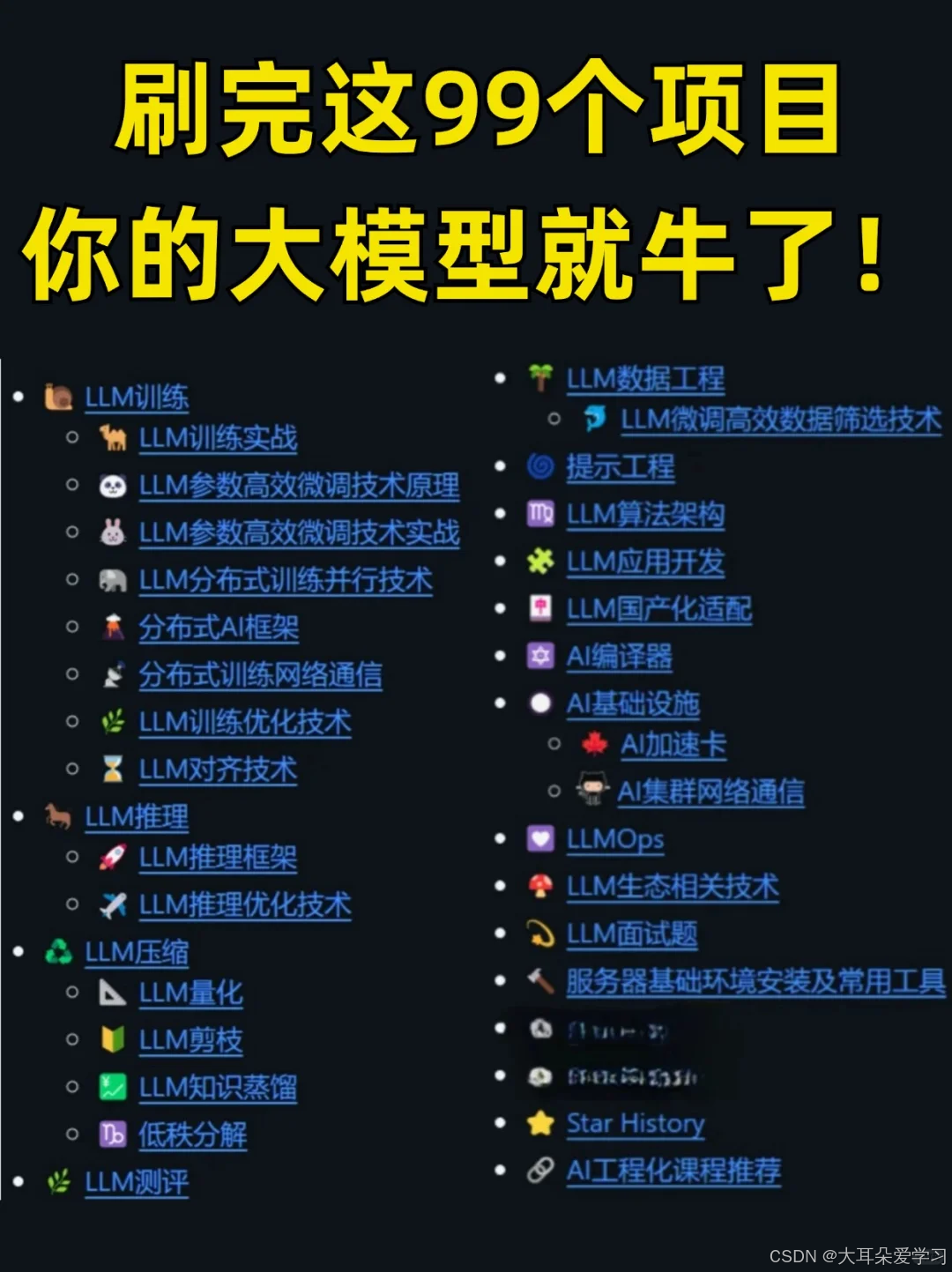

LLM的应用场景不是独立的,而是和其他业务结合生成的新智能服务,这就是为什么多练习大模型项目如此重要。而理解了这点,也就知道了大模型应用的潜力有多巨大。练习项目不仅是对原理和概念的加深理解,更是对如何结合业务,业务逻辑的深度理解。要落到实际的应用场景,肯定需要对应用场景本身有足够的了解。而要理解场景,需要对大模型有足够的知识积累和实战经验。这些项目不仅收集了大模型训练实战,还有微调,分布式等训练,

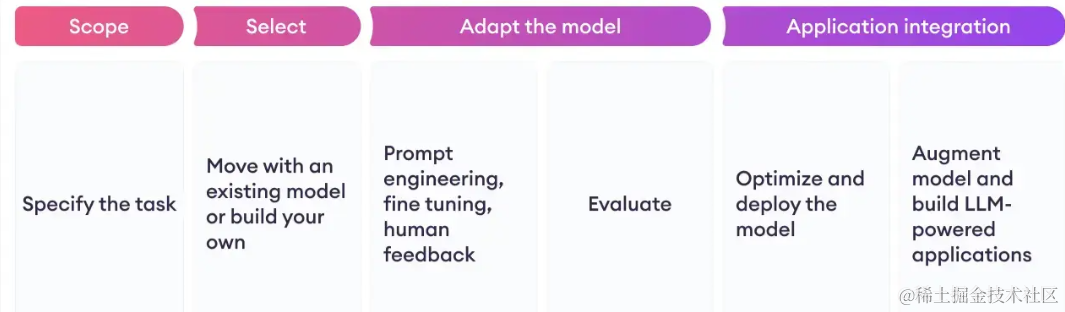

众所周知,大语言模型(LLM)正在飞速发展,各行业都有了自己的大模型。其中,大模型微调技术在此过程中起到了非常关键的作用,它提升了模型的生成效率和适应性,使其能够在多样化的应用场景中发挥更大的价值。那么,今天这篇文章就带大家深入了解大模型微调。其中主要包括什么是大模型微调、什么时候需要大模型微调、大模型微调方法总结、大模型微调最佳实践等。在介绍大模型微调方法之前,首先带大家了解一下大语言模型的项目

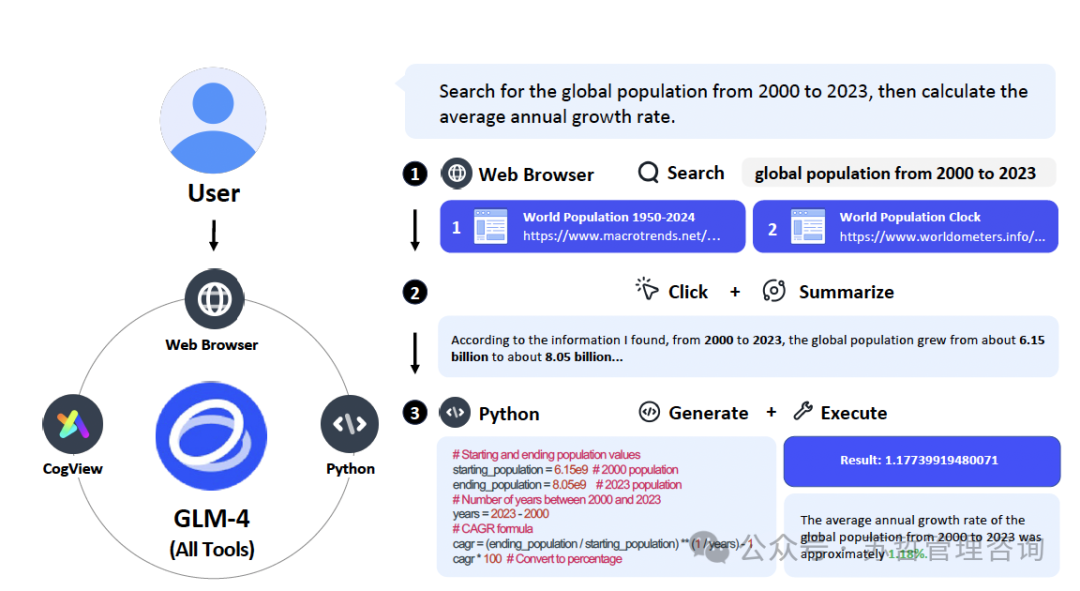

**最近的ChatGLM模型 — GLM-4(0116,0520)、GLM-4-Air(0605)和GLM-4 All Tools — 通过自主使用外部工具和功能,在理解和执行复杂任务方面取得了显著进展。**这些GLM-4模型在处理与中文相关任务方面的表现已经达到了甚至超越了GPT-4 Turbo、Claude 3 Opus和Gemini 1.5 Pro等现有模型的水平。此外,我们致力于通过公开发

AI大语言模型(Large Language Models, LLMs)是近1-2年来人工智能领域的重要发展,它们通过深度学习技术,特别是基于Transformer的架构(如GPT、BERT等),实现了对自然语言处理的巨大突破。AI大语言模型的主要功能和作用有:文本生成、创意写作、对话生成、问答系统、文本翻译、代码生成、代码解释、文档生成、辅助写作、辅助设计等。①人工智能/大模型学习路线②AI产品

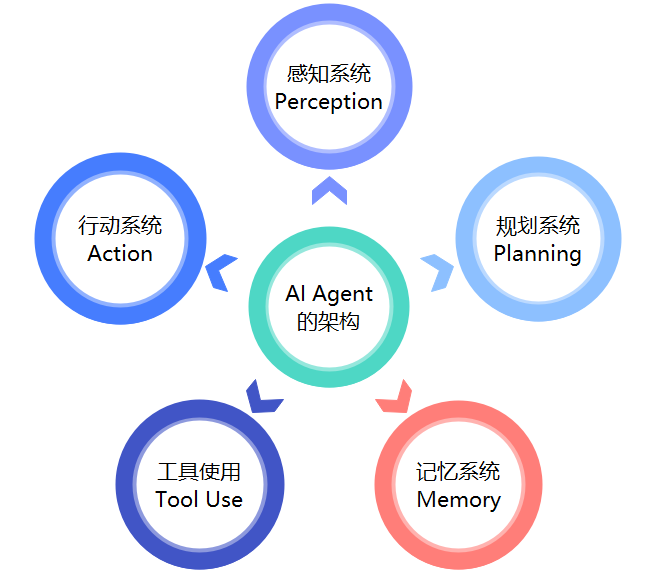

学术界和工业界对术语“AI Agent”提出了各种定义。其中,OpenAI将AI Agent定义为“