简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文作者分享了自己从程序员转行至AI大模型领域的经历。由于对现有工作生活状态的不满,作者在32岁时决定转行。经过对大模型领域的分析,作者选择了需求相对较低的应用工程师方向,并详细介绍了自学大模型的学习路线和技能要求。作者强调了持续学习的重要性,并提供了丰富的学习资源和项目实战建议,旨在帮助其他程序员顺利转行至AI大模型领域。

DeepSeek V4即将发布,主打编程能力,有望超越GPT和Claude,并支持国产AI芯片训练。DeepSeek团队规模虽小,却以极低成本做出惊人成果,引发硅谷震动。创始人梁文锋非典型科技大佬,带领本土人才团队逆袭。DeepSeek的崛起,意味着AI工具将更便宜,竞争加速,规则改变,对普通人和全球南方国家都有重大影响。资源并非关键,认知才是。DeepSeek V4将带来什么惊喜,拭目以待!

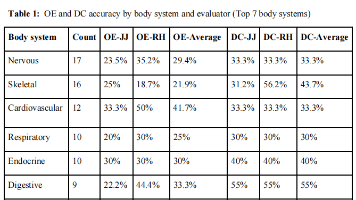

本文通过一个试点研究,评估了AI医疗搜索引擎OpenEvidence在复杂医学专科场景中的表现。研究发现,OpenEvidence的两种模式(快速搜索OE和深度咨询DC)的准确率远低于预期,最高仅为41%,且可重复性也有待提高。尽管OpenEvidence在USMLE考试中表现优异,但这一结果与真实临床场景存在差距。研究强调,在临床决策中使用AI工具时必须有专家监督,并建议未来进行更大规模、多维度

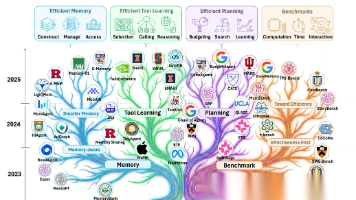

本文介绍了上海AI Lab与多所高校联合发表的《迈向高效智能体:记忆、工具学习与规划综述》,指出高效智能体通过优化记忆、工具使用和规划模块,以最大化任务成功率并最小化资源消耗。文章深入探讨了提升智能体效率的三大战略方向:高效记忆、高效工具学习和高效规划,并详细介绍了各类方法和技术,为想要学习大模型和智能体技术的读者提供了宝贵的参考和指导。

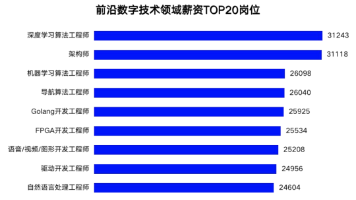

本文全面介绍了大模型领域的各类岗位及其要求,包括技术类的算法工程师、研发工程师和管理类的AI项目经理、产品经理、销售及解决方案专家。详细分析了各岗位所需的技能和经验,提供了求职渠道,并分享了学习路线和资源,帮助零基础小白和有经验的程序员系统学习大模型技术,为职业发展提供指导。

AI大模型产业进入快速发展期,人才需求激增。根据工信部文件,大模型岗位分为架构、算法、数据、评测、应用5大方向,包括8个具体岗位,能力要求涵盖专业知识、技术技能、工程实践三方面。文章建议青年人才明确职业方向、关注行业趋势、选择合适学校专业、积累实习经验,并介绍了从基础到实战的大模型学习路径,帮助小白系统掌握大模型知识与技能。

BIM模型审查痛点与AI解决方案:传统BIM审查依赖人工碰撞检查,存在规则更新滞后、无效工作量大(占比40%)、多维度定位耗时(单问题超15分钟)等问题。本文提出基于DeepSeek大模型的Revit插件方案,采用四层架构实现智能化审查:1)本地提取模型数据;2)AI分析规范冲突;3)可视化呈现结果;4)支持自定义规则库。方案可降低50%成本,提升3-5倍效率,并通过自然语言解释审查结果,实现非技

在当前的技术环境下,大型语言模型(LLMs)已经成为人工智能领域的一个重要里程碑。这些模型能够在各种任务上展现出人类水平的性能,包括但不限于文本生成、语言理解和问题解答。随着开源项目的发展,个人开发者现在有机会在本地部署这些强大的模型,以探索和利用它们的潜力。本文将详细介绍如何使用Ollama,一个开源项目,在Mac上本地运行大型模型(Win同理)。通过遵循以下步骤,即使是配备了几年前硬件的电脑,

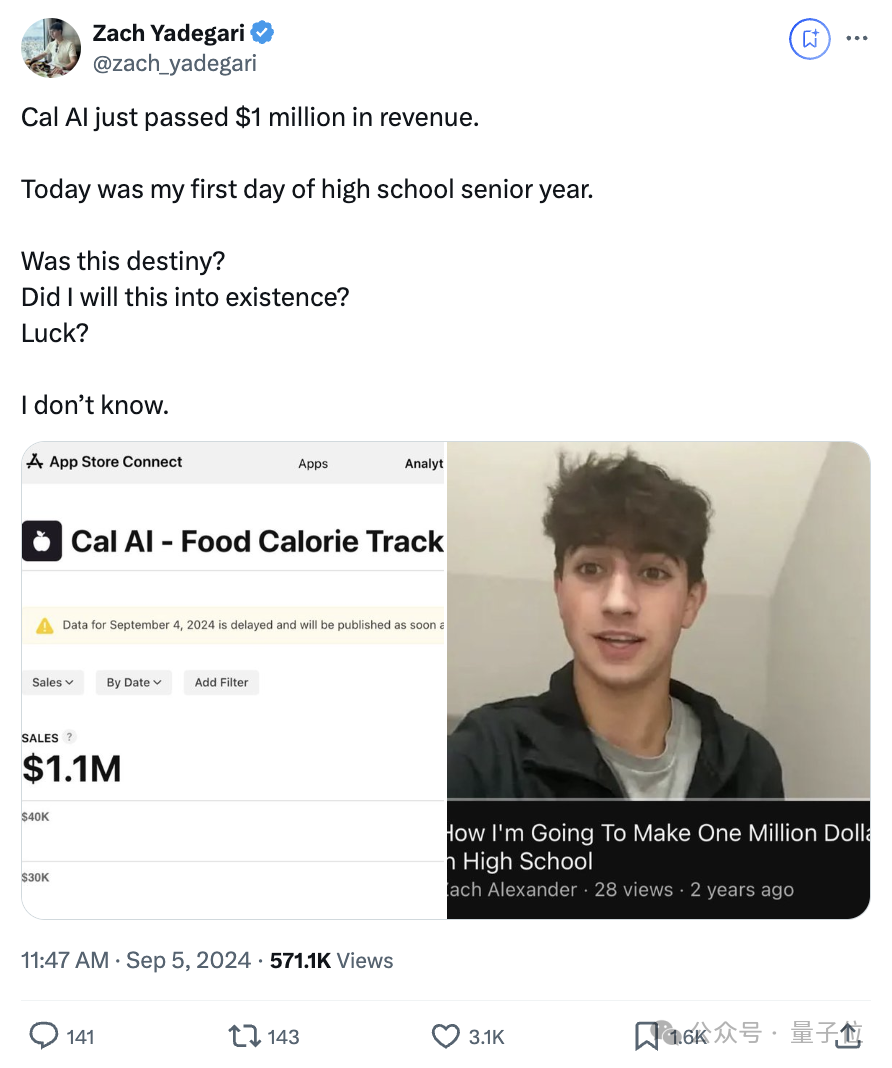

随着AI时代的到来叠加经济下行,越来越多的独立开发者梦想着实现年入百万的壮举。近日,这种小概率事件正在发生。17岁高中生做了个AI APP,短短四个月销售额达。小伙儿Zach Yadegari(下面暂称小扎克)在X上炫战绩,引来大量网友围观。小扎克发文表示,Cal AI 的收入超过了百万美元,而达成这一成绩的那一天,刚好是他最后一年高中的开学第一天。他发出了“这是命中注定的吗?”的感慨…这个 Ap

文章介绍了AI领域高薪岗位的薪资分布与岗位需求,重点分析了生成式AI的学习路线图,包括机器学习基础、生成式模型、NLP、音频和视觉生成等关键技术。文章指出AI行业人才缺口大,薪资高,并提供了从入门到实战的学习资源,包括视频教程、路线图、技术文档和面试题目等,适合小白和程序员系统学习AI大模型技术,实现职业转型和薪资提升。