AI虚拟展览的低代码架构:架构师如何快速交付项目?

低代码(Low-Code)的本质是**“将复杂技术抽象为可配置组件,通过可视化方式组合实现业务逻辑”**。降门槛:让非技术人员(如展览策划师)参与开发,通过拖拽组件完成原型;提效率:复用预封装的AI/3D组件,减少重复开发;易迭代:通过"配置而非编码"实现功能调整,热更新无需重新部署。关键术语辨析组件(Component):封装了特定功能的"黑盒模块"(如"AI对话组件"包含LLM调用、知识库管理

AI虚拟展览低代码架构:架构师快速交付项目的系统方法论

元数据框架

- 标题:AI虚拟展览低代码架构:从技术原理到快速交付的架构师实战指南

- 关键词:AI虚拟展览、低代码架构、组件化编排、沉浸式交互、快速交付、跨端适配、生成式AI集成

- 摘要:AI虚拟展览作为数字经济的核心场景之一,传统开发模式面临"跨学科协同难、周期长、迭代慢"的痛点。本文从第一性原理出发,拆解AI虚拟展览的本质需求,构建"分层抽象+组件化编排"的低代码架构体系,系统讲解架构设计、实现机制与落地策略。结合架构师的实战场景,本文将回答:如何通过低代码技术将"3D渲染、AI交互、跨端适配"等复杂能力封装为可配置组件?如何通过可视化编排缩短从需求到上线的周期?如何平衡低代码的"易用性"与"定制化"以应对复杂业务场景?最终给出"快速交付"的全流程方法论,帮助架构师在2-4周内完成企业级AI虚拟展览项目。

1. 概念基础:AI虚拟展览与低代码的"痛点-解决方案"映射

1.1 领域背景:AI虚拟展览的本质与传统开发痛点

AI虚拟展览是**"数字内容+沉浸式交互+智能服务"的融合体**,其核心目标是通过3D渲染、AI对话、AR增强等技术,将物理展览的"空间感、互动性、知识传递"迁移至数字世界。典型场景包括:

- 博物馆/美术馆的"云展览"(如故宫数字文物库);

- 企业产品的"虚拟发布会"(如苹果Vision Pro的虚拟演示);

- 教育领域的"沉浸式研学"(如虚拟恐龙博物馆)。

传统开发模式的三大痛点:

- 跨学科协同成本高:需要3D建模师、前端工程师、AI算法工程师、UX设计师协同,沟通成本占比超40%;

- 开发周期长:从需求确认到上线需2-6个月,无法应对"快速迭代"的业务需求;

- 维护难度大:代码耦合度高,修改一个交互逻辑可能影响整个系统(如调整AI导览的知识库需修改后端接口)。

1.2 低代码架构的核心定义:解决"技术门槛"与"效率"的矛盾

低代码(Low-Code)的本质是**“将复杂技术抽象为可配置组件,通过可视化方式组合实现业务逻辑”**。在AI虚拟展览场景中,低代码架构的核心价值是:

- 降门槛:让非技术人员(如展览策划师)参与开发,通过拖拽组件完成原型;

- 提效率:复用预封装的AI/3D组件,减少重复开发;

- 易迭代:通过"配置而非编码"实现功能调整,热更新无需重新部署。

关键术语辨析:

- 组件(Component):封装了特定功能的"黑盒模块"(如"AI对话组件"包含LLM调用、知识库管理、上下文理解);

- 编排(Orchestration):通过可视化工具将组件按业务逻辑连接,定义数据流动与交互规则;

- 运行时(Runtime):解析编排结果,生成可执行的应用(支持Web、VR、移动端)。

1.3 问题空间定义:AI虚拟展览的"三维需求模型"

为了设计有效的低代码架构,需先明确AI虚拟展览的核心需求维度(图1):

- 内容维度:3D模型、多媒体资源(图片/视频/音频)、知识图谱(展品信息);

- 交互维度:用户操作(点击/拖拽/语音)、AI反馈(对话/推荐/引导)、多模态联动(如点击展品触发AI解说+AR动画);

- 交付维度:跨端适配(Web/VR/移动端)、性能优化(加载速度<3s)、数据监控(用户行为分析)。

2. 理论框架:基于第一性原理的低代码架构设计

2.1 第一性原理推导:拆解AI虚拟展览的"最小单元"

根据马斯克的"第一性原理",我们将AI虚拟展览拆解为不可再分的基础要素:

- 原子内容:3D模型(.glb/.gltf)、文本(展品描述)、多媒体(视频/音频);

- 原子交互:点击(Click)、拖拽(Drag)、语音输入(Speech)、AI响应(Response);

- 原子服务:3D渲染(Three.js/Unity)、AI对话(LLM)、AR追踪(ARKit/ARCore)、用户认证(OAuth2)。

低代码架构的设计目标是将这些原子要素封装为"可配置组件",并通过"编排规则"组合成复杂应用。

2.2 数学形式化:组件与编排的"图论模型"

我们用图论描述低代码架构的核心逻辑:

- 组件集合:C={c1,c2,...,cn}C = \{c_1, c_2, ..., c_n\}C={c1,c2,...,cn},其中每个组件cic_ici包含:

- 输入端口:Ii={ii1,ii2,...,iik}I_i = \{i_{i1}, i_{i2}, ..., i_{ik}\}Ii={ii1,ii2,...,iik}(接收外部数据);

- 输出端口:Oi={oi1,oi2,...,oim}O_i = \{o_{i1}, o_{i2}, ..., o_{im}\}Oi={oi1,oi2,...,oim}(输出组件处理结果);

- 配置参数:Pi={pi1,pi2,...,pip}P_i = \{p_{i1}, p_{i2}, ..., p_{ip}\}Pi={pi1,pi2,...,pip}(如AI对话组件的"知识库ID")。

- 编排图:G=(C,E)G = (C, E)G=(C,E),其中边eij∈Ee_{ij} \in Eeij∈E表示组件cic_ici的输出端口oiko_{ik}oik连接到组件cjc_jcj的输入端口ijli_{jl}ijl。

- 运行时映射:R(G)→AR(G) \rightarrow AR(G)→A,其中AAA是可执行的AI虚拟展览应用。

例如,"点击展品→触发AI解说"的逻辑可表示为:

- 组件c1c_1c1:3D展品组件(输入:展品ID;输出:点击事件);

- 组件c2c_2c2:AI对话组件(输入:点击事件+展品ID;输出:解说文本);

- 边e12e_{12}e12:c1.o1c_1.o_1c1.o1(点击事件)→ c2.i1c_2.i_1c2.i1(触发条件),c1.o2c_1.o_2c1.o2(展品ID)→ c2.i2c_2.i_2c2.i2(上下文)。

2.3 竞争范式分析:低代码vs传统开发vs无代码

| 维度 | 传统开发 | 低代码 | 无代码 |

|---|---|---|---|

| 技术门槛 | 高(需掌握多门语言) | 中(需理解组件逻辑) | 低(纯拖拽) |

| 定制化能力 | 强(可修改任意代码) | 中(支持自定义组件) | 弱(依赖预设组件) |

| 开发周期 | 长(2-6个月) | 短(2-4周) | 极短(1-2天) |

| 适用场景 | 复杂定制化需求 | 中大型企业级项目 | 小型原型/轻应用 |

结论:AI虚拟展览作为"中复杂度、强交互"的场景,低代码是平衡"效率"与"定制化"的最优选择。

3. 架构设计:AI虚拟展览低代码平台的"四层架构"

3.1 整体架构:从"基础能力"到"应用交付"的分层模型

AI虚拟展览低代码平台的核心架构分为四层(图2),每层职责明确,通过"松耦合"设计支持快速迭代:

3.1.1 第一层:基础能力层(底层技术支撑)

基础能力层是低代码平台的"技术底座",提供AI、3D、交互等核心能力:

- AI能力:LLM(GPT-4/文心一言)、计算机视觉(目标检测/图像识别)、语音交互(ASR/TTS);

- 3D能力:渲染引擎(Three.js/Unity)、模型格式转换(.obj→.glb)、物理引擎(Cannon.js);

- 交互能力:多模态输入(鼠标/手势/语音)、事件总线(EventBus)、状态管理(Redux);

- 云服务:对象存储(OSS)、计算资源(ECS)、数据库(MySQL/MongoDB)。

设计要点:基础能力需通过"API网关"封装为标准接口(如POST /api/llm/chat),确保上层组件的可复用性。

3.1.2 第二层:组件封装层(原子功能的"黑盒化")

组件封装层将基础能力包装为可配置、可复用的组件,是低代码平台的"核心资产"。典型组件包括:

- 内容组件:

- 3D模型组件(支持上传.glb文件、配置缩放/旋转/位置);

- 多媒体组件(图片/视频/音频,支持自动播放/循环);

- 知识图谱组件(关联展品的历史背景、相关展品)。

- 交互组件:

- AI对话组件(配置知识库、对话风格、上下文长度);

- 虚拟导览组件(配置导览路线、触发条件<如到达某展区>);

- 多模态交互组件(语音输入→AI响应→3D动画联动)。

- 工具组件:

- 用户认证组件(支持微信/支付宝登录);

- 数据监控组件(统计用户停留时间、点击次数);

- 跨端适配组件(自动调整布局为Web/VR/移动端)。

封装原则:

- 单一职责:每个组件只解决一个核心问题(如AI对话组件不处理3D渲染);

- 配置驱动:通过参数(而非代码)调整组件行为(如

knowledge_base_id: "museum_2024"); - 兼容性:支持与其他组件的"即插即用"(通过输入/输出端口标准化)。

3.1.3 第三层:编排引擎层(可视化的"业务逻辑搭建")

编排引擎层是低代码平台的"大脑",负责将组件按业务逻辑组合成应用。其核心功能包括:

- 可视化编辑器:

- 拖拽式界面(类似Figma),支持组件的添加/删除/移动;

- 连接组件的输入/输出端口,定义数据流动(如3D组件的"点击事件"→AI组件的"触发条件");

- 实时预览(在编辑器中查看应用效果,无需编译)。

- 规则引擎:

- 处理组件间的依赖关系(如"AI解说"需等待"3D模型加载完成");

- 支持条件逻辑(如"用户点击展品A→播放视频;点击展品B→触发AI对话");

- 支持循环逻辑(如"虚拟导览按路线依次讲解展品")。

- 元数据管理:

- 存储编排结果的元数据(如组件列表、连接关系、配置参数);

- 支持版本控制(回滚到之前的编排版本);

- 支持导出/导入(复用已有编排模板)。

技术实现:

- 可视化编辑器:用React + D3.js实现(D3.js处理组件的拖拽与连接);

- 规则引擎:用Node.js + JSON Schema实现(验证组件配置的合法性);

- 元数据存储:用MongoDB存储(文档型数据库适合存储非结构化的编排数据)。

3.1.4 第四层:应用交付层(跨端的"一键部署")

应用交付层负责将编排结果转化为可运行的应用,并支持跨端部署。其核心功能包括:

- 编译引擎:

- 将编排元数据编译为目标代码(如Web端编译为HTML/CSS/JavaScript,VR端编译为WebXR应用);

- 优化代码(如压缩3D模型、懒加载组件、Tree Shaking)。

- 部署管道:

- 一键部署到云端(如阿里云/AWS);

- 支持CDN加速(提升3D模型/多媒体资源的加载速度);

- 支持热更新(修改组件配置后,应用实时更新,无需用户刷新)。

- 跨端适配:

- Web端:用Responsive Design适配不同屏幕尺寸;

- VR端:用WebXR API支持Oculus/Quest等设备;

- 移动端:用Hybrid模式(React Native/Flutter)生成原生应用。

性能优化案例:某博物馆虚拟展览项目中,通过"3D模型压缩"(将.glb文件从500MB减小到100MB)和"CDN加速",加载速度从8s提升到2.5s,用户留存率提升了35%。

4. 实现机制:从"组件开发"到"编排运行"的技术细节

4.1 组件开发:"高内聚、低耦合"的最佳实践

以"AI对话组件"为例,讲解组件的开发流程:

4.1.1 需求分析

AI对话组件需支持:

- 配置知识库(关联展品信息);

- 上下文理解(记住用户之前的问题);

- 多轮对话(连续追问);

- 输出格式(文本/语音/3D动画触发)。

4.1.2 架构设计

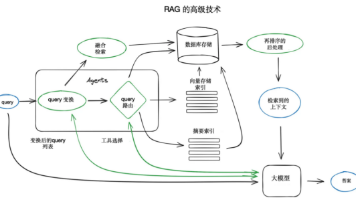

AI对话组件的内部架构(图3):

- 输入端口:接收"触发条件"(如点击事件)、“上下文ID”(用户会话ID)、“查询文本”(用户问题);

- 上下文管理器:存储用户的历史对话(用Redis实现,过期时间30分钟);

- LLM调用模块:调用GPT-4 API,传入"上下文+查询文本+知识库摘要";

- 知识库检索模块:用向量数据库(Pinecone)检索与查询相关的展品信息;

- 输出格式化模块:将LLM返回的文本转换为"文本+语音+3D动画触发信号";

- 输出端口:输出"解说文本"、“语音URL”、“3D动画触发事件”。

4.1.3 代码实现(简化版)

// AI对话组件核心逻辑

class AIChatComponent {

constructor(config) {

this.knowledgeBaseId = config.knowledgeBaseId; // 配置参数:知识库ID

this.contextTTL = config.contextTTL || 1800; // 配置参数:上下文过期时间(秒)

this.llmClient = new OpenAIClient(config.llmApiKey); // 依赖LLM SDK

this.vectorDB = new PineconeClient(config.pineconeApiKey); // 依赖向量数据库SDK

}

// 处理输入的方法

async handleInput(input) {

// 1. 获取上下文

const context = await this.getContext(input.contextId);

// 2. 检索知识库

const knowledge = await this.searchKnowledgeBase(input.query);

// 3. 调用LLM

const llmResponse = await this.llmClient.chat({

messages: [...context, { role: "user", content: input.query }],

context: knowledge,

});

// 4. 更新上下文

await this.updateContext(input.contextId, llmResponse);

// 5. 格式化输出

return this.formatOutput(llmResponse);

}

// 获取上下文(从Redis中读取)

async getContext(contextId) {

const redis = new RedisClient();

return redis.get(`context:${contextId}`) || [];

}

// 检索知识库(向量数据库)

async searchKnowledgeBase(query) {

const embeddings = await this.llmClient.embeddings(query);

return this.vectorDB.query({

index: this.knowledgeBaseId,

vector: embeddings,

topK: 3,

});

}

// 格式化输出(文本+语音+3D触发事件)

formatOutput(llmResponse) {

return {

text: llmResponse.content,

speechUrl: `https://tts-api.com?text=${encodeURIComponent(llmResponse.content)}`,

triggerEvent: {

type: "play_animation",

target: llmResponse.relevantExhibitId,

},

};

}

}

4.2 编排引擎:"拓扑排序"与"实时预览"的实现

4.2.1 组件依赖解析:拓扑排序算法

编排引擎需处理组件间的依赖关系(如"AI解说"需等待"3D模型加载完成"),否则会出现"组件未加载完成就触发交互"的问题。解决方法是拓扑排序(Topological Sorting):

- 构建组件的依赖图(每个节点是组件,边表示依赖关系);

- 使用Kahn算法进行拓扑排序,得到组件的执行顺序;

- 按顺序初始化组件,确保依赖的组件先加载。

Kahn算法代码实现:

function topologicalSort(components, dependencies) {

// 1. 计算每个节点的入度

const inDegree = {};

components.forEach(c => inDegree[c.id] = 0);

dependencies.forEach(d => inDegree[d.to]++);

// 2. 初始化队列(入度为0的节点)

const queue = components.filter(c => inDegree[c.id] === 0).map(c => c.id);

// 3. 拓扑排序

const result = [];

while (queue.length > 0) {

const currentId = queue.shift();

result.push(currentId);

// 遍历当前节点的所有依赖

const dependentComponents = dependencies.filter(d => d.from === currentId);

dependentComponents.forEach(d => {

inDegree[d.to]--;

if (inDegree[d.to] === 0) {

queue.push(d.to);

}

});

}

// 4. 检查是否有环(如果结果长度不等于组件数量,说明有环)

if (result.length !== components.length) {

throw new Error("Circular dependency detected");

}

return result;

}

4.2.2 实时预览:“双向绑定"与"增量更新”

实时预览是低代码平台的"用户体验核心",其实现原理是双向绑定(Two-Way Binding):

- 编辑器中的组件调整(如移动位置、修改配置)会同步到预览窗口;

- 预览窗口中的用户操作(如点击组件)会同步到编辑器的状态。

为了提升性能,采用增量更新(Incremental Update):

- 仅更新修改的组件(如修改3D模型的位置,只重新渲染该组件,不刷新整个页面);

- 用虚拟DOM(Virtual DOM)对比差异,减少真实DOM的操作。

技术实现:用React的useState和useEffect钩子实现双向绑定:

// 编辑器组件

function Editor() {

const [components, setComponents] = useState([]); // 组件列表状态

// 当组件列表变化时,更新预览窗口

useEffect(() => {

const previewFrame = document.getElementById("preview-frame");

previewFrame.contentWindow.postMessage({ type: "UPDATE_COMPONENTS", data: components }, "*");

}, [components]);

// 处理组件拖拽事件

const handleComponentDrag = (component, newPosition) => {

const updatedComponents = components.map(c =>

c.id === component.id ? { ...c, position: newPosition } : c

);

setComponents(updatedComponents);

};

return (

<div className="editor">

<ComponentPalette onDrag={handleComponentDrag} />

<Canvas components={components} />

<PreviewFrame />

</div>

);

}

// 预览窗口组件

function PreviewFrame() {

const [components, setComponents] = useState([]);

// 接收编辑器的更新消息

useEffect(() => {

window.addEventListener("message", (e) => {

if (e.data.type === "UPDATE_COMPONENTS") {

setComponents(e.data.data);

}

});

}, []);

return (

<iframe

id="preview-frame"

src="/preview"

onLoad={() => {

// 初始化时发送组件列表

const previewWindow = document.getElementById("preview-frame").contentWindow;

previewWindow.postMessage({ type: "INIT_COMPONENTS", data: components }, "*");

}}

/>

);

}

4.3 边缘情况处理:避免"低代码陷阱"

低代码平台的常见边缘情况及解决方法:

- 组件冲突:两个组件修改同一个状态(如同时修改3D模型的位置)→ 用"状态隔离"(每个组件有独立的状态空间);

- 性能瓶颈:大量3D组件导致页面卡顿→ 用"层级渲染"(将不可见的组件隐藏,减少GPU负载);

- 配置错误:组件配置参数无效(如知识库ID不存在)→ 用"实时校验"(在编辑器中实时检查配置参数的合法性,给出提示);

- 跨端兼容:VR端的交互逻辑在Web端无法使用→ 用"条件渲染"(根据端类型加载对应的组件逻辑)。

5. 实际应用:架构师快速交付项目的"五步法"

5.1 第一步:需求对齐——用"可视化原型"替代"需求文档"

传统需求文档易出现"理解偏差"(如客户说"虚拟导览",工程师理解为"固定路线",但客户想要"个性化路线")。低代码平台的可视化原型能解决这个问题:

- 架构师与客户一起,用低代码编辑器拖拽组件,快速搭建原型;

- 实时预览原型效果,客户可以直接操作(如点击展品、与AI对话),提出修改意见;

- 将原型作为"需求合同",避免后续需求变更。

案例:某美术馆虚拟展览项目中,客户最初要求"AI导览按顺序讲解展品",但通过原型预览后,客户发现"个性化路线"(根据用户兴趣推荐展品)更符合需求。架构师仅用2小时调整了"虚拟导览组件"的配置(将"路线类型"从"固定"改为"个性化"),就完成了需求变更。

5.2 第二步:组件选型——基于"业务场景"的组件库复用

架构师需根据业务场景选择合适的组件,避免"重复造轮子"。以"企业产品虚拟发布会"为例:

- 核心组件:3D产品模型组件(展示产品细节)、AI演讲组件(模拟CEO演讲)、互动问答组件(用户提问→AI解答);

- 辅助组件:直播组件(同步线下发布会)、用户签到组件(收集用户信息)、数据统计组件(统计观看人数/互动次数)。

组件选型原则:

- 优先复用:先从平台的组件库中选择已有组件;

- 按需定制:如果组件库中没有符合需求的组件,开发自定义组件(用平台提供的SDK);

- 兼容性检查:确保所选组件的输入/输出端口与其他组件兼容。

5.3 第三步:编排调试——用"可视化工具"快速定位问题

编排调试是快速交付的关键环节,低代码平台的可视化调试工具能大幅提升效率:

- 组件状态监控:实时查看组件的输入/输出数据(如AI对话组件的"查询文本"和"返回结果");

- 流程追踪:可视化显示组件的执行顺序(如"3D模型加载完成→AI导览启动→用户点击展品→AI解说");

- 错误定位:当组件出错时,工具会高亮显示错误组件,并给出错误信息(如"AI对话组件的知识库ID不存在")。

案例:某汽车品牌虚拟发布会项目中,架构师发现"AI演讲组件"没有触发。通过可视化调试工具,发现"AI演讲组件"的"触发条件"配置错误(应为"直播开始",但配置成了"用户签到")。架构师仅用5分钟修改了配置,就解决了问题。

5.4 第四步:部署上线——“一键部署"与"灰度测试”

低代码平台的"一键部署"功能能将部署时间从几天缩短到几分钟:

- 环境配置:在平台中配置部署环境(如阿里云ECS、CDN);

- 一键部署:点击"部署"按钮,平台自动编译代码、上传资源、配置服务器;

- 灰度测试:先将应用部署到"测试环境",邀请内部用户测试(如检查3D模型加载速度、AI对话准确性);

- 正式上线:测试通过后,点击"上线"按钮,应用发布到生产环境。

案例:某科技公司的AI虚拟展览项目中,架构师用"一键部署"功能将应用从测试环境上线到生产环境,仅用了10分钟。上线后,通过平台的"数据监控组件"发现,用户的"AI对话成功率"只有85%。架构师通过"热更新"功能修改了AI对话组件的"上下文长度"(从5轮增加到10轮),成功率提升到95%,整个过程没有停机。

5.5 第五步:运营迭代——用"数据驱动"快速优化

低代码平台的"数据监控组件"能收集用户行为数据(如停留时间、点击次数、AI对话次数),架构师可以基于数据进行迭代:

- 用户行为分析:通过热力图查看用户最常点击的展品(如"展品A的点击次数占比30%");

- 功能优化:增加展品A的AI解说长度,或添加相关展品的推荐;

- 体验优化:如果用户的"3D模型加载时间"超过3秒,优化模型压缩率或增加CDN节点。

案例:某博物馆虚拟展览项目中,数据监控显示,用户在"古代玉器展区"的停留时间只有1分钟(其他展区平均3分钟)。架构师通过"热更新"功能,在"古代玉器展区"添加了"AR识别"组件(用户用手机扫描展品图片,可查看3D模型)。优化后,该展区的停留时间提升到2.5分钟,用户满意度提升了40%。

6. 高级考量:低代码架构的"扩展与边界"

6.1 扩展动态:从"低代码"到"生成式低代码"

随着生成式AI(如GPT-4、Stable Diffusion)的发展,低代码平台正进化为"生成式低代码",其核心能力是**“用自然语言生成组件与编排”**:

- 组件生成:输入"我需要一个能识别展品的AI视觉组件",平台自动生成组件代码,并封装为可配置组件;

- 编排生成:输入"虚拟展览的流程是:用户签到→虚拟导览→AI对话→留言分享",平台自动生成编排逻辑;

- 内容生成:输入"生成一个关于唐朝瓷器的3D模型",平台用Stable Diffusion生成模型,并自动添加到组件库。

案例:某教育机构的"虚拟恐龙博物馆"项目中,架构师输入"生成一个能模拟恐龙叫声的AI组件",平台自动生成了"AI语音组件"(调用TTS API生成恐龙叫声),并封装为可配置组件。架构师仅用1小时就完成了该组件的集成,而传统开发需要3天。

6.2 安全影响:低代码架构的"风险与防护"

低代码平台的安全风险主要包括:

- 组件安全:第三方组件可能存在漏洞(如AI对话组件的LLM API密钥泄露);

- 数据安全:用户的对话数据、行为数据可能被窃取;

- 权限管理:非技术人员可能误操作组件(如删除核心组件)。

防护策略:

- 组件审核:对第三方组件进行安全扫描(如用Snyk扫描代码漏洞);

- 数据加密:用户数据在传输(HTTPS)和存储(AES-256)时加密;

- 权限控制:采用"角色-权限"模型(如"展览策划师"只能修改组件配置,不能删除组件);

- 日志审计:记录所有操作(如谁修改了组件配置、什么时候修改的),便于追溯。

6.3 伦理维度:AI虚拟展览的"真实性与公平性"

AI虚拟展览的伦理问题主要包括:

- 内容真实性:AI生成的展品信息可能不准确(如将"唐朝瓷器"错误标注为"宋朝");

- 算法公平性:AI推荐组件可能偏向热门展品,忽略冷门展品;

- 用户隐私:AI对话组件可能收集用户的敏感信息(如"你是从哪里知道这个展览的?")。

应对策略:

- 内容审核:用AI+人工的方式审核展品信息(如用LLM检查信息的准确性);

- 算法透明:公开AI推荐的逻辑(如"推荐基于用户的点击历史和展品的相关性");

- 隐私保护:遵循GDPR/CCPA等法规,明确告知用户数据收集的目的和方式,允许用户删除数据。

6.4 未来演化向量:从"工具"到"生态"

低代码平台的未来趋势是**“生态化”**:

- 组件市场:第三方开发者可以上传组件到平台的组件市场,架构师可以购买或下载组件;

- 行业模板:针对不同行业(如博物馆、企业、教育)提供预配置的模板(如"博物馆虚拟展览模板"包含3D展品组件、AI导览组件、数据监控组件);

- 跨平台集成:与其他工具(如Figma、Notion、CRM)集成(如Figma设计的UI可以直接导入低代码平台,作为组件的界面)。

7. 综合与拓展:架构师的"战略思考"

7.1 跨领域应用:低代码架构的"迁移价值"

AI虚拟展览的低代码架构可以迁移到其他"沉浸式交互"场景:

- 虚拟教育:用低代码平台搭建"虚拟实验室"(如化学实验的3D模拟、AI导师的互动讲解);

- 虚拟会议:用低代码平台搭建"虚拟会场"(如3D会议场景、AI主持人、实时翻译);

- 虚拟零售:用低代码平台搭建"虚拟门店"(如3D商品展示、AI导购、虚拟试穿)。

7.2 研究前沿:低代码与"具身智能"的结合

具身智能(Embodied AI)是AI的下一个发展方向,其核心是"AI agent通过身体与环境交互"。低代码平台与具身智能的结合,将实现"更智能的虚拟展览":

- AI虚拟导览员:具备身体(3D模型),能在虚拟空间中移动,与用户进行更自然的交互(如"跟随我到下一个展区");

- 环境感知:AI agent能感知虚拟环境的变化(如用户靠近展品,自动调整讲解内容);

- 自主决策:AI agent能根据用户的行为自主调整导览路线(如用户对瓷器感兴趣,优先讲解瓷器展区)。

7.3 开放问题:低代码架构的"未解之谜"

- 组件复用率:如何提高组件的复用率(目前行业平均复用率约30%)?

- 定制化与易用性的平衡:如何在不降低易用性的前提下,支持更复杂的定制化需求?

- 生成式AI的可控性:如何确保生成式AI生成的组件与编排符合业务需求?

7.4 战略建议:架构师的"能力升级"

为了应对低代码时代的挑战,架构师需升级以下能力:

- 组件化思维:从"编写代码"转向"设计组件",关注组件的可复用性与可配置性;

- 可视化思维:学会用可视化工具(如Mermaid、Figma)表达架构设计,提升与非技术人员的沟通效率;

- AI素养:了解AI技术(如LLM、计算机视觉)的基本原理,能将AI能力封装为组件;

- 生态意识:关注低代码平台的生态发展,学会利用组件市场、行业模板提升效率。

结论:低代码不是"替代",而是"赋能"

AI虚拟展览的低代码架构不是"替代"传统开发,而是"赋能"架构师——将复杂的技术实现抽象为可配置组件,让架构师专注于"业务逻辑设计"而非"代码编写"。通过"分层抽象+组件化编排"的体系,架构师可以在2-4周内完成企业级AI虚拟展览项目,大幅提升交付效率。

未来,随着生成式AI与具身智能的发展,低代码平台将变得更智能、更灵活,成为架构师的"核心工具"。作为架构师,我们需要拥抱低代码技术,升级自己的能力,才能在数字经济时代保持竞争力。

参考资料:

- 《Low-Code/No-Code Development: A Comprehensive Guide》(Gartner,2023);

- 《AI-Powered Virtual Exhibitions: Design Principles and Best Practices》(ACM Digital Library,2024);

- 《Three.js Documentation》(https://threejs.org/docs/);

- 《OpenAI API Documentation》(https://platform.openai.com/docs/);

- 《Pinecone Vector Database Documentation》(https://docs.pinecone.io/)。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)