从大模型幻觉到机器人实干,零样本实测UR3、XArm6依旧稳

大模型在机器人领域卷疯了!刚有MCR用36k真实轨迹让ViT悟出“操控中心性”,STP就用双解码器把未来帧95%掩码当提示,让0.27B ViT-B在19个仿真任务上秒掉VC-1;PhysVLM更狠,直接加一张S-P可达图,把GPT-4o的机器人问答成绩抬升14%,零样本实测UR3、XArm6依旧稳。最近顶会风口证明,大模型+机器人已成顶会顶刊超火赛道,轻量ViT、3B Qwen就能在真机上跑,巧

来gongzhonghao【图灵学术计算机论文辅导】,快速拿捏更多计算机SCI/CCF发文资讯~

大模型在机器人领域卷疯了!刚有MCR用36k真实轨迹让ViT悟出“操控中心性”,STP就用双解码器把未来帧95%掩码当提示,让0.27B ViT-B在19个仿真任务上秒掉VC-1;PhysVLM更狠,直接加一张S-P可达图,把GPT-4o的机器人问答成绩抬升14%,零样本实测UR3、XArm6依旧稳。

最近顶会风口证明,大模型+机器人已成顶会顶刊超火赛道,轻量ViT、3B Qwen就能在真机上跑,巧妙掩码、统一可达图、跨机器人表征,一招鲜即可出圈!

本文速拆三篇最新标杆,帮你一眼锁定下一波落地风口。

ROBOTS PRE-TRAIN ROBOTS: MANIPULATION-CENTRIC ROBOTIC REPRESENTATION FROM LARGE-SCALE ROBOT DATASETS

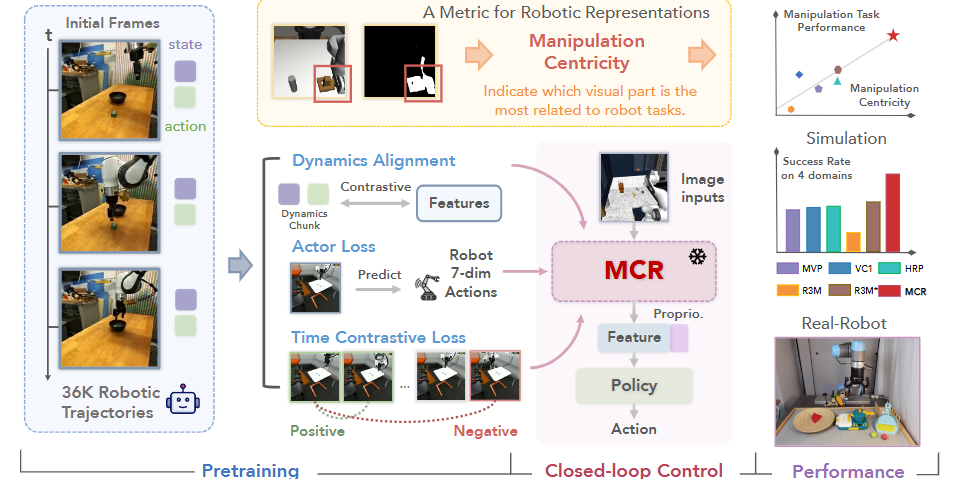

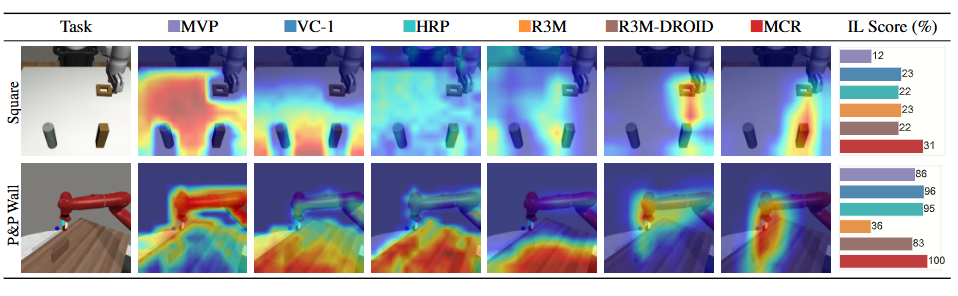

方法:首次系统揭示了机器人表征性能与其聚焦操作关键区域能力的强关联,并据此设计MCR框架,利用大规模机器人数据集DROID中的视觉、本体感知与动作信息,通过动态对齐、动作预测和时间对比三重损失预训练视觉编码器,从而在仿真和真实机器人任务中显著提升操控成功率。

创新点:

-

首次提出“操作中心性”评估指标,为机器人表征效果提供可量化的全新尺度。

-

发现大规模机器人数据集在缩小域差距和提升操作中心性上优于传统人类视频数据。

-

设计MCR框架,通过融合动态对齐、动作预测与时间对比损失,有效利用机器人本体感知与动作标签,显著增强表征的操作相关性。

总结:文章先用Grad-CAM可视化和Jaccard指数验证操作中心性与下游任务成功率的正相关,随后用DROID数据集替代人类视频重训基线模型以缩小域差距,再在MCR中引入动态对齐损失将视觉特征与机器人状态-动作序列对齐,并辅以动作预测和时间对比损失,最终在20个仿真任务和3个真实任务上分别取得14.8%和76.9%的性能提升。

Spatiotemporal Predictive Pre-training for Robotic Motor Control

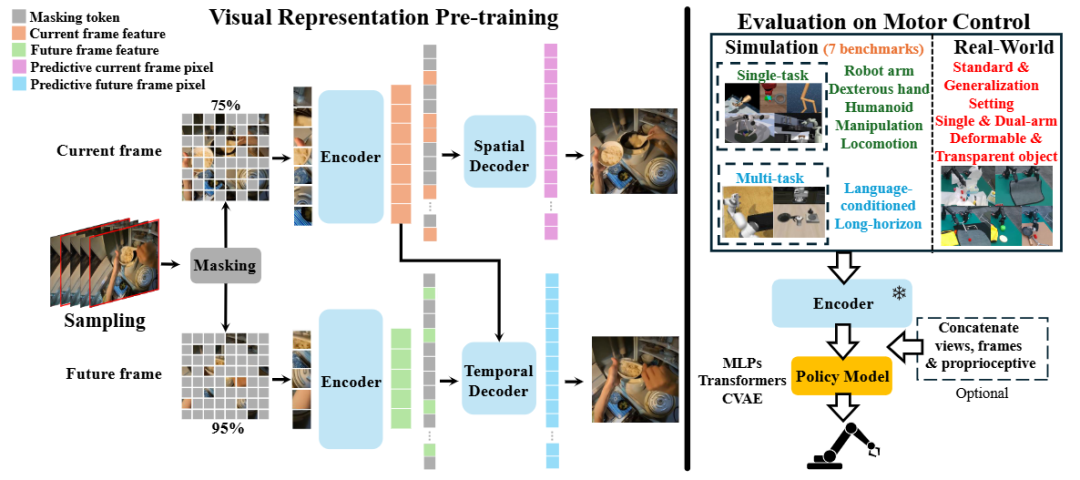

方法:这篇文章首次揭示了仅关注静态内容而忽视人类视频中隐含动作线索的预训练范式会严重制约机器人运动控制性能,并提出 STP 框架用“时空预测”双解码器同时挖掘大规模 egocentric 视频的空间结构与运动规律。

创新点:

-

提出非对称掩码策略:当前帧 75% 掩码用于空间重建,未来帧 95% 掩码作为条件用于运动预测,实现内容与运动解耦学习。

-

设计解耦双解码器:共享 ViT 编码器后,空间解码器专注静态纹理补全,时间解码器以当前帧为键值、未来高掩码为查询进行交叉注意力,避免信息泄露。

-

构建无额外监督的通用预训练框架:无需动作、语言或深度标签,即可在仿真与真实任务中以冻结权重方式直接迁移并显著优于 MAE 与 VC-1 等基线。

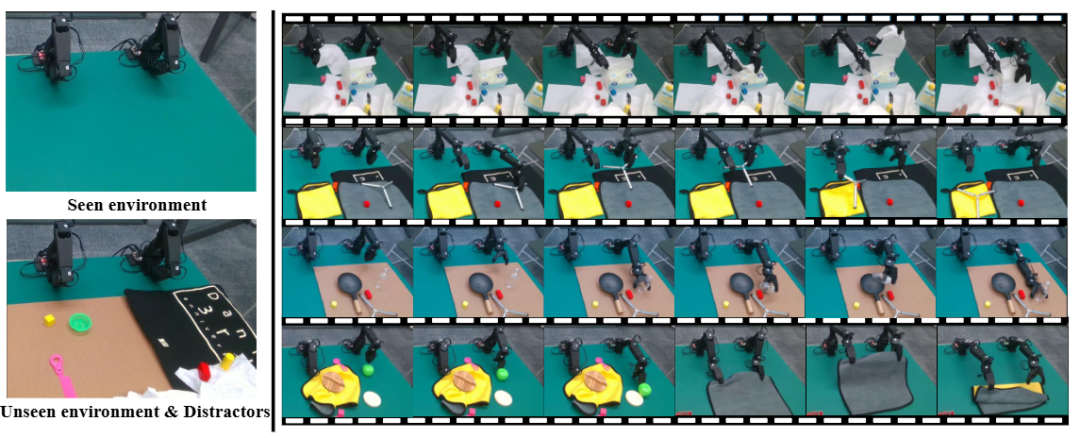

总结:整个流程以 MSE 损失多任务训练 50 个 epoch,随后在 19 个仿真任务与 5 个真实任务上冻结 ViT 编码器、仅用少量演示数据训练行为克隆策略;实验表明 STP 在单任务仿真平均提升 4.1%,真实世界未见场景再提升 9.6%,并通过混合 ImageNet-MAE 初始化与任务特定后预训练进一步释放通用性和数据效率。

纠结选题?导师放养?投稿被拒?对论文有任何问题的同学,欢迎来gongzhonghao【图灵学术计算机论文辅导】,获取顶会顶刊前沿资讯~

PhysVLM: Enabling Visual Language Models to Understand Robotic Physical Reachability

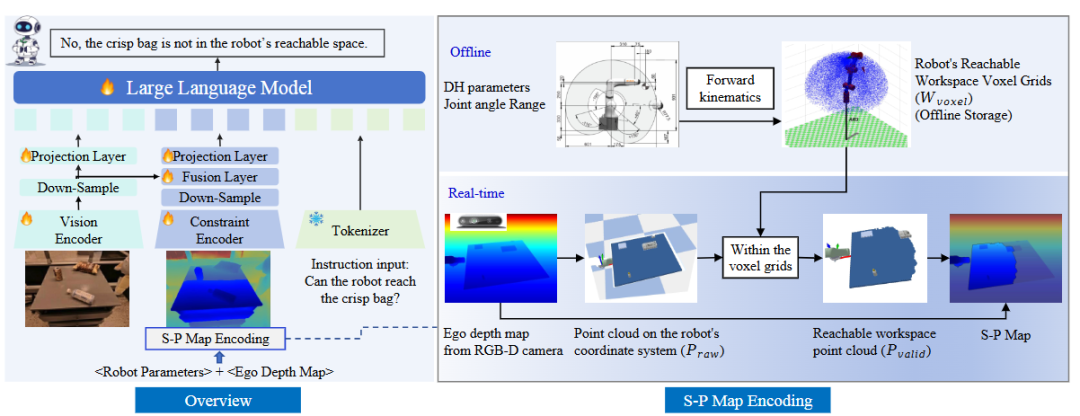

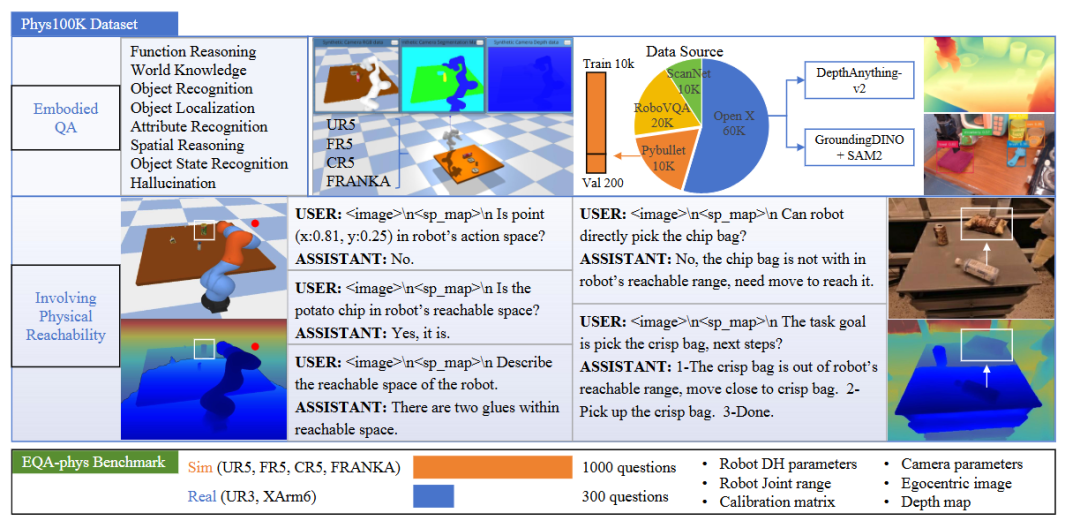

方法:这篇文章直击“大模型懂场景却不懂机器人到底能不能摸到”这一痛点,提出 PhysVLM,让视觉-语言模型首次真正看懂“可达性”并用于机器人问答与规划。

创新点:

-

提出机器人无关的 S-P Map,用统一灰度图把任意构型机械臂的可行空间抽象出来,摆脱对具体 DH 参数的依赖。

-

设计双分支架构,在冻结的 ViT 视觉编码器外新增独立的可达性编码器,将 S-P Map 特征与图文特征对齐后再送入 LLM,既保留通用视觉语言力又引入物理约束。

-

构建 Phys100K 数据集与 EQA-phys 基准,覆盖 6 种机器人和 1.3K 问答对,首次系统评测 VLM 对“可达性”的理解能力。

总结:文章先用机器人参数与 egocentric 深度图离线计算高分辨率可达体素网格,再将其投影为灰度 S-P Map,推理时仅输入 RGB+S-P Map+文本,PhysVLM 即可零样本回答“能否抓到”并给出合理规划,在 EQA-phys 上比 GPT-4o 高 14%,在真实 UR3/XArm6 上零样本仍达 63% 以上。

关注gongzhonghao【图灵学术计算机论文辅导】,快速拿捏更多计算机SCI/CCF发文资讯

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)