Agentic AI 与 AI 编程入门:让 AI 成为学习与创作的最佳伴侣

摘要: 2025年,AgenticAI(智能体AI)与AI辅助编程已成为高效学习与创作的核心工具。AgenticAI通过自主目标解析、规划拆解、工具调用和反馈迭代四大能力,实现从被动响应到主动服务的转变,显著提升学习效率(如定制Python学习路径)和项目开发能力(如自动生成Flask API服务)。工具生态涵盖通用平台(ChatGPT-4.1、LangChain)与垂直领域应用(CodeRabb

前言:AI 驱动的学习与创作新范式

在 2025 年的技术浪潮中,Agentic AI(智能体 AI)和AI 辅助编程已从前沿概念彻底转变为实用工具,重塑了我们学习、思考和创造的底层逻辑。传统学习模式中,线性教材的局限性、被动听课的低效率和重复练习的枯燥感,常常成为能力提升的瓶颈;而在编程与创作领域,新手因语法障碍、逻辑断层和创意枯竭停滞不前的问题更为突出。

如今,Agentic AI(具备自主规划、工具调用与迭代优化能力的智能体系统)与 AI 编程工具(如 Cursor AI、LangChain 驱动的代码助手)形成了强大的 "学习 - 创作联合体":它们既能根据你的知识基础定制个性化学习路径,实时解答技术疑点,又能生成代码示例、优化创作逻辑,甚至自主完成跨工具的复杂任务流程。

本教程将通过理论解析 + 实战案例 + 工具指南的三维结构,结合代码示例、Mermaid 流程图、可复用 Prompt 模板和工具对比图表,带你系统掌握 Agentic AI 的核心原理与 AI 编程的实战方法,最终让 AI 成为你不可或缺的学习导师与创作伙伴。

第一部分:Agentic AI 入门 —— 让 AI 自主驱动学习与创作

1.1 什么是 Agentic AI?

Agentic AI(智能体 AI) 是指具备目标导向性与自主决策能力的 AI 系统,其核心特征可概括为 "四自能力":

- 自主目标解析:将模糊需求(如 "帮我学 Python")转化为清晰可执行的目标(如 "30 天 Python 入门计划,含语法、函数、实战项目");

- 自主规划拆解:生成步骤化执行方案,能动态调整任务顺序与资源分配;

- 自主工具调用:根据任务需求调用搜索引擎、代码解释器、文档解析器等外部工具;

- 自主反馈迭代:基于执行结果评估目标达成度,优化策略直至任务完成。

与传统问答式 AI 相比,Agentic AI 实现了从 "被动响应" 到 "主动服务" 的范式转变,其差异可通过具体场景直观体现:

| 应用场景 | 传统 AI 交互模式 | Agentic AI 交互模式 |

|---|---|---|

| 学术论文调研 | 用户:"找 2024 年 AI Agent 相关论文"→AI:"论文列表如下"→用户:"总结核心观点"→AI:"观点 1..."→用户:"对比不同研究方法"→AI:"方法对比如下" | 用户:"帮我完成 AI Agent 研究综述,需包含 2024 年 10 篇核心论文的观点提炼、方法对比及未来趋势预测"→AI:"执行计划:1. 调用学术搜索引擎获取高被引论文;2. 解析论文核心内容;3. 构建对比框架;4. 生成综述初稿;5. 补充最新研究动态。现在开始执行..."(20 分钟后输出完整综述 + 论文原文链接) |

| 编程项目开发 | 用户:"教我用 Flask 写接口"→AI:"代码如下..."→用户:"怎么连接数据库"→AI:"用 SQLAlchemy..."→用户:"如何实现权限验证"→AI:"使用 JWT..." | 用户:"帮我开发一个用户管理 API 服务,用 Flask 实现,需包含注册、登录、权限控制功能,连接 MySQL 数据库并生成接口文档"→AI:"开发计划:1. 设计数据库模型;2. 实现核心接口;3. 集成认证机制;4. 生成 Swagger 文档;5. 编写测试用例。现在生成完整代码架构..."(附项目文件结构 + 所有代码) |

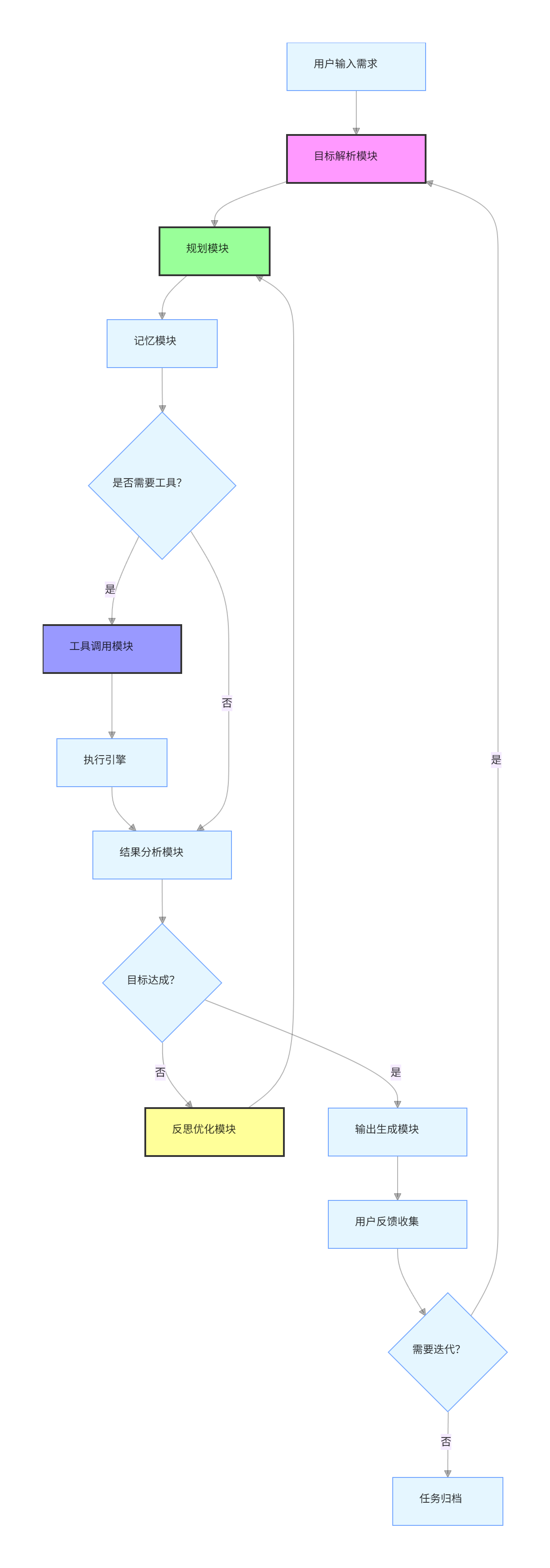

1.2 Agentic AI 的核心架构与工作流

一个成熟的 Agentic AI 系统由六大核心模块构成,其协同工作流程可通过 Mermaid 流程图清晰展示:

graph TD

A[用户输入需求] --> B[目标解析模块]

B --> C[规划模块]

C --> D[记忆模块]

D --> E{是否需要工具?}

E -- 是 --> F[工具调用模块]

F --> G[执行引擎]

G --> H[结果分析模块]

E -- 否 --> H

H --> I{目标达成?}

I -- 否 --> J[反思优化模块]

J --> C

I -- 是 --> K[输出生成模块]

K --> L[用户反馈收集]

L --> M{需要迭代?}

M -- 是 --> B

M -- 否 --> N[任务归档]

style B fill:#f9f,stroke:#333,stroke-width:2px

style C fill:#9f9,stroke:#333,stroke-width:2px

style F fill:#99f,stroke:#333,stroke-width:2px

style J fill:#ff9,stroke:#333,stroke-width:2px

核心模块功能详解

- 目标解析模块:基于自然语言处理技术,提取需求中的核心目标、约束条件(如时间、资源)和质量要求。例如将 "3 天内做一个简单的数据分析报告" 解析为:目标 = 生成数据分析报告,时间约束 = 72 小时,复杂度 = 简单,输出形式 = 报告文档。

- 规划模块:采用 "分而治之" 策略,将复杂目标拆解为原子任务。如将 "数据分析报告" 拆解为 "数据获取→数据清洗→可视化分析→结论提炼" 四个子任务,支持动态优先级调整。

- 记忆模块:分为短期记忆(当前会话上下文)和长期记忆(历史任务数据、用户偏好),采用向量数据库存储以实现高效检索。例如记住用户 "偏好用 Seaborn 绘图" 的习惯,在后续任务中自动应用。

- 工具调用模块:管理工具注册表与调用协议,支持 API 调用、代码执行、文档解析等能力。LangChain 等框架已实现对 200 + 常用工具的标准化集成。

- 反思优化模块:通过 "执行结果→预期目标" 的差异分析,生成优化策略。例如发现 "数据可视化效果不佳" 时,自动调整图表类型或配色方案。

- 输出生成模块:根据用户偏好格式化输出内容,支持文档、代码、图表等多种形式,可自动生成目录、注释和使用说明。

1.3 实战:用 LangChain 构建个人学习智能体

LangChain 作为 Agentic AI 开发的主流框架,提供了模块化的组件体系,让新手也能快速搭建自定义智能体。以下以 "Python 数据分析学习智能体" 为例,展示完整构建过程。

前置准备

- 环境安装:

bash

# 安装核心库

pip install langchain openai chromadb pypdf python-dotenv

# 安装工具依赖

pip install pandas matplotlib seaborn requests

- 配置 API 密钥:创建

.env文件存储 OpenAI API 密钥

env

OPENAI_API_KEY=your_api_key_here

步骤 1:构建基础组件

首先初始化模型、记忆与工具组件:

python

from langchain_openai import ChatOpenAI

from langchain.memory import ConversationBufferWindowMemory

from langchain.tools import Tool, tool

from langchain.utilities import SerpAPIWrapper

from dotenv import load_dotenv

import os

# 加载环境变量

load_dotenv()

# 1. 初始化大语言模型(采用GPT-4.1增强Agent能力)

llm = ChatOpenAI(

model="gpt-4.1-preview",

temperature=0.3, # 低温度保证输出确定性

max_tokens=2048

)

# 2. 配置记忆模块(保留最近5轮对话)

memory = ConversationBufferWindowMemory(

k=5,

return_messages=True,

memory_key="chat_history"

)

# 3. 定义工具函数

# 工具1:学术搜索(获取学习资源)

search = SerpAPIWrapper(serpapi_api_key=os.getenv("SERPAPI_KEY"))

# 工具2:代码执行(运行数据分析代码)

@tool

def execute_python_code(code: str) -> str:

"""

执行Python代码并返回结果,适用于数据分析、可视化等任务。

注意:仅执行可信代码,避免包含文件操作或网络请求的代码。

"""

try:

# 创建临时执行环境

local_vars = {}

exec(code, globals(), local_vars)

return f"代码执行成功,返回结果:{local_vars.get('result', '无显式结果')}"

except Exception as e:

return f"代码执行失败,错误信息:{str(e)}"

# 工具3:文档解析(解析PDF教程)

@tool

def parse_pdf_document(file_path: str) -> str:

"""

读取PDF文件内容并返回文本,适用于解析学习资料、教程文档。

"""

from langchain.document_loaders import PyPDFLoader

try:

loader = PyPDFLoader(file_path)

pages = loader.load_and_split()

return f"PDF解析成功(共{len(pages)}页),内容摘要:{pages[0].page_content[:500]}..."

except Exception as e:

return f"PDF解析失败,错误信息:{str(e)}"

# 4. 注册工具

tools = [

Tool(

name="Search",

func=search.run,

description="用于搜索最新的Python数据分析学习资源、教程、数据集"

),

Tool(

name="CodeExecutor",

func=execute_python_code,

description="用于执行Python数据分析代码,验证代码正确性"

),

Tool(

name="PDFParser",

func=parse_pdf_document,

description="用于解析PDF格式的学习资料和教程文档"

)

]

步骤 2:配置 Agent 核心逻辑

利用 LangChain 的 AgentExecutor 实现自主决策与工具调用:

python

from langchain.agents import create_openai_functions_agent

from langchain.agents import AgentExecutor

from langchain.prompts import ChatPromptTemplate, MessagesPlaceholder

# 1. 定义Agent提示模板(融入GPT-4.1 Agentic最佳实践)

prompt = ChatPromptTemplate.from_messages([

(

"system",

"""

你是专业的Python数据分析学习导师,具备以下能力:

1. 目标导向:严格按照用户的学习目标制定计划,持续工作直至目标达成

2. 工具使用:必须通过提供的工具完成任务,不凭记忆回答时效性/技术性问题

3. 规划反思:每次行动前制定详细步骤,行动后反思结果是否符合预期

4. 教学风格:结合实例讲解,代码需附带详细注释,语言通俗易懂

可用工具:

- Search:获取学习资源、数据集、最新教程

- CodeExecutor:运行和验证Python代码

- PDFParser:解析PDF学习资料

工作流程:

1. 明确用户的学习基础、时间安排和目标需求

2. 制定分阶段学习计划,包含知识点、案例和练习

3. 调用工具获取所需资源和数据

4. 生成可执行的代码示例并验证正确性

5. 根据用户反馈调整学习计划

"""

),

MessagesPlaceholder(variable_name="chat_history"),

("user", "{input}"),

MessagesPlaceholder(variable_name="agent_scratchpad")

])

# 2. 创建Agent实例

agent = create_openai_functions_agent(

llm=llm,

tools=tools,

prompt=prompt

)

# 3. 初始化Agent执行器

agent_executor = AgentExecutor(

agent=agent,

tools=tools,

memory=memory,

verbose=True, # 显示思考过程

return_intermediate_steps=True # 返回中间执行步骤

)

步骤 3:运行与交互示例

启动智能体并进行学习交互:

python

# 第一次交互:设定学习目标

result = agent_executor.invoke({

"input": "我是Python新手,每天能学习1小时,想在2周内掌握数据分析基础,需要包含Pandas和Matplotlib的实战案例"

})

# 输出结果(简化版)

print("智能体响应:", result["output"])

# 第二次交互:反馈学习问题

result = agent_executor.invoke({

"input": "我对Pandas的数据筛选方法不太理解,特别是loc和iloc的区别,能提供带注释的示例吗?"

})

# 输出结果(简化版)

print("智能体响应:", result["output"])

交互效果展示

第一次交互输出:

plaintext

> 思考:用户是Python新手,每天1小时,2周内掌握数据分析基础,重点是Pandas和Matplotlib。首先需要明确学习路径,然后获取合适的资源和数据集。

> 工具调用:Search("Python数据分析 2周学习计划 Pandas Matplotlib 新手")

> 搜索结果:找到《Python数据分析2周入门指南》和 Kaggle 零售数据集...

> 思考:已获取学习计划和数据集,接下来生成Day1的学习内容,包含基础概念和简单代码示例。

> 工具调用:CodeExecutor("""

import pandas as pd

# 读取零售数据集

df = pd.read_csv("retail_data.csv")

# 查看前5行数据

print("数据集前5行:")

print(df.head())

# 查看数据基本信息

print("\n数据基本信息:")

print(df.info())

result = "数据集包含1000条记录,8个字段"

""")

> 代码执行结果:代码执行成功,返回结果:数据集包含1000条记录,8个字段

> 思考:代码验证通过,现在整理Day1学习计划并输出。

## Python数据分析2周学习计划(Day1)

### 学习目标

掌握Pandas基础:数据读取与基本信息查看

### 核心知识点

1. Pandas安装:`pip install pandas`

2. 数据读取:`pd.read_csv()` 读取CSV文件

3. 数据预览:`head()` 查看前N行数据

4. 数据信息:`info()` 查看字段类型与缺失值

### 实战代码(带注释)

```python

import pandas as pd

# 读取Kaggle零售数据集(已为你搜索获取)

# 下载地址:https://www.kaggle.com/datasets/retail-data-set

df = pd.read_csv("retail_data.csv")

# 查看数据集前5行,快速了解数据结构

print("数据集前5行:")

print(df.head()) # 默认显示前5行,可通过df.head(10)显示前10行

# 查看数据基本信息,包括字段名、类型、非空值数量

print("\n数据基本信息:")

print(df.info()) # 重点关注"Non-Null Count"列,判断是否有缺失值

练习任务

- 下载零售数据集并运行上述代码

- 尝试使用

df.tail()查看数据集最后 5 行 - 用

df.describe()查看数值型字段的统计信息

明日预告

Day2 将学习数据清洗:缺失值处理与重复值删除

第二次交互输出:

plaintext

> 思考:用户对loc和iloc区别有疑问,需要先明确两者的核心差异,再提供对比示例。

> 工具调用:CodeExecutor("""

import pandas as pd

import numpy as np

# 创建示例DataFrame

data = {

"姓名": ["张三", "李四", "王五", "赵六"],

"年龄": [25, 30, 35, 40],

"城市": ["北京", "上海", "广州", "深圳"]

}

df = pd.DataFrame(data, index=["A", "B", "C", "D"]) # 设置自定义索引

print("示例DataFrame:")

print(df)

# 1. loc用法:基于标签(行名/列名)索引

print("\n1. loc基于标签索引:")

# 选取行标签为"B"的整行

row_b = df.loc["B"]

print("行标签'B'的数据:", row_b)

# 选取行标签"A"到"C",列标签"姓名"到"年龄"

range_data = df.loc["A":"C", "姓名":"年龄"]

print("行A-C、列姓名-年龄的数据:")

print(range_data)

# 2. iloc用法:基于位置(整数索引)索引

print("\n2. iloc基于位置索引:")

# 选取第2行(索引从0开始)

row_1 = df.iloc[1]

print("第2行的数据:", row_1)

# 选取第0到2行,第0到1列

pos_data = df.iloc[0:3, 0:2]

print("第0-2行、第0-1列的数据:")

print(pos_data)

# 核心区别总结

result = """

loc vs iloc核心区别:

1. 索引依据:loc按标签(行名/列名),iloc按位置(0开始的整数)

2. 切片规则:loc包含结束位置,iloc不包含结束位置

3. 适用场景:loc适合按名称定位,iloc适合按位置定位

"""

print(result)

""")

> 代码执行结果:代码执行成功,返回结果:loc vs iloc核心区别:...

> 思考:示例代码清晰展示了两者区别,无需进一步工具调用,直接整理输出。

## loc与iloc的区别详解(附实战示例)

### 核心差异对比

| 特性 | loc方法 | iloc方法 |

|--------------|--------------------------|---------------------------|

| 索引依据 | 行标签/列标签(如"A"、"姓名") | 整数位置索引(如0、1、2) |

| 切片规则 | 包含结束位置(如"A":"C"含C) | 不包含结束位置(如0:3含0-2) |

| 支持条件查询 | 是(如df.loc[df["年龄"]>30]) | 否(需转换为位置索引) |

| 适用场景 | 按名称定位数据 | 按位置快速访问数据 |

### 实战代码示例(可直接运行)

```python

import pandas as pd

# 1. 准备示例数据(含自定义行标签)

data = {

"姓名": ["张三", "李四", "王五", "赵六"],

"年龄": [25, 30, 35, 40],

"城市": ["北京", "上海", "广州", "深圳"]

}

df = pd.DataFrame(data, index=["员工A", "员工B", "员工C", "员工D"]) # 自定义行标签

print("原始数据:")

print(df)

# 2. loc用法示例

print("\n=== loc方法演示 ===")

# 2.1 按行标签选取单行

print("1. 选取'员工B'的信息:")

print(df.loc["员工B"])

# 2.2 按行标签范围选取多行

print("\n2. 选取'员工A'到'员工C'的信息:")

print(df.loc["员工A":"员工C"]) # 包含结束标签"员工C"

# 2.3 按列标签选取特定列

print("\n3. 选取所有员工的'姓名'和'城市':")

print(df.loc[:, ["姓名", "城市"]]) # 冒号表示所有行

# 2.4 结合条件查询

print("\n4. 选取年龄大于30的员工:")

print(df.loc[df["年龄"] > 30])

# 3. iloc用法示例

print("\n=== iloc方法演示 ===")

# 3.1 按位置选取单行(第2行,索引从0开始)

print("1. 选取第2行的信息:")

print(df.iloc[1])

# 3.2 按位置范围选取多行

print("\n2. 选取第0到2行的信息:")

print(df.iloc[0:3]) # 不包含结束位置3,实际取0-2行

# 3.3 按位置选取特定列(第0列和第2列)

print("\n3. 选取所有员工的第0列和第2列:")

print(df.iloc[:, [0, 2]])

# 3.4 按位置选取特定单元格(第3行第1列)

print("\n4. 选取第3行第1列的值:")

print(df.iloc[3, 1])

练习任务

- 运行上述代码,观察两种方法的输出差异

- 尝试用 loc 选取 "员工 C" 的 "年龄" 字段

- 尝试用 iloc 选取第 1 行第 2 列的字段

1.4 Agentic AI 工具生态与选型指南

当前 Agentic AI 工具已形成 "通用平台 + 垂直领域" 的二元生态,不同工具的特性与适用场景差异显著,可通过下表进行选型:

| 工具类型 | 代表工具 | 核心特性 | 优势 | 局限 | 适用人群 |

|---|---|---|---|---|---|

| 通用智能体平台 | ChatGPT-4.1(带插件) | 支持 800 + 工具调用,长上下文(128k tokens),强 Agentic 规划能力 | 生态完善,交互友好,无需代码即可使用 | 付费订阅($20 / 月),部分工具需单独配置 | 学习用户、内容创作者、非技术人员 |

| 通用智能体平台 | Claude 3.5 Sonnet | 支持 100 万 tokens 上下文,可直接运行代码、生成文件,隐私保护更强 | 长文档处理能力突出,代码执行体验好 | 工具种类少于 ChatGPT,国内访问需特殊配置 | 学术研究者、需要处理大文件的用户 |

| 开发框架 | LangChain | 模块化组件体系,支持自定义 Agent,集成 200 + 工具,兼容主流 LLM | 灵活性高,可深度定制,社区资源丰富 | 需具备 Python 基础,学习曲线较陡 | 开发者、技术爱好者、需要定制智能体的用户 |

| 开发框架 | AutoGen | 多智能体协作能力突出,支持智能体对话分工,内置代码执行与调试模块 | 适合复杂任务拆分,多角色协作场景 | 配置较复杂,对硬件要求较高 | 团队开发、复杂项目管理、多任务协同场景 |

| 垂直领域智能体 | CodeRabbit | 专注代码审查,支持 GitHub 集成,自动识别 bug、优化性能、生成测试用例 | 代码理解精准,与开发流程无缝衔接 | 仅限代码相关任务,功能单一 | 程序员、开发团队 |

| 垂直领域智能体 | ScholarAI | 专注学术研究,可检索论文、解析数据、生成文献综述,支持 LaTeX 公式生成 | 学术资源整合能力强,引用格式规范 | 非学术场景适用性低,部分数据库需权限 | 科研人员、研究生、学术写作者 |

新手入门推荐工具组合

-

学习场景:ChatGPT-4.1 + LangChain 模板库

- 优势:无需代码即可使用强大的 Agent 能力,同时可复用社区现成模板

- 配置步骤:登录 ChatGPT 官网→开通 Plus 会员→在设置中启用 "Advanced Data Analysis" 和 "Plugins"

-

编程场景:Cursor AI + LangChain Code Agent

- 优势:IDE 集成式体验,代码生成与调试同步进行,支持自定义工具

- 配置步骤:下载 Cursor IDE→在设置中登录 OpenAI 账号→安装 LangChain 插件

1.5 Agentic AI 提示词工程最佳实践

提示词(Prompt)是驱动 Agentic AI 高效工作的核心,结合 GPT-4.1 官方指南与实战经验,总结以下 5 大技巧:

技巧 1:明确 Agent 角色与能力边界

通过角色定义激活模型的领域知识,同时明确能力范围避免越界。Prompt 模板:

plaintext

你是{专业领域}的专家,拥有{X}年实战经验,专长于{具体技能}。

你的核心能力:

1. 能通过{工具1}获取{资源类型}

2. 能通过{工具2}完成{任务类型}

3. 能生成{输出形式}的结果

你的限制:

1. 不回答超出{专业领域}的问题

2. 所有结论必须基于工具获取的数据,不编造信息

3. 输出内容需符合{格式要求}

请根据用户需求,制定执行计划并完成任务。

示例:

plaintext

你是Python数据分析专家,拥有5年实战经验,专长于Pandas数据处理与Matplotlib可视化。

你的核心能力:

1. 能通过Search获取公开数据集和教程

2. 能通过CodeExecutor运行和验证Python代码

3. 能生成带注释的代码和Markdown格式的分析报告

你的限制:

1. 不回答超出数据分析领域的问题

2. 所有结论必须基于工具获取的数据,不编造信息

3. 输出内容需包含"核心知识点"、"实战代码"、"练习任务"三部分

请根据用户需求,制定执行计划并完成任务。

技巧 2:采用 "目标 - 约束 - 输出" 三段式结构

清晰的结构能帮助 Agent 快速抓取关键信息,减少无效交互。结构解析:

- 目标:明确需要完成的具体任务(可量化、可验证)

- 约束:时间、资源、格式、质量等限制条件

- 输出:预期的结果形式、交付物清单、评估标准

Prompt 示例:

plaintext

## 任务目标

帮我完成一份"2024年中国电商用户行为分析"的数据分析报告,需包含用户地域分布、消费时段偏好两个核心维度。

## 约束条件

1. 时间限制:1小时内完成

2. 数据来源:需调用Search获取2024年公开电商数据集(优先Kaggle、国家统计局数据源)

3. 分析工具:使用Pandas进行数据处理,Matplotlib绘制可视化图表

4. 报告长度:不超过2000字

## 输出要求

1. 交付物:数据集链接 + 完整分析代码(带注释) + Markdown格式报告

2. 报告结构:数据概述→分析过程→可视化解读→结论建议

3. 评估标准:数据真实可信,代码可直接运行,结论有数据支撑

技巧 3:强制 Agent 生成执行计划

引导 Agent 在行动前明确步骤,减少盲目工具调用,提升效率。Prompt 模板:

plaintext

在开始执行任务前,请先输出详细的执行计划,包含以下内容:

1. 任务拆解:将目标分解为3-5个具体子任务

2. 工具选择:每个子任务需要调用的工具及理由

3. 时间分配:每个子任务的预计耗时

4. 风险预案:可能遇到的问题及解决方案

执行计划需经我确认后,再开始执行任务。

技巧 4:融入思维链(Chain of Thought)引导

要求 Agent 展示思考过程,便于追踪决策逻辑,及时修正偏差。Prompt 示例:

plaintext

在完成任务过程中,请每执行一步后,补充"思考笔记",包含:

1. 当前执行的子任务

2. 选择该操作的原因

3. 预期结果

4. 下一步计划

例如:

> 执行操作:调用Search搜索"2024中国电商用户数据集"

> 思考笔记:

> 1. 当前子任务:获取分析所需数据

> 2. 原因:用户未提供数据集,需通过搜索获取公开资源

> 3. 预期结果:找到至少2个符合要求的数据集链接

> 4. 下一步计划:若搜索成功则选择合适数据集,失败则推荐替代数据源

技巧 5:设置反馈迭代机制

主动邀请用户反馈,让 Agent 根据意见优化结果,形成闭环。Prompt 模板:

plaintext

完成初步任务后,请按以下格式输出:

1. 任务完成情况:已完成/未完成的子任务清单

2. 核心交付物:本次生成的关键结果(如链接、代码、摘要)

3. 待优化点:可能需要改进的地方(至少2点)

4. 反馈请求:请用户提供具体的修改意见(可从内容、格式、深度等方面提出)

根据用户反馈,我将进行迭代优化,直至任务完全满足需求。

第二部分:AI 编程入门 —— 让 AI 成为你的编码伴侣

2.1 AI 编程工具生态与核心能力

AI 编程工具已从单纯的代码补全进化为 "全流程辅助" 工具,能覆盖从需求分析到部署测试的完整开发周期。2025 年主流 AI 编程工具的核心能力对比如下:

| 核心能力 | Cursor AI | GitHub Copilot X | Bolt.new | Claude 3.5 Sonnet |

|---|---|---|---|---|

| 代码生成 | 支持全文件生成,可理解项目结构 | 实时代码补全,支持多语言 | 支持全栈项目生成,30 秒出原型 | 支持复杂逻辑代码,可解释思路 |

| 代码解释 | 可逐行解释代码,生成注释 | 支持函数级解释,关联文档 | 侧重 UI 组件解释,较基础 | 支持架构级解释,逻辑清晰 |

| 调试能力 | 内置 "Debug with AI" 按钮,自动修复 | 需手动复制错误信息,提供修复建议 | 支持实时运行调试,错误提示直观 | 可模拟运行,定位深层 bug |

| 项目管理 | 支持文件树分析,跨文件引用提示 | 集成 GitHub,支持 PR 审查 | 支持项目导出,与 Vercel 集成 | 可生成项目文档,规划开发步骤 |

| 学习支持 | 提供替代实现方案,对比优劣 | 关联 Stack Overflow 答案 | 侧重前端技术讲解,案例丰富 | 支持自定义学习路径,推荐资源 |

| 免费额度 | 免费 500 次提示,后续付费 | 学生免费,个人 $19 / 月 | 完全免费,有功能限制 | 免费版有额度限制,Pro 版 $20 / 月 |

2.2 新手入门:Cursor AI + Python 编程实战

Cursor AI 作为 2025 年最受欢迎的 AI 编程工具,以 "IDE 集成 + 强 Agentic 能力" 著称,特别适合新手入门。以下以 "开发一个天气查询小程序" 为例,展示完整的 AI 辅助编程流程。

步骤 1:环境配置

- 下载并安装 Cursor IDE:访问Cursor 官网下载对应系统版本(支持 Windows/macOS)

- 激活 AI 功能:打开 Cursor→点击右上角 "Settings"→登录 OpenAI 账号→启用 "AI Assistant"

- 安装依赖库:在 Cursor 终端中执行

bash

pip install requests python-dotenv

步骤 2:需求分析与 Prompt 设计

向 AI 明确程序需求,采用 "功能 - 输入 - 输出 - 技术栈" 四要素描述:

plaintext

请帮我开发一个Python天气查询小程序,需求如下:

1. 核心功能:根据用户输入的城市名,查询实时天气(温度、湿度、天气状况)

2. 输入:用户通过命令行输入城市名(如"北京")

3. 输出:格式化显示天气信息,示例:"【北京实时天气】温度:25℃ 湿度:60% 状况:晴"

4. 技术栈:使用requests库调用公开天气API,dotenv管理API密钥

5. 附加功能:

- 输入错误处理(如城市不存在、网络异常)

- 支持连续查询,输入"q"退出程序

- 生成详细的代码注释

请先分析实现步骤,再生成完整代码。

步骤 3:AI 生成代码与解析

Cursor AI 会先输出实现步骤,再生成完整代码:

AI 生成的实现步骤:

plaintext

实现天气查询小程序的步骤:

1. 获取天气API密钥:推荐使用高德开放平台天气API(免费注册获取)

2. 配置环境变量:创建.env文件存储API密钥,避免硬编码

3. 编写核心函数:

- load_env():加载环境变量

- get_weather(city):调用API获取天气数据

- parse_weather(data):解析API返回的JSON数据

4. 实现交互逻辑:

- 接收用户输入

- 错误处理(城市不存在、网络错误等)

- 连续查询功能

5. 测试与优化:验证不同场景下的程序稳定性

AI 生成的完整代码:

python

import requests

import os

from dotenv import load_dotenv

def load_environment():

"""

加载环境变量,获取API密钥

返回:API密钥字符串,若加载失败则返回None

"""

try:

# 加载.env文件中的环境变量

load_dotenv()

api_key = os.getenv("AMAP_API_KEY")

if not api_key:

raise ValueError("API密钥未在.env文件中配置")

return api_key

except Exception as e:

print(f"环境配置错误:{str(e)}")

return None

def fetch_weather_data(city: str, api_key: str) -> dict:

"""

调用高德开放平台天气API获取城市天气数据

参数:

city: 城市名称(如"北京")

api_key: 高德开放平台API密钥

返回:

成功:包含天气数据的字典

失败:空字典并打印错误信息

"""

# 高德天气API接口

base_url = "https://restapi.amap.com/v3/weather/weatherInfo"

# 请求参数

params = {

"city": city,

"key": api_key,

"extensions": "base" # 获取实时天气

}

try:

# 发送GET请求

response = requests.get(base_url, params=params, timeout=10)

# 检查响应状态码

response.raise_for_status() # 非200状态码会抛出异常

# 解析JSON响应

data = response.json()

# 检查API返回状态

if data.get("status") != "1":

print(f"API请求失败:{data.get('info', '未知错误')}")

return {}

return data

except requests.exceptions.Timeout:

print("错误:请求超时,请检查网络连接")

return {}

except requests.exceptions.ConnectionError:

print("错误:网络连接失败,请检查网络设置")

return {}

except Exception as e:

print(f"获取天气数据失败:{str(e)}")

return {}

def parse_weather_info(weather_data: dict) -> dict:

"""

解析天气数据,提取核心信息

参数:

weather_data: API返回的原始天气数据

返回:

包含核心天气信息的字典,解析失败则返回空字典

"""

try:

# 提取天气数据列表(通常第一个元素为目标城市数据)

lives = weather_data.get("lives", [])

if not lives:

print("错误:未找到对应城市的天气数据")

return {}

# 提取核心天气信息

weather_info = lives[0]

result = {

"city": weather_info.get("city", "未知城市"),

"temperature": weather_info.get("temperature", "未知"), # 温度

"humidity": weather_info.get("humidity", "未知"), # 湿度

"weather": weather_info.get("weather", "未知"), # 天气状况

"winddirection": weather_info.get("winddirection", "未知"), # 风向

"windpower": weather_info.get("windpower", "未知") # 风力

}

return result

except Exception as e:

print(f"解析天气数据失败:{str(e)}")

return {}

def weather_app():

"""

天气查询小程序主函数,实现用户交互逻辑

"""

print("===== 天气查询小程序 =====")

print("提示:输入城市名查询天气,输入'q'退出程序")

print("-" * 30)

# 加载环境变量和API密钥

api_key = load_environment()

if not api_key:

print("程序初始化失败,无法继续运行")

return

# 循环接收用户输入,实现连续查询

while True:

# 获取用户输入

city = input("\n请输入城市名:").strip()

# 检查是否退出程序

if city.lower() == "q":

print("感谢使用,程序已退出!")

break

# 输入验证

if not city:

print("错误:请输入有效的城市名")

continue

# 获取并解析天气数据

print(f"正在查询{city}的天气信息...")

raw_data = fetch_weather_data(city, api_key)

if not raw_data:

continue

weather_info = parse_weather_info(raw_data)

if not weather_info:

continue

# 格式化输出天气信息

print("\n【{}实时天气】".format(weather_info["city"]))

print(f"温度:{weather_info['temperature']}℃")

print(f"湿度:{weather_info['humidity']}%")

print(f"状况:{weather_info['weather']}")

print(f"风向:{weather_info['winddirection']}")

print(f"风力:{weather_info['windpower']}级")

# 程序入口

if __name__ == "__main__":

weather_app()

步骤 4:API 密钥配置与运行测试

- 获取 API 密钥:访问高德开放平台注册账号→创建应用→获取天气 API 密钥

- 创建

.env文件:在项目目录下新建文件,写入

env

AMAP_API_KEY=你的API密钥

- 运行程序:在 Cursor 中按

F5运行,测试效果如下:

plaintext

===== 天气查询小程序 =====

提示:输入城市名查询天气,输入'q'退出程序

------------------------------

请输入城市名:上海

正在查询上海的天气信息...

【上海市实时天气】

温度:28℃

湿度:65%

状况:多云

风向:东南风

风力:3级

请输入城市名:q

感谢使用,程序已退出!

步骤 5:AI 辅助调试与优化

假设运行时出现 "未找到对应城市的天气数据" 错误,向 Cursor AI 提问:

plaintext

我的程序输入"上海"能正常查询,但输入"上海市"会提示"未找到对应城市的天气数据",请帮我找到问题并修复。

AI 分析与修复方案:

plaintext

问题原因:

高德天气API对城市名的匹配精度较高,"上海市"包含"市"字,与API数据库中的"上海"不匹配,导致查询失败。

修复方案:

在接收用户输入后,自动去除城市名中的"市"、"省"、"自治区"等后缀,统一格式后再调用API。

修改后的代码(fetch_weather_data函数前增加预处理函数):

def preprocess_city_name(city: str) -> str:

"""

预处理城市名,去除常见后缀,统一格式

"""

# 定义需要去除的后缀列表

suffixes = ["市", "省", "自治区", "自治州", "盟", "地区", "县", "区"]

for suffix in suffixes:

if city.endswith(suffix):

city = city[:-len(suffix)]

break # 只去除最后一个匹配的后缀

return city

# 在weather_app函数的输入处理部分调用预处理函数

city = input("\n请输入城市名:").strip()

city = preprocess_city_name(city) # 新增这行

2.3 AI 辅助编程的核心场景与 Prompt 模板

AI 编程工具能覆盖开发全流程,以下是高频场景的 Prompt 模板与实战案例:

场景 1:需求转代码(从零开始生成程序)

核心需求:将自然语言需求转化为可运行的代码,适合新手快速实现功能。Prompt 模板:

plaintext

请帮我用{编程语言}实现{功能描述},具体要求如下:

1. 输入:{输入内容/格式}

2. 输出:{输出内容/格式}

3. 功能细节:{详细功能点,如错误处理、边界情况等}

4. 技术限制:{必须使用/禁止使用的技术、库、框架}

5. 代码要求:{注释要求、命名规范、代码结构等}

请先分析实现思路,再生成完整代码,并说明运行步骤。

实战示例:

plaintext

请帮我用Python实现"学生成绩管理系统",具体要求如下:

1. 输入:支持添加(姓名 科目 成绩)、查询(姓名)、修改(姓名 科目 新成绩)、删除(姓名)四种操作

2. 输出:查询时显示该学生所有科目成绩及平均分,其他操作显示"操作成功"或"操作失败"

3. 功能细节:

- 成绩需在0-100之间,否则提示"成绩无效"

- 查询不存在的学生时提示"未找到该学生"

- 支持连续操作,输入"exit"退出系统

4. 技术限制:使用字典存储数据,不使用数据库

5. 代码要求:每个函数带注释,使用面向对象编程思想

请先分析实现思路,再生成完整代码,并说明运行步骤。

场景 2:代码解释(理解陌生代码)

核心需求:让 AI 逐行解释代码逻辑,适合学习开源项目或理解遗留代码。Prompt 模板:

plaintext

请解释以下{编程语言}代码的功能与逻辑,要求:

1. 整体功能:说明这段代码的核心作用

2. 逐块解析:按函数/类/关键代码块解释逻辑

3. 关键技术:指出使用的核心技术、算法或设计模式

4. 潜在问题:分析可能存在的bug、性能瓶颈或安全隐患

5. 优化建议:提出改进方向(可选)

代码如下:

{粘贴代码}

plaintext

场景 3:bug 修复(定位并解决代码错误)

核心需求:提供错误信息与代码,让 AI 定位问题并修复,适合调试阶段。Prompt 模板:

plaintext

我的{编程语言}代码运行时出现错误,具体信息如下:

1. 错误类型:{错误名称,如SyntaxError、TypeError}

2. 错误信息:{完整的错误提示文本}

3. 复现步骤:{输入什么、执行什么操作会触发错误}

相关代码如下(标记出错位置):

{粘贴代码,用 // 出错位置 标记可能的错误行}

plaintext

请帮我:

1. 分析错误原因

2. 提供修复后的完整代码

3. 说明避免类似错误的注意事项

场景 4:代码优化(提升质量与性能)

核心需求:让 AI 优化现有代码,提升可读性、性能或安全性,适合代码重构阶段。Prompt 模板:

plaintext

请优化以下{编程语言}代码,优化方向:

1. {优化目标1,如提升性能、增强可读性、减少内存占用等}

2. {优化目标2}

3. {技术限制:如不能改变函数输入输出、需兼容Python 3.8+等}

原始代码:

{粘贴代码}

plaintext

请提供:

1. 优化思路:说明针对每个目标的优化方法

2. 优化后代码:完整的优化后代码

3. 效果对比:优化前后的性能/可读性提升情况(可选)

2.4 AI 编程进阶:全栈 AI 项目实战(LangChain + FastAPI + React)

为展示 AI 在复杂项目中的应用,以下以 "智能简历匹配系统" 为例,展示全栈 AI 项目的开发流程,AI 将负责 80% 的代码生成工作。

项目需求

开发一个能根据职位描述(JD)匹配简历的系统,核心功能:

- 上传 JD 与简历(支持 PDF 格式)

- 自动解析文档内容,提取核心技能、工作经验等信息

- 计算匹配度并生成详细对比报告

- 提供 Web 界面供用户操作

技术栈

- 后端:Python + FastAPI + LangChain(文档解析与 AI 匹配)

- 前端:React + Ant Design(用户界面)

- 数据库:ChromaDB(向量存储,用于相似度计算)

步骤 1:AI 生成后端 API(FastAPI)

向 ChatGPT-4.1 提问:

plaintext

请用Python + FastAPI + LangChain开发简历匹配系统的后端API,需求:

1. 接口1:/upload - 接收JD和简历的PDF文件,返回文件ID

2. 接口2:/match - 接收两个文件ID(jd_id和resume_id),返回匹配度(0-100)和对比报告

3. 文档解析:使用LangChain的PyPDFLoader解析PDF,提取核心信息(技能、经验、学历等)

4. 匹配算法:将解析内容转换为向量,计算余弦相似度,结合AI评分生成匹配度

5. 错误处理:处理文件格式错误、文件不存在等异常

请生成完整代码,包含main.py、utils.py、requirements.txt,并说明运行步骤。

AI 生成的核心代码(main.py):

python

from fastapi import FastAPI, UploadFile, File, HTTPException

from fastapi.middleware.cors import CORSMiddleware

import uuid

import os

from utils import parse_pdf, calculate_match

# 初始化FastAPI应用

app = FastAPI(title="简历匹配系统API", version="1.0")

# 配置CORS,允许前端访问

app.add_middleware(

CORSMiddleware,

allow_origins=["*"], # 生产环境需替换为前端域名

allow_credentials=True,

allow_methods=["*"],

allow_headers=["*"],

)

# 配置文件存储路径

UPLOAD_DIR = "uploads"

os.makedirs(UPLOAD_DIR, exist_ok=True)

# 存储文件ID与路径的映射(生产环境需用数据库)

file_map = {}

# 1. 文件上传接口

@app.post("/upload", summary="上传PDF文件(JD或简历)")

async def upload_file(file: UploadFile = File(...)):

# 验证文件格式

if not file.filename.endswith(".pdf"):

raise HTTPException(status_code=400, detail="仅支持PDF格式文件")

# 生成唯一文件ID

file_id = str(uuid.uuid4())

# 保存文件

file_path = os.path.join(UPLOAD_DIR, f"{file_id}.pdf")

with open(file_path, "wb") as f:

f.write(await file.read())

# 记录文件映射

file_map[file_id] = file_path

return {"file_id": file_id, "message": "文件上传成功"}

# 2. 匹配分析接口

@app.get("/match", summary="计算JD与简历的匹配度")

async def match_resume(jd_id: str, resume_id: str):

# 验证文件ID存在

if jd_id not in file_map:

raise HTTPException(status_code=404, detail=f"JD文件ID {jd_id} 不存在")

if resume_id not in file_map:

raise HTTPException(status_code=404, detail=f"简历文件ID {resume_id} 不存在")

# 解析JD和简历

jd_info = parse_pdf(file_map[jd_id], content_type="jd")

resume_info = parse_pdf(file_map[resume_id], content_type="resume")

# 计算匹配度

match_result = calculate_match(jd_info, resume_info)

return match_result

# 3. 健康检查接口

@app.get("/health", summary="服务健康检查")

async def health_check():

return {"status": "healthy", "message": "简历匹配系统API运行正常"}

步骤 2:AI 生成前端界面(React)

向 Cursor AI 提问:

plaintext

请用React + Ant Design开发简历匹配系统的前端界面,需求:

1. 页面结构:上传区(分别上传JD和简历)→ 匹配区(点击匹配按钮)→ 结果展示区(匹配度+对比报告)

2. 交互逻辑:

- 上传文件后显示文件名和大小

- 点击匹配按钮时显示加载动画

- 匹配完成后展示800px宽的报告卡片

3. 样式要求:现代简约风格,主色调#1890ff,适配移动端

4. API调用:调用FastAPI的/upload和/match接口

请生成完整代码,包含App.jsx、index.css,并说明安装依赖和运行步骤。

步骤 3:AI 辅助集成与部署

当前后端开发完成后,向 AI 提问部署方案:

plaintext

我的简历匹配系统由FastAPI后端和React前端组成,请问如何部署到云服务器(阿里云ECS,Ubuntu系统)?请提供详细步骤,包括环境配置、依赖安装、Nginx配置、域名绑定等。

AI 会生成详细的部署指南,涵盖从服务器初始化到项目上线的完整流程,新手可按步骤完成部署。

第三部分:Agentic AI 与 AI 编程的融合应用

3.1 融合架构:智能体驱动的全流程开发

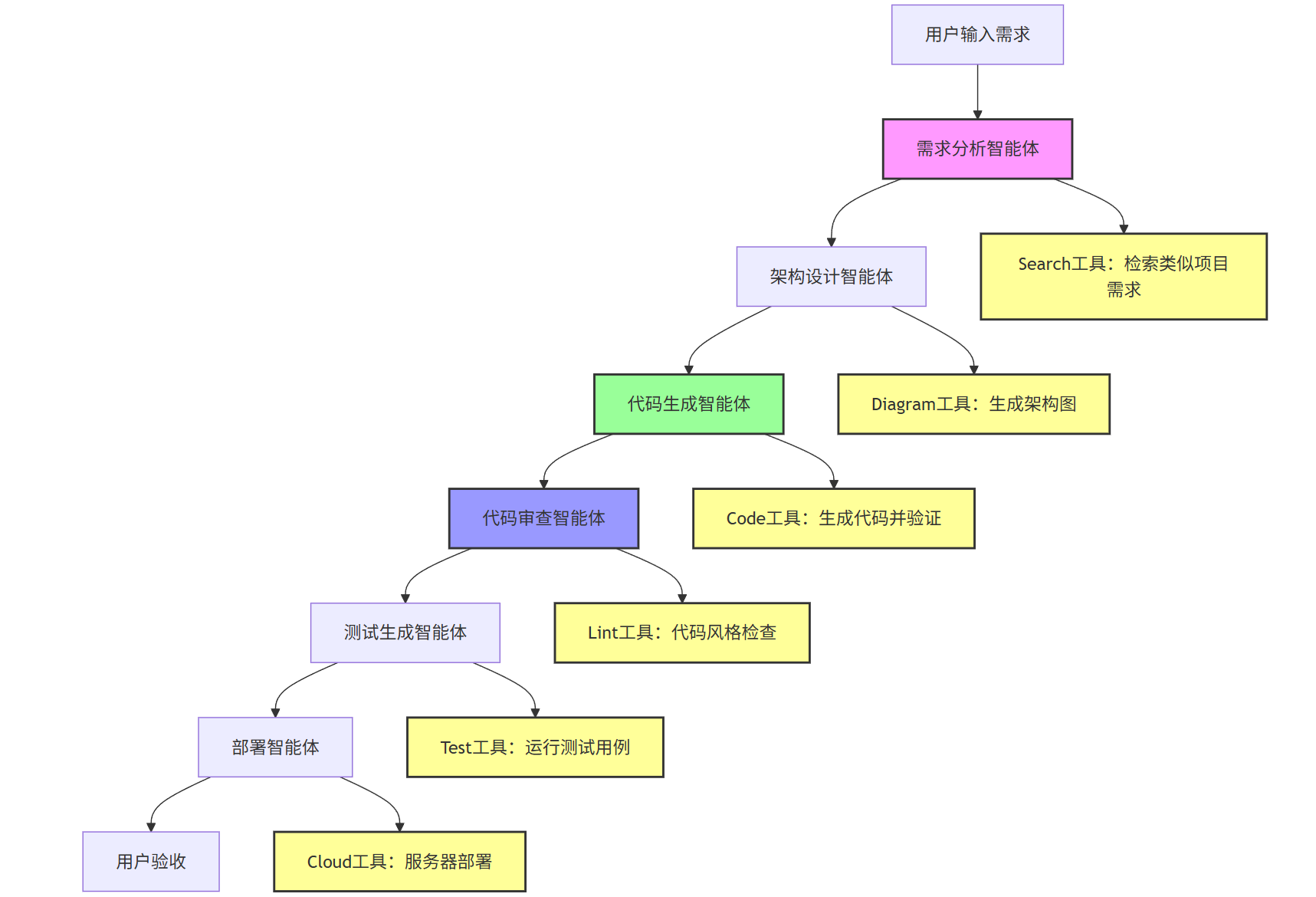

Agentic AI 与 AI 编程工具的融合,实现了 "需求→设计→开发→测试→部署" 的全流程自动化。其架构如下:

graph TD

A[用户输入需求] --> B[需求分析智能体]

B --> C[架构设计智能体]

C --> D[代码生成智能体]

D --> E[代码审查智能体]

E --> F[测试生成智能体]

F --> G[部署智能体]

G --> H[用户验收]

%% 工具调用链路

B --> I[Search工具:检索类似项目需求]

C --> J[Diagram工具:生成架构图]

D --> K[Code工具:生成代码并验证]

E --> L[Lint工具:代码风格检查]

F --> M[Test工具:运行测试用例]

G --> N[Cloud工具:服务器部署]

style B fill:#f9f,stroke:#333,stroke-width:2px

style D fill:#9f9,stroke:#333,stroke-width:2px

style E fill:#99f,stroke:#333,stroke-width:2px

style I fill:#ff9,stroke:#333,stroke-width:2px

style J fill:#ff9,stroke:#333,stroke-width:2px

style K fill:#ff9,stroke:#333,stroke-width:2px

style L fill:#ff9,stroke:#333,stroke-width:2px

style M fill:#ff9,stroke:#333,stroke-width:2px

style N fill:#ff9,stroke:#333,stroke-width:2px

融合应用案例:自动生成个人博客系统

- 需求输入:"帮我开发一个个人博客系统,用 Python+Django 后端,React 前端,支持文章发布、评论、分类功能,需要包含用户登录注册,部署到 Vercel。"

- 需求分析智能体:调用 Search 工具检索 "Django React 博客系统 最佳实践",生成详细需求文档;

- 架构设计智能体:生成系统架构图,定义数据库模型(用户、文章、评论、分类);

- 代码生成智能体:分模块生成后端 API、前端页面、数据库迁移文件;

- 代码审查智能体:调用 flake8 检查代码风格,生成优化建议;

- 测试生成智能体:生成单元测试用例,运行并修复发现的 bug;

- 部署智能体:生成 Vercel 部署配置文件,自动部署并返回访问链接。

整个过程无需用户编写一行代码,仅需在关键节点确认需求即可。

3.2 学习与创作的终极伴侣:定制化多智能体协作系统

对于深度学习者和创作者,可构建由多个专业化智能体组成的协作系统,各司其职又协同工作。以下是 "AI 学习创作助手" 的多智能体配置:

智能体分工与协作流程

- 需求拆解智能体:接收模糊需求(如 "学完机器学习线性回归并做一个项目"),拆解为 "理论学习→代码实践→项目优化" 三个阶段;

- 资源搜集智能体:根据阶段目标,调用学术搜索引擎获取最新教程,筛选 Kaggle 数据集;

- 教学辅导智能体:用通俗语言讲解线性回归原理,生成带注释的代码示例;

- 代码开发智能体:辅助实现项目代码,调试运行错误,优化模型性能;

- 内容创作智能体:将项目过程整理为技术博客,生成 Markdown 文档;

- 质量审核智能体:检查博客内容准确性、代码可运行性,提出改进建议。

多智能体协作 Prompt 模板

plaintext

请作为多智能体协作系统的调度者,协调以下智能体完成用户需求:

智能体列表:

1. 需求拆解智能体:擅长将模糊需求转化为清晰的阶段目标和任务清单

2. 资源搜集智能体:擅长检索和筛选高质量学习资源、数据集、工具

3. 教学辅导智能体:擅长用通俗语言讲解技术知识,生成学习材料

4. 代码开发智能体:擅长生成、调试、优化代码,实现技术项目

5. 内容创作智能体:擅长将技术内容整理为结构化的文档或博客

用户需求:{输入你的学习或创作需求}

请按以下步骤工作:

1. 先让需求拆解智能体输出任务计划

2. 按计划依次调度对应智能体执行任务

3. 每个智能体完成后输出结果,再调度下一个

4. 最终整合所有结果,生成完整的交付物

现在开始执行。

3.3 伦理与安全:与 AI 伴侣共处的边界

在享受 AI 带来便利的同时,需坚守以下伦理与安全原则:

- 知识产权意识:AI 生成的代码和内容可能包含开源组件,需遵守开源协议(如 MIT、Apache),重要作品需手动核实版权归属;

- 隐私保护原则:不向 AI 工具上传敏感信息(如身份证号、商业机密),本地部署开源模型处理私密数据;

- 能力边界认知:AI 生成的代码可能存在安全漏洞,生产环境使用前必须经过人工审核;AI 讲解的知识可能存在过时或错误,需交叉验证;

- 主动学习心态:AI 是辅助工具而非替代者,需理解 AI 生成结果的底层逻辑,避免 "知其然不知其所以然";

- 责任承担机制:明确 AI 决策的最终责任归属,尤其是在医疗、金融等关键领域,不可完全依赖 AI 判断。

结语:AI 驱动的学习与创作新纪元

Agentic AI 与 AI 编程工具的结合,不仅是技术的革新,更是学习与创作范式的重构。从 "被动接收知识" 到 "主动驱动学习",从 "代码实现障碍" 到 "创意快速落地",AI 正在消除能力提升的门槛。

但真正让 AI 成为 "最佳伴侣" 的关键,在于用户自身的主动性 —— 明确目标、善用工具、验证结果、迭代优化。未来,随着多模态智能体、自主进化 AI 等技术的发展,AI 将从 "工具" 升级为 "伙伴",与人类共同探索知识的边界,创造更有价值的内容。

现在,不妨从本文的第一个实战案例开始,亲手搭建你的第一个 AI 智能体,开启属于你的 AI 辅助学习与创作之旅。

更多推荐

已为社区贡献33条内容

已为社区贡献33条内容

所有评论(0)