【必学收藏】强化学习如何让大模型变身超级推理引擎?一文掌握LRM训练核心技巧

本文系统综述了强化学习(RL)在提升大语言模型(LLM)推理能力方面的最新进展。研究从RLHF、DPO到RLVR等方法演进,详细分析了奖励设计、策略优化和采样策略三大核心组件,并探讨了RL在模型能力提升中"磨砺"与"发现"的关键争议。文章强调训练资源的重要性,展示了RL在代码生成、智能体等多领域的应用潜力,并展望了持续强化学习、基于记忆的RL等未来方向。该研

这篇综述系统回顾了强化学习(RL)在大型语言模型(LLM)推理能力构建中的最新进展,探讨了如何通过RL将LLM转变为大型推理模型(LRMs)。研究从RLHF、DPO发展到RLVR等方法,详细分析了奖励设计、策略优化和采样策略三大基础组件,并讨论了RL是"磨砺"还是"发现"模型能力的关键问题。文章还强调了训练资源的重要性,并展望了持续强化学习、基于记忆的RL等未来研究方向,为AI迈向更高层次智能提供了系统性的技术路径。

研究背景与科学问题

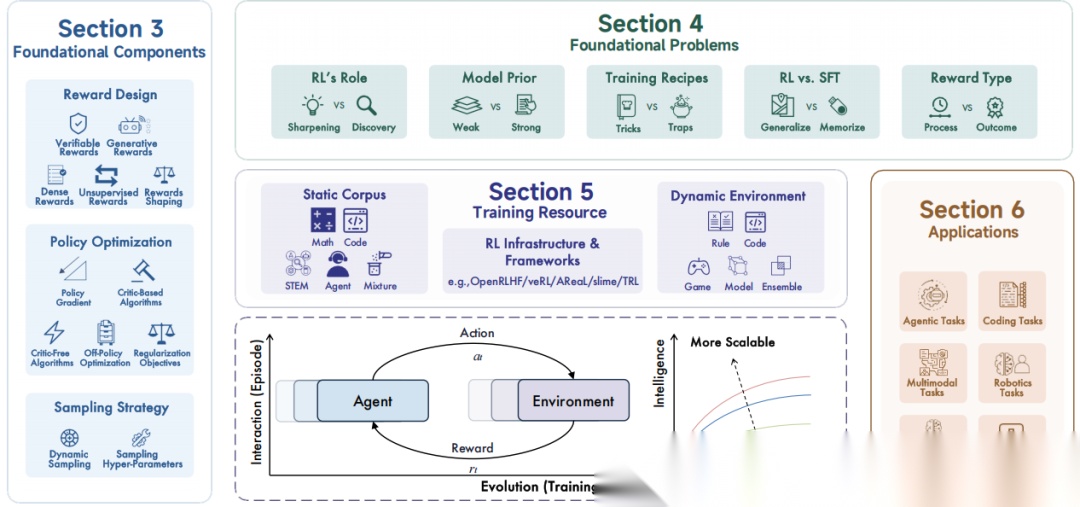

强化学习(RL)最初因其在人类对齐任务中的成功而备受瞩目,其中以人类反馈强化学习(RLHF)和直接偏好优化(DPO)为代表的方法,显著提升了模型的有益性、诚实性和无害性。然而,近年来出现了一个新趋势:应用RL不再仅仅为了“对齐”,而是为了直接激励和训练模型的“推理”本身。

以OpenAI的o1和DeepSeek-R1为里程碑,研究者证明了利用**可验证奖励的强化学习(RLVR)(**例如,数学题的答案正确性或代码的单元测试通过率)能够有效训练模型进行规划、反思和自我修正等长程推理。将推理能力视为一种可被显式训练和扩展的能力,为提升模型性能开辟了独立于预训练参数和数据规模的新维度。

RL在赋能大型推理模型(LRMs)时面临着算法设计、训练数据和基础设施等多方面的挑战。因此,系统性地回顾该领域的发展历程,评估其技术轨迹,并探索未来扩展策略,对于推动AI迈向更高层次的智能至关重要。

研究设计与核心方法

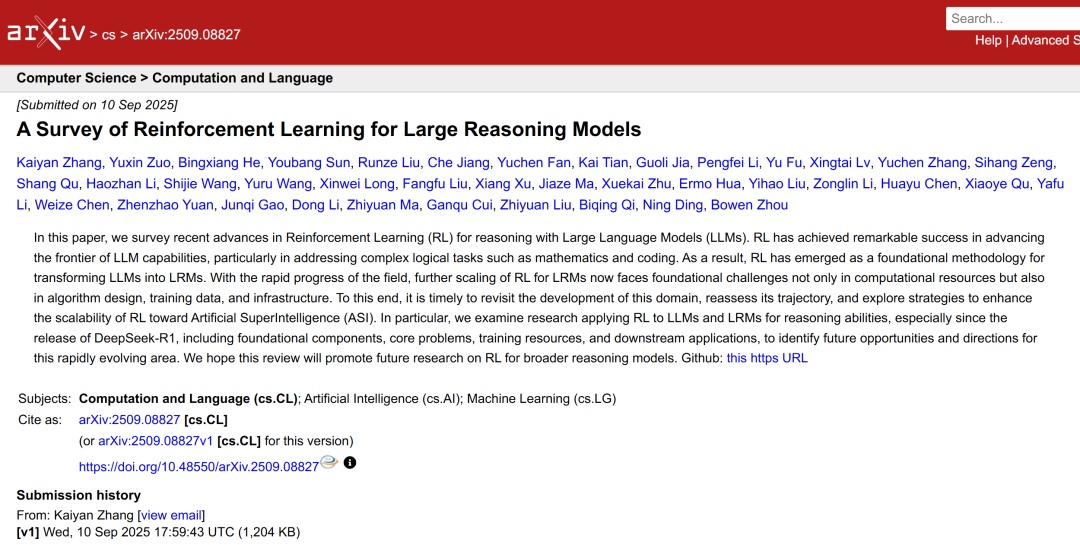

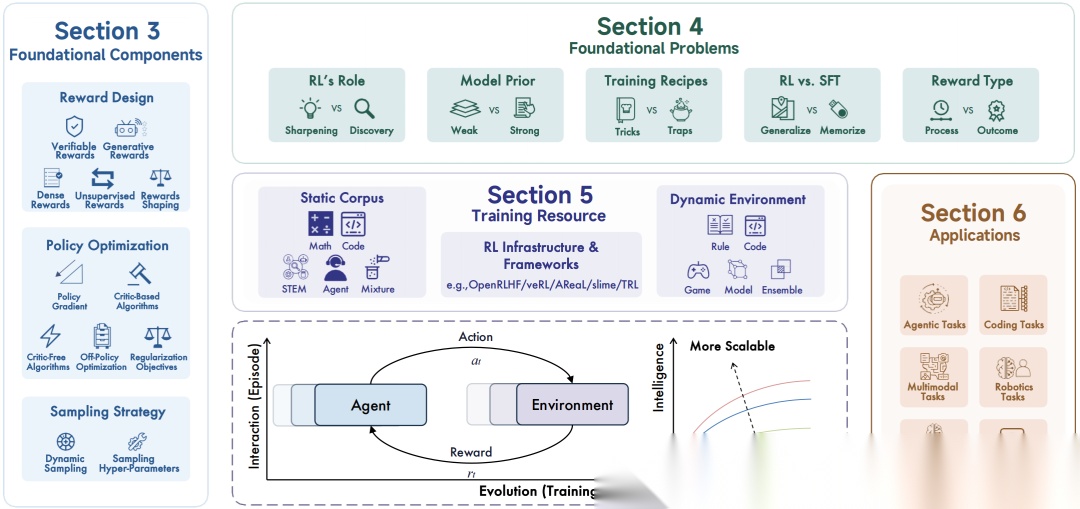

研究对应用RL提升LLM推理能力的研究进行了全面梳理。其核心框架围绕语言智能体与环境的长期演化和交互展开,系统地剖析了RL赋能LRMs的各个层面,包括基础构成、核心问题、训练资源和下游应用。

图1. 综述概览,涵盖RL赋能LRMs的基础组件、核心问题、训练资源及应用

文章追溯了RL方法论的演变,从经典的RLHF和DPO,发展到当前主流的RLVR,并展望了更具挑战性的开放式RL,清晰地展示了RL从行为对齐向能力提升的范式转移。

图2. 近年来RL在LLM中应用的方法论演进

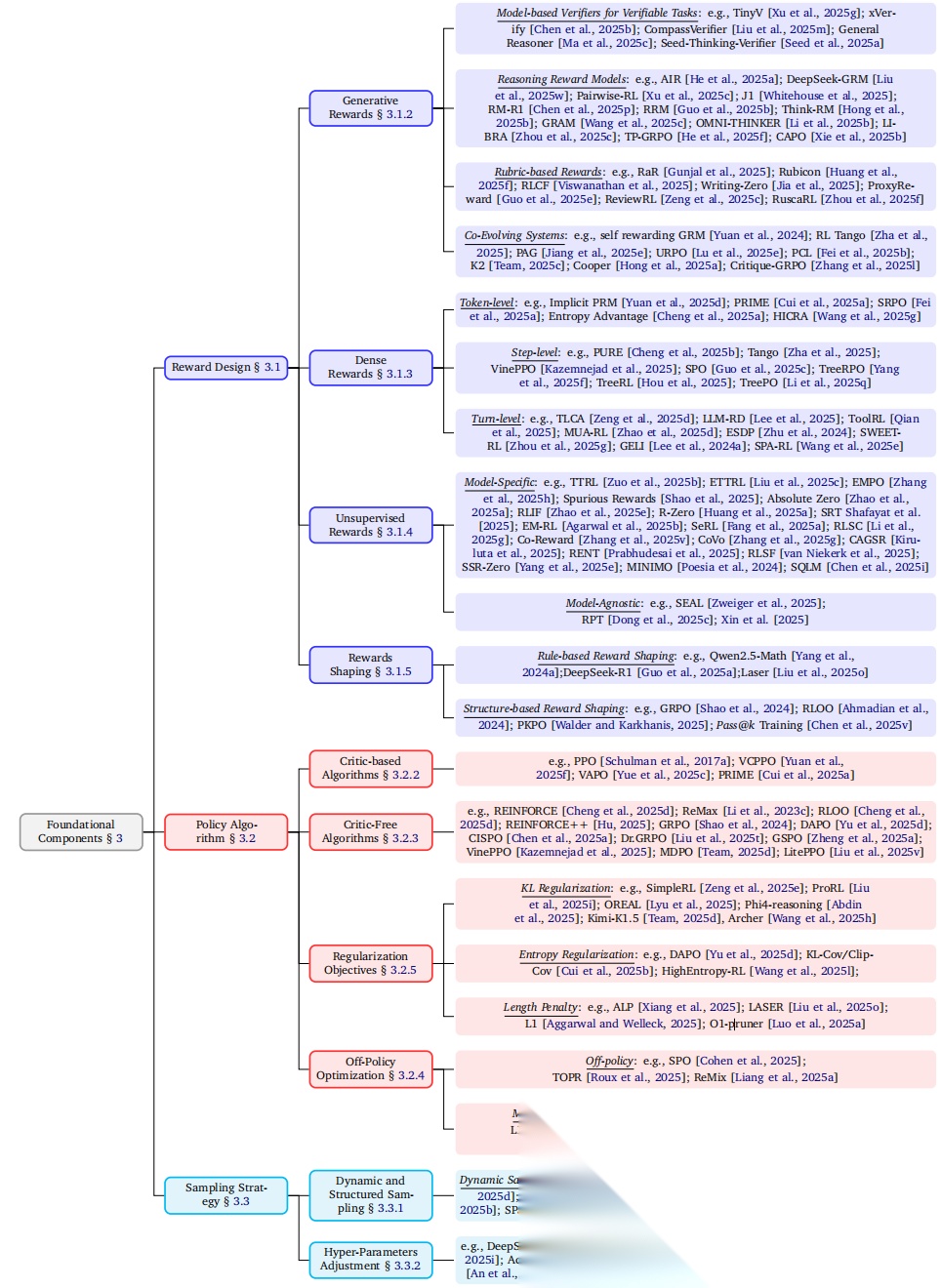

在技术层面,综述详细拆解了RL训练流程的三大基础组件:奖励设计(如可验证奖励、生成式奖励、稠密奖励等)、策略优化(涵盖基于评论家和无评论家的算法)以及采样策略。

图3. RL基础组件的分类及代表性工作

核心结果与讨论

在对现有工作进行系统梳理的基础上,综述提炼出了当前领域内几个亟待解决的基础性问题。最核心的争议在于RL在模型能力提升中扮演的角色:究竟是“磨砺”(Sharpening)还是“发现”(Discovery)?“磨砺”观点认为,RL只是优化和重新加权了模型在预训练阶段已获得的潜在能力;而“发现”观点则主张,RL能够引导模型探索并学习到全新的推理模式。

另一个关键辩题是RL与监督微调(SFT)的对比,即模型是在“泛化”(Generalize)还是在“记忆”(Memorize)。大量证据表明,RL在分布外任务上表现出更强的泛化能力,而SFT则更容易过拟合到训练数据,导致表征漂移。然而,RL并非万能药,其效果严重依赖初始模型(即模型先验)的质量。对于能力较弱的基础模型,往往需要通过中段训练(Mid-training)注入高质量的推理数据来“预热”,才能更好地适应RL训练。

综述还强调了训练资源的重要性,包括高质量的静态数据集和动态交互环境。近年来,开源社区涌现出大量专为RL推理训练设计的模型、数据集和框架,极大地推动了领域发展。

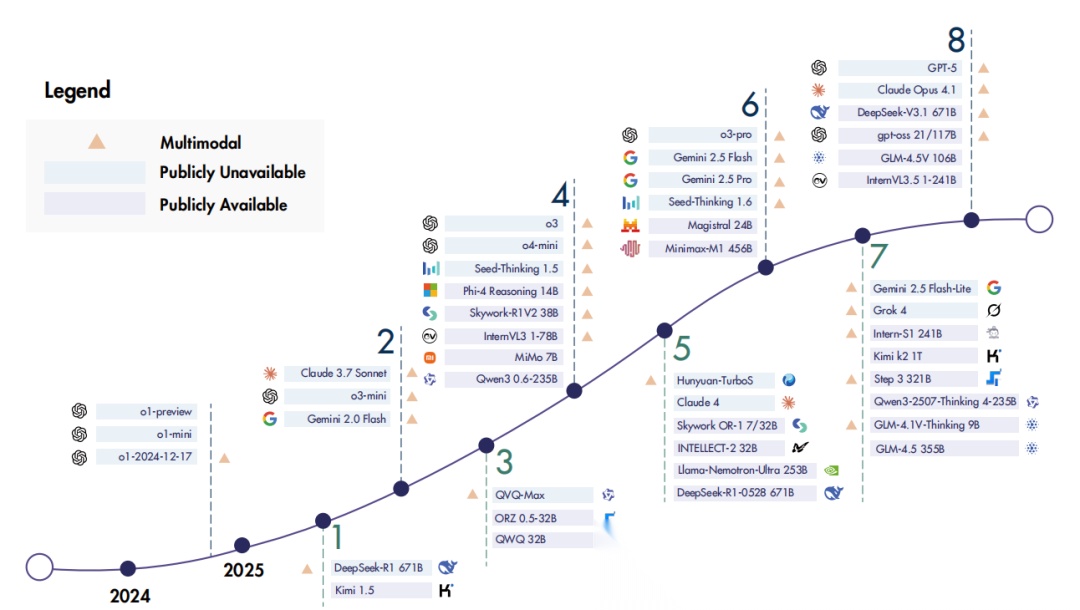

图4. 代表性的开源与闭源推理模型发展时间线

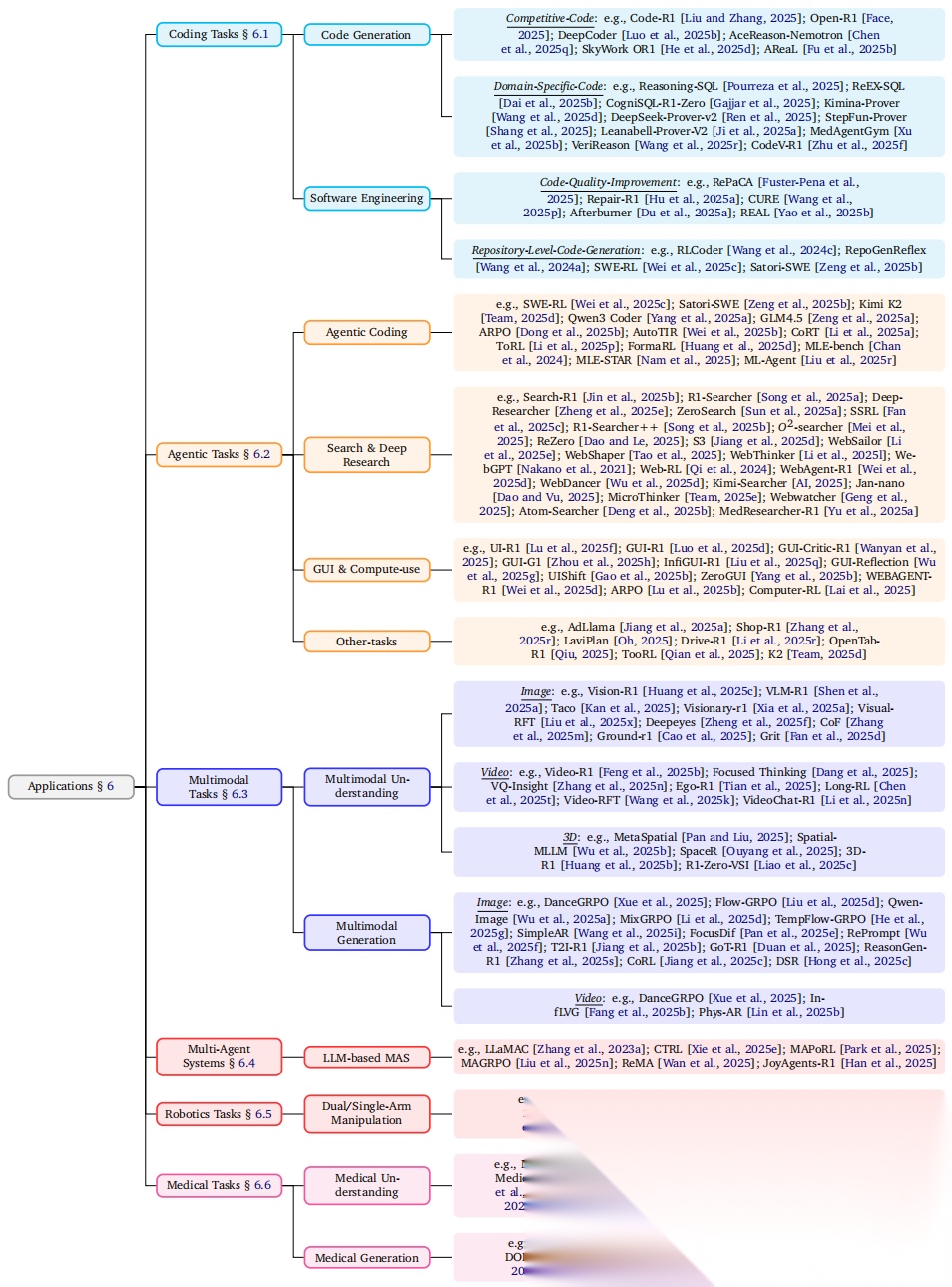

在应用层面,RL已在代码生成、智能体任务、多模态理解与生成、多智能体系统、机器人技术和医疗等多个领域展现出巨大潜力,催生了众多前沿模型和应用。

图8. RL在各项下游任务中的应用分类

研究展望

未来研究应聚焦:面向LLM的持续强化学习(Continual RL),以适应动态变化的任务和数据;基于记忆和世界模型的RL,以增强智能体的长期规划和理解能力;将RL应用于预训练阶段,从根本上提升模型的基础能力;以及面向扩散模型架构的RL等前沿探索。

读者福利大放送:如果你对大模型感兴趣,想更加深入的学习大模型**,那么这份精心整理的大模型学习资料,绝对能帮你少走弯路、快速入门**

如果你是零基础小白,别担心——大模型入门真的没那么难,你完全可以学得会!

👉 不用你懂任何算法和数学知识,公式推导、复杂原理这些都不用操心;

👉 也不挑电脑配置,普通家用电脑完全能 hold 住,不用额外花钱升级设备;

👉 更不用你提前学 Python 之类的编程语言,零基础照样能上手。

你要做的特别简单:跟着我的讲解走,照着教程里的步骤一步步操作就行。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

为什么要学习大模型?

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献70条内容

已为社区贡献70条内容

所有评论(0)