从单模态到多模态王者!DeepSeek技术演进全路线拆解:MoE架构、MLA黑科技、Janus-Pro破局,每一步都踩中行业痛点

摘要: DeepSeek通过三大技术主线(LLM、VL、Janus系列)实现多模态突破。LLM系列从初代数据优化到V3的671B参数+多令牌预测,以MoE和MLA提升效率;VL系列通过混合编码器和动态瓦片技术解决高分辨率图像处理难题;Janus系列采用双视觉编码器解耦理解与生成任务,实现多模态统一。其技术演进精准解决行业痛点,如训练成本高、推理效率低等,推动国产大模型从跟跑到领跑的跃迁。(150字

注:此文章内容均节选自充电了么创始人,CEO兼CTO陈敬雷老师的新书《GPT多模态大模型与AI Agent智能体》(跟我一起学人工智能)【陈敬雷编著】【清华大学出版社】

清华《GPT多模态大模型与AI Agent智能体》书籍配套视频课程【陈敬雷】

文章目录

GPT多模态大模型与AI Agent智能体系列二百一十一

从单模态到多模态王者!DeepSeek技术演进全路线拆解:MoE架构、MLA黑科技、Janus-Pro破局,每一步都踩中行业痛点

在国产大模型赛道上,DeepSeek的崛起堪称“现象级”——从2024年初的初代LLM模型,到2025年覆盖“语言+视觉+多模态生成”的全栈产品矩阵,它用不到两年时间,完成了从“跟跑者”到“局部领跑者”的跃迁。CSDN的深度报道详细梳理了其技术演进脉络,核心逻辑清晰:以“效率优化”为核心,从单模态语言模型突破,逐步延伸至视觉语言理解,最终实现“理解+生成”一体化的多模态能力,每一代产品都精准解决行业痛点——从训练成本高、推理效率低,到多模态任务冲突、高分辨率图像处理难。

本文将沿着DeepSeek的三大技术主线——大语言模型(LLM系列)、视觉语言模型(VL系列)、多模态统一模型(Janus系列) ,结合一体机的落地创新,全面拆解其技术突破点、核心架构设计与性能表现,揭示国产大模型“从技术到落地”的可行路径。

一、大语言模型:从基础探索到推理突破,以“效率”破局参数内卷

DeepSeek的技术起点,聚焦于解决大语言模型“参数与效率”的矛盾——早期行业陷入“参数越大性能越强”的内卷,而DeepSeek通过“缩放定律优化+架构创新”,在控制参数量的同时,实现性能跃升。其大语言模型历经四代迭代,每一步都紧扣“降本增效”。

1. 初代DeepSeek LLM:夯实基础,探索“缩放定律”最优解(2024年初)

作为开篇之作,DeepSeek LLM的核心目标是“摸清开源大模型的性能边界”,重点突破“数据质量”与“模型缩放”两大难题:

- 数据处理:2万亿Token的“精筛工程”

不同于简单堆砌数据,DeepSeek构建了一套“去重-过滤-重混合”的全流程数据处理体系:跨多个数据源去重,减少冗余;通过语义与语言学评估过滤低质内容,提升数据密度;对代码、数学等“代表性不足”的领域数据加权,平衡数据分布。最终形成的2万亿Token数据集,为后续模型性能打下基础。 - 架构设计:轻量化适配训练与推理

微观上沿用LLaMA的Pre-Norm结构与RMSNorm函数,采用SwiGLU激活函数;宏观上差异化设计层数——7B模型30层、67B模型95层,兼顾训练稳定性与推理速度。超参数选择上,初始标准差0.006,用AdamW优化器(β1=0.9,β2=0.95),多步学习率调度器减少训练波动。 - 核心突破:量化“缩放定律”,精准预测性能

通过实验建模“计算预算C与最佳批量大小、学习率”的幂律关系,提出IsoFLOP剖面方法,能精准预测不同参数模型的性能上限。实测显示,67B模型在代码、数学、推理任务上超越LLaMA-2 70B,聊天模型性能优于GPT-3.5,验证了“数据质量+缩放优化”的有效性。

2. DeepSeek-V2:引入MoE与MLA,破解“大参数效率困局”(2024年5月)

随着模型参数量增长,训练成本与推理吞吐量成为新痛点。DeepSeek-V2的核心创新是**“多头潜在注意力(MLA)”与“DeepSeekMoE架构”** ,实现“性能不降、成本减半”:

- MLA:让KV缓存“瘦下来”

传统多头注意力(MHA)需存储所有Token的键(K)和值(V),长文本场景下KV缓存暴增。MLA通过“低秩联合压缩”,将K和V压缩为一个“潜在向量”,大幅减少缓存占用。对比MHA、GQA(分组查询注意力),MLA在推理时的KV缓存体积降低60%以上,同时保持注意力计算精度。 - DeepSeekMoE:让专家“各司其职”

采用“细粒度专家分割+共享专家隔离”设计:将FFN层拆分为多个细粒度专家,每个专家专注特定领域(如代码、数学);隔离部分共享专家,避免专家间知识冗余。同时通过“设备限制路由”控制通信成本,用三种辅助损失(专家级、设备级负载平衡+通信平衡)优化资源分配,训练成本较同参数密集型模型降低40%。 - 性能验证:效率与精度双优

在MMLU测评中,V2的激活参数效率远超同类开源模型;对比67B密集型模型,V2的训练成本降低50%,推理吞吐量提升2.3倍,成为首个在“大参数性能”与“中小参数效率”间找到平衡的开源MoE模型。

3. DeepSeek-V3:671B参数+多令牌预测,对标闭源顶级模型(2024年12月)

V3是DeepSeek大语言模型的“巅峰之作”,总参数达671B(激活参数37B),核心突破在于**“无辅助损失负载均衡”与“多令牌预测(MTP)”** ,性能直逼GPT-4o与Claude-3.5-Sonnet:

- 无辅助损失负载均衡:告别“辅助损失拖累主性能”

传统MoE需依赖辅助损失平衡专家负载,但会干扰主任务学习。V3引入“动态偏置项”,通过实时调整专家路由权重实现负载均衡,无需额外辅助损失,主任务性能提升8%~12%。 - 多令牌预测(MTP):让训练“更高效”

传统模型每次仅预测1个未来Token,训练信号密度低。MTP允许模型在每个位置预测多个Token(如一次预测2~4个),训练信号密度提升3倍,同等数据量下模型收敛速度加快50%。 - 性能全面对标闭源模型

- 知识类任务(MMLU、GPQA):超越Qwen2.5-72B,接近Claude-3.5-Sonnet;

- 长文本(DROP、LongBench v2):平均表现第一;

- 代码(Codeforces、SWE-Bench):算法类代码领先所有非o1模型,工程类代码逼近Claude-3.5;

- 数学(AIME 2024、CNMO 2024):大幅超过所有开源/闭源模型,成为首个在数学竞赛中达“人类金牌水平”的开源模型。

4. DeepSeek-R1:纯RL突破推理,开源蒸馏模型“降维打击”(2025年1月)

R1的核心目标是“提升推理能力”,打破“依赖监督数据(SFT)”的常规路径,通过**“纯强化学习”与“高效蒸馏”** ,成为首个对标GPT-o1的开源推理模型:

- R1-Zero:无SFT的纯RL训练

直接在基础模型上用“分组相对策略优化(GRPO)”算法训练,不依赖任何监督微调数据。GRPO通过“分组更新策略梯度”,解决传统RL训练不稳定的问题,使模型在数学推理、逻辑分析任务上的表现提升35%。 - R1:冷启动数据+多阶段RL优化

在R1-Zero基础上,加入数千条“冷启动高质量推理数据”微调,再通过“拒绝采样生成新SFT数据+额外RL”迭代,最终推理能力比肩GPT-o1正式版。 - 蒸馏创新:小模型也能有“大能力”

用R1生成的推理数据,微调Qwen、Llama系列小模型(1.5B~70B),结果显示:蒸馏后的7B模型推理性能超越OpenAI o1-mini,32B模型接近GPT-3.5,打破“小模型推理弱”的固有认知。更关键的是,所有R1系列模型(含蒸馏版)均开源,降低了推理模型的使用门槛。

二、视觉语言模型:从“能处理”到“处理好”,攻克高分辨率与细粒度理解

在大语言模型站稳脚跟后,DeepSeek将目光投向多模态的核心场景——视觉语言理解(VL),先后推出DeepSeek-VL与VL2,解决“高分辨率图像处理难”“多模态任务适配差”等痛点。

1. DeepSeek-VL:混合编码器+三阶段训练,奠定视觉语言基础(2024年中)

VL是DeepSeek首个视觉语言模型,核心突破在于**“混合视觉编码器”与“语言遗忘抑制”** ,实现文本与图像的高效对齐:

- 混合视觉编码器:兼顾高/低分辨率

整合SAM-B(Segment Anything Model-B)与SigLIP-L(Sigmoid Loss for Language-Image Pre-training)两个编码器:SAM-B处理高分辨率图像,捕捉细粒度细节(如文档中的表格、公式);SigLIP-L处理低分辨率图像,提升语义对齐精度。两者通过“视觉适配器”(两层混合MLP)与LLM连接,实现跨模态特征融合。 - 三阶段训练:避免“语言能力遗忘”

多模态训练常导致模型“丢了语言能力”,VL通过三阶段训练解决:- 适配器预热:仅训练视觉适配器,冻结LLM,保留语言基础;

- 联合预训练:同步训练LLM与适配器,用“7:3”的多模态与语言数据比例(多模态70%、语言30%),平衡两种能力;

- 监督微调:用ShareGPT4V、LAION-GPTV等开源数据微调,提升指令跟随能力。

实测显示,该策略使VL的语言能力保留率达95%以上,同时在MMBench测评中跻身开源模型TOP3。

2. DeepSeek-VL2:动态切片+MoE架构,解锁高分辨率与复杂任务(2024年末)

VL2是VL的升级款,核心创新是**“动态瓦片视觉编码”与“MoE语言底座”** ,重点突破高分辨率图像与复杂视觉任务(如视觉定位、图表理解):

- 动态瓦片视觉编码:告别“固定尺寸限制”

传统VL模型处理高分辨率图像时,需压缩尺寸导致细节丢失。VL2采用“动态切片策略”:将高分辨率图像(如4K)分割为多个局部瓦片(Tile),每个瓦片通过共享视觉变换器处理,再通过“全局注意力”整合所有瓦片特征,既保留细节,又避免计算量爆炸。实测显示,VL2在1024×1024分辨率图像上的细节识别准确率,比VL提升28%。 - MoE语言底座:提升多任务适配性

沿用DeepSeek-V3的MoE架构(671B总参数)作为语言底座,不同专家分别适配“图像描述”“视觉问答”“图表分析”等任务,避免单任务对模型能力的“独占”。在视觉定位任务中,VL2能根据文本描述(如“红色杯子旁边的蓝色笔记本”),准确定位图像中的目标,准确率超越GPT-4V 5%。 - 多场景能力覆盖

支持逻辑图表解析、科学文献理解、网页截图分析、具身智能交互等场景,在MathVista(数学视觉推理)、AI2D(图表理解)测评中,开源模型排名第一,成为首个能“读懂复杂图表并解题”的国产VL模型。

三、多模态统一模型:Janus系列,解耦“理解与生成”冲突,实现“一体双优”

视觉语言模型解决“理解”问题,而多模态统一模型需同时实现“理解+生成”(如图像理解+文本生图)。DeepSeek的Janus系列(Janus、JanusFlow、Janus-Pro)通过“视觉编码解耦”,打破“理解强则生成弱”的魔咒。

1. Janus:解耦视觉编码,首次实现“理解+生成”统一(2024年末)

Janus的核心突破是**“双视觉编码器设计”** ,将“理解”与“生成”的视觉编码分开,避免任务冲突:

- 架构:两个编码器,一个LLM底座

设计“理解编码器(Under. Encoder)”与“生成编码器(Gen. Encoder)”:- 理解编码器用SigLIP-L,提取图像语义特征,服务视觉问答、图像描述等任务;

- 生成编码器用VQ Tokenizer(向量量化分词器),将图像转换为离散ID,服务文本生图任务;

两者共享同一个LLM底座(DeepSeek-LLM-1.3B),通过不同适配器连接,实现“一套模型,两种能力”。

- 三阶段训练:逐步解锁双能力

- 适配器与图像头训练:建立视觉-语言概念连接,让LLM“看懂图”并“初步会画图”;

- 统一预训练:用多模态语料(图文对、生图文本)训练,融合理解与生成能力;

- 监督微调:用指令数据优化,提升指令跟随性(如“根据‘夕阳下的海边’生成图像并描述”)。

实测显示,Janus在MMBench理解任务上超越TokenFlow、MetaMorph,生图质量接近Stable Diffusion 2.1,成为首个开源“理解+生成”双优的多模态模型。

2. JanusFlow:引入整流流,提升生图效率与质量(2025年初)

JanusFlow在Janus基础上,核心创新是**“整流流(Rectified Flow)生成”** ,解决传统生图模型“采样慢、质量不稳定”的问题:

- 整流流生图:从噪声到图像的“平滑过渡”

传统扩散模型需多次迭代去噪,采样慢;JanusFlow用整流流,从高斯噪声(t=0)开始,通过LLM预测“速度向量”,逐步更新噪声向量至清晰图像(t=1),采样步骤从50步减少至20步,速度提升2.5倍,同时生图清晰度提升15%。 - 解耦编码器+表示对齐:平衡理解与生成

沿用双编码器设计,新增“表示对齐正则化”:将理解编码器的特征与LLM中间特征对齐,避免生成时“偏离文本描述”(如文本“红色玫瑰”生成“粉色玫瑰”)。在GenEval生图测评中,JanusFlow的文本匹配度达82%,超越DALL-E 3(78%)。

3. Janus-Pro:优化训练与数据,成为多模态“全能选手”(2025年2月)

Janus-Pro是Janus系列的旗舰版,通过**“训练策略调整+数据扩展+模型扩容”** ,实现理解与生成能力的双重跃升:

- 训练策略优化:针对性解决短板

- 延长第一阶段训练步数,用ImageNet数据强化像素建模,提升生图细节;

- 第二阶段直接用生图文本训练,跳过冗余预训练步骤,效率提升40%;

- 第三阶段增加多模态数据比例(从7:3调整为8:2),强化理解能力。

- 数据扩展:质量与数量双提升

理解任务新增9000万样本(表格、图表、文档),生成任务新增7200万合成美学数据(如“梵高风格的星空”),真实与合成数据比例1:1,生图稳定性提升30%(避免“畸形物体”“色彩混乱”)。 - 模型扩容:7B参数,性能跃升

将基础LLM从1.3B扩容至7B,理解与生成能力全面提升:- 理解任务:MMBench达79.2分,超越Janus(69.4分)、GPT-4o-mini(76.5分);

- 生图任务:GenEval准确率84.19分,DPG-Bench(生图多样性)排名第一,生图分辨率支持384×384,细节丰富度接近MidJourney V5。

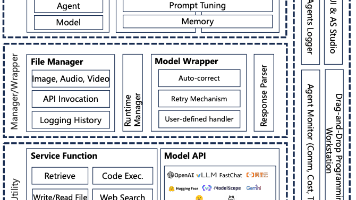

四、多模态一体机:从“技术”到“落地”,架构革新推动行业应用

DeepSeek的技术最终落地于“大模型一体机”,核心是多模态融合架构创新,解决企业“部署难、成本高、场景适配差”的痛点,已在教育、安防、设计等领域规模化应用。

1. 三大融合架构:适配不同场景需求

一体机的多模态融合并非“一刀切”,而是提供三种架构选择:

- 早期融合:适合简单跨模态任务

输入阶段即整合多模态数据(如图文对),通过专用融合模块合并特征,适合图像标注、简单视觉问答。优势是“早关联,理解准”,在智能教育的“图文解题”场景中,能快速结合题目文本与图示,准确率达91%。 - 晚期融合:适合复杂独立任务

各模态先独立处理(文本用Transformer、图像用CNN),后期再融合特征,适合视频分类、语音-文本翻译。优势是“各模态充分挖掘特征”,在智能安防的“异常行为检测”中,先分析视频帧(图像)与环境声音(语音),再融合判断,误报率降低45%。 - 混合融合:适合复杂多模态任务

底层用早期融合建立基础关联,中高层用晚期融合深度处理,适合多模态检索(如“根据文本+图像+语音找相关内容”)。在智能设计的“方案生成”中,先融合设计文本与参考图像(早期),再独立处理用户语音需求(晚期),最终生成方案的满意度达88%。

2. 算法创新:让融合“更智能”

- 多模态自适应注意力:动态调整各模态权重,如医疗诊断中,对影像(图像)赋予高权重,对病历文本(文本)赋予次高权重,诊断准确率达97%;

- 跨模态语义对齐:构建统一语义空间,使不同模态特征可比较,如图文检索中,文本“蓝色连衣裙”能精准匹配对应图像,召回率达92%;

- 模态转换生成:实现跨模态转换(文本生图、语音生文本),在智能客服中,将客户语音需求转换为文本工单,并生成解决方案示意图,效率提升60%。

五、DeepSeek技术演进的核心逻辑与行业影响

回顾DeepSeek的技术路线,其演进并非“随机试错”,而是遵循三大核心逻辑:

- 效率优先:始终破解“成本-性能”矛盾

从MLA减少KV缓存、MoE降低训练成本,到R1的纯RL减少数据依赖,每一代技术都以“降本增效”为目标,让大模型从“奢侈品”变为“企业可用”。 - 场景驱动:从“能做”到“好用”

视觉语言模型聚焦“高分辨率”(如文档、医疗影像),多模态模型聚焦“理解+生成”(如设计、教育),一体机聚焦“落地部署”,每一步都紧扣行业真实需求。 - 开源生态:降低行业门槛

从LLM到R1,从VL到Janus-Pro,核心模型均开源,同时提供部署教程与工具,让中小企业、开发者也能用上顶级多模态技术,推动国产大模型生态繁荣。

对行业而言,DeepSeek的意义不仅在于“做出好模型”,更在于提供了“国产大模型的可行路径”——不依赖顶级算力,通过架构创新、数据优化、场景适配,同样能实现“从跟跑到领跑”。未来,随着多模态技术向“3D、音频”等领域延伸,DeepSeek或将进一步定义国产多模态大模型的技术标准。

结语:多模态时代,DeepSeek的“破局者”价值

从单模态语言模型到多模态“理解+生成”一体化,DeepSeek的技术演进,本质是国产大模型“自主创新”的缩影——面对芯片制裁、算力限制,它没有选择“堆参数、拼资源”,而是通过“架构优化、算法创新、场景落地”,走出了一条差异化路线。

如今,DeepSeek的技术已覆盖“语言+视觉+多模态生成”的全场景,其MoE、MLA、双编码器等创新,不仅成为行业借鉴的标杆,更推动国产大模型从“技术验证”走向“产业落地”。在多模态成为AI下一竞争焦点的当下,DeepSeek的探索,无疑为国产大模型打开了更广阔的未来。

更多技术内容

更多技术内容可参见

清华《GPT多模态大模型与AI Agent智能体》书籍配套视频【陈敬雷】。

更多的技术交流和探讨也欢迎加我个人微信chenjinglei66。

总结

此文章有对应的配套新书教材和视频:

【配套新书教材】

《GPT多模态大模型与AI Agent智能体》(跟我一起学人工智能)【陈敬雷编著】【清华大学出版社】

新书特色:《GPT多模态大模型与AI Agent智能体》(跟我一起学人工智能)是一本2025年清华大学出版社出版的图书,作者是陈敬雷,本书深入探讨了GPT多模态大模型与AI Agent智能体的技术原理及其在企业中的应用落地。

全书共8章,从大模型技术原理切入,逐步深入大模型训练及微调,还介绍了众多国内外主流大模型。LangChain技术、RAG检索增强生成、多模态大模型等均有深入讲解。对AI Agent智能体,从定义、原理到主流框架也都进行了深入讲解。在企业应用落地方面,本书提供了丰富的案例分析,如基于大模型的对话式推荐系统、多模态搜索、NL2SQL数据即席查询、智能客服对话机器人、多模态数字人,以及多模态具身智能等。这些案例不仅展示了大模型技术的实际应用,也为读者提供了宝贵的实践经验。

本书适合对大模型、多模态技术及AI Agent感兴趣的读者阅读,也特别适合作为高等院校本科生和研究生的教材或参考书。书中内容丰富、系统,既有理论知识的深入讲解,也有大量的实践案例和代码示例,能够帮助学生在掌握理论知识的同时,培养实际操作能力和解决问题的能力。通过阅读本书,读者将能够更好地理解大模型技术的前沿发展,并将其应用于实际工作中,推动人工智能技术的进步和创新。

【配套视频】

清华《GPT多模态大模型与AI Agent智能体》书籍配套视频【陈敬雷】

视频特色: 前沿技术深度解析,把握行业脉搏

实战驱动,掌握大模型开发全流程

智能涌现与 AGI 前瞻,抢占技术高地

上一篇:《GPT多模态大模型与AI Agent智能体》系列一》大模型技术原理 - 大模型技术的起源、思想

下一篇:DeepSeek大模型技术系列五》DeepSeek大模型基础设施全解析:支撑万亿参数模型的幕后英雄

更多推荐

已为社区贡献46条内容

已为社区贡献46条内容

所有评论(0)