硬刚制裁、反超范式!DeepSeek的中国式创新:不堆算力不圈钱,凭什么让硅谷紧张?

摘要: DeepSeek以“中国式创新”打破AI大模型的算力内卷,通过强化学习裸训、顿悟现象可视化、模型蒸馏优化及PTX编程语言等“巧劲”,在芯片制裁下实现技术突破。其“大道求简、平衡求熵”的思维,摒弃堆参数与商业变现,专注算法优化与开源生态生态共建,为中小团队提供了“低资源高效益”的创新样本。这一路径不仅挑战硅谷的算力霸权,更重塑了中国AI创新的全球话语权,展现技术韧性下的本土智慧。(149字)

注:此文章内容均节选自充电了么创始人,CEO兼CTO陈敬雷老师的新书《GPT多模态大模型与AI Agent智能体》(跟我一起学人工智能)【陈敬雷编著】【清华大学出版社】

清华《GPT多模态大模型与AI Agent智能体》书籍配套视频课程【陈敬雷】

文章目录

GPT多模态大模型与AI Agent智能体系列二百一十

硬刚制裁、反超范式!DeepSeek的中国式创新:不堆算力不圈钱,凭什么让硅谷紧张?

当2025年春节前后的AI圈被“百模大战”搅得沸沸扬扬时,DeepSeek的异军突起显得格外扎眼——成立不到1年半,没有疯狂融资,不做商业变现,却在芯片制裁的“紧箍咒”下,接连推出V3通用模型、R1推理模型、Janus-Pro-7B多模态模型,甚至让Anthropic CEO Dario Amodei写下充满酸味的“打压报告”。

它没有像RNN、BP算法、Transformer那样开创“核弹级”技术路线,却用一套充满“中国式智慧”的创新逻辑,打破了大模型“堆算力、垒数据”的内卷困局。钛媒体的深度报道揭开了核心:DeepSeek的厉害,不在于颠覆规则,而在于用“大道求简、平衡求熵”的思维,把现有技术的潜力挖到极致,走出了一条“非典型创新路”。

一、AI发展史的“颠覆者”与“优化者”:DeepSeek的创新坐标

要理解DeepSeek的创新,首先要回到AI发展的时间线——那些真正改变行业走向的“核弹级突破”,定义了“颠覆式创新”的标准,也让DeepSeek的“优化式创新”更具辨识度。

从1956年达特茅斯会议正式提出“人工智能”概念开始,行业经历了多轮“寒冬”与“热潮”,每一次破局都依赖“路线级”的突破:

- 1982年RNN(循环神经网络):打破传统机器学习“输入输出直线传递”的局限,让后一个数据能继承前一个数据的关联(比如预测“What time is…”的结尾是“it”),第一次让机器有了“记忆”雏形;

- 1986年BP算法(反向传播):像“传信息时逐人核对”,每个环节都反向验证误差、调整权重,解决了多层神经网络的训练难题,让机器学习从“理论”走向“实用”;

- 2006年深度学习概念:辛顿提出“多隐层神经网络”,把图像领域的GPU拉进AI计算,直接推动英伟达崛起,开启“算力比拼”时代;

- 2017年Transformer:用“自注意力机制”捕捉长文本依赖,支持并行计算,彻底替代RNN成为大模型基座,ChatGPT、Claude等都源于此。

这些突破的共性是“开创路线”——它们解决了“能不能做”的问题,是行业的“从0到1”。而DeepSeek的定位,是“从1到N”的优化者:它不否定现有技术框架,却在“如何用得更好、更省、更灵活”上做文章,尤其在“芯片制裁+算力昂贵”的中国市场,这种创新更具现实意义。

二、DeepSeek的四大技术“巧劲”:不按常理出牌,却击中行业痛点

DeepSeek从V3到R1的迭代,没有堆砌参数规模,却每一步都踩在行业“低效痛点”上。它的技术创新不是“炫技”,而是“解决真问题”,四个特点尤为突出:

1. 强化学习(RL):跳过“常规范式”,直接“裸奔”训练

行业默认的大模型训练流程是“预训练→监督微调→强化学习”,像“先打基础→再教规则→最后奖励优化”。而DeepSeek反其道而行之:

- 先做R1-zero模型:不做预训练、不搞监督微调,直接用强化学习“裸训”——相当于不给学生教课本,直接让他在“做题-改错-得奖励”中学习;

- 再迭代R1模型:在R1-zero基础上,只用少量高质量标注数据再跑一次RL,相当于“针对性补短板”。

结果出乎意料:纯RL训练的模型不仅能用,推理能力还不逊于按常规流程训练的产品。这证明了两个关键:一是强化学习的“优先级”被低估,二是行业对“预训练必须海量数据”的认知可能存在误区。对资源有限的中国团队来说,这等于提供了“不堆数据也能做模型”的新路径。

2. 顿悟现象(Grokking):把机器“开窍”搬进用户视野

“顿悟”不是DeepSeek首创——Google、OpenAI 2023年就发现,模型训练时会突然“打通任督二脉”,前几遍学不会的内容,某一遍突然掌握。但DeepSeek做了一件“开创性”的事:

- 把“顿悟”写进公开技术文档,不再是实验室里的“秘密”;

- 让用户“看得见”顿悟过程:用R1的“深度思考模式”时,模型会突然停下,用自然语言标注“等等,这是一个顿悟时刻,让我们重新评估”,再输出修正后的答案。

这看似是“交互细节”,实则改变了人与模型的关系——它让机器从“黑箱”变成“有思考过程的伙伴”,也让“高阶思维”不再是人类专属。有用户反馈,第一次看到模型“自我修正”时,“感觉机器真的在‘想’问题”。

3. 模型蒸馏:用“友商小模型”练出“超预期效果”

“蒸馏”是行业常规操作:把大模型的知识“教”给小模型,让小模型在特定场景下能用(比如把“百科全书级”大模型蒸馏成“数学专用”小模型)。但DeepSeek玩出了新花样:

- 用自家R1模型生成的数据,去微调友商的小模型;

- 结果:蒸馏后的小模型,推理能力不仅超过原模型,甚至比“直接在小模型上做强化学习”效果更好——打破了“凤凰生不出金蛋”的固有认知。

这背后的逻辑是“数据质量>训练方式”:R1生成的“高质量推理数据”,比单纯给小模型加RL更能提升能力。对行业来说,这提供了“低成本提升小模型性能”的方案——不用再为每个小模型投入巨额训练资源,只需用优质数据“喂”它就行。

4. 编程语言选择:用PTX绕开CUDA,给芯片制裁留“后手”

当国内团队普遍用英伟达CUDA语言开发时,DeepSeek却选择了更底层的PTX语言——这相当于别人用“中文翻译”和芯片沟通,它直接用“芯片母语”对话:

- 技术层面:把GPU中20个原本用于计算的流式处理器,改成负责服务器间通信,绕过了硬件对通信速度的限制,尤其适合性能受限的H800、H80芯片;

- 战略层面:万一未来美国限制CUDA授权,PTX作为英伟达底层汇编语言,能直接与芯片交互,相当于“留了条后路”;

- 生态层面:掌握PTX优化能力,未来适配昇腾、寒武纪等国产GPU时,能更快打通“软件-硬件”链路。

更耐人寻味的是:R1本身就是推理模型,具备编程能力——有业内猜测,DeepSeek可能在尝试“用R1生成PTX代码,再优化R1”,形成“模型优化模型”的循环。

三、中国式创新的本质:不是颠覆,而是“韧性与智慧的融合”

DeepSeek的创新之所以被称为“中国式”,核心在于它的逻辑贴合中国文化中的“底层思维”——不追求极致对抗,而讲究“顺势而为、平衡破局”,具体体现在四个维度:

1. 大道求简:砍掉冗余,聚焦核心

道家“大道至简”的思想,在DeepSeek身上体现得淋漓尽致:

- 技术上“去内卷”:当行业陷入“参数越大越牛”的误区时,它不堆算力,反而改架构(如MLA多头潜在注意力)、做优化,用更精简的范式实现相近性能;

- 商业上“去欲望”:成立以来不融资、不设商业运营团队、不做产品变现,甚至不参与“百模大战”的流量竞争,只专注基础模型和前沿创新;

- 团队上“去层级”:没有繁琐的审批流程,成员能灵活调用训练集群资源;发现MLA技术潜力后,立刻围绕提出者成立专项小组,“上人上卡上资源”,不浪费创新火花。

这种“求简”不是“偷懒”,而是“抓本质”——DeepSeek CEO梁文锋的观点很直接:“一个东西能不能让社会效率变高,才是关键。中间的噪音太多,过度关注只会眼花缭乱。”

2. 平衡求熵:在限制中找最优解

中国文化中的“平衡思维”,是DeepSeek应对外部限制的核心策略——不是“硬刚”,而是“在算力、数据、成本间找平衡”:

- 芯片制裁下的平衡:没有H100,就用H800+PTX优化,把硬件性能榨到极致;

- 资源投入的平衡:没有大厂的海量数据,就用“少量高质量数据+RL”替代,降低数据依赖;

- 时间与效果的平衡:成立不到1年半,不追求“一步到位”,而是用“V3→R1-zero→R1”的迭代,逐步验证技术路线,避免资源浪费。

这像极了中国的发展逻辑:从“两弹一星”的白手起家,到“抗美援朝”的战术穿插,都是“在限制中找机会”,不追求“极致条件”,但求“最优结果”。

3. 胸怀求广:开源共享,建中国AI生态

DeepSeek的“开放”,远超行业平均水平:

- 技术透明:发布每个版本时,同步公开论文、技术文档,甚至主动谈“不足”——比如V3的推理速度短板、R1在多模态场景的局限,邀请用户反馈优化;

- 开源共建:把模型权重、训练代码开源,允许开发者基于其技术二次开发;用R1数据蒸馏友商小模型的方法,也写进技术文档,不藏私;

- 生态联动:与国产GPU厂商提前联调,V3.2-Exp发布当天就实现昇腾、寒武纪“0天适配”,推动“软件-硬件”协同。

梁文锋的一句话道破核心:“当前最重要的不是商业化,而是参与全球创新的浪潮。闭源的护城河是短暂的,只有生态才能长久。”这种“不圈地、不筑墙”的思维,正是中国“和合共生”文化的体现——要建“中国AI社区”,而不是“DeepSeek的自留地”。

4. 机制求变:用“灵活组织”激发创新

传统大厂的层级繁琐、审批复杂,是创新的“天敌”,而DeepSeek的组织机制,恰好解决了这个问题:

- 自下而上探索:不前置分工,让团队成员自由尝试——MLA技术、PTX优化,都来自“员工突发奇想”,而非“管理层规划”;

- 自上而下支持:一旦发现有潜力的方向,立刻调配资源——比如发现“顿悟”现象有价值,马上组织团队把它落地到产品交互中;

- 人才不拘一格:核心团队以211 TOP高校应届生、博四博五实习生为主,没有“大厂资深专家”的思维定式,反而敢打破常规。

这种机制像“活水”——没有固化的流程,却能让创新自然生长。正如梁文锋所说:“在不确定的前沿探索上,繁琐的管理只会杀死灵感。”

四、硅谷的紧张与中国的底气:DeepSeek的“破局意义”

DeepSeek的崛起,之所以让Anthropic CEO Dario Amodei公开“泼脏水”,甚至呼吁“加强出口管制”,本质是它戳破了“硅谷创新垄断”的神话——中国团队不用“顶级芯片+海量资金”,也能做出世界级的大模型。

这种“破局”的意义,远超一个模型的成功:

- 打破“堆资源”的内卷:证明大模型不是“有钱人的游戏”,算法优化、数据质量、机制灵活,同样能实现突破,为中小团队提供了“生存样本”;

- 构建“中国AI生态”的起点:它的开源、透明,正在吸引更多开发者加入“国产大模型共建”,避免行业陷入“各自为战、重复造轮子”的困境;

- 应对制裁的“韧性模板”:用PTX绕开CUDA、用RL减少数据依赖、与国产GPU协同,这些做法为其他团队提供了“如何在限制中创新”的参考;

- 重塑“创新话语权”:过去硅谷认为“创新策源地只能在硅谷”,而DeepSeek用实际成果证明,中国也能走出“自己的创新路”——不是复制,而是融合本土智慧的新路径。

当然,DeepSeek不是“完美偶像”——它的多模态能力仍落后于GPT-4o,在极端场景下的稳定性还有待验证。但它的价值,不在于“做到最好”,而在于“走出不同”——证明AI创新不止有“颠覆式”一条路,“优化式”“融合式”的创新,同样能改变行业。

结语:中国式创新,是“韧性”也是“未来”

当AI行业沉迷于“谁的参数更大、谁的融资更多”时,DeepSeek像一股“清流”——它不追逐热点,却抓住了行业的“真痛点”;它不对抗规则,却在规则的缝隙中找到了“新空间”;它不标榜“颠覆”,却用“中国式智慧”走出了一条可持续的创新路。

钛媒体的报道中,有一句话很贴切:“DeepSeek不是AI的未来,但它为中国AI的未来,提供了一种可能。”这种可能,不是“超越硅谷”的口号,而是“立足本土、解决真问题”的务实——用大道求简的专注,平衡求熵的韧性,胸怀求广的格局,机制求变的灵活,在限制中找机会,在创新中建生态。

未来的AI竞赛,不会是“单一技术路线的胜利”,而会是“多元创新的融合”。DeepSeek的中国式创新,或许正是中国AI在全球竞争中“破局”的关键——它证明,我们不需要复制硅谷的模式,只需把本土智慧与技术创新结合,就能走出一条属于自己的路。而这条路上,需要更多像DeepSeek这样“不浮躁、不盲从、敢突破”的勇者。

更多技术内容

更多技术内容可参见

清华《GPT多模态大模型与AI Agent智能体》书籍配套视频【陈敬雷】。

更多的技术交流和探讨也欢迎加我个人微信chenjinglei66。

总结

此文章有对应的配套新书教材和视频:

【配套新书教材】

《GPT多模态大模型与AI Agent智能体》(跟我一起学人工智能)【陈敬雷编著】【清华大学出版社】

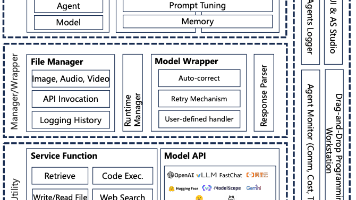

新书特色:《GPT多模态大模型与AI Agent智能体》(跟我一起学人工智能)是一本2025年清华大学出版社出版的图书,作者是陈敬雷,本书深入探讨了GPT多模态大模型与AI Agent智能体的技术原理及其在企业中的应用落地。

全书共8章,从大模型技术原理切入,逐步深入大模型训练及微调,还介绍了众多国内外主流大模型。LangChain技术、RAG检索增强生成、多模态大模型等均有深入讲解。对AI Agent智能体,从定义、原理到主流框架也都进行了深入讲解。在企业应用落地方面,本书提供了丰富的案例分析,如基于大模型的对话式推荐系统、多模态搜索、NL2SQL数据即席查询、智能客服对话机器人、多模态数字人,以及多模态具身智能等。这些案例不仅展示了大模型技术的实际应用,也为读者提供了宝贵的实践经验。

本书适合对大模型、多模态技术及AI Agent感兴趣的读者阅读,也特别适合作为高等院校本科生和研究生的教材或参考书。书中内容丰富、系统,既有理论知识的深入讲解,也有大量的实践案例和代码示例,能够帮助学生在掌握理论知识的同时,培养实际操作能力和解决问题的能力。通过阅读本书,读者将能够更好地理解大模型技术的前沿发展,并将其应用于实际工作中,推动人工智能技术的进步和创新。

【配套视频】

清华《GPT多模态大模型与AI Agent智能体》书籍配套视频【陈敬雷】

视频特色: 前沿技术深度解析,把握行业脉搏

实战驱动,掌握大模型开发全流程

智能涌现与 AGI 前瞻,抢占技术高地

上一篇:《GPT多模态大模型与AI Agent智能体》系列一》大模型技术原理 - 大模型技术的起源、思想

下一篇:DeepSeek大模型技术系列五》DeepSeek大模型基础设施全解析:支撑万亿参数模型的幕后英雄

更多推荐

已为社区贡献46条内容

已为社区贡献46条内容

所有评论(0)