建议收藏:大模型微调入门:LoRA技术详解与应用场景

LoRA(低秩自适应)是一种高效的大模型微调方法,通过冻结原模型参数并引入可训练的低秩矩阵,显著降低训练成本和显存需求。其核心优势包括:仅需微调少量参数(0.01%-1%)、训练速度快、产出模型小(MB级)、支持模块化任务切换且无推理延迟。该方法广泛应用于指令微调、领域知识注入、代码优化等场景,成为当前大模型定制化的主流技术之一,尤其适合消费级硬件实现高效微调。

文章主要介绍了一种大模型高效微调方法LoRA(Low-Rank Adaptation)。通过冻结原模型参数,添加少量低秩矩阵进行训练,LoRA能大幅降低微调成本和显存占用,使消费级硬件也能微调大模型。文章详细解释了LoRA的工作原理、实现步骤及其优势:训练速度快、产出物小巧、无推理延迟且支持模块化任务切换。LoRA广泛应用于指令微调、领域知识注入、代码模型优化等场景,是当前大模型定制化的主流技术之一。

1,什么是模型微调

模型微调 是指在一个已经预训练好的大型模型(例如 BERT、GPT、ResNet 等)的基础上,使用特定领域或任务的数据进行额外的训练,使模型适应新的任务或数据分布。为什么要微调呢?原因包括但不限于如下几个:

- 节省开发成本:不用开发基础模型,节省大量资源。

- 节省资源:从零开始训练一个大型模型需要海量数据和巨大的算力,成本极高。微调只需要相对较少的数据和计算资源。

- 提升性能:预训练模型已经从海量通用数据中学习了丰富的特征和知识(如图像纹理、语言语法)。微调可以看作是在这个“知识渊博”的基础上,进行“专项强化训练”,从而在新任务上快速达到很高的性能。

- 避免过拟合:当任务特定数据较少时,如果从头训练一个复杂模型,很容易过拟合。微调预训练模型则有效得多。

2,一些模型微调的方法

我目前了解到的一些模型微调的方法都属于PEFT的范畴,核心思想都是冻结原模型的大部分参数,只选择性地微调一小部分参数或者添加少量额外参数,以实现高效微调。具体有:

- Adapter:在 Transformer 层的 FFN 层后面插入一个小的神经网络模块(Adapter层),只训练这些Adapter。

- Prompt Tuning:不修改模型本身,只在输入前添加一些可训练的“软提示”向量,通过引导模型关注特定信息来完成任务。

- Prefix Tuning:是 Prompt Tuning 的升级版,不仅在输入层添加可训练前缀,在每一层都添加。

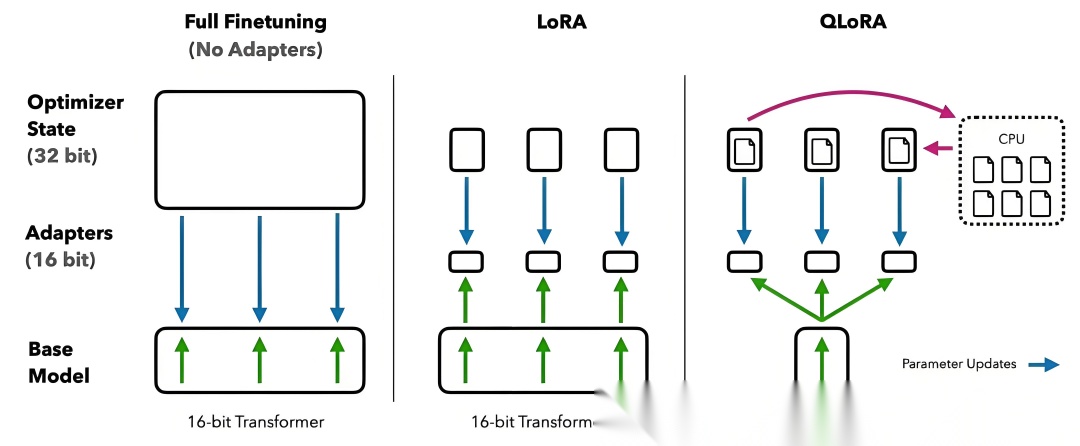

- QLoRA:可以看作是 LoRA 的量化升级版。它首先将预训练模型量化为 4-bit(大大减少显存占用),然后冻结参数,再添加 LoRA 旁路矩阵进行训练。这是目前消费级硬件微调大模型的最流行、最先进的方法之一。

- IA³:通过引入可训练的“缩放向量”来对模型的激活值或权重进行缩放,从而调整模型行为,要训练的参数量极少。

3,什么是LoRA(Low-Rank Adaptation)

LoRA 是一种主流的参数高效微调方法,能大幅降低微调成本。通过向模型的部分层添加可训练的低秩矩阵模块,实现模型在特定任务上的能力调整,同时保持原模型参数不变。

LoRA 由微软研究员 Edward J.Hu 等人在2021年提出,原论文为《LoRA: Low-Rank Adaptation of Large LanguageModels》

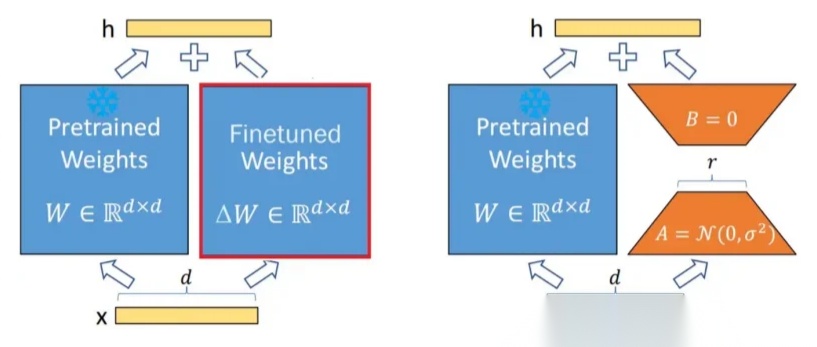

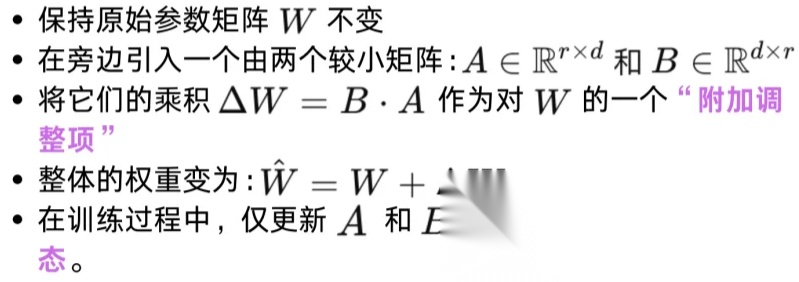

LoRA 的灵感来源于一个发现:模型在适应新任务时,其权重变化往往具有较低的“内在秩”。这意味着完整的权重更新矩阵(∆W)可以用更低维度的矩阵来近似表示。

LoRA 的具体实现步骤如下:

- 冻结原始权重:首先,我们锁定预训练模型(例如LLaMA、ChatGLM)的所有参数。在微调过程中,这些参数保持不变,既不计算梯度也不更新。

- 注入旁路矩阵:对于模型中需要微调的层(通常是Transformer结构中的自注意力机制 的Query, Key, Value, Output投影层和前馈网络层),我们并行地添加一对矩阵 A 和 B。

-

矩阵 A :一个 (原始维度 × 秩r) 的矩阵,使用随机高斯分布初始化。

-

矩阵 B :一个 (秩r × 原始维度) 的矩阵,初始化为零矩阵。

-

这里的 秩(r) 是一个远小于原始维度的超参数(通常为4、8、16、64等),是LoRA的核心,决定了新增参数量的大小。

- 前向传播:在前向计算时,对于原始权重矩阵 W,其输出变为:h = Wx + BAx

-

Wx 是原始模型的计算结果(权重被冻结)。

-

BAx 是LoRA引入的“旁路”计算结果。B*A 就是一个低秩的、对原始权重的增量更新矩阵(∆W)。

-

只训练新参数:在微调过程中,只优化低秩矩阵 A 和 B 的参数。原始权重 W 完全不参与更新。

-

合并权重(推理阶段):训练完成后,我们可以将低秩更新直接合并回原始权重中:W_new = W + BA。合并后,模型架构和原始模型完全一样,没有任何推理延迟。当然,也可以不合并,在推理时动态加载LoRA权重。

4,LoRA的优势

- 显存效率极高,大幅降低硬件门槛:这是LoRA最突出的优势。由于不需要存储和计算绝大部分参数的梯度,显存占用从“整个模型”变为“LoRA参数+优化器状态+激活值”。这使得在单张24GB显存的消费级显卡(如RTX 4090)上微调70亿参数(7B)的模型成为现实。

- 训练速度快:需要训练的参数数量可能仅为原模型的0.01%到1%,因此训练速度非常快,通常几个小时就能完成微调。

- 产出物小巧,易于共享与部署:训练得到的LoRA权重文件(adapter_model.safetensors)通常只有几MB到几百MB,而不是原模型的几个GB。这使得分享、存储和加载多个针对不同任务的微调模型变得极其方便。

- 无推理延迟:一旦将LoRA权重合并回原模型,最终的模型和原版结构、速度完全一致,不会引入任何额外的计算开销。

- 模块化与任务切换:可以不合并权重,而是为同一个基座模型准备多个LoRA适配器(例如:一个用于数学能力,一个用于法律咨询,一个用于角色扮演)。在推理时,可以根据需求动态加载不同的LoRA模块,实现“一个模型,多种能力”的灵活切换。

5,应用场景

LoRA的应用场景极其广泛,几乎所有基于Transformer架构的大模型微调任务都可以使用它:

- 指令微调:让一个通用的基座模型(如LLaMA 3)遵循人类的指令进行对话。这是最常见的使用场景,使用指令数据集(如Alpaca格式)进行LoRA微调,可以快速得到一个高质量的对话机器人。

- 领域知识注入:将特定领域的知识(如医疗、法律、金融、科技论文)注入模型,打造一个领域专家。例如,使用医学教科书和论文摘要微调一个模型,使其能回答专业的医学问题。

- 代码模型微调:提升模型在特定编程语言、代码库或框架下的代码生成和理解能力。

- 角色扮演与风格化:让模型模仿某个特定人物(如历史名人、虚拟角色)或某种风格(如莎士比亚文体、新闻稿风格)进行说话和创作。

- 控制模型输出:微调模型以生成特定格式的输出,例如严格的JSON结构、特定的摘要长度或情感倾向。

读者福利大放送:如果你对大模型感兴趣,想更加深入的学习大模型**,那么这份精心整理的大模型学习资料,绝对能帮你少走弯路、快速入门**

如果你是零基础小白,别担心——大模型入门真的没那么难,你完全可以学得会!

👉 不用你懂任何算法和数学知识,公式推导、复杂原理这些都不用操心;

👉 也不挑电脑配置,普通家用电脑完全能 hold 住,不用额外花钱升级设备;

👉 更不用你提前学 Python 之类的编程语言,零基础照样能上手。

你要做的特别简单:跟着我的讲解走,照着教程里的步骤一步步操作就行。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

为什么要学习大模型?

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献68条内容

已为社区贡献68条内容

所有评论(0)