大模型安全防线构建:预训练数据过滤技术实现33%有害性降低!

我们尝试从模型的预训练数据中移除有关化学、生物、放射性和核武器(CBRN)的有害信息。我们使用分类器识别有害内容,并在过滤后的数据集上从头开始预训练模型。这种方法使模型在有害性评估指标中相对于随机基线降低了33%,同时保留了其有益能力。

摘要: 我们尝试从模型的预训练数据中移除有关化学、生物、放射性和核武器(CBRN)的有害信息。我们使用分类器识别有害内容,并在过滤后的数据集上从头开始预训练模型。这种方法使模型在有害性评估指标中相对于随机基线降低了33%,同时保留了其有益能力。

引言

基于互联网规模数据训练的 AI 系统可以为用户提供涵盖极其广泛主题的综合知识。然而,这些丰富的信息中也包含敏感内容,如果被滥用可能带来危险。例如,与化学、生物、放射性和核武器(CBRN)相关的信息,如果落入不当之手,可能使具备基础技术背景的恶意行为者有能力开发大规模杀伤性武器。我们的“负责任扩展政策”(Responsible Scaling Policy, RSP)承诺我们将减轻此类威胁模型的风险,并限制我们的模型传播有害信息。

在模型预训练过程中学习了有害信息后,使用后处理方法(如遗忘方法)移除这些信息可能具有挑战性(Deeb 等人,2024;Łucki 等人,2024)。现有方法往往难以在不损害其他能力的情况下完全清除有害内容。在本文中,我们通过预训练数据过滤从源头上解决这一风险。我们使用分类器识别并移除预训练数据中潜在的有害信息,然后在过滤后的数据集上从头开始预训练模型。

通过过滤特定数据,我们能够在不降低模型其他能力的情况下减少其有害知识。在中等规模模型上,我们将有害性评估指标相对于随机基线降低了33%,而在MMLU、代码和散文等标准基准测试中没有显著下降。

设置

预训练数据过滤的目标是最大化有害性评估指标的下降,同时最小化无害性评估指标的下降。为此,我们自动评估模型预训练数据集中每个文档的危害性,并移除那些超过特定阈值的文档。通过调整这一阈值,我们实现了安全性和实用性之间的不同权衡,从而根据我们的具体要求调整模型性能。需要注意的是,某些信息可能具有双重用途。例如,关于通用科学能力的信息可能使恶意用户能够执行有害任务,但也可能使合法用户受益以执行正当任务。因此,如何进行针对有害信息的定向数据干预仍是一个开放性问题。

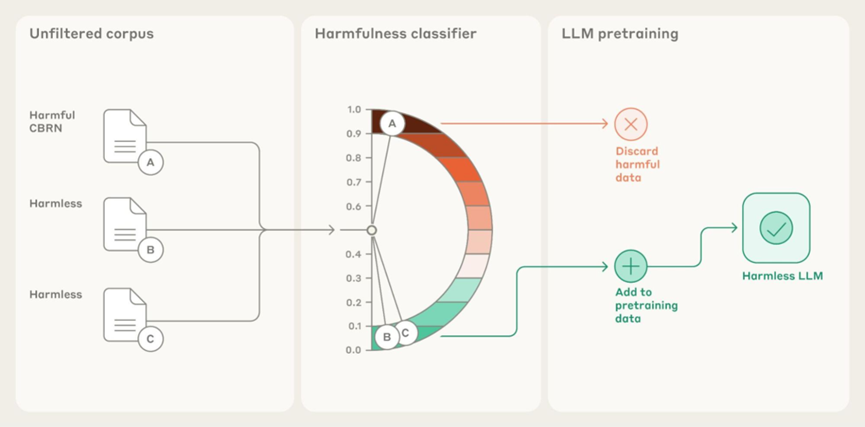

图1:预训练数据过滤流程。我们使用分类器自动评估模型预训练数据集中每个文档的危害性,并移除那些超过特定阈值的文档。然后,我们在仅包含无害内容(由分类器确定)的过滤后数据集上从头开始预训练模型。

分类器

有害数据过滤的关键是一个危害性评分器,我们将其设定为一个二元分类问题(有害 vs. 无害)。

一个好的分类器应具备以下特点:

- 准确性:确保过滤结果能够降低危害性,同时仅对实用性造成最小的影响;

- 高效性:由于预训练语料库的规模庞大,分类器需要能够高效处理。

方法

我们实验了6种分类方法来检测CBRN内容。我们首先描述这些方法,然后讨论每种方法使用的骨干模型。

-

宪法式微调分类器(Finetuned Constitutional classifier):我们在标记为有害与无害的数据上微调了一个语言模型(LM)。更多细节请参见 Sharma 等人,2025,特别是附录 B 中的宪法示例。

-

提示式宪法分类器(Prompted Constitutional classifier):我们通过提示一个语言模型来标记违反我们 CBRN 宪法的内容。我们还测试了第二个版本,其宪法聚焦于 CBRN 的不同方面,称为提示式宪法分类器 v2。

-

隔离损失(Holdout Loss)(Mindermann 等人,2022):我们构建了一个专门针对有害 CBRN 内容的“金丝雀模型”(canary model),然后如果金丝雀模型在某文档上的困惑度显著低于基础模型,则将该文档标记为有害。在金丝雀模型下困惑度低的文档很可能包含有害 CBRN 内容,因为该模型在有害 CBRN 数据上训练,自然在类似内容上损失较低。我们通过以下两种方式构建了有害语言模型:

1)微调:我们在有害文档上以语言建模损失微调基础模型。

2)提示:我们使用有害文档作为上下文示例,提示一个仅限帮助的模型。

-

FastText:我们在标记为有害与无害的数据上训练了具有可学习嵌入的二元词袋分类器(Joulin 等人,2016)。

-

命名实体字符串匹配(Named Entities String Match):我们编制了一份需要格外谨慎的有害 CBRN 命名实体列表。我们使用字符串匹配,并以文档中有害命名实体的密度来衡量其危害性。

骨干模型:我们的宪法式微调分类器使用了一个小型模型(远小于 Claude 3.5 Haiku)。提示式宪法分类器、提示 CBRN 分类器和隔离损失分类器均使用 Claude 3.5 Sonnet,成本远高于小型模型。FastText 比小型模型便宜几个数量级,而命名实体字符串匹配是成本最低的。

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

分类器评估

为了评估我们的分类器,我们需要标记为有害和无害的文档。由于没有可用的标记数据,我们通过提示大语言模型(LLMs)生成合成的标记文档。具体来说,我们通过提示 Claude 3.5 Sonnet 回答 MMLU 数据集(Hendrycks 等人,2020)中的无害自然科学(化学和生物学)问题来生成合成无害文档,并通过提示仅限帮助的 Claude 3.5 Sonnet 回答 WMDP 数据集(Li 等人,2024)中的有害 CBRN 问题来生成合成有害文档。我们在合成数据集上测量了所有分类器的 F1 分数,除了命名实体分类器,因为它仅设计用于捕获特定危害的子集。

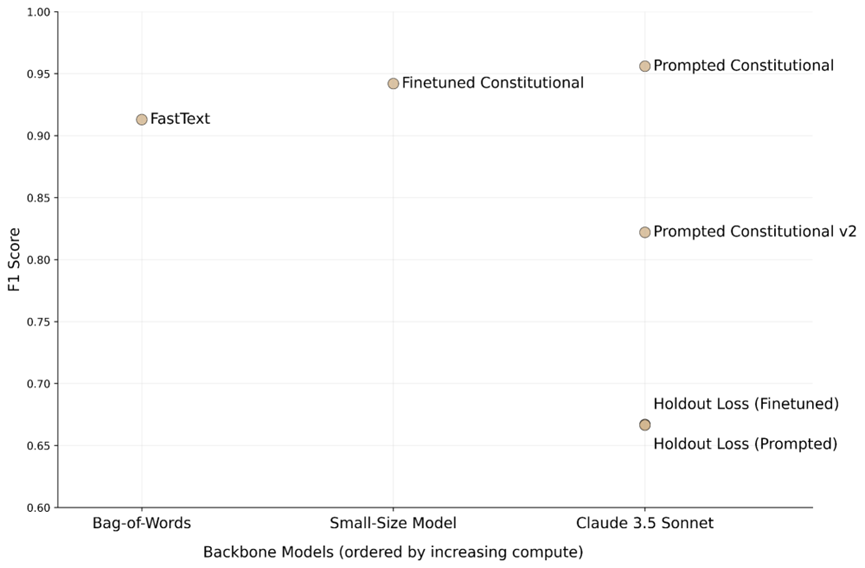

图2:我们构建的各种分类器的F1分数。基于Claude 3.5 Sonnet的提示式宪法分类器表现最佳,其次是基于小型模型的宪法式微调分类器。

基于Claude 3.5 Sonnet的提示式宪法分类器的F1分数为0.96,表现最佳,其次是基于小型模型的宪法式微调分类器(F1分数为0.94)。然而,Claude 3.5 Sonnet的计算成本过高,无法扫描整个预训练语料库。因此,我们使用计算成本低得多的小型宪法式微调分类器来扫描整个预训练语料库,并在此基础上实验了另外两个变体:

- 宪法式微调 + 提示式宪法(顺序):我们首先使用成本较低的微调分类器标记出1%最具危害性的文档,然后使用成本较高但更精确的提示分类器进行重新排序。这种两步分类器仅标记了预训练数据中的一小部分,因为大多数最初被微调分类器识别为有害的文档在提示分类器的后续评分中获得了低危害分数。

- 宪法式微调+ 命名实体(并行):我们分别使用微调分类器和命名实体分类器标记最具危害性的文档,然后合并被标记的文档。

我们还对被标记为有害的数据样本进行了人工审查,发现它们确实与我们试图移除的有害 CBRN 信息相符。

预训练实验

为了评估数据过滤的效果,我们从头开始预训练了多对模型进行比较:每对模型中,一个模型在包含有害和无害内容的未过滤数据集上训练,另一个模型在仅包含无害内容(由分类器确定)的过滤数据集上训练。

为了确保公平比较,我们通过从更大的初始数据池中构建过滤数据集,保证过滤和未过滤数据集具有相同数量的样本。我们通过比较成对模型在一组能力评估上的性能差异来衡量数据过滤的影响。

评估数据与指标

为了评估我们的方法,我们测量了有害性和无害性的指标变化。我们使用WMDP数据集的多项选择题评估有害性。对于无害性,我们首先在MMLU数据集的自然科学(化学和生物学)问题上进行评估,这些问题是与有害CBRN内容较为相关的无害性指标,因此较容易受到过于严格的数据过滤的影响。我们还评估了多种相关性较低的无害性指标,包括散文、代码、数学和MMLU,以确保数据过滤不会对实用性产生意外的副作用。

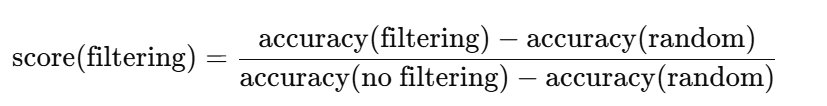

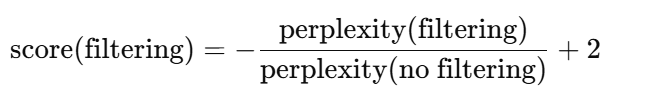

我们对散文和代码任务测量了困惑度(perplexity),对多项选择题(WMDP、MMLU)测量了top-1少样本(few-shot)准确率。所有结果均以相对于无过滤的性能分数报告。对于多项选择题,我们使用相对于随机基线的准确率计算相对分数:

分数越高表示保留的能力越多。对于散文和代码评估,我们计算了过滤后困惑度与无过滤困惑度的比率。由于较低的困惑度表示更高的能力,我们通过取负值并加2转换该比率,即

经过这一转换,两个指标的方向性一致:分数越高表示保留的能力越多,分数为1表示数据过滤未导致能力变化。

一个有效的数据过滤过程应使有害性的指标相对分数显著低于1,而无害性的指标相对分数接近1。我们的数据过滤方法通过设置不同的过滤阈值,允许我们在安全性和各种实用性之间实现不同的权衡。

结果

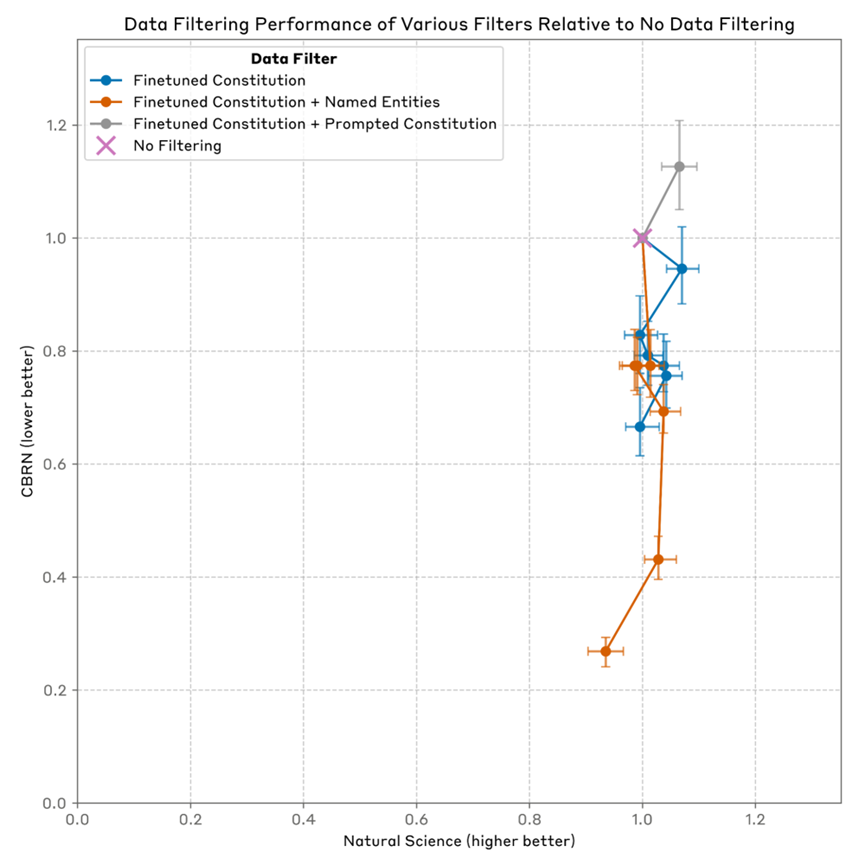

我们首先比较了三种数据过滤器(单独的宪法式微调分类器、宪法式微调 + 提示式宪法分类器、宪法式微调 + 命名实体分类器)的性能,然后展示了表现最佳的过滤器的完整结果。为简单起见,以下我们使用“微调”指代宪法式微调分类器,“提示”指代提示式宪法分类器。

在结果图中,我们将展示CBRN相关能力的相对性能(分数越低越好)与各种有用能力的相对性能(分数越高越好)之间的关系。每条曲线上的不同点对应不同的过滤阈值,使我们能够在安全性和能力之间进行权衡。

不同过滤器的比较

在实验中,我们观察到过于激进的CBRN数据过滤主要影响自然科学(化学和生物学)的性能,因此我们在比较不同过滤器时,重点关注CBRN与自然科学之间的权衡。

图3:不同数据过滤器在有害CBRN和无害自然科学上的性能(相对于无数据过滤)。微调分类器(Finetuned)与微调+命名实体(Finetuned + Named Entities)的性能相当,两种过滤器均优于微调+提示(Finetuned + Prompted)。分数大于1表示数据过滤提升了评估性能。

与仅使用微调分类器(蓝色)相比,添加命名实体进行并行标记(橙色)并未持续改善安全性和实用性的权衡。这可能表明我们的微调分类器已经捕获了包含有害命名实体的大部分有害内容。

不幸的是,使用微调+提示两步分类器(灰色)进行过滤不仅未能降低CBRN性能,反而略有增加。这有些令人意外,因为我们的分类器评估结果显示提示分类器的表现最佳。这种差异可能源于实际预训练文档与用于分类器评估的合成文档之间的分布偏移。提示分类器在此处表现不佳可能表明,危害的定义在某些方面较为微妙,通过简单提示难以准确指定,而微调分类器则有机会从标记示例中学习。

基于上述结果,我们选择了单独的宪法式微调分类器作为我们的数据过滤解决方案。

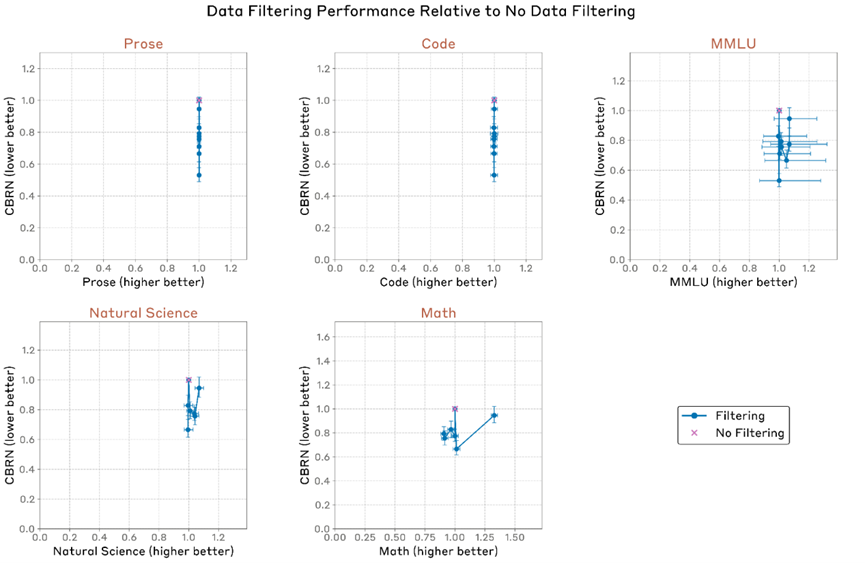

最佳过滤器的完整结果

我们现在展示所选过滤器的完整结果。每个图表显示了安全性(CBRN,值越低越好)与我们关注的特定实用性指标(散文、代码、MMLU、自然科学、数学,值越高越好)之间的权衡。两个轴均显示数据过滤后相对于无数据过滤的性能分数,x轴为实用性,y轴为安全性。结果显示,数据过滤在 5 项无害性指标评估中的 4 项并未损害模型的有用性,唯一的例外是数学(Math),其结果更具噪声(即在某些阈值下过滤会降低性能,而在另一些阈值下则会提升性能)。总体而言,我们的结果表明:我们可以有效区分有害数据与无害数据,并通过预训练数据过滤提升模型的安全性,而不会严重损害其实用性。

图4:我们选定的数据过滤器在有害CBRN和各种无害实用能力上的性能(相对于无数据过滤)。通过选择不同的过滤阈值,我们实现了不同的安全性和实用性权衡。

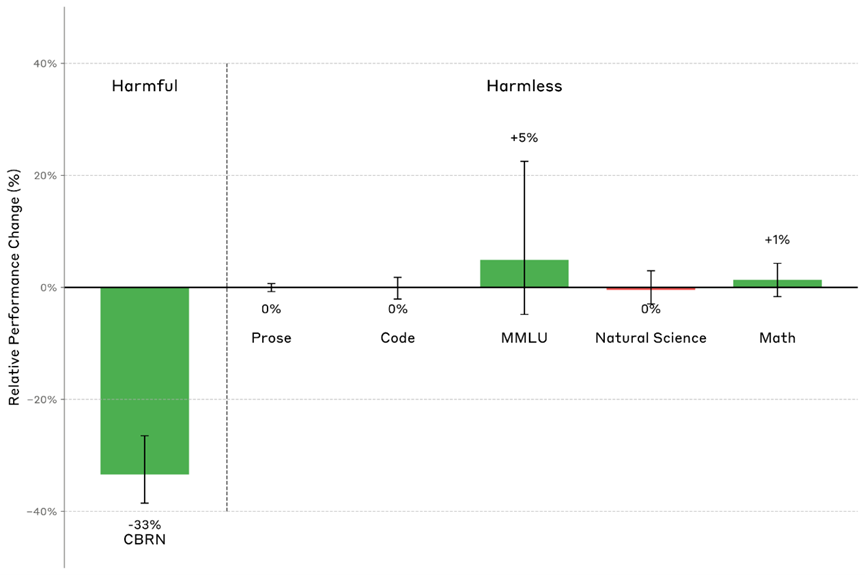

我们可以根据特定用例选择安全性和能力之间的权衡。在一个过滤阈值(0.939)下,我们的数据过滤将有害CBRN评估指标的相对分数降低了 33%(从33.7±0.4%降低到30.8±0.4%,其中33%的降低是基于该方法相对于25%随机基线的表现计算得出的),同时在我们使用的所有无害性评估指标中没有显著下降。

图5:我们选定阈值下数据过滤相对于无数据过滤的性能变化。我们的最终数据过滤将CBRN的评估指标的相对分数降低了33%,同时在任何无害性评估指标中均未导致显著下降。

这些结果共同表明,我们可以有效地将有害数据与无害数据分开,并通过预训练数据过滤来提高模型安全性,而不损害其实用性。

相关工作

预训练数据干预。先前研究已探索了出于各种目的进行预训练数据干预,例如减轻毒性(PaLM 2)、减少私人信息泄露(Korbak 等人,2023)以及提高预训练效率(Wettig 等人,2024)。两种常见的干预方法是数据过滤和条件训练,其中条件训练在预训练数据前添加特殊的数据质量标记,并用于控制测试时推理(Korbak 等人,2023,PaLM 2)。与我们的方法不同,条件训练仍然训练模型获取有害知识,因此可能通过越狱攻击被诱导出来。在数据选择方面,先前工作研究了通过影响函数(Zhang 等人,2024;Yu 等人,2024)或对数概率相关性(Thrush 等人,2024)识别与下游任务最相关的预训练数据的方法。先前工作还研究了使用模型评分器选择高质量数据(Wettig 等人,2024)。与我们的工作同时,O’Brien 等人(2025)表明,预训练数据过滤还能在对抗性微调有害文本的情况下提高开源权重模型的安全性。

大语言模型遗忘。先前研究探索了多种遗忘方法,以在预训练大语言模型(LLMs)后提高其安全性。梯度上升方法通过梯度上升训练模型遗忘特定知识(Jang 等人,2023;Yao 等人,2023)。另一种方法是模型内部方法,首先定位模型激活或权重中需要遗忘的知识,然后通过扰动或微调移除这些知识(Sinitsin 等人,2020;Zhu 等人,2020;Yu 等人,2023)。不幸的是,现有遗忘方法往往缺乏鲁棒性——被遗忘的知识仍可能被诱导出来,或者遗忘过程可能损害有用的能力(Lynch 等人,2024;Deeb 等人,2024)。

结论与未来方向

在本文中,我们讨论了针对性的预训练数据过滤方法,该方法有效提高了模型安全性的同时仍能保持模型的有效性。

我们希望我们的结果能激励研究人员探索过滤有害内容以减轻各种人工智能风险。除了本文关注的滥用风险外,数据过滤还有可能降低对齐风险(misalignment risks)。一种可能的方法是过滤掉描述人工智能可能通过离上下文推理(Berglund 等人,2023)进行不对齐行为的有效策略的AI研究论文(例如奖励操控(reward hacking)、阴谋(scheming)、欺骗(deception)、破坏(sabotage)等),以及鼓励这些不对齐行为的文档。从预训练数据中排除此类内容可能使训练出的模型在这些行为上的能力降低,并且一开始就不太倾向于从事这些行为。

未来在改进数据过滤方面有许多机会。我们的方法使用分类器来确定要过滤的数据;未来的工作可以提升分类器的准确性和/或效率。我们也有兴趣探索不使用数据分类器的正交数据过滤方法,例如使用影响函数(Koh 等人,2017;Grosse 等人,2023)来识别对下游有害性评估最有效转移的预训练样本。

未来的工作还应研究经过数据过滤训练的模型在微调方面的鲁棒性。在对抗性场景中,恶意行为者可能在有害数据上微调模型以进行滥用。通过实证研究:数据过滤所带来的有害性评估指标削减中,有多少比例可以通过事后微调(post-hoc finetuning)或上下文提示(in-context prompting)被恢复,将有助于评估在最坏情况下预训练数据过滤的有效性(O’Brien 等,2025)。

AI大模型学习和面试资源

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献75条内容

已为社区贡献75条内容

所有评论(0)