医疗AI的“透明眼镜“:让AI诊断过程清清楚楚的技术详解与代码实现(值得收藏)

文章介绍了可解释人工智能(XAI)在医疗领域的重要性及应用,解决AI医疗"黑箱"问题。详细分析了XAI技术分类(前解释/后解释、全局/局部解释)、核心方法(Grad-CAM、SHAP、LIME)及其在医学图像分析、电子健康记录中的应用。研究通过实验评估了不同XAI方法在CNN模型上的性能,强调了XAI在提高医疗AI可信度、交互性和隐私保护方面的价值。

简介

文章介绍了可解释人工智能(XAI)在医疗领域的重要性及应用,解决AI医疗"黑箱"问题。详细分析了XAI技术分类(前解释/后解释、全局/局部解释)、核心方法(Grad-CAM、SHAP、LIME)及其在医学图像分析、电子健康记录中的应用。研究通过实验评估了不同XAI方法在CNN模型上的性能,强调了XAI在提高医疗AI可信度、交互性和隐私保护方面的价值。

原论文信息如下:

论文标题:

Towards a Transparent and Interpretable AI Model for Medical Image Classifications

发表日期:

2025年09月

作者:

Binbin Wen, Yihang Wu, Tareef Daqqaq, Ahmad Chaddad

发表单位:

无

原文链接:

http://arxiv.org/pdf/2509.16685v1

开源代码链接:

https://github.com/AIPMLab/XAI-review-2024

想象一下这个场景:AI医生看了你的CT片后说"你得了肺癌",但你问它为什么这么判断时,它却支支吾吾说不出个所以然。这种"黑箱"操作在医疗领域可是大忌!医生不敢轻易相信,患者更是心里没底。😟

这就是为什么**可解释人工智能(XAI)**在医疗领域如此重要。XAI的全称是Explainable Artificial Intelligence,中文意思是"可解释的人工智能"。它就像是给AI医生装上了一副"透明眼镜",让它的诊断过程变得清清楚楚、明明白白。

引言:为什么XAI在医学中至关重要?

在医疗诊断中,准确性固然重要,但解释性同样不可或缺。医生需要知道AI是基于什么特征做出判断的,这样才能验证诊断的合理性,避免误诊。

举个例子:当深度学习模型根据CT扫描数据推断患者患有肺结核时,医生必须确定诊断结果的来源。如果AI无法提供清晰的解释,医生就不敢直接使用这个结果,而是需要根据自己的经验仔细检查相关测试数据。

XAI的出现正是为了解决这个信任危机。它通过提供透明的决策过程,让医生和患者都能理解AI的判断依据,从而建立对AI系统的信任。

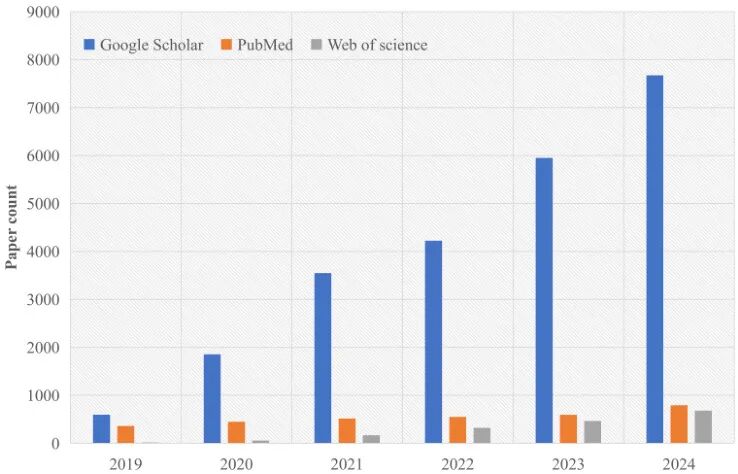

图1:过去五年XAI领域发表论文数量。数据来源于Google Scholar、PubMed和Web of Science三个不同的来源,数据收集截止到2025年3月1日。

从图1可以看出,XAI领域的研究热度在持续上升。特别是在2023年,相关论文发表数量达到了约6000篇,这说明学术界对XAI的重视程度越来越高。

相关工作:XAI技术的发展脉络

XAI技术在医疗领域的应用已经取得了显著进展。研究人员开发了多种方法来提高AI系统的可解释性,包括基于规则的学习、学习过程的可视化、基于知识的数据表示以及以人为中心的AI模型等。

在疾病预测、诊断和治疗方面,XAI的应用和研究最为广泛。例如:

**胸部X光图像分类:**研究人员引入了一种新的XAI方法来分割图像,更好地理解AI模型如何得出胸部X光图像分类任务的结果。

**乳腺癌分割:**使用梯度加权类激活图(Grad-CAM)来可视化Deeplabv3的决策过程,提高乳腺癌分割任务的可解释性。

这些研究展示了XAI在提高模型透明度、增加信任、优化性能和推动医学图像分析创新方面的潜力。

XAI方法的分类:从阶段到具体技术

XAI方法可以根据不同的标准进行分类,如范围、数据类型和阶段等。本论文主要关注基于阶段、范围和特异性的分类方法。

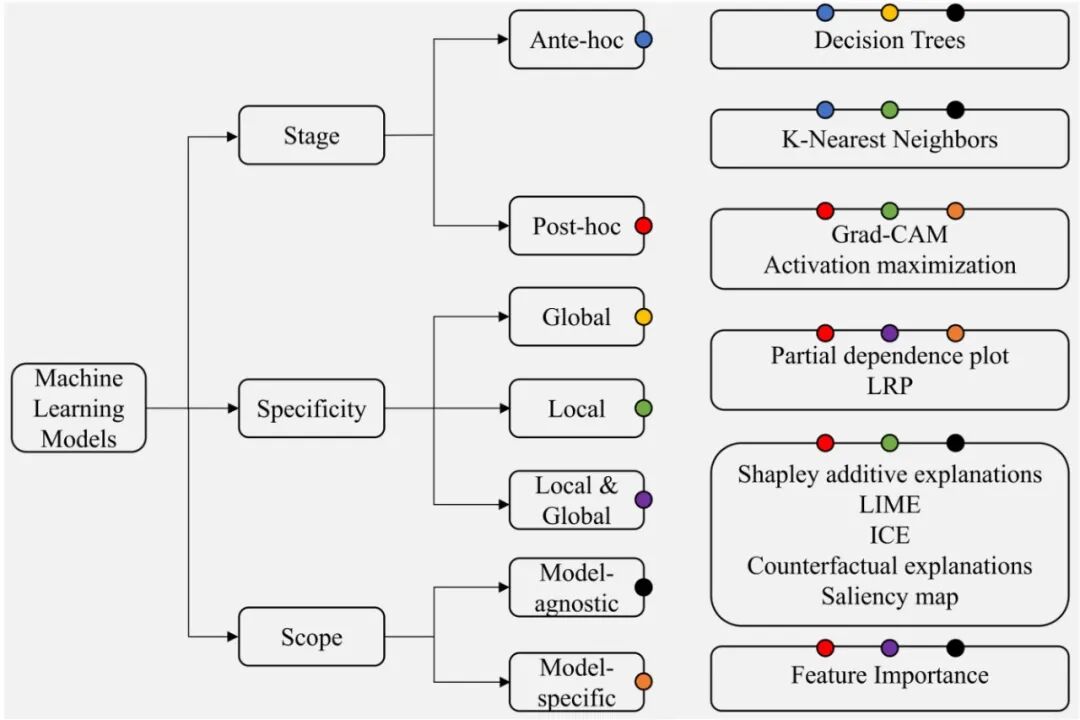

图2:XAI方法的分类。基于阶段、特异性和范围三个维度对十二种常见XAI方法进行分类。如图所示,后解释和模型无关包含的技术分别多于前解释和模型特定。

前解释 vs 后解释

**前解释(Ante-Hoc)**指的是通过训练具有简单结构和良好可解释性的模型,或者将可解释性集成到特定模型结构中,使模型本身具有可解释性。

自解释模型意味着如果一个模型本身是可理解的,那么它就被认为是透明的。因此,自解释模型也被称为透明模型。标准模型包括线性/逻辑回归、决策树、K近邻算法、贝叶斯模型、基于规则的模型等。

**后解释(Post-Hoc)**指的是通过开发解释技术来解释训练好的机器学习模型。给定一个训练好的学习模型,后解释的目标是使用解释方法或构建解释模型来解释模型做出的决策或行为。

全局解释 vs 局部解释

全局解释意味着理解模型的整体决策逻辑,而局部解释则专注于单个预测的解释。

当前的XAI方法,如LIME和SHAP,主要关注局部可解释性,帮助理解特定预测是如何做出的。这在医疗保健中非常重要,因为理解每个患者的个体预测至关重要。

假设一个深度学习模型将胸部X光图像诊断为"肺炎"。全局解释可能基于年龄、病史等披露预测该类的原因,但它无法确定在这个特定的X光图像中哪些区域导致了"肺炎"的诊断。局部解释直接分析图像中的特定区域,通过局部扰动观察哪些区域对预测结果影响最大,从而识别可能与肺炎相关的特定影像特征(如肺部磨玻璃影)。

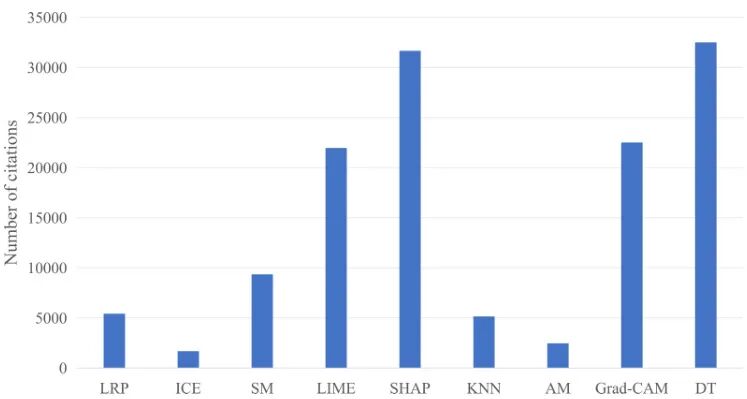

图3:基于XAI技术的引用次数条形图。搜索了Google Scholar中前面提到的九种技术的原始论文引用次数,数据收集截止到2025年3月1日。

从图3可以看出,除了基本的决策树技术外,最受欢迎的技术是SHAP、LIME和Grad-CAM。这个结论也可以在我们收集的论文中得到证明。

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

核心XAI技术详解

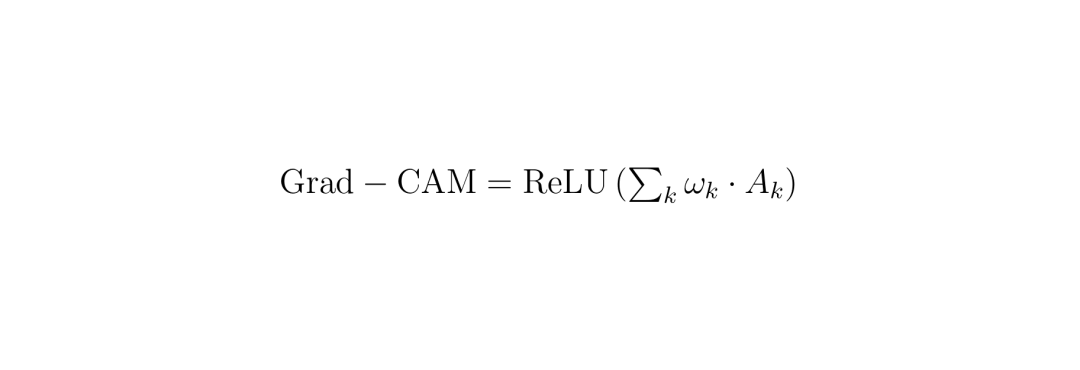

**Grad-CAM(梯度加权类激活映射):**这是一种基于梯度的可视化方法。它是CAM的广义形式,可以与各种CNN模型结合。只要模型有卷积层,Grad-CAM就可以用来可视化其决策过程。

Grad-CAM的优势在于生成的映射保留了输入图像的空间信息,允许精确定位图像中与预测结果相关的特定区域。

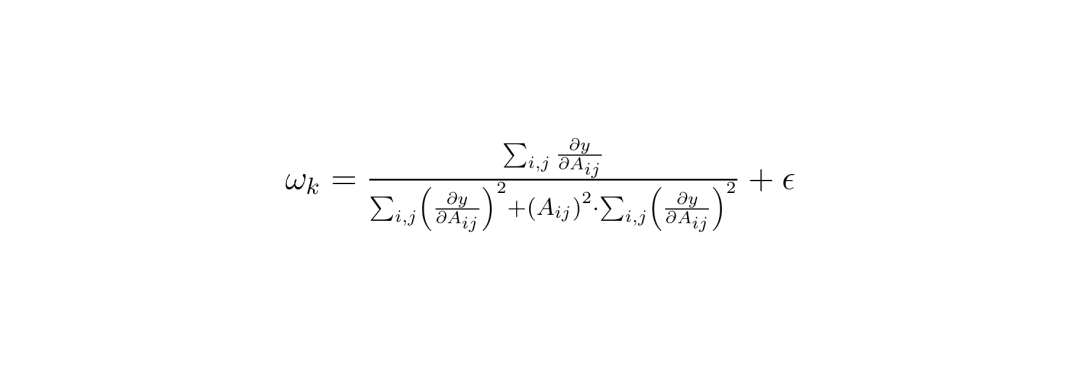

Grad-CAM权重计算公式:其中A_ij是特征图的元素,y是类别分数,ε是防止除零的小常数。

Grad-CAM可视化公式:其中ω_k是第k个通道的权重,A_k是第k个通道的特征图。

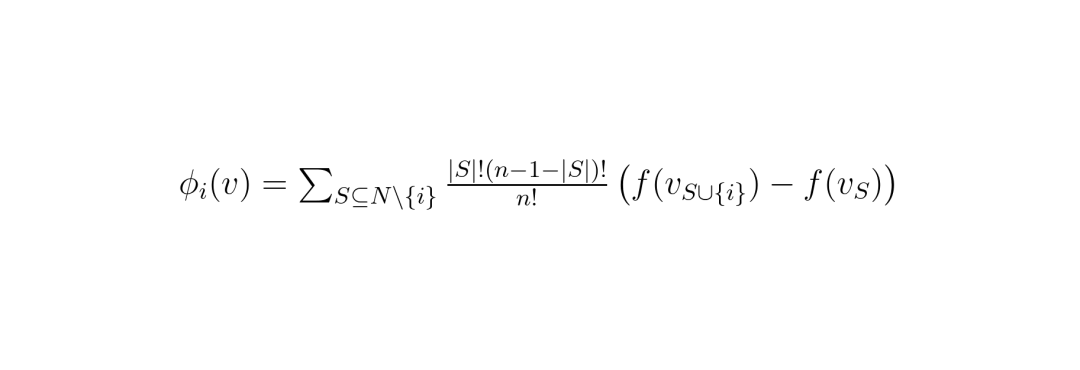

**SHAP(沙普利加性解释):**SHAP的目标是通过计算每个特征对预测的贡献来解释实例x的预测。SHAP可以看作是一个解释性预测框架,它统一了这些局部解释方法。

SHAP值计算公式:其中N是所有特征的集合,S是不包含特征i的N的子集,v是特征值的集合,f是模型预测函数,n是特征总数。

**LIME(局部可解释模型无关解释):**其思想是通过拟合局部代理模型来解释复杂模型(如深度神经网络)的预测。这个模型的预测很容易解释。

这种方法的一个优点是它在图像分类和自然语言处理相关任务中能够提供良好的性能。由于LIME本身是模型无关的,它具有广泛的应用性。

以人为中心的XAI:用户需求与定制化解释

每个产品或工具都是为特定目的或目标受众设计的,XAI也不例外。XAI的开发就是为了阐明超出人类理解范围的模型。

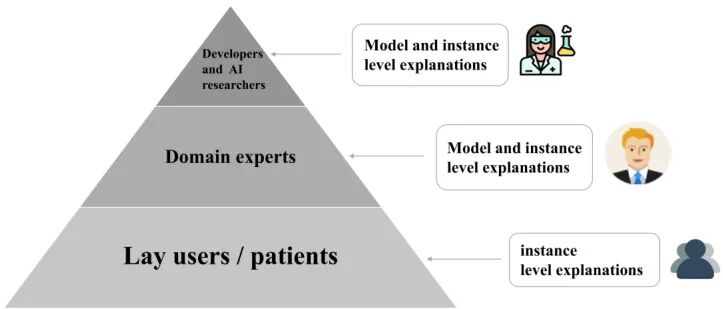

图4:基于用户知识背景和需求的分类。将用户分为三组,并为各自的类别提供适当的解释。

为了更好地解释不同的用户群体,研究人员将人们/用户划分为不同的目标群体,并为它们构建特定的解释。基于最近的文献,这些目标群体主要分为三类:

**开发者和AI研究人员:**具有深厚的技术背景,需要了解模型的内部工作机制和数学原理。

**领域专家(如医生):**需要了解AI诊断的医学依据,验证诊断结果的合理性。

**普通用户(如患者):**需要简单易懂的解释,了解诊断结果的基本依据。

这些不同解释的理由包括:用户需要的解释程度取决于其专业知识和能力;关键参与者有不同的目标,需要定制化的解释;某些解释对特定用户可能更重要;理论框架可以指导设计满足用户特定需求和目标的解决方案。

在医疗领域,以人为中心的设计尤为重要。研究人员开发了多种方法来提高用户信任和理解度,包括比较不同的XAI方法、评估测试组对AI决策的信任程度、开发理论驱动的框架等。

以人为中心的解释方法在方向和目的上更加具体,这使得每个目标群体都能获得更有针对性和更易理解的解释,从而对解释的满意度更高。

XAI在医疗保健中的应用:目标与实际案例

XAI在医疗领域的应用不仅仅是技术上的进步,更是对医疗信任体系的重新构建。通过提供透明的决策过程,XAI帮助医生和患者理解AI的判断依据,从而在高风险场景中建立可靠的合作关系。

在医疗保健中,XAI的核心目标可以归纳为三个关键点:可信度、交互性和隐私意识。这些目标确保了AI驱动的决策对医疗专业人员和患者都是可访问和透明的。

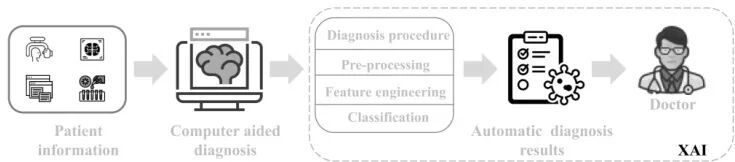

计算机辅助诊断(CAD)中的XAI

AI技术在医疗领域的应用日益广泛,包括手术机器人、医学图像分析、医疗决策支持和个人医疗助手等。在这些应用中,计算机辅助诊断系统尤其受益于XAI的集成。

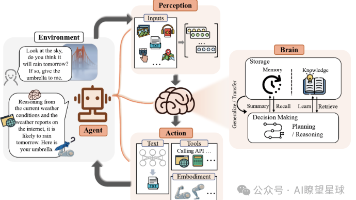

图5:XAI辅助CAD的流程图。展示了如何通过各种方法收集患者信息,并通过特征工程获得所需特征。这些特征随后被发送到XAI,在XAI专家和临床医生的帮助下,最终获得预测和诊断等决策结果。

图5清晰地展示了XAI在CAD中的工作流程。从患者信息收集到最终决策,XAI在整个过程中扮演着"解释者"的角色,确保每一步都是可追溯和可理解的。

医学图像分析的一个重大挑战是需要深入的解析分析来辅助诊断和决策支持。研究人员通过结合知识驱动和数据驱动的方法实现了可解释的CAD。这种整合可以利用前者的可解释性和后者的高准确性,从而实现多模态多样性和完整的解释,这些解释可以通过文本和概念等可理解的模式传达给人类。

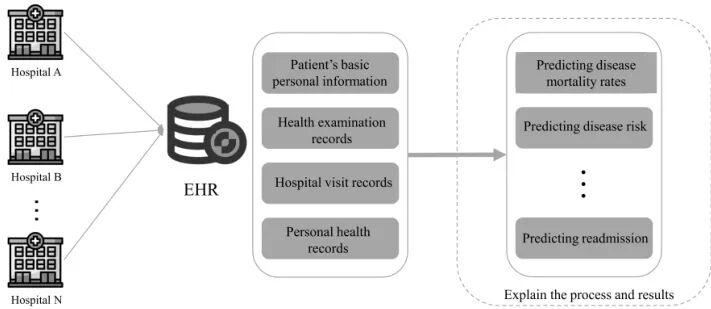

电子健康记录(EHR)与XAI的结合

电子健康记录系统旨在通过快速访问患者的完整医疗历史、提高医疗处方的准确性和可靠性,以及促进高效治疗来提高医疗服务质量。

图6:XAI中的EHR工作流程。EHR收集不同医院存储的患者信息以获取患者记录,并结合XAI为疾病预测、再入院预测等应用提供解释。

EHR系统的一个关键特征是其互操作性,允许医疗专业人员在不同的医疗实体之间生成、管理和共享数字健康信息,确保患者护理的连续性和一致性。

目前存在几种预测模型,包括随机森林、提升树、朴素贝叶斯、逻辑回归和决策树。尽管这些模型具有可解释性,但它们依赖于聚合属性,并没有考虑EHR数据内在属性的时间相关性,导致模型准确性不理想。

一项相关研究以另一种方式解释数据,比较了XAI方法(SHAP、LIME和Scoped Rules)给出的解释,作为分析复杂EHR的第三个扩展。最终,通过XAI模型对EHR的解释可以阐明特征的重要性,为临床决策提供重要信息。

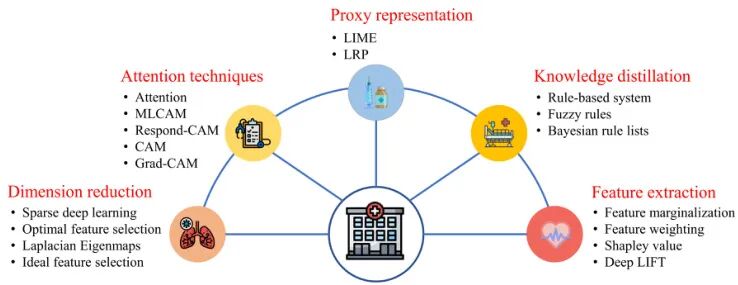

解决方案分类学

XAI在医疗保健中的解决方案可以根据不同的任务和技术类型进行分类。图7展示了五种不同的任务分类,并为每种任务提供了几种常用技术。

图7:医疗保健中不同任务的分类。根据XAI解释技术的类型对医疗保健中的不同任务进行分类。在五种不同的任务分类下,我们还为不同的任务提供了几种常用技术。

这些分类包括降维、注意力技术、代理表示、知识蒸馏和特征提取等。每种技术都有其独特的优势和应用场景,例如降维技术旨在保留主导特征的同时消除冗余特征,减少数据存储空间、计算时间和多重共线性问题。

注意力技术类似于人类视觉注意力,专注于图像的相关部分而忽略无关细节。这种方法解决了信息过载问题,提高了任务效率。

实验:基于CNN模型的XAI性能评估

为了全面评估三种主要XAI方法(集成梯度、Grad-CAM和SHAP)的性能,本研究考虑了四种公共CNN模型(ResNet50、DenseNet121、EfficientNetB3和EfficientNetB0)用于分类任务。这些模型应用于五个医学成像数据集(脑肿瘤、肺癌、结肠疾病、眼病和Covid-19)。

研究目标是探索这些XAI方法揭示模型决策过程的能力,特别是它们如何解释医学图像分类任务中的模型行为。

硬件和软件配置

本研究使用了具有先进计算能力和充足内存的硬件平台,以促进深度学习模型的高效训练和评估。系统采用第13代Intel® Core™ i9-13900K处理器,并支持128GB RAM。这些规格为处理大型数据集和执行计算密集型操作提供了强大的支持。

图形处理能力由包含的NVIDIA GeForce RTX 4090 GPU支持,其专用大容量视频内存显著增强了图像处理和模型训练的有效性。在软件设置方面,Python 3.9.18被用作实验编码环境,允许准确执行模型和分析。

数据集

实验使用了五个公开可用的Kaggle数据集。在数据集划分中,对于没有预定义验证集的脑肿瘤和Covid-19数据集,我们将训练集的20%分配为验证集。对于肺癌和结肠疾病数据集,虽然最初存在验证集,但我们将其合并到训练集中,然后从这个组合集中重新划分20%来构建新的验证集。

最后,对于眼病数据集,我们完全构建了数据划分,将70%分配给训练,10%分配给验证,20%分配给测试,以确保全面的评估框架。

评估指标

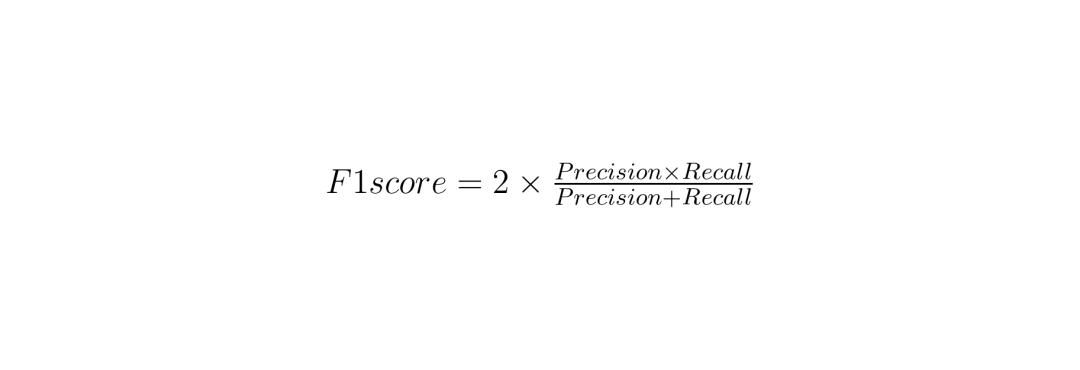

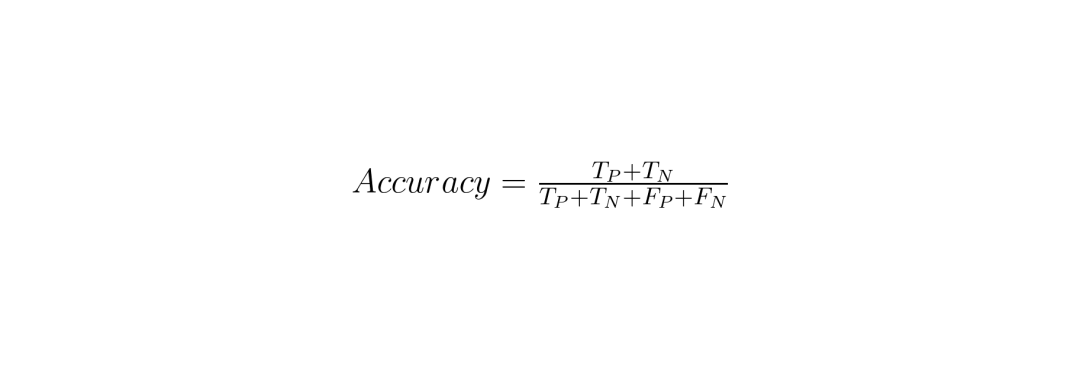

为了评估模型的性能,我们使用了以下指标:精确度、召回率、F1分数和准确度。

精确度计算公式:其中TP代表真阳性,FP代表假阳性。

召回率计算公式:其中TP代表真阳性,FN代表假阴性。

F1分数计算公式:F1分数是精确度和召回率的调和平均数。

准确度计算公式:其中TP代表真阳性,TN代表真阴性,FP代表假阳性,FN代表假阴性。

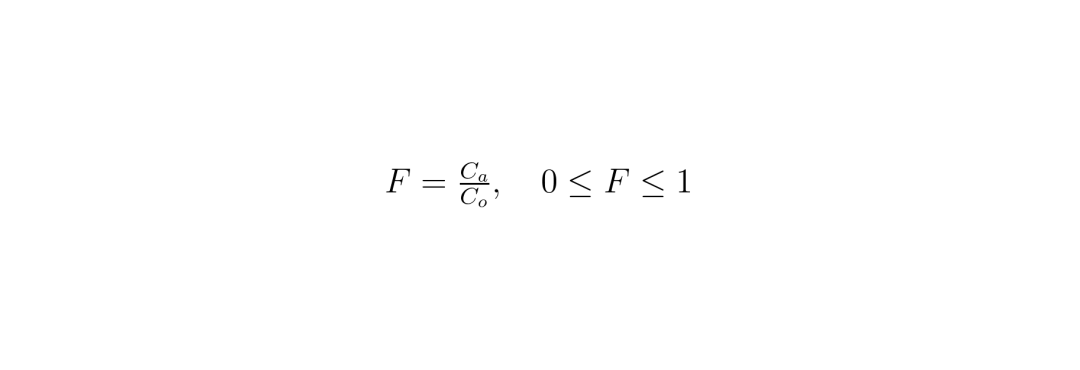

此外,我们引入了**保真度分数(F)**来评估解释方法的可信度,并量化解释与模型预测之间的一致性。它将模型在正常条件下的预测置信度(原始置信度)与引入对抗性扰动时的预测置信度进行比较。两个值越接近,解释方法对模型行为的忠实度越高。

保真度分数计算公式:其中C_o代表模型对特定类别的原始置信度,C_a代表对抗性置信度。

高保真度分数(F接近1)表示解释方法稳定、鲁棒且可靠,与模型预测一致性好。然而,低分数(F接近0)表明一致性和鲁棒性差。

实验结果

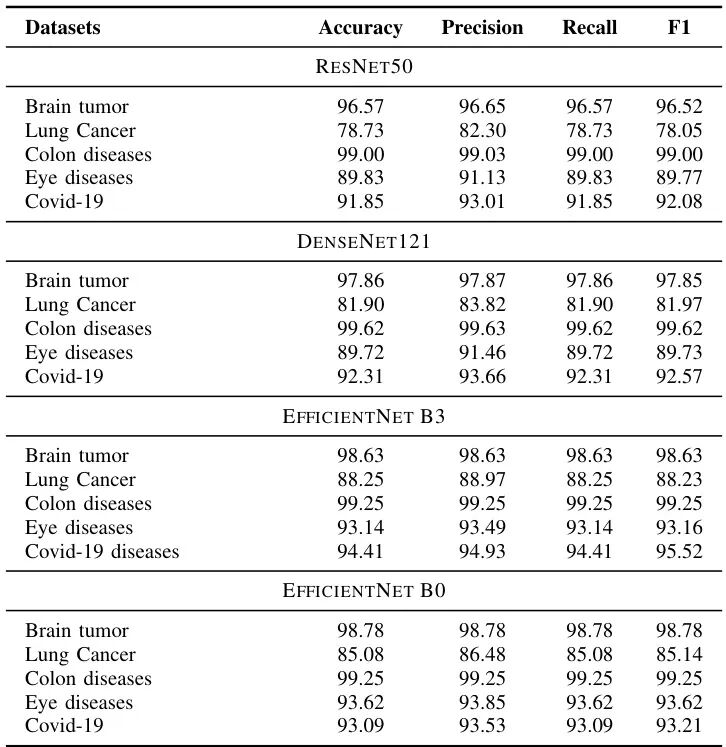

为了总结我们的模拟结果,我们以以下形式呈现性能指标:[准确度、精确度、召回率、F1分数以及正确/错误分类样本数]。表III显示了使用测试数据集的性能指标。

表III:分类任务中不同模型的性能指标总结。展示了ResNet50、DenseNet121、EfficientNetB3和EfficientNetB0在五个数据集上的准确度、精确度、召回率和F1分数。

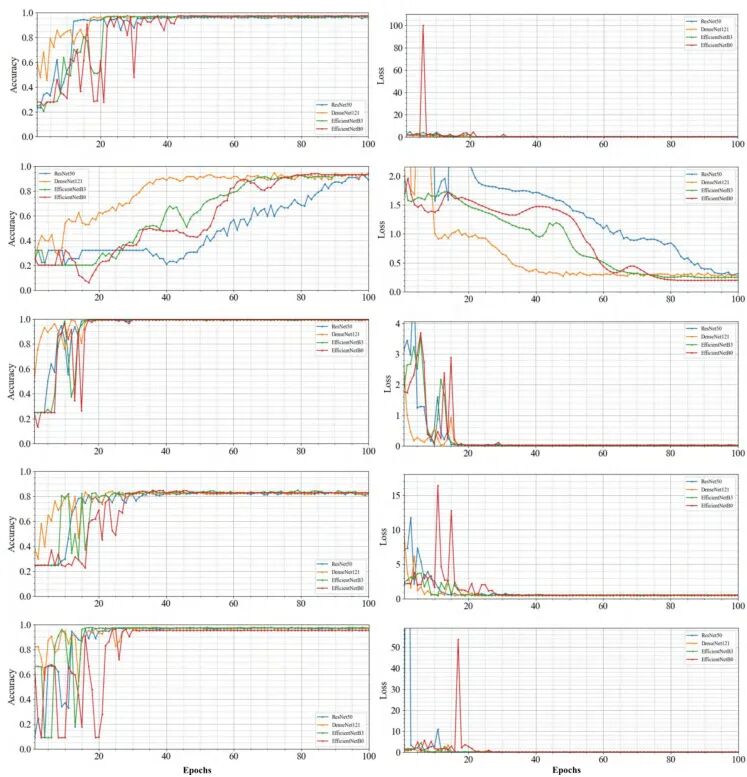

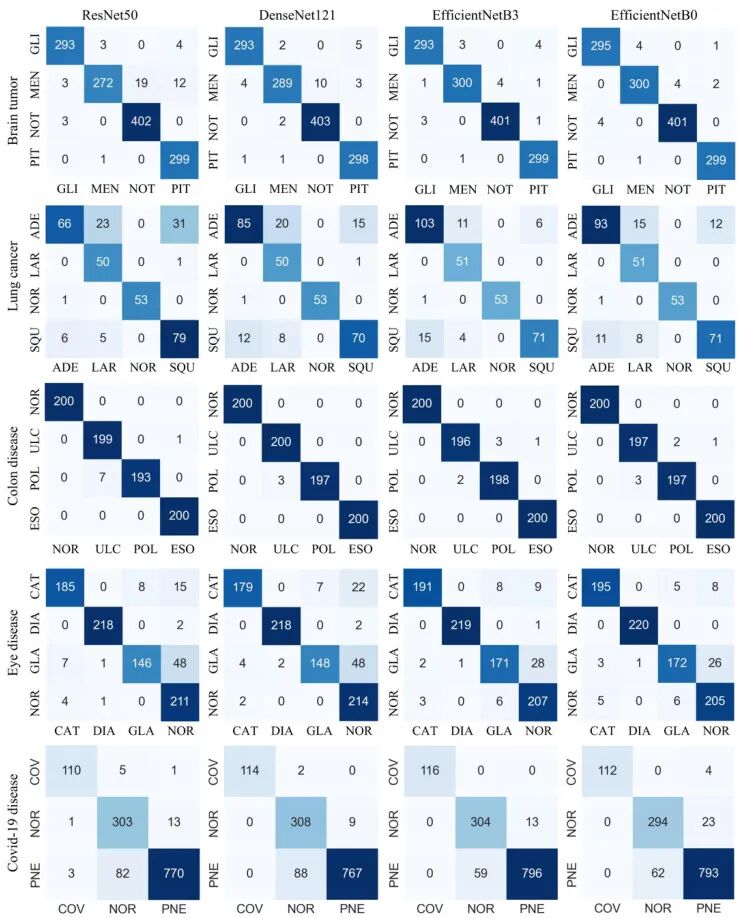

我们还展示了每个模型在周期内验证集的准确度和损失,如图8所示,以及混淆矩阵,如图9所示。

图8:不同数据集上训练的性能比较。蓝线、橙线、绿线和红线分别代表ResNet50、DenseNet121、EfficientNetB3和EfficientNetB0。每列中的五组图代表使用不同模型执行相同任务的准确度和损失。每行从上到下的图像分别属于脑肿瘤、肺癌、结肠疾病、眼病和Covid-19疾病的数据集。

图9:混淆矩阵概览。这些矩阵说明了每个模型在区分类别方面的准确性,突出了真实和错误的预测。图中的缩写如下:胶质瘤肿瘤(GLI)、脑膜瘤肿瘤(MEN)、无肿瘤(NOT)和垂体肿瘤(PIT);腺癌(ADE)、大细胞癌(LAR)、正常细胞(NOR)和鳞状细胞癌(SQU);正常(NOR)、溃疡性结肠炎(ULC)、息肉(POL)和食管炎(ESO);白内障(CAT)、糖尿病视网膜病变(DIA)、青光眼(GLA)和正常(NOR);Covid-19(COV)、正常(NOR)和肺炎(PNE)。

集成梯度映射通过为像素或特征分配权重来展示个体特征在模型决策中的影响。然而,突出特征是通过加权突出原始图像中的重要特征而增强的图像,这使这些重要区域在视觉上更加突出。

AI大模型学习路线

如果你对AI大模型入门感兴趣,那么你需要的话可以点击这里大模型重磅福利:入门进阶全套104G学习资源包免费分享!

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

这是一份大模型从零基础到进阶的学习路线大纲全览,小伙伴们记得点个收藏!

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

100套AI大模型商业化落地方案

大模型全套视频教程

200本大模型PDF书籍

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

LLM面试题合集

大模型产品经理资源合集

大模型项目实战合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献60条内容

已为社区贡献60条内容

所有评论(0)