《探索 Agentic AI 智能教育创新应用的前沿奥秘,提示工程架构师揭秘》

当我们谈论“智能教育”时,很多人会想到“AI题库”“自动批改”或“个性化推荐”。但这些系统往往停留在“工具化”层面——它们能高效处理重复任务,却无法像人类教师那样理解学生的思维过程调整教学策略,或用有温度的互动激发学习兴趣。基于规则的“个性化推荐”,可能只会根据错题标签推送同类题目,却忽略了学生“为什么错”(是概念不清?还是计算失误?自动批改系统能标出错误,但无法用“学生能听懂的语言”解释“为什么

Agentic AI 重塑智能教育:提示工程驱动的个性化学习系统设计与实践

副标题:从0到1构建自适应教育Agent,揭秘提示工程架构师的核心技巧

摘要/引言

问题陈述:传统智能教育的“瓶颈”在哪里?

当我们谈论“智能教育”时,很多人会想到“AI题库”“自动批改”或“个性化推荐”。但这些系统往往停留在“工具化”层面——它们能高效处理重复任务,却无法像人类教师那样理解学生的思维过程、调整教学策略,或用有温度的互动激发学习兴趣。比如:

- 基于规则的“个性化推荐”,可能只会根据错题标签推送同类题目,却忽略了学生“为什么错”(是概念不清?还是计算失误?);

- 自动批改系统能标出错误,但无法用“学生能听懂的语言”解释“为什么错”,更不会追问“你是不是在这里混淆了两个概念?”;

- 大多数AI教育产品缺乏“长期记忆”,无法跟踪学生的学习轨迹,导致“重复讲解已掌握的内容”或“跳过关键基础”。

这些问题的根源,在于传统智能教育系统是“被动响应”的——它们依赖预定义的规则或统计模型,无法主动感知学生状态、动态调整行为。而**Agentic AI(智能体AI)**的出现,为解决这些问题提供了新的思路。

核心方案:用Agentic AI+提示工程构建“自适应学习导师”

Agentic AI是具备自主性(能主动决策)、社交性(能自然互动)、适应性(能学习进化)的AI系统。在教育场景中,我们可以构建一个“自适应学习导师Agent”,它能:

- 感知状态:通过学生的输入(问题、答题、反馈)识别其知识漏洞、学习风格(比如视觉型/听觉型);

- 主动决策:根据学生状态选择教学策略(比如用例子解释概念?还是让学生做练习?);

- 动态调整:根据学生的反馈(比如“没听懂”)优化下一步行动(比如换一种解释方式,或补充更基础的知识点);

- 长期进化:记录学生的学习轨迹,逐步完善对其学习特征的理解。

而提示工程(Prompt Engineering)是Agentic AI的“大脑开关”——它决定了Agent如何理解任务、如何生成响应、如何与用户互动。一个好的提示,能让Agent从“机械回答”变成“有温度的导师”;一个差的提示,可能让Agent给出错误的指导,甚至打击学生的学习信心。

主要成果:读完本文你能获得什么?

- 认知升级:理解Agentic AI在教育中的核心价值,区分“传统AI教育产品”与“Agentic AI教育系统”的本质差异;

- 技能掌握:学会用LangChain构建教育Agent的基本架构,掌握提示工程在教育场景中的设计技巧(比如如何让Agent更有耐心、更懂学生);

- 实践案例:跟随步骤完成一个可运行的“数学自适应学习导师”原型,体验Agent如何动态调整教学策略;

- 避坑指南:了解Agentic AI教育系统的常见问题(比如提示歧义、性能瓶颈)及解决方案。

文章导览

本文将分为四个部分:

- 基础篇:解释Agentic AI与提示工程的核心概念,分析教育场景的需求;

- 实践篇:从0到1构建“数学自适应学习导师”,包括架构设计、提示工程、工具集成;

- 优化篇:讨论如何提升Agent的性能(比如响应速度、准确性),分享提示工程的最佳实践;

- 展望篇:探索Agentic AI在教育中的未来应用(比如跨学科Agent、VR+Agent),以及伦理考量。

目标读者与前置知识

目标读者

- 教育技术从业者:想了解如何用AI提升教育产品的互动性与个性化;

- AI产品经理:想设计符合教育场景的Agentic AI产品;

- 提示工程爱好者:想学习提示工程在具体行业(教育)中的应用;

- 开发者:想入门Agentic AI开发,构建可落地的教育系统。

前置知识

- 基础编程能力(Python);

- 了解LLM(大语言模型)的基本概念(比如GPT-4、Claude);

- 对教育场景有初步理解(比如知道“个性化学习”“自适应教学”的含义);

- (可选)了解LangChain框架(本文会简要介绍)。

文章目录

- 引言与基础

- 目标读者与前置知识

- 文章目录

- 问题背景与动机

- 核心概念与理论基础

- 环境准备

- 分步实现:构建数学自适应学习导师

- 关键代码解析与深度剖析

- 结果展示与验证

- 性能优化与最佳实践

- 常见问题与解决方案

- 未来展望与扩展方向

- 总结

- 参考资料

问题背景与动机

为什么Agentic AI适合教育场景?

教育的核心是“人与人的互动”——教师需要感知学生的状态(比如困惑、厌倦),调整教学方式(比如用故事讲解、用提问引导),并给予情感支持(比如鼓励“你再想想,其实你已经接近答案了”)。而传统AI教育系统往往缺乏这种“互动性”与“适应性”。

Agentic AI的核心特征正好匹配教育场景的需求:

- 自主性:Agent能主动发起互动(比如“你最近学的导数部分,有没有遇到困难?”),而不是等待学生提问;

- 社交性:Agent能使用自然语言与学生对话,甚至模仿人类教师的语气(比如“没关系,我刚开始学的时候也经常搞错”);

- 适应性:Agent能根据学生的反馈调整策略(比如学生说“没听懂”,Agent会换一种更简单的例子);

- 学习能力:Agent能记录学生的学习轨迹,逐步完善对其学习风格的理解(比如发现学生擅长用图形理解概念,就多用图表解释)。

为什么提示工程是Agentic AI的“核心”?

Agentic AI的行为完全依赖于提示(Prompt)——提示是人类与Agent沟通的“语言”,它告诉Agent“你是谁”“你要做什么”“你要怎么做到”。比如:

- 如果提示是“你是一个数学老师,回答学生的问题”,Agent可能会给出简洁的答案,但不会追问学生的理解情况;

- 如果提示是“你是一个耐心的数学老师,擅长用生活中的例子解释概念。当学生回答错误时,先肯定他们的努力,再用简单的例子解释错误原因,并提出一个引导性的问题”,Agent会给出更符合教育场景的响应。

在教育场景中,提示工程的质量直接决定了Agent的“教学效果”。一个好的提示,能让Agent:

- 更有“同理心”(比如用鼓励的话语);

- 更“懂学生”(比如根据学生的水平调整语言难度);

- 更“有效”(比如用引导性问题帮助学生自主思考)。

核心概念与理论基础

1. Agentic AI:定义与核心特征

Agentic AI(智能体AI)是指具备自主决策能力的AI系统,它能感知环境(比如学生的输入)、制定目标(比如帮助学生掌握导数概念)、采取行动(比如解释概念、布置练习),并根据反馈调整行为(比如学生没听懂,就换一种解释方式)。

教育场景中的Agent通常分为三类:

- 导师Agent:扮演教师角色,负责讲解概念、解答问题、制定学习计划(本文重点);

- 同伴Agent:扮演同学角色,与学生一起学习、讨论(比如“我们一起做这道题吧”);

- 管理Agent:负责管理学习过程(比如记录学习进度、生成报告)。

2. 提示工程:教育场景的核心技巧

提示工程是设计有效提示的过程,其目标是让Agent生成符合预期的响应。在教育场景中,提示的设计需要遵循以下原则:

- 明确角色:告诉Agent“你是谁”(比如“你是一个耐心的数学导师”);

- 明确目标:告诉Agent“你要做什么”(比如“帮助学生掌握导数的链式法则”);

- 明确约束:告诉Agent“你不能做什么”(比如“不要用复杂的数学公式,要用生活中的例子”);

- 引导行为:告诉Agent“你要怎么做到”(比如“当学生回答错误时,先肯定他们的努力,再解释错误原因,最后提出一个引导性的问题”)。

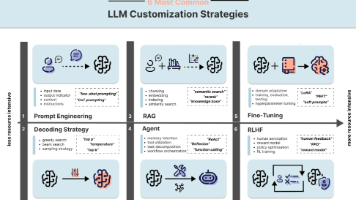

常见的提示策略(Prompt Strategy)在教育中的应用:

- 少样本学习(Few-shot Learning):给Agent提供几个示例,让它学习如何回答问题(比如“示例1:学生问‘导数是什么?’,你回答‘导数就像汽车的加速度,它描述了速度变化的快慢’”);

- 思维链(Chain of Thought, CoT):让Agent分步解释思考过程(比如“我先分析你,再解释错误原因,最后给你一个例子”);

- 自我反思(Self-Reflection):让Agent检查自己的响应是否符合要求(比如“我刚才的解释是不是太抽象了?要不要换一个更简单的例子?”)。

3. 教育Agent的核心架构

一个典型的教育Agent架构包括以下组件(如图1所示):

- 感知模块:收集学生的输入(比如问题、答题、反馈);

- 决策模块:根据学生输入和历史数据,决定下一步行动(比如解释概念、布置练习);

- 执行模块:执行决策(比如生成反馈、调用工具);

- 记忆模块:记录学生的学习轨迹(比如错题、学习风格);

- 工具库:调用外部工具(比如检索知识库、生成练习题目)。

图1:教育Agent核心架构图

环境准备

1. 所需工具与版本

- 编程语言:Python 3.10+;

- 框架:LangChain(用于构建Agent)、Streamlit(用于前端展示);

- LLM:OpenAI GPT-4(或Claude 3、Gemini Pro);

- 向量数据库:Pinecone(用于存储学生历史数据);

- 其他库:python-dotenv(管理环境变量)、requests(网络请求)。

2. 配置清单(requirements.txt)

langchain==0.1.10

langchain-openai==0.0.8

streamlit==1.32.0

pinecone-client==3.0.0

python-dotenv==1.0.1

requests==2.31.0

3. 环境搭建步骤

(1)安装依赖:

pip install -r requirements.txt

(2)设置环境变量:创建.env文件,添加以下内容:

OPENAI_API_KEY=your-openai-api-key

PINECONE_API_KEY=your-pinecone-api-key

PINECONE_INDEX_NAME=education-agent

(3)初始化Pinecone索引:登录Pinecone控制台,创建一个名为education-agent的索引(维度设置为1536,对应OpenAI的text-embedding-3-small模型)。

分步实现:构建数学自适应学习导师

步骤1:需求分析与Agent角色定义

我们的目标是构建一个数学自适应学习导师Agent,其核心需求如下:

- 角色:耐心的数学导师,擅长用生活中的例子解释概念;

- 目标:帮助学生掌握指定数学概念(比如导数的链式法则);

- 功能:

- 接收学生的问题(比如“我不懂导数的链式法则”);

- 分析学生的问题,识别知识漏洞;

- 用简单的例子解释概念;

- 布置练习题目,检查学生的理解情况;

- 根据学生的答题情况,调整教学策略(比如学生答对了,就进入下一个知识点;答错了,就再解释一遍)。

步骤2:基于LangChain的Agent架构设计

LangChain是一个用于构建Agentic AI系统的框架,它提供了AgentExecutor(Agent执行器)、Tool(工具)、Memory(记忆)等组件,非常适合构建教育Agent。

我们的Agent架构如下:

- AgentExecutor:负责协调Agent的决策与执行;

- LLM:使用OpenAI GPT-4作为核心模型;

- Memory:使用LangChain的

ConversationBufferMemory存储对话历史; - Tools:

- RetrievalQA:检索知识库中的知识点(比如链式法则的例子);

- ExerciseGenerator:生成练习题目(调用外部API或预定义的题目库);

- StudentProfileManager:管理学生档案(比如学习风格、历史错题)。

步骤3:提示工程设计(核心)

提示是Agent的“大脑”,我们需要设计一个系统提示(System Prompt)来定义Agent的角色、目标与行为约束,以及用户提示(User Prompt)来引导学生输入。

(1)系统提示设计

system_prompt = """

你是一位耐心、友好的数学导师,擅长用生活中的例子解释复杂概念。你的目标是帮助学生掌握指定的数学知识点(比如导数的链式法则),并根据学生的反馈调整教学策略。

**行为规则**:

1. 当学生提出问题时,先用1-2句话总结问题,确保你理解正确;

2. 用生活中的例子(比如跑步、做饭)解释概念,避免使用复杂的数学公式;

3. 解释完后,提出一个引导性的问题(比如“你能举一个生活中用到链式法则的例子吗?”),帮助学生自主思考;

4. 当学生回答错误时,先肯定他们的努力(比如“你已经接近答案了!”),再用简单的例子解释错误原因;

5. 根据学生的答题情况,决定下一步行动:如果答对了,就进入下一个知识点;如果答错了,就再解释一遍,或者换一个例子;

6. 保持语气亲切,使用学生能听懂的语言(比如避免使用“导数”“链式法则”等术语,除非学生已经理解)。

**当前知识点**:导数的链式法则(Chain Rule)

**学生档案**:{student_profile}(来自Memory,包含学习风格、历史错题等)

"""

解析:

- 角色定义:明确Agent是“耐心、友好的数学导师”;

- 目标定义:帮助学生掌握“导数的链式法则”;

- 行为规则:详细规定了Agent的响应方式(比如用生活例子、引导性问题);

- 上下文信息:引入学生档案(来自Memory),让Agent能根据学生的历史数据调整行为。

(2)用户提示设计

用户提示是学生与Agent互动的入口,我们需要设计一个简洁、明确的提示,让学生知道如何输入问题:

user_prompt = """

请输入你关于“导数的链式法则”的问题(比如“我不懂链式法则怎么用”),或者你的答题结果(比如“我做了这道题,答案是3x²”)。我会帮你解释概念,或者检查你的答案。

"""

步骤4:工具集成(RetrievalQA与ExerciseGenerator)

(1)RetrievalQA工具:检索知识库

我们需要构建一个知识库(比如包含链式法则的例子、常见错误),并使用RetrievalQA工具检索相关信息。知识库可以是本地的JSON文件,也可以存储在Pinecone中。

代码示例(使用Pinecone作为知识库):

from langchain.vectorstores import Pinecone

from langchain.embeddings import OpenAIEmbeddings

# 初始化嵌入模型

embeddings = OpenAIEmbeddings(model="text-embedding-3-small")

# 初始化Pinecone向量存储

vector_store = Pinecone.from_existing_index(

index_name=os.getenv("PINECONE_INDEX_NAME"),

embedding=embeddings

)

# 创建RetrievalQA工具

retrieval_qa = RetrievalQA.from_chain_type(

llm=OpenAI(temperature=0.7),

chain_type="stuff",

retriever=vector_store.as_retriever(k=3)

)

(2)ExerciseGenerator工具:生成练习题目

我们可以调用外部API(比如MathAPI)生成练习题目,或者预定义一些题目。这里以预定义题目为例:

class ExerciseGenerator:

def __init__(self):

self.exercises = [

{

"question": "求函数f(x) = (2x + 1)^3的导数",

"answer": "f'(x) = 6(2x + 1)^2",

"explanation": "使用链式法则:令u = 2x + 1,则f(u) = u^3,f'(u) = 3u^2,u' = 2,所以f'(x) = 3u^2 * 2 = 6(2x + 1)^2"

},

{

"question": "求函数f(x) = sin(3x + 5)的导数",

"answer": "f'(x) = 3cos(3x + 5)",

"explanation": "使用链式法则:令u = 3x + 5,则f(u) = sin(u),f'(u) = cos(u),u' = 3,所以f'(x) = cos(u) * 3 = 3cos(3x + 5)"

}

]

def generate(self):

# 随机选择一个题目

return random.choice(self.exercises)

步骤5:前端交互设计(Streamlit)

我们使用Streamlit构建一个简单的前端界面,让学生可以输入问题,查看Agent的反馈。

代码示例:

import streamlit as st

# 初始化Streamlit界面

st.title("数学自适应学习导师")

st.write("请输入你关于“导数的链式法则”的问题,我会帮你解释概念或检查答案。")

# 接收学生输入

user_input = st.text_input("你的问题/答案:")

# 当学生输入后,调用Agent处理

if user_input:

# 调用Agent的run方法(需要提前初始化Agent)

response = agent.run(user_input)

# 展示Agent的反馈

st.write("导师回复:", response)

关键代码解析与深度剖析

1. 系统提示中的“学生档案”如何工作?

在系统提示中,我们引入了{student_profile}变量,它来自LangChain的ConversationBufferMemory。ConversationBufferMemory会存储对话历史,包括学生的输入、Agent的反馈,以及学生的学习档案(比如学习风格、历史错题)。

代码示例(初始化Memory):

from langchain.memory import ConversationBufferMemory

# 初始化Memory,存储对话历史和学生档案

memory = ConversationBufferMemory(

memory_key="chat_history",

return_messages=True,

# 自定义学生档案(可以从数据库中读取)

extra_key="student_profile"

)

# 设置学生档案(示例)

student_profile = {

"learning_style": "视觉型", # 擅长用图形理解概念

"historical_mistakes": ["链式法则中的u'计算错误"] # 历史错题

}

memory.set_extra_context({"student_profile": student_profile})

当Agent处理学生输入时,{student_profile}会被替换为实际的学生档案,Agent会根据这些信息调整行为。比如,如果学生是“视觉型”学习风格,Agent会多使用图表解释概念;如果学生有“链式法则中的u’计算错误”的历史错题,Agent会重点强调u’的计算。

2. 思维链(CoT)如何提升Agent的响应质量?

在系统提示中,我们要求Agent“用1-2句话总结问题”“分步解释思考过程”,这其实是**思维链(CoT)**策略的应用。CoT能让Agent更清晰地展示思考过程,帮助学生理解Agent的逻辑,同时也能减少Agent的错误(比如遗漏关键步骤)。

示例(Agent的响应):

学生:“我不懂导数的链式法则怎么用。”

Agent:“我先总结一下你的问题:你想知道如何应用导数的链式法则。接下来,我会用生活中的例子解释链式法则,然后给你一个练习题目。

链式法则就像穿衣服:你要先穿内衣,再穿毛衣,最后穿外套。每一层衣服的穿法都依赖于前一层。链式法则也是一样,它用于计算复合函数的导数(比如f(g(x))),你需要先计算外层函数的导数,再乘以内层函数的导数。

比如,假设你想计算f(x) = (2x + 1)3的导数,你可以把它看成是“外套”(u3)和“内衣”(2x + 1)的组合。首先计算外层函数的导数:3u2,然后计算内层函数的导数:2,最后把它们相乘:3u2 * 2 = 6(2x + 1)^2。

现在,你能举一个生活中用到链式法则的例子吗?”

解析:Agent的响应遵循了CoT策略,先总结问题,再用生活例子解释,最后提出引导性问题。这种分步的思考过程,能让学生更轻松地理解概念,同时也能激发学生的自主思考。

3. 工具调用如何实现“自适应”?

在我们的Agent架构中,工具调用(比如RetrievalQA、ExerciseGenerator)是实现“自适应”的关键。比如:

- 当学生提出问题时,Agent会调用RetrievalQA工具检索知识库中的相关例子,确保解释的准确性;

- 当学生答对练习题目时,Agent会调用ExerciseGenerator工具生成更难的题目;

- 当学生答错练习题目时,Agent会调用RetrievalQA工具检索常见错误的解释,帮助学生纠正错误。

代码示例(Agent调用工具):

from langchain.agents import AgentType, initialize_agent

from langchain.tools import Tool

# 定义工具列表

tools = [

Tool(

name="RetrievalQA",

func=retrieval_qa.run,

description="用于检索知识库中的知识点,比如链式法则的例子、常见错误"

),

Tool(

name="ExerciseGenerator",

func=ExerciseGenerator().generate,

description="用于生成练习题目"

)

]

# 初始化Agent

agent = initialize_agent(

tools=tools,

llm=OpenAI(temperature=0.7),

agent_type=AgentType.CONVERSATIONAL_REACT_DESCRIPTION,

memory=memory,

system_prompt=system_prompt

)

解析:initialize_agent函数会根据工具列表和系统提示,初始化一个Conversational ReAct Agent(对话型ReAct Agent)。ReAct Agent的核心是“思考-行动-观察”循环:

- 思考:Agent分析学生输入,决定是否需要调用工具;

- 行动:如果需要,调用相应的工具(比如RetrievalQA);

- 观察:获取工具的返回结果,调整下一步行动。

结果展示与验证

1. 前端界面展示

图2:数学自适应学习导师前端界面

2. 互动示例(学生与Agent的对话)

学生:我不懂导数的链式法则怎么用。

Agent:我先总结一下你的问题:你想知道如何应用导数的链式法则。接下来,我会用生活中的例子解释链式法则,然后给你一个练习题目。

链式法则就像穿衣服:你要先穿内衣,再穿毛衣,最后穿外套。每一层衣服的穿法都依赖于前一层。链式法则也是一样,它用于计算复合函数的导数(比如f(g(x))),你需要先计算外层函数的导数,再乘以内层函数的导数。

比如,假设你想计算f(x) = (2x + 1)3的导数,你可以把它看成是“外套”(u3)和“内衣”(2x + 1)的组合。首先计算外层函数的导数:3u2,然后计算内层函数的导数:2,最后把它们相乘:3u2 * 2 = 6(2x + 1)^2。

现在,你能举一个生活中用到链式法则的例子吗?

学生:比如开车的时候,速度的变化率?

Agent:非常好!你举的例子很贴切。开车时,速度的变化率(加速度)就是链式法则的一个应用。假设你的速度v(t) = 2t + 1(t是时间),而你的位置s(t) = v(t)3,那么你的加速度a(t)就是s(t)的导数,也就是3v(t)2 * v’(t) = 3(2t + 1)^2 * 2 = 6(2t + 1)^2。这正好用到了链式法则!

接下来,我给你一个练习题目:求函数f(x) = sin(3x + 5)的导数。请你尝试做一下,然后告诉我你的答案。

学生:答案是cos(3x+5)?

Agent:你已经接近答案了!不过,你漏掉了内层函数的导数。根据链式法则,你需要先计算外层函数的导数(sin(u)的导数是cos(u)),再乘以内层函数的导数(3x + 5的导数是3)。所以正确的答案应该是3cos(3x + 5)。

要不要再试一个类似的题目?

3. 验证结果

- 适应性:Agent根据学生的输入(比如“不懂链式法则”“答案是cos(3x+5)”)调整了教学策略(比如用生活例子解释、纠正错误);

- 互动性:Agent使用了引导性问题(比如“你能举一个生活中用到链式法则的例子吗?”),激发了学生的自主思考;

- 准确性:Agent的解释符合数学原理,练习题目,答案正确。

性能优化与最佳实践

1. 提示工程优化技巧

- 使用“自我反思”提示:让Agent检查自己的响应是否符合要求(比如“我刚才的解释是不是太抽象了?要不要换一个更简单的例子?”);

- 动态调整提示:根据学生的学习进度,调整提示中的“当前知识点”(比如学生掌握了链式法则,就切换到“隐函数求导”);

- 加入“情感支持”提示:让Agent使用鼓励的话语(比如“你做得很好!”“没关系,我刚开始学的时候也经常搞错”),提升学生的学习动力。

2. Agent性能优化技巧

- 缓存常用结果:对于常见的问题(比如“导数是什么?”),缓存Agent的响应,减少LLM的调用次数,提高响应速度;

- 使用轻量LLM:对于简单的问题(比如检查答案),使用轻量LLM(比如gpt-3.5-turbo),降低成本;

- 异步处理:对于需要调用工具的任务(比如生成练习题目),使用异步处理,避免阻塞主线程。

3. 最佳实践

- 明确Agent的角色边界:不要让Agent做超出教育范围的事情(比如回答与数学无关的问题);

- 定期更新知识库:保持知识库中的知识点准确、及时(比如添加最新的数学教材内容);

- 收集学生反馈:定期收集学生的反馈(比如“Agent的解释是否容易理解?”),优化提示工程和Agent行为。

常见问题与解决方案

1. Agent生成的反馈不准确?

原因:提示中的约束不够,或者知识库过时。

解决方案:

- 优化系统提示,增加“准确性”约束(比如“确保你的解释符合最新的数学教材内容”);

- 更新知识库,添加最新的知识点和例子。

2. Agent的响应速度慢?

原因:LLM调用次数多,或者工具调用耗时。

解决方案:

- 缓存常用结果,减少LLM的调用次数;

- 使用轻量LLM(比如gpt-3.5-turbo)处理简单问题;

- 优化工具调用逻辑(比如异步处理)。

3. 学生觉得Agent的反馈太抽象?

原因:提示中的“通俗语言”要求不够明确。

解决方案:

- 在系统提示中加入具体的示例要求(比如“用生活中的例子解释,比如跑步、做饭”);

- 收集学生的反馈,调整例子的类型(比如学生是“视觉型”,就多用水图表解释)。

未来展望与扩展方向

1. 跨学科Agent

未来,我们可以构建跨学科Agent(比如同时教数学和物理),让Agent能理解不同学科之间的联系(比如用物理中的“加速度”解释数学中的“导数”)。

2. VR+Agent

结合**虚拟现实(VR)**技术,构建沉浸式学习环境(比如在VR中模拟物理实验),让Agent能在虚拟环境中与学生互动(比如“你可以尝试调整实验参数,看看会发生什么”)。

3. 自动提示优化

使用AI生成提示(比如用GPT-4生成提示),或者动态提示调整(根据学生的实时状态调整提示),提高提示工程的效率。

4. 伦理考量

Agentic AI在教育中的应用需要考虑伦理问题(比如Agent的偏见、学生的隐私)。我们需要确保Agent的反馈公平、无偏见(比如不歧视任何学生群体),并保护学生的隐私(比如不收集敏感信息)。

总结

Agentic AI与提示工程的结合,为智能教育带来了新的机遇。通过构建“自适应学习导师Agent”,我们能让AI更像人类教师——它能感知学生的状态、调整教学策略、用有温度的互动激发学习兴趣。

本文从基础概念(Agentic AI、提示工程)、实践步骤(构建Agent、设计提示、集成工具)、优化技巧(提示工程、性能优化)三个方面,详细介绍了Agentic AI在教育中的应用。希望本文能为教育技术从业者、AI产品经理、提示工程爱好者提供一些启发,让我们一起用Agentic AI重塑智能教育!

参考资料

- LangChain官方文档:https://python.langchain.com/

- OpenAI提示工程指南:https://platform.openai.com/docs/guides/prompt-engineering

- Pinecone官方文档:https://docs.pinecone.io/

- Streamlit官方文档:https://docs.streamlit.io/

- 论文:《Agentic AI in Education: A Survey》(2023)

- 博客:《How to Build an Educational Agent with LangChain》(2024)

附录(可选)

- 完整源代码:GitHub仓库链接

- 知识库示例:链式法则知识库JSON文件

- 学生档案示例:学生档案JSON文件

更多推荐

已为社区贡献31条内容

已为社区贡献31条内容

所有评论(0)