江大白 | 一个模型搞定九大任务!基于Qwen2.5-VL,腾讯开源像素级视觉推理模型(附论文及源码)

多模态大模型在图像整体描述和简单问答上表现出色,但在细粒度视觉任务中仍易产生“幻觉”。腾讯ARC实验室与香港理工大学联合提出突破性解决方案—UniPixel。该方法不仅能一网打尽多种视觉任务,更在10大基准测试中刷新纪录,实现了性能的“双赢”。

本文来源公众号“江大白”,仅用于学术分享,侵权删,干货满满。

原文链接:https://mp.weixin.qq.com/s/Tl1UHtyxwAF5h4a-kYgcrw

导读

多模态大模型在图像整体描述和简单问答上表现出色,但在细粒度视觉任务中仍易产生“幻觉”。腾讯ARC实验室与香港理工大学联合提出突破性解决方案—UniPixel。该方法不仅能一网打尽多种视觉任务,更在10大基准测试中刷新纪录,实现了性能的“双赢”。

目前,多模态大模型已经是开发智能助手的标配了。通过大规模对齐预训练和视觉指令微调等方式,它们在描述整张图像或回答简单问题时,表现得很出色。

然而,模型在细粒度图像理解场景中容易出现幻觉,比如区域级描述、指代表达式分割,或者推理分割任务。为什么呢?先缓一下,我们先来简单解读下上述一些词汇的概念。

-

大规模对齐预训练:让模型在海量的“图像-文本对”上进行训练。目标是学习如何将图片中的视觉内容(如物体、场景、动作)与描述它们的文字准确地关联起来。

-

视觉指令微调:使用大量人工编写的、格式为“指令-回答”的对话数据来训练模型。指令通常是各种复杂的问题或要求,回答则是符合人类交流习惯的回复。

-

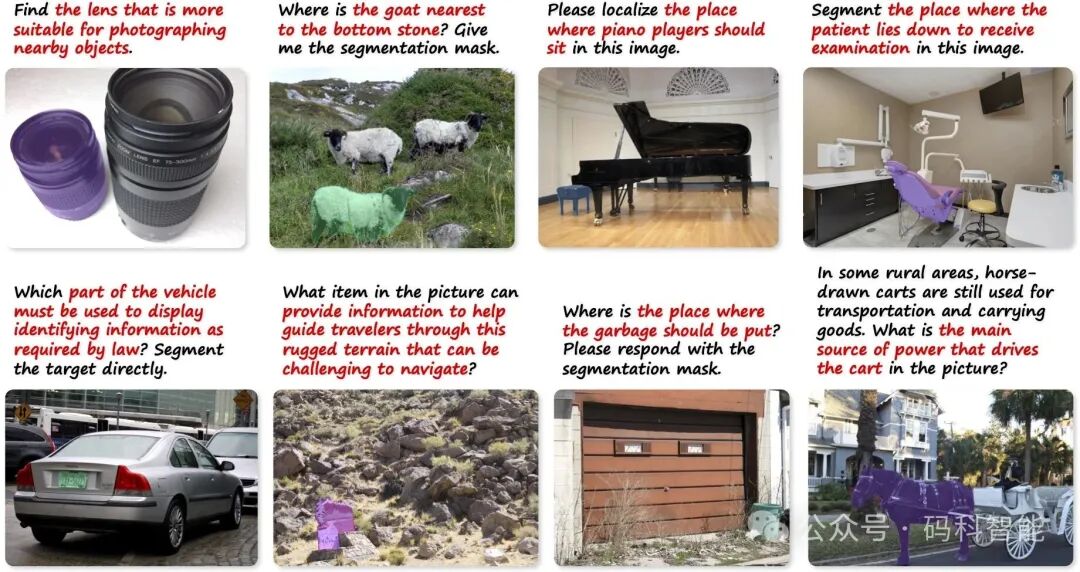

指代表达式分割:根据一句自然语言描述,在图片中精确地找出并分割出所描述的目标物体,比如描述:“分割出离窗户最近的那把椅子”。

回到正题,为什么大语言模型面向像素级别的视觉任务还不够精通?

首先,这些大模型的内部推理过程主要在粗粒度层面运行,直接感知整个内容而非对特定对象/区域进行推理,使其难以理解细粒度细节。其次,它们与用户的交互仅限于文本形式,缺乏对更直观通信形式的支持,例如绘制点/框作为参考,或用掩码表示的关键区域来支撑模型响应。

又要实现细粒度理解,又要多模态的交互方式?那升级这些模型最好的方式就是结合视觉领域中的像素级模型,如SAM、DINO。

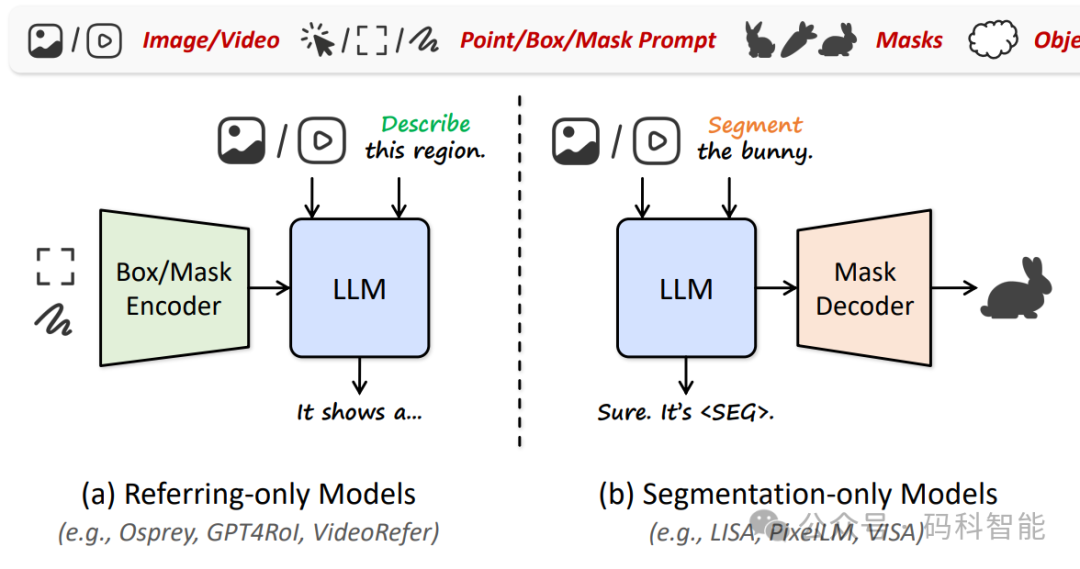

像LISA这样的模型,就是一个典型例子,它把SAM整合进来,能根据文字描述分割出物体。通过严格定义的输入/输出模板(“It's <SEG>.”)仅限于独立执行指代或分割任务,未能将细粒度感知能力整合到视觉推理中。另外,将此类细粒度感知能力与其原有的多模态推理能力相结合,导致在通用视觉理解基准测试上的性能下降。

一、腾讯开源的像素级理解模型

腾讯ARC实验室和香港理工大学的研究团队开源了一个叫UniPixel的模型,它是首个真正“端到端”(从头到尾一气呵成,不用东拼西凑)统一对象指代和掩码预测的方法。

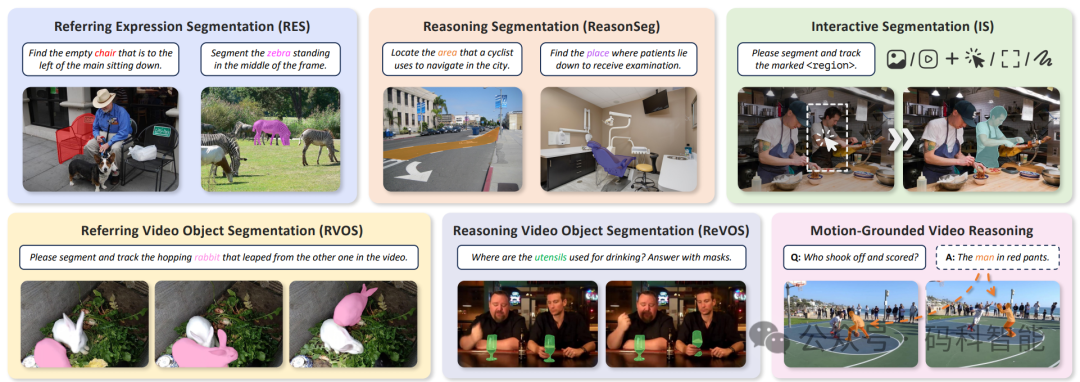

简单说,它能同时处理多种细粒度图像与视频理解任务:包括指代/推理/交互式分割、基于运动的视频推理、指代视频描述与问答,全都一网打尽。

UniPixel还能被当作“对象优先”的扩展工具:先自动分割出关键物体,然后再基于这些物体进行深入推理。

二、UniPixel是怎么做到的?

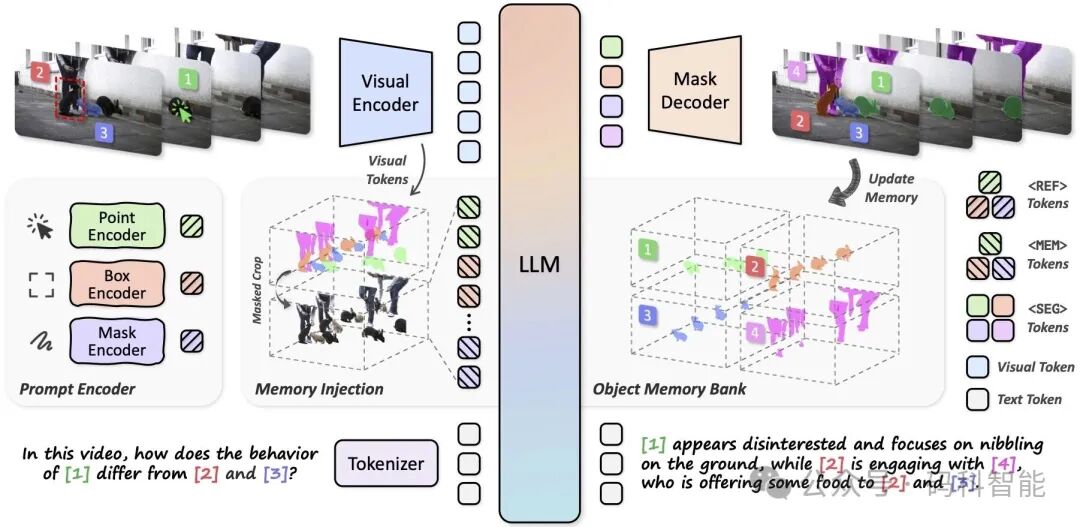

它基于Qwen2.5-VL框架构建,包括一个强大的语言模型主干和一个能处理不同分辨率输入的视觉编码器。输入一段视频或图片,加上文字提示,模型先把它们转换成“标记”,然后扔给语言模型生成回应。

为了从“粗看”升级到“像素级细看”,UniPixel加了三个聪明设计:

-

提示编码器:支持三种视觉提示,比如你点个点、画个框,或者直接用掩码标注区域。它把这些“直观输入”转换成模型能懂的语言,让互动更自然。

-

对象记忆库:像个“记忆仓库”,存储物体信息,并在生成回应时随时注入。这样,AI不会忘掉之前提到的物体,能保持连贯推理。

-

掩码解码器:专门生成时空掩码(就是视频中的动态区域分割),让AI能输出精确的物体轮廓。

为了让这些功能无缝衔接,UniPixel还扩展了模型的“词汇表”,加了像<REF>(参考提示)、<MEM>(记忆注入)和<SEG>(触发分割)这样的特殊标记。结果呢?它不只在细粒度任务上表现出色,还保持了原有的多模态推理能力,不会顾此失彼。

二、UniPixel模型效果示例

模型在涵盖9个指代/分割任务的10个公共基准上达到了最先进的性能,验证了这种统一的相互促进效应。

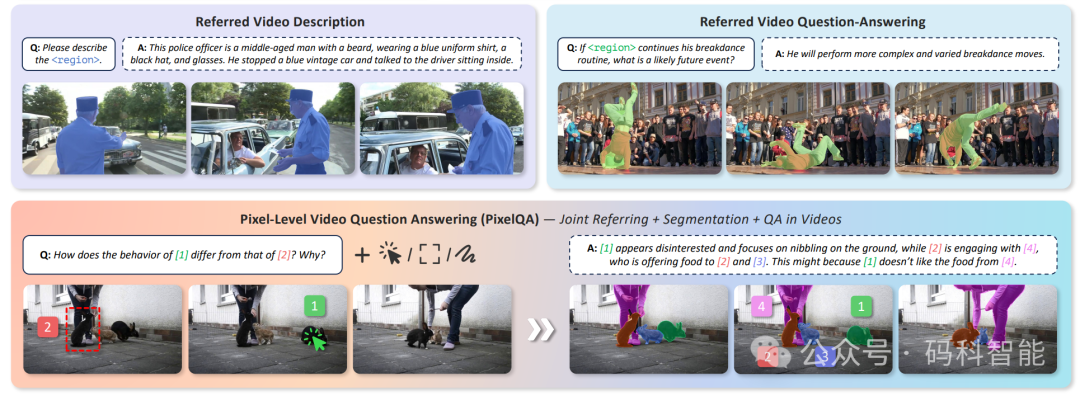

值得注意的是,在具有挑战性的视频推理分割和指代视频QA任务上,超越了参数量为7B ∼ 13B的强大同类模型。ReasonSeg 上的推理细分示例:

团队还设计了一个新颖的 PixelQA 任务,该任务同时需要引用、分割和问答功能,PixelQA(视频中的联合参考+分割+QA)的效果示例:

更详细内容可查看原论文及代码:

# 论文 https://arxiv.org/pdf/2509.18094 # 代码 https://github.com/PolyU-ChenLab/UniPixel # 项目 https://polyu-chenlab.github.io/unipixel/

THE END !

文章结束,感谢阅读。您的点赞,收藏,评论是我继续更新的动力。大家有推荐的公众号可以评论区留言,共同学习,一起进步。

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)