别让AI战略“停在试点”!AI应用架构师教你规模化复制的5方法

随着人工智能技术的飞速发展,许多企业都开启了AI战略试点项目。然而,不少企业却被困在试点阶段,无法将成功的试点经验进行规模化复制,实现AI在企业内的广泛应用和价值最大化。本文的目的就是聚焦这一困境,为企业和相关技术人员提供切实可行的规模化复制方法,帮助企业突破瓶颈,推动AI战略从试点走向全面应用。范围涵盖AI战略试点中遇到的常见问题以及解决这些问题的5种核心方法。首先,我们会介绍AI战略试点的背景

别让AI战略“停在试点”!AI应用架构师教你规模化复制的5方法

关键词:AI战略、试点、规模化复制、AI应用架构、方法

摘要:本文旨在为面临AI战略停留在试点阶段困境的相关人员,介绍由AI应用架构师总结的5种实现规模化复制的方法。通过详细阐述AI战略试点的背景、核心概念,深入讲解规模化复制的算法原理、实际操作步骤,并结合项目实战、实际应用场景等,帮助读者全面理解并掌握如何突破AI战略试点瓶颈,实现大规模应用落地。

背景介绍

目的和范围

随着人工智能技术的飞速发展,许多企业都开启了AI战略试点项目。然而,不少企业却被困在试点阶段,无法将成功的试点经验进行规模化复制,实现AI在企业内的广泛应用和价值最大化。本文的目的就是聚焦这一困境,为企业和相关技术人员提供切实可行的规模化复制方法,帮助企业突破瓶颈,推动AI战略从试点走向全面应用。范围涵盖AI战略试点中遇到的常见问题以及解决这些问题的5种核心方法。

预期读者

本文预期读者包括企业的技术决策者、AI应用架构师、数据科学家、软件开发工程师以及对AI战略落地感兴趣的相关人员。

文档结构概述

首先,我们会介绍AI战略试点的背景,帮助读者理解为什么会出现“停在试点”的情况。接着讲解AI应用架构等核心概念,通过有趣的故事和生活实例让读者清晰明白这些概念及其相互关系。之后详细阐述规模化复制的5种方法所涉及的核心算法原理、具体操作步骤,还会结合数学模型和公式进行深入讲解,并给出项目实战的代码实际案例。同时介绍AI规模化应用的实际场景,推荐相关工具和资源,探讨未来发展趋势与挑战。最后进行总结,提出思考题,还设有附录解答常见问题以及提供扩展阅读和参考资料。

术语表

核心术语定义

- AI战略:企业为了利用人工智能技术提升竞争力、创造价值,所制定的一系列长期规划和行动方案。比如一家电商企业计划利用AI技术优化商品推荐系统,提高用户购买转化率,这一系列规划就是它的AI战略。

- 试点:在全面推行某一计划或项目之前,先在小范围内进行试验,以评估可行性、发现问题并积累经验。就像新口味的饮料先在少数城市试销,看看市场反应。

- 规模化复制:将在小范围试点成功的模式、方法、技术等,大规模地应用到更广泛的范围,实现效益的大幅提升。比如一款小游戏在小部分玩家中测试成功后,推广到全球玩家。

- AI应用架构:指为了实现特定的AI应用目标,对AI系统的各个组成部分及其相互关系进行的设计和规划,类似于建造房子前的设计蓝图。

相关概念解释

- 数据标注:对原始数据进行标记,以便让AI模型能够理解数据的含义。比如给图片中的猫、狗贴上对应的标签。

- 模型训练:使用标注好的数据对AI模型进行学习,让模型能够掌握数据中的规律和特征,就像学生通过学习课本知识掌握解题方法。

缩略词列表

- AI:Artificial Intelligence,人工智能

- ML:Machine Learning,机器学习

- DL:Deep Learning,深度学习

核心概念与联系

故事引入

从前有个小镇,镇里的面包师发明了一种超级美味的面包。他先在自己的小店里试卖,结果大受欢迎,很多人都排队购买。面包师想把这种面包推广到全镇,让更多人吃到,但是他遇到了难题:不知道怎么才能在全镇的面包店做出一样美味的面包。这就好比企业在AI战略试点中取得了成功,想规模化推广却不知道怎么做。AI应用架构就像是面包师制作面包的详细配方和流程,按照这个架构,就能做出一样美味的面包,实现规模化复制。

核心概念解释(像给小学生讲故事一样)

> ** 核心概念一:AI战略**

> AI战略就像是一场大冒险的计划。想象你要去一个神秘的宝藏岛,AI战略就是你制定的从出发到找到宝藏的详细计划,包括坐什么船,带什么工具,走哪条路线等。企业制定AI战略,就是规划好怎么利用AI技术实现自己的目标,比如提高生产效率、提升客户服务质量等。

> ** 核心概念二:试点**

> 试点就像在家里做新菜的小尝试。你从美食杂志上看到一道新菜,但是不确定家人喜不喜欢,也不知道自己能不能做好,就先按照菜谱做一小份试试。如果味道不错,再考虑正式做一大桌给大家吃。企业的AI试点就是在小范围内试试AI项目,看看能不能行得通,有没有效果。

> ** 核心概念三:规模化复制**

> 规模化复制就像制作很多一模一样的玩具。假设你手工做了一个特别好玩的玩具,很多小朋友都想要。你就需要找到一种方法,能够快速做出很多同样好玩的玩具给大家。企业把在试点成功的AI项目,推广到整个公司,让各个部门都能受益,这就是规模化复制。

> ** 核心概念四:AI应用架构**

> AI应用架构就像搭建积木城堡的设计图。你想搭一个特别厉害的积木城堡,得先想好每块积木放在哪里,怎么连接,城堡有哪些部分。AI应用架构就是设计AI系统,规划好数据从哪里来,模型怎么训练,结果怎么输出,各个部分怎么协同工作。

核心概念之间的关系(用小学生能理解的比喻)

> AI战略、试点、规模化复制和AI应用架构就像一个探险小队。AI战略是队长,决定要去哪里探险(企业目标);试点是先派出去探路的小兵,看看这条路好不好走(验证AI项目可行性);规模化复制是大部队,在探路成功后,浩浩荡荡地沿着探好的路前进(全面推广AI项目);AI应用架构则是地图,指导大家该怎么走(设计AI系统的蓝图)。

> ** AI战略和试点的关系**

> 就像厨师计划做一道新菜(AI战略),先做一小份尝尝(试点),看看味道是不是符合预期,能不能达到自己想要的效果。试点是为了验证AI战略的可行性,给AI战略提供实践依据。

> ** 试点和规模化复制的关系**

> 试点就像种了一朵漂亮的花,发现它长得很好(试点成功)。规模化复制就是用同样的方法种很多这样的花,让整个花园都变得漂亮。试点成功是规模化复制的前提,只有试点可行,才能进行规模化复制。

> ** AI战略和规模化复制的关系**

> 制定AI战略是为了实现企业的大目标,而规模化复制是实现这个目标的重要手段。比如企业想通过AI提高销售额(AI战略),把成功的AI营销试点项目推广到各个地区(规模化复制),从而达到提高整体销售额的目的。

> ** AI应用架构和其他概念的关系**

> AI应用架构是实现AI战略、进行试点和规模化复制的基础。就像建造高楼大厦,AI应用架构是设计图纸,没有它,AI战略没办法落地,试点和规模化复制也无从谈起。它为试点提供具体的实施方案,为规模化复制提供可遵循的标准模式。

核心概念原理和架构的文本示意图(专业定义)

- AI战略:是企业基于对自身业务需求、市场竞争环境以及AI技术发展趋势的分析,制定的涵盖目标设定、技术选型、资源配置、实施路径等方面的长远规划。例如,一家医疗企业的AI战略可能是利用AI技术实现疾病的早期精准诊断,这就需要确定采用哪些AI技术(如深度学习的图像识别技术用于医学影像分析),投入多少人力和资金,分几个阶段推进等。

- 试点:在有限的范围内(如特定部门、特定产品线或特定区域),按照AI应用架构设计,使用真实的数据和业务场景,对AI项目进行初步实施和验证。通过试点,可以评估AI项目在实际运行中的性能、效果、对业务流程的影响等,发现潜在问题并及时调整。例如,电商企业先在一个品类的商品推荐中试点AI推荐算法,观察用户点击率、购买转化率等指标。

- 规模化复制:在试点成功验证了AI项目的可行性和价值后,将经过优化的AI应用架构、数据处理流程、模型训练方法等,推广应用到更广泛的业务范围、更多的部门或更大的用户群体。这需要解决诸如资源扩展、系统性能优化、数据一致性等问题,以确保大规模应用的稳定性和高效性。例如,将成功的AI客服试点项目推广到全公司各个客服团队。

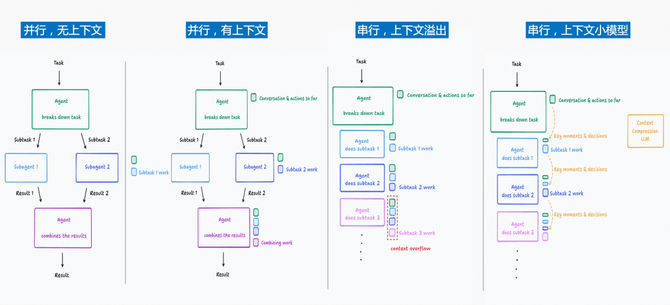

- AI应用架构:包括数据层(负责数据的采集、存储、预处理和管理,如收集电商用户的浏览记录、购买历史等数据)、模型层(选择和训练合适的AI模型,如基于深度学习的神经网络模型用于商品推荐)、应用层(将训练好的模型集成到实际业务应用中,如开发商品推荐界面供用户查看)以及管理层(对整个AI系统进行监控、评估和优化)。各层之间相互协作,数据层为模型层提供养分,模型层为应用层提供智能决策支持,管理层保障整个系统的稳定运行和持续优化。

Mermaid 流程图

核心算法原理 & 具体操作步骤

方法一:标准化数据管理

核心算法原理

在AI应用中,数据是基础。标准化数据管理就像整理图书馆的书籍,让每本书都放在合适的位置,方便查找和使用。在Python中,我们可以使用pandas库来进行数据的标准化处理。例如,对于一个包含不同格式日期的数据列,我们可以使用以下代码将其标准化为统一格式:

import pandas as pd

data = {

'date': ['1/1/2023', '2023 - 02 - 01', '03/01/2023']

}

df = pd.DataFrame(data)

df['date'] = pd.to_datetime(df['date'])

print(df)

这段代码中,pd.to_datetime函数将不同格式的日期数据转化为统一的日期时间格式,便于后续的数据分析和模型训练。

具体操作步骤

- 数据收集:确定需要收集的数据来源,比如电商平台的用户行为数据可以来自网站日志、数据库等。

- 数据清洗:去除重复数据、处理缺失值和异常值。例如,对于缺失值可以使用均值、中位数填充,或者根据其他相关数据进行预测填充。

- 数据标准化:对数据进行归一化或标准化处理,使不同特征的数据具有相同的尺度。比如使用Z - score标准化方法,公式为:z=x−μσz=\frac{x - \mu}{\sigma}z=σx−μ,其中xxx是原始数据,μ\muμ是均值,σ\sigmaσ是标准差。在Python中可以使用

sklearn.preprocessing.StandardScaler来实现:

from sklearn.preprocessing import StandardScaler

import numpy as np

data = np.array([[1], [2], [3], [4], [5]])

scaler = StandardScaler()

scaled_data = scaler.fit_transform(data)

print(scaled_data)

- 数据存储:将处理好的数据存储到合适的数据库或数据仓库中,以便后续使用。

方法二:模块化模型设计

核心算法原理

模块化模型设计就像搭建乐高积木,每个积木块都是一个独立的功能模块,可以自由组合。在机器学习中,我们可以将模型的不同部分,如特征提取、模型训练、预测等,设计成独立的模块。以Python的scikit - learn库为例,我们可以将特征提取和模型训练分开:

from sklearn.datasets import load_iris

from sklearn.feature_selection import SelectKBest, f_classif

from sklearn.model_selection import train_test_split

from sklearn.tree import DecisionTreeClassifier

iris = load_iris()

X = iris.data

y = iris.target

# 特征提取模块

selector = SelectKBest(score_func = f_classif, k = 2)

X_new = selector.fit_transform(X, y)

# 模型训练模块

X_train, X_test, y_train, y_test = train_test_split(X_new, y, test_size = 0.3)

clf = DecisionTreeClassifier()

clf.fit(X_train, y_train)

具体操作步骤

- 确定模块功能:分析AI任务,确定需要哪些功能模块,比如图像识别可能需要图像预处理、特征提取、分类模型等模块。

- 设计模块接口:明确每个模块的输入和输出,确保模块之间能够正确交互。例如,特征提取模块的输出应该是模型训练模块的合适输入格式。

- 实现模块:使用合适的编程语言和库实现每个模块,保证模块的独立性和可复用性。

- 模块集成:将各个模块按照设计好的架构组合起来,进行整体测试和优化。

方法三:自动化流程构建

核心算法原理

自动化流程构建就像设置好的自动生产线,原料放进去,成品就自动生产出来。在AI项目中,我们可以使用工具来自动化数据处理、模型训练、评估等流程。例如,使用Airflow这个工作流管理平台,我们可以定义一个简单的工作流来自动化模型训练:

from airflow import DAG

from airflow.operators.python_operator import PythonOperator

from datetime import datetime

def data_processing():

# 数据处理代码

pass

def model_training():

# 模型训练代码

pass

dag = DAG('ai_workflow', start_date = datetime(2023, 1, 1))

data_process_task = PythonOperator(task_id = 'data_processing', python_callable = data_processing, dag = dag)

model_train_task = PythonOperator(task_id ='model_training', python_callable = model_training, dag = dag)

data_process_task >> model_train_task

具体操作步骤

- 流程分析:梳理AI项目从数据到模型上线的整个流程,确定哪些环节可以自动化。

- 选择自动化工具:根据项目需求和技术栈,选择合适的自动化工具,如

Airflow、Kubeflow等。 - 定义工作流:使用自动化工具的语法定义工作流,包括任务的顺序、依赖关系等。

- 部署和监控:将定义好的工作流部署到相应的环境中,并设置监控机制,及时发现和处理异常情况。

方法四:可扩展基础设施

核心算法原理

可扩展基础设施就像搭建一个可以随时扩建的房子。随着AI项目规模的扩大,基础设施需要能够承受更多的负载。在云计算环境中,我们可以使用弹性计算资源来实现可扩展性。例如,在亚马逊云服务(AWS)中,可以使用Auto Scaling组来根据负载自动调整EC2实例的数量。当CPU使用率超过一定阈值时,自动增加实例;当负载降低时,自动减少实例。

具体操作步骤

- 评估需求:分析AI项目在数据量、计算资源、存储等方面的当前和未来需求。

- 选择云平台:根据评估结果,选择合适的云服务提供商,如AWS、阿里云、腾讯云等。

- 配置资源:在云平台上配置初始的计算、存储和网络资源,如创建EC2实例、S3存储桶等。

- 设置扩展策略:根据业务需求设置自动扩展策略,如基于CPU使用率、内存使用率等指标进行资源的自动缩放。

方法五:人才培养与团队协作

核心算法原理

人才培养与团队协作就像组建一支优秀的足球队。每个队员都要具备相应的技能,并且团队要默契配合。在AI项目中,数据科学家、工程师、业务专家等需要紧密合作。例如,数据科学家负责模型的研发,工程师负责将模型部署到生产环境,业务专家提供业务需求和数据理解。通过定期的沟通会议、代码共享平台等方式,促进团队成员之间的协作。

具体操作步骤

- 明确角色职责:清晰定义团队中每个成员的角色和职责,如数据标注员负责数据标注,算法工程师负责模型开发等。

- 培训与学习:为团队成员提供相关的培训和学习机会,如参加AI技术研讨会、在线课程学习等,提升团队整体技术水平。

- 建立沟通机制:建立定期的沟通会议、即时通讯群组等,确保团队成员之间信息畅通,及时解决问题。

- 协作工具使用:使用代码版本控制工具(如Git)、项目管理工具(如Jira)等,提高团队协作效率。

数学模型和公式 & 详细讲解 & 举例说明

数据标准化中的Z - score公式

z=x−μσz=\frac{x - \mu}{\sigma}z=σx−μ

详细讲解:这个公式用于将数据进行标准化处理,使其均值为0,标准差为1。xxx是原始数据点,μ\muμ是数据的均值,σ\sigmaσ是数据的标准差。通过这个公式,不同尺度的数据可以转化到同一尺度,便于模型更好地学习数据特征。

举例说明:假设有一组数据[1, 3, 5, 7, 9],首先计算均值μ=1+3+5+7+95=5\mu=\frac{1 + 3+5+7+9}{5}=5μ=51+3+5+7+9=5,标准差σ=(1−5)2+(3−5)2+(5−5)2+(7−5)2+(9−5)25≈2.83\sigma=\sqrt{\frac{(1 - 5)^2+(3 - 5)^2+(5 - 5)^2+(7 - 5)^2+(9 - 5)^2}{5}}\approx2.83σ=5(1−5)2+(3−5)2+(5−5)2+(7−5)2+(9−5)2≈2.83。对于数据点3,标准化后的值z=3−52.83≈−0.71z=\frac{3 - 5}{2.83}\approx - 0.71z=2.833−5≈−0.71。

模型评估中的准确率公式

Accuracy=TP+TNTP+TN+FP+FNAccuracy=\frac{TP + TN}{TP+TN+FP+FN}Accuracy=TP+TN+FP+FNTP+TN

详细讲解:在分类模型评估中,准确率用于衡量模型预测正确的比例。TPTPTP(True Positive)表示真正例,即实际为正类且被正确预测为正类的样本数;TNTNTN(True Negative)表示真负例,即实际为负类且被正确预测为负类的样本数;FPFPFP(False Positive)表示假正例,即实际为负类但被错误预测为正类的样本数;FNFNFN(False Negative)表示假负例,即实际为正类但被错误预测为负类的样本数。

举例说明:假设一个疾病诊断模型,对100个患者进行诊断,其中实际患病的有30人,未患病的有70人。模型预测正确患病的有25人(TPTPTP),预测正确未患病的有60人(TNTNTN),预测错误患病的有10人(FPFPFP),预测错误未患病的有5人(FNFNFN)。则准确率Accuracy=25+6025+60+10+5=85100=0.85Accuracy=\frac{25 + 60}{25+60+10+5}=\frac{85}{100}=0.85Accuracy=25+60+10+525+60=10085=0.85,即模型的准确率为85%。

项目实战:代码实际案例和详细解释说明

开发环境搭建

假设我们要开发一个基于AI的图像分类项目,使用Python和深度学习框架PyTorch。

- 安装Python:从Python官网下载并安装最新版本的Python。

- 安装PyTorch:根据自己的系统和CUDA版本,在PyTorch官网找到对应的安装命令。例如,对于没有CUDA的系统,可以使用以下命令安装CPU版本的PyTorch:

pip install torch torchvision torchaudio

- 安装其他依赖库:如

numpy用于数值计算,matplotlib用于数据可视化等。

pip install numpy matplotlib

源代码详细实现和代码解读

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# 数据预处理

transform = transforms.Compose([

transforms.Resize((224, 224)),

transforms.ToTensor(),

transforms.Normalize((0.485, 0.456, 0.406), (0.229, 0.224, 0.225))

])

# 加载数据集

train_dataset = datasets.ImageFolder('train_data', transform = transform)

train_loader = DataLoader(train_dataset, batch_size = 32, shuffle = True)

test_dataset = datasets.ImageFolder('test_data', transform = transform)

test_loader = DataLoader(test_dataset, batch_size = 32, shuffle = False)

# 定义模型

class ImageClassifier(nn.Module):

def __init__(self):

super(ImageClassifier, self).__init__()

self.conv1 = nn.Conv2d(3, 16, kernel_size = 3, padding = 1)

self.relu1 = nn.ReLU()

self.pool1 = nn.MaxPool2d(kernel_size = 2, stride = 2)

self.conv2 = nn.Conv2d(16, 32, kernel_size = 3, padding = 1)

self.relu2 = nn.ReLU()

self.pool2 = nn.MaxPool2d(kernel_size = 2, stride = 2)

self.fc1 = nn.Linear(32 * 56 * 56, 128)

self.relu3 = nn.ReLU()

self.fc2 = nn.Linear(128, 2)

def forward(self, x):

out = self.conv1(x)

out = self.relu1(out)

out = self.pool1(out)

out = self.conv2(out)

out = self.relu2(out)

out = self.pool2(out)

out = out.view(-1, 32 * 56 * 56)

out = self.fc1(out)

out = self.relu3(out)

out = self.fc2(out)

return out

# 初始化模型、损失函数和优化器

model = ImageClassifier()

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr = 0.001)

# 训练模型

for epoch in range(10):

running_loss = 0.0

for i, data in enumerate(train_loader, 0):

inputs, labels = data

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

running_loss += loss.item()

print(f'Epoch {epoch + 1}, Loss: {running_loss / len(train_loader)}')

# 测试模型

correct = 0

total = 0

with torch.no_grad():

for data in test_loader:

images, labels = data

outputs = model(images)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

print(f'Accuracy of the network on the test images: {100 * correct / total}%')

代码解读与分析

- 数据预处理:

transforms.Resize((224, 224))将图像大小调整为224x224像素,这是很多预训练模型要求的输入尺寸。transforms.ToTensor()将图像转化为PyTorch的张量格式。transforms.Normalize((0.485, 0.456, 0.406), (0.229, 0.224, 0.225))对图像进行标准化处理,提高模型训练效果。

- 数据集加载:

datasets.ImageFolder根据文件夹结构加载图像数据集,train_data和test_data分别是训练集和测试集的文件夹路径。DataLoader将数据集按批次加载,batch_size设置为32,训练集shuffle = True表示在每个epoch中数据会随机打乱顺序。

- 模型定义:

ImageClassifier类继承自nn.Module,定义了一个简单的卷积神经网络。conv1和conv2是卷积层,用于提取图像特征。relu1、relu2和relu3是ReLU激活函数,增加模型的非线性。pool1和pool2是池化层,用于降低数据维度。fc1和fc2是全连接层,用于分类。

- 模型训练:

- 在每个epoch中,遍历训练集,使用优化器

optimizer对模型进行训练。 optimizer.zero_grad()清空梯度,loss.backward()计算梯度,optimizer.step()更新模型参数。

- 在每个epoch中,遍历训练集,使用优化器

- 模型测试:

- 在测试集上进行测试,计算模型的准确率。

torch.max(outputs.data, 1)返回每行的最大值及其索引,索引即为预测的类别。

- 在测试集上进行测试,计算模型的准确率。

实际应用场景

- 医疗领域:通过规模化复制AI辅助诊断系统,医生可以快速获得准确的疾病诊断建议。例如,在肺部疾病诊断中,将试点成功的基于AI的X光片分析系统推广到各个医院,提高疾病诊断效率和准确性。

- 金融领域:AI风险评估模型的规模化应用可以帮助银行更准确地评估贷款风险。银行可以将在某个地区试点成功的风险评估模型推广到全国分行,降低信贷风险。

- 制造业:利用AI实现生产流程的优化和质量控制。例如,将试点成功的AI缺陷检测系统应用到整个生产线,及时发现产品缺陷,提高产品质量。

工具和资源推荐

- 数据处理工具:

pandas、numpy用于数据清洗、处理和分析;Dask用于处理大规模数据集。 - 机器学习框架:

scikit - learn适合传统机器学习算法;PyTorch和TensorFlow是深度学习框架,功能强大且灵活。 - 自动化工具:

Airflow用于工作流管理;Kubeflow专注于机器学习工作流的自动化和部署。 - 云平台:

AWS、阿里云、腾讯云提供丰富的云计算资源和AI服务。 - 学习资源:

Coursera上的“机器学习”和“深度学习专项课程”;edX的相关AI课程;书籍《Python机器学习基础教程》《深度学习》等。

未来发展趋势与挑战

未来发展趋势

- AI与边缘计算融合:将AI模型部署到边缘设备,实现数据的本地处理,减少数据传输延迟和隐私风险。例如,智能家居设备可以在本地进行图像识别,判断是否有异常情况。

- 联邦学习普及:在保护数据隐私的前提下,实现多参与方的数据联合建模。比如不同医院可以在不共享患者数据的情况下,共同训练更强大的疾病诊断模型。

- 无代码AI平台发展:降低AI应用开发门槛,让更多非技术人员也能轻松创建AI应用。

挑战

- 数据隐私与安全:随着AI应用规模扩大,数据泄露风险增加。如何在保证数据可用性的同时保护数据隐私是一大挑战。

- 模型可解释性:复杂的AI模型决策过程难以理解,在医疗、金融等关键领域,需要模型具有可解释性,以便人们信任和应用。

- 人才短缺:对AI专业人才的需求不断增长,培养足够数量和高质量的AI人才是当务之急。

总结:学到了什么?

> 我们一起学习了AI战略试点相关的重要知识。首先了解了AI战略就像企业利用AI技术的大计划,试点是这个计划在小范围的尝试,规模化复制是把成功的试点经验推广扩大,而AI应用架构是实现这一切的蓝图。

> ** 核心概念回顾:**

> - **AI战略**:是企业为利用AI技术达成目标的规划,比如电商企业计划用AI优化推荐系统。

> - **试点**:在小范围验证AI项目可行性,像新饮料先在少数城市试销。

> - **规模化复制**:将试点成功的项目推广到更广泛范围,类似小游戏从小范围测试到全球推广。

> - **AI应用架构**:设计AI系统各部分及其关系的蓝图,好比搭建积木城堡的设计图。

> ** 概念关系回顾:**

> - AI战略决定方向,试点验证可行性,规模化复制实现目标,AI应用架构贯穿始终。它们相互关联,AI战略指导试点,试点为规模化复制打基础,AI应用架构为它们提供具体方案。

思考题:动动小脑筋

> ** 思考题一:** 假如你是一家农业企业的技术负责人,你会如何运用本文的5种方法,将试点成功的AI病虫害检测项目规模化复制到整个农场?

> ** 思考题二:** 在数据标准化过程中,如果数据分布非常不均匀,除了Z - score标准化,还有哪些方法可以尝试?

附录:常见问题与解答

- 问:在自动化流程构建中,如何处理任务失败的情况?

答:可以在工作流定义中设置任务失败后的重试机制,如设置重试次数和重试间隔时间。也可以添加异常处理逻辑,将失败信息记录下来并通知相关人员进行处理。 - 问:在可扩展基础设施中,如何选择合适的云平台?

答:需要考虑云平台的功能、性能、价格、安全性、易用性以及与现有技术栈的兼容性等因素。可以对比不同云平台的服务条款、用户评价,进行实际测试后再做决策。

扩展阅读 & 参考资料

- 《人工智能:一种现代方法》,作者:Stuart Russell、Peter Norvig

- 《Python深度学习》,作者:Francois Chollet

- 相关论文:“Scaling AI Applications: Challenges and Solutions”,发表于《Journal of Artificial Intelligence Research》

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)