K8s快速部署大模型

摘要:本文介绍了在Kubernetes上部署Qwen-32B大模型的完整方案。核心包括:1)使用云原生技术解决资源消耗和启动慢问题;2)两大关键阶段(模型加载和智能流量调度);3)华为云/火山引擎一键部署方案;4)自建部署的四个核心环节(容器化、存储策略、智能网关、运维优化);5)不同场景下的决策建议。重点强调了智能网关在动态路由、并发控制和缓存优化中的关键作用,以及根据需求选择最适部署路径的方法

在Kubernetes (K8s) 上快速部署Qwen-32B这类大模型,关键在于利用云原生技术栈化解其资源消耗大、启动慢等挑战。下面我将为你梳理从快速上手指南到进阶优化的完整路径。

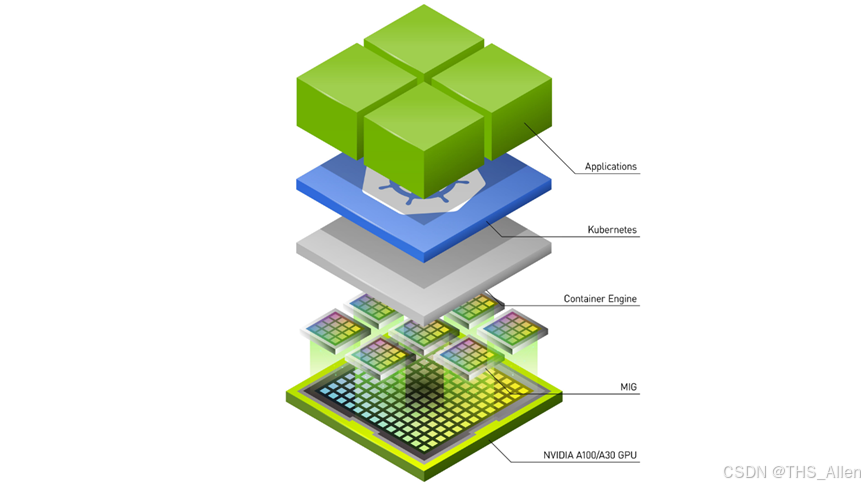

为了让你对部署流程有个全局的俯瞰,我先用一个序列图来展示其中涉及的核心组件与交互过程:

上图揭示了两个关键阶段:部署时模型文件需通过存储卷加载,运行时流量需经智能网关调度。接下来,我们深入每个环节的具体实践。

🚀 快速启动:主要云平台方案

对于希望快速验证功能的团队,主流云厂商提供了一键式解决方案。

- 华为云:通过其“解决方案实践”平台,你可以选择“快速部署Qwen-QwQ-32B模型”模板,采用一键部署(GPU版) 方式。该方案会自动化完成GPU云服务器、网络、安全组等资源的配置与部署,适合追求极致效率和对华为云生态熟悉的用户。

- 火山引擎:通过其容器服务(VKE)和持续交付(CP)产品,可以快速部署Qwen3-32B。其特色在于提供了清晰的机型推荐表(例如使用

ecs.gni3cl.11xlarge实例,配置2个GPU)。部署完成后,可以通过其API网关(APIG) 获得一个公网可访问的推理端点。

⚙️ 核心部署环节详解

若你需要更多控制权或希望在自有集群部署,需关注以下几个核心环节。

1. 容器化与资源定义

首先,需要将Qwen-32B及其推理框架(如vLLM)打包成Docker镜像,确保环境一致性。

# 示例Dockerfile概要

FROM pytorch/pytorch:2.1.0-cuda11.8-cudnn8-runtime

WORKDIR /app

COPY . .

RUN pip install -r requirements.txt # 包含vllm, transformers等

EXPOSE 8000

CMD ["python", "serve_qwen.py"]

随后,在K8s的Deployment或StatefulSet资源定义中,精确声明GPU资源至关重要。

# 示例Deployment资源片段

resources:

limits:

nvidia.com/gpu: 2 # 根据模型大小和并发需求申请

requests:

cpu: 16

memory: "100Gi"

2. 模型存储策略

Qwen-32B模型文件体积巨大,推荐使用网络存储卷(如华为云SFS Turbo、AWS EFS等)并挂载到Pod中。这样所有实例都能共享同一份模型数据,也便于模型更新。

3. 服务暴露与流量管理

这是实现高效、稳定服务的关键。如序列图所示,简单的NodePort服务仅用于测试。生产环境强烈建议采用智能模型网关方案,如作业帮团队的实践。该网关能提供:

- 动态模型路由:解析请求体中的

"model": "Qwen-32B"字段,自动路由到正确后端,无需为每个模型手动配置Ingress规则。 - 精细并发控制:采用最小连接数算法,防止单个实例因过载而发生CUDA内存溢出(OOM)错误,保障服务稳定性。

- KV Cache亲和:将同一对话会话的请求尽量路由到同一后端实例,充分利用推理过程中的KV缓存,显著降低延迟。

4. 进阶运维与优化

- 弹性伸缩:可以基于网关暴露的并发连接数等自定义指标,配置K8s的Horizontal Pod Autoscaler实现自动扩缩容。

- 监控与成本:集成Prometheus监控GPU利用率和推理延迟。在网关层集成Token计数功能,便于在多租户环境下进行成本核算。

💎 决策参考

选择哪种路径取决于你的首要目标:

- 追求速度与简便:直接使用华为云或火山引擎的一键部署方案。

- 需要控制与灵活性:在自有集群上基于 vLLM等推理框架和智能网关技术 自建部署。

- 计划大规模生产部署:必须重点考虑并实施智能流量调度和精细化的监控成本管理。

希望这份指南能帮助你清晰规划在K8s上部署Qwen-32B的路径。如果你能分享更多关于你的部署环境(例如是公有云还是私有集群)和具体业务场景(例如是高并发在线推理还是批量任务),我可以提供更有针对性的建议。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)