第13章 AI代码助手——构建你的编程伙伴

本项目基于专用代码大模型(Code LLM)开发多功能AI代码助手,支持代码生成、解释和补全三大核心功能。通过Hugging Face加载Code Llama模型,结合Gradio构建交互界面,实现代码任务的智能处理。系统采用指令模板设计Prompt,并实现流式输出优化用户体验。作为LLM在垂直领域的典型应用,该项目展示了专业代码模型在理解代码结构、逻辑和上下文方面的优势。未来可扩展方向包括模型微

1. 项目概述

软件开发是LLM应用最成功的领域之一。从GitHub Copilot到各种IDE内置的AI插件,AI代码助手正在深刻地改变开发者的工作流。本项目将带你深入这一领域,学习如何利用为代码任务专门优化的Code LLM,构建一个属于你自己的AI代码助手。

核心目标:

开发一个能够执行多种代码相关任务的命令行或Web应用,主要包括:

- 代码生成:根据自然语言描述生成代码片段。

- 代码解释:用通俗的语言解释一段给定的代码。

- 代码补全:在不完整的代码后面,智能地补全后续代码。

你将学习到的核心技术:

- Code LLM的应用:了解专门用于代码任务的LLM(如Code Llama, DeepSeek Coder)的特点和使用方法。

- 代码任务的Prompt Engineering:学习如何为代码生成、解释、补全等不同任务设计高效的Prompt模板。

- 流式输出 (Streaming):掌握如何实现打字机效果的流式输出,极大提升用户体验。

- 与IDE集成(概念):探讨将此类代码助手封装成VSCode等主流IDE插件的基本思路。

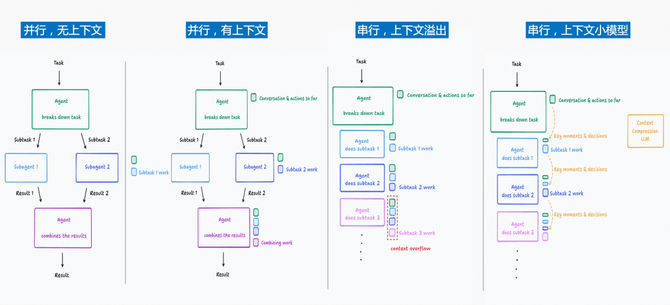

项目整体流程图

2. 核心概念:Code LLM

虽然通用的LLM(如GPT-4)也具备强大的代码能力,但Code LLM是为软件开发场景“特训”的模型,它们在代码数据上进行了大量的预训练和微调,因此在代码任务上通常表现更佳、效率更高。

Code LLM的特点:

- 海量代码语料:它们的训练数据中包含数万亿行的开源代码,覆盖了几十种编程语言。

- 理解代码结构:它们不仅能理解代码的语法,还能在一定程度上理解代码的逻辑、上下文和依赖关系。

- 支持特定任务:许多Code LLM针对特定任务进行了优化,例如:

- 代码补全 (Infilling):模型能够根据光标前后的代码,智能地在中间插入缺失的代码块。

- 指令遵循 (Instruction Following):模型能够很好地理解“请用Python写一个快速排序函数”这类自然语言指令。

代表模型:

- Code Llama (Meta):基于Llama 2构建,是目前最主流的开源Code LLM系列,有多种尺寸(7B, 13B, 34B, 70B)和针对不同语言(Python)或任务(指令微调)的特定版本。

- DeepSeek Coder (深度求索):由国内团队开发的强大Code LLM,在多个代码能力榜单上名列前茅。

- StarCoder (Hugging Face):由Hugging Face和ServiceNow联合发起的大型开源项目。

3. 项目实战:构建多功能代码助手

3.1 环境准备

我们将使用Hugging Face加载Code Llama模型,并使用Gradio构建界面。

!pip install -q transformers torch accelerate bitsandbytes gradio

3.2 加载Code Llama模型

我们将选择一个经过指令微调的Code Llama版本,因为它更擅长遵循我们的指令。

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM, TextStreamer

# 我们选择一个较小的7B指令微调模型作为示例

model_id = "codellama/CodeLlama-7b-Instruct-hf"

# 注意:Code Llama的权重需要通过Hugging Face的申请才能获得访问权限

# 请确保你已登录Hugging Face CLI并有权限访问该模型

# huggingface-cli login

tokenizer = AutoTokenizer.from_pretrained(model_id)

model = AutoModelForCausalLM.from_pretrained(

model_id,

torch_dtype=torch.float16,

device_map="auto",

)

# 用于实现流式输出的工具

streamer = TextStreamer(tokenizer, skip_prompt=True)

3.3 设计任务Prompt模板

为不同的任务设计清晰的Prompt至关重要。Code Llama的指令模板通常遵循特定的格式。

def get_codellama_prompt(task, user_input):

"""根据任务类型和用户输入,生成符合Code Llama指令模板的Prompt。"""

if task == "代码生成":

# 对于代码生成,直接将用户的自然语言描述作为指令

prompt = f"<s>[INST] {user_input} [/INST]"

elif task == "代码解释":

prompt = f"<s>[INST] 请用中文解释以下这段代码的功能:\n```\n{user_input}\n```[/INST]"

elif task == "代码补全":

# Code Llama原生支持使用<FILL_ME>标记进行补全,但更简单的方式是直接让它续写

prompt = f"<s>[INST] 请补全以下代码:\n```\n{user_input} [/INST]"

else:

raise ValueError("未知的任务类型")

return prompt

3.4 构建推理与流式输出函数

这个函数将接收任务类型和用户输入,然后以流式的方式返回模型的生成结果。

import threading

def generate_code(task, user_input):

prompt = get_codellama_prompt(task, user_input)

inputs = tokenizer(prompt, return_tensors="pt").to(model.device)

# 使用线程来运行生成过程,以便Gradio界面可以实时更新

generation_kwargs = {

"input_ids": inputs["input_ids"],

"streamer": streamer,

"max_new_tokens": 512,

"do_sample": True,

"temperature": 0.1,

"top_p": 0.95

}

thread = threading.Thread(target=model.generate, kwargs=generation_kwargs)

thread.start()

# Gradio的流式输出需要一个生成器函数

# 我们通过TextStreamer的输出来模拟这个过程

# 这是一个简化的实现,实际应用中需要更健壮的队列机制

# 这里我们直接返回一个提示信息,实际的流式输出会显示在console中

# 要在Gradio中实现真正的流式输出,需要使用 `yield` 关键字

return "生成过程已开始,请在Console中查看流式输出..."

# --- 测试一下 ---

# print("--- 代码生成测试 ---")

# generate_code("代码生成", "用Python写一个函数,计算斐波那契数列的第n项")

# print("\n--- 代码解释测试 ---")

# code_to_explain = "def fib(n):\n a, b = 0, 1\n for _ in range(n):\n a, b = b, a + b\n return a"

# generate_code("代码解释", code_to_explain)

注意: 在Gradio中实现真正的流式输出需要将函数改造为一个Python生成器(使用yield)。上面的代码为了简化,只在控制台(Console)打印流式结果。一个完整的Gradio流式实现会更复杂一些。

3.5 使用Gradio构建交互界面

import gradio as gr

# 这是一个简化的界面,实际的流式输出需要更复杂的Gradio实现

def gradio_interface(task, user_input):

# 在实际应用中,这里会调用一个能yield结果的函数

# 为了演示,我们直接调用上面的函数

print(f"\n--- 任务: {task} ---")

return generate_code(task, user_input)

iface = gr.Interface(

fn=gradio_interface,

inputs=[

gr.Radio(["代码生成", "代码解释", "代码补全"], label="选择任务"),

gr.Code(label="输入自然语言描述或代码", language="python")

],

outputs=gr.Markdown(label="结果"),

title="💻 Code Llama 代码助手",

description="选择一个任务,然后输入你的需求。流式结果将打印在运行程序的控制台中。",

allow_flagging="never"

)

# 启动应用

iface.launch(share=True)

4. 总结与展望

本项目带你构建了一个基础但功能完备的AI代码助手,让你亲身体验了Code LLM的强大能力。这是将LLM应用于专业垂直领域的典型范例。

可以探索的扩展方向:

- 微调自己的Code LLM:如果你有自己团队的代码库,可以收集高质量的代码数据,对Code Llama进行微调,使其更懂你的代码风格和项目规范,成为一个真正的“团队专家”。

- 构建VSCode插件:学习VSCode插件开发,将你的代码助手能力集成到IDE中,实现更无缝的开发体验。这通常涉及到使用TypeScript/JavaScript与Language Server Protocol (LSP)。

- 代码库级别的问答:结合RAG技术(参考教程九),让AI能够理解整个代码仓库的上下文,回答“我们项目中的认证逻辑是如何实现的?”这类复杂问题。

- AI驱动的软件测试:探索使用LLM自动生成单元测试、定位Bug,甚至进行代码重构,进一步提升软件开发的自动化水平。

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)