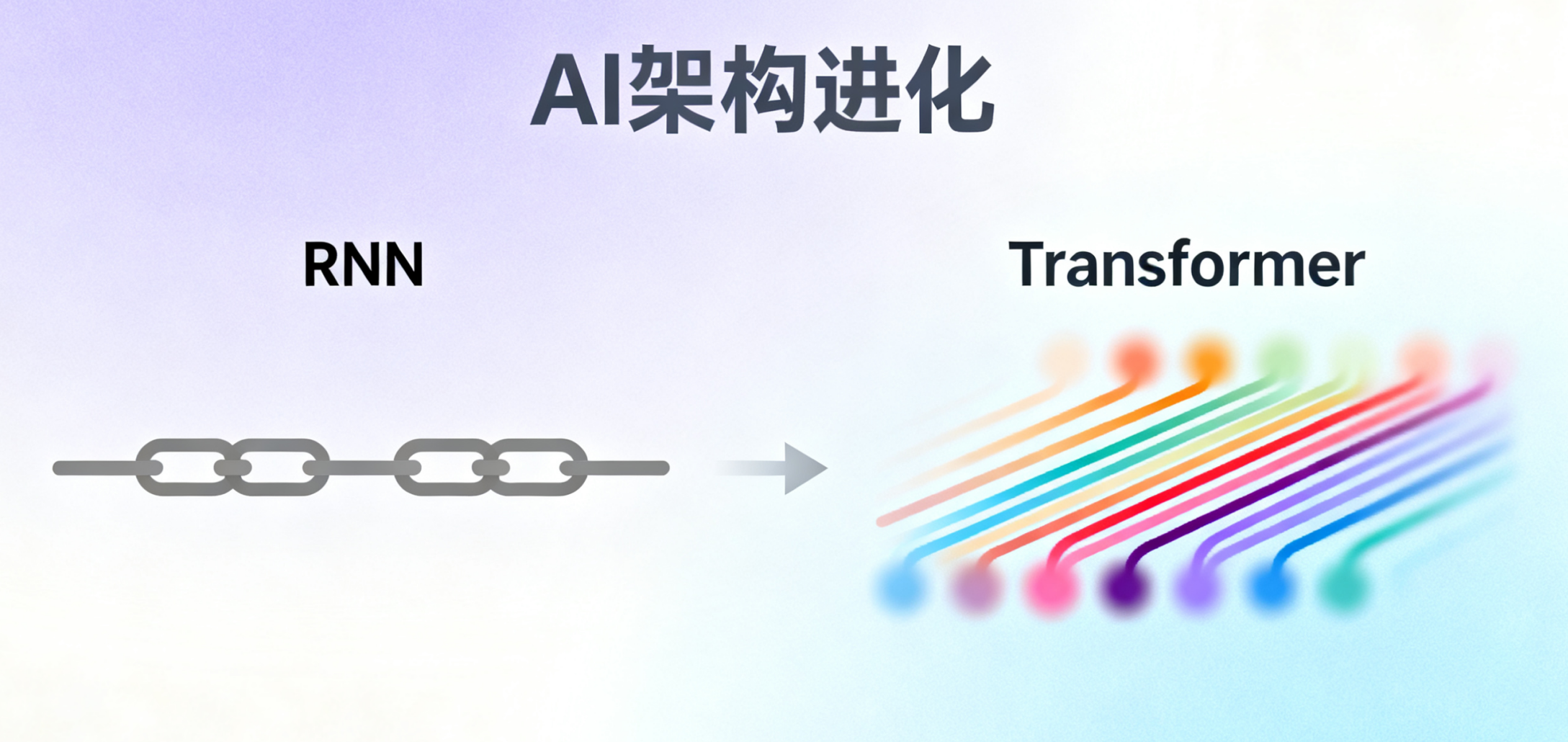

AI架构进化:从RNN困局到Transformer破壁,一文解析注意力机制如何重塑NLP

本文回顾了Transformer架构如何突破RNN在NLP领域的技术瓶颈。传统RNN因串行计算和长程依赖问题导致性能受限,而Transformer通过自注意力机制实现并行化处理,直接建模全局语义关联。文章详细解析了自注意力、多头注意力、位置编码等核心机制,以及编码器-解码器结构和残差连接等工程实现。Transformer不仅显著提升NLP任务性能,还催生了预训练范式和大模型时代,其通用架构更被成功

在 2017 年之前的自然语言处理领域,NLP 始终深陷 “瓶颈时代”:彼时主流的 RNN 等模型,只能以 “序列串行” 的方式逐词处理文本,就像人逐字阅读却无法同时把握全文逻辑,既难以捕捉长文本中的远距离语义关联,又受限于串行效率无法处理大规模数据 —— 这与人类理解语言时 “整体并行” 的思维模式形成尖锐矛盾,成为制约技术突破的关键壁垒。

直到 Transformer 架构横空出世,其创新的注意力机制彻底打破这一僵局,不仅实现了文本的并行化处理,还能精准聚焦关键语义信息,直接开启了大模型驱动的 NLP 新时代。本文将带您回溯这场关键的技术革命,从 RNN 的固有困境切入,深入解析 Transformer 如何凭借注意力机制破局,完整呈现 NLP 领域从瓶颈到爆发的进化脉络。

一、困局之殇:RNN时代的技术瓶颈

1、RNN的工作原理与理想愿景

-

序列处理的直觉:模拟人类阅读的"从左到右"过程

-

代码示例:简单RNN的向前传播过程

class SimpleRNN: def step(self, x, h_prev): # h_t = tanh(W_xh * x_t + W_hh * h_{t-1} + b) h_new = np.tanh(np.dot(self.W_xh, x) + np.dot(self.W_hh, h_prev) + self.b) return h_new -

理论优势:能够处理变长序列,具备"记忆"能力

2、三大致命瓶颈

-

梯度消失/爆炸问题:长距离依赖的"记忆衰退"

# 梯度传播的数学本质:连乘效应 gradient = ∂L/∂h_t ≈ ∏_{k=1}^{t} ∂h_k/∂h_{k-1} # 连乘导致梯度指数级衰减/增长 -

并行化困境:序列计算的"锁步限制"

# RNN必须顺序计算,无法并行 for t in range(sequence_length): # 这个循环无法并行化! h_t = rnn_cell(x_t, h_{t-1}) -

长程依赖失效:上下文理解的"近视眼"问题

例句:"这部电影虽然开头很无聊,中间部分也显得拖沓,但最终的剧情反转和深刻主题表达让我觉得______。" RNN可能已经"忘记"了开头的信息,无法做出准确预测

3、改良尝试与根本局限

-

LSTM/GRU:门控机制的"补丁式"优化

为解决长程记忆衰退问题,1997 年诞生的 LSTM(长短期记忆网络)引入了创新的门控机制,通过 “遗忘门”“输入门”“输出门” 的协同作用,精准控制信息的保留、更新与输出。例如,在处理 “电影评价” 类长句时,遗忘门可筛选并丢弃无关的细节描述,输入门则将 “剧情反转” 等关键信息存入长期记忆,输出门再按需提取信息用于预测。这种设计大幅提升了模型对长序列的建模能力,成为 2017 年前 NLP 任务的主流选择。

2014 年推出的 GRU(门控循环单元)则对 LSTM 进行了轻量化改良,将遗忘门与输入门合并为 “更新门”,同时简化了内部状态结构,在保持相近性能的前提下减少了约 1/3 的参数数量,降低了计算成本。无论是 LSTM 还是 GRU,本质都是通过精细化的信息筛选机制 “延缓” 记忆衰退,却未能改变梯度依赖时序传播的本质 —— 当序列长度突破临界值(如超过 100 个时间步),梯度消失问题仍会显现。

-

双向RNN:前后文信息的"折中方案"

针对单方向序列处理无法兼顾上下文的问题,双向 RNN 通过并行堆叠 “正向层” 与 “反向层” 实现信息互补:正向层从左到右处理序列捕捉前文信息,反向层从右到左处理序列捕捉后文信息,最终将两层输出拼接作为当前时刻的状态。例如在词性标注任务中,模型可同时利用 “前面是动词” 和 “后面是名词” 的信息,更准确地判断中间词语的词性。

但双向 RNN 的局限性同样明显:

其一,它仍需按时序逐步计算,并行化困境未得到解决。

其二,反向层的计算必须等待整个序列输入完成,导致推理延迟显著增加。

其三,对于超长篇幅文本,双向传播的梯度依然会面临衰减问题,无法实现真正的全局语义关联建模。

-

根本问题:序列计算的底层范式限制无法彻底解决

无论是 LSTM 的多门控设计,还是双向 RNN 的双方向传播,本质都是在 “序列串行计算” 的框架内做局部优化。这些方案能缓解梯度消失、增强记忆能力,却始终无法突破两个核心限制:

- 并行性缺失:所有改良模型仍依赖 “前一时刻状态决定当前计算” 的逻辑,无法像 CNN 那样对输入数据进行批量并行处理,计算效率受限于序列长度;

- 全局依赖弱:即使通过门控保留了部分长程信息,模型仍需通过链式传播间接获取远距离关联,无法像人类阅读那样直接 “跳跃” 到关键上下文,对复杂语义的捕捉能力存在天然瓶颈。

二、破壁之道:Transformer的革命性创新

1、核心洞察:注意力机制的灵感来源

Transformer 的突破,始于对 “人类语言理解方式” 的精准模仿 —— 它摒弃了 RNN “逐词串行” 的思维,用注意力机制实现了类似人类的 “全局语义关联” 能力。

-

人类认知的启示:我们如何同时关注句子的不同部分

当我们阅读 “这部电影虽然开头无聊,但结尾的反转很精彩” 时,不会逐词孤立理解,而是会主动将 “结尾的反转” 与 “开头无聊” 关联,判断出 “转折关系”;同时忽略 “的”“很” 等虚词,聚焦关键信息。这种 “选择性关注 + 全局关联” 的能力,正是注意力机制的设计原型。

-

从编码器-解码器注意力到自注意力:关键的思想跃迁

在 Transformer 之前,注意力机制已用于机器翻译(如 Seq2Seq 模型),但仅能实现 “编码器输出(源语言)” 与 “解码器输入(目标语言)” 的跨序列关联(即 “编码器 - 解码器注意力”);而 Transformer 创新提出的自注意力(Self-Attention),允许同一序列内的每个词与其他所有词建立关联 —— 比如 “结尾的反转” 可直接与 “开头无聊” 计算关联度,无需依赖中间词的 “接力传递”,彻底打破了序列顺序的限制。

-

范式转换:从"序列处理"到"关系挖掘"

RNN 的核心是 “按时间步更新记忆”,本质是 “处理序列的先后顺序”;而 Transformer 的核心是 “计算序列内所有词的语义关联强度”,本质是 “挖掘文本的内在关系网络”。这种范式转变,让模型首次实现了文本的并行化处理(无需等待前一个词计算完成),同时解决了长程依赖问题。

2、自注意力机制:Transformer的灵魂

自注意力是 Transformer 的 “核心引擎”,其本质是通过 “查询 - 键 - 值” 的逻辑,量化序列内词与词的关联度,再按关联度加权整合信息 —— 类似信息检索中 “用关键词(查询)匹配文档(键),再获取文档内容(值)” 的过程。

- Query-Key-Value(QKV)模型:信息检索的完美类比

为了让模型 “自主判断该关注什么”,自注意力为每个词向量(如 “反转”)生成三个角色向量:

- Query(查询向量):代表 “当前词需要什么信息”(比如 “反转” 的 Query 会倾向于寻找 “转折词”“评价词”);

- Key(键向量):代表 “其他词能提供什么信息”(比如 “虽然” 的 Key 会标注 “转折信号”,“无聊” 的 Key 会标注 “负面评价”);

- Value(值向量):代表 “其他词的实际语义内容”(比如 “无聊” 的 Value 就是其完整语义向量)。

通过计算 Query 与所有 Key 的相似度(关联度),再用相似度加权 Value,就能得到当前词的 “全局语义整合结果”。

- 简单自注意力的直观实现(Python 示例)

以下代码用 NumPy 模拟自注意力的核心逻辑,清晰展示 “关联计算 - 加权整合” 过程:

import numpy as np

def softmax(x):

# 简化版softmax,将相似度转化为0-1的权重

exp_x = np.exp(x - np.max(x, axis=-1, keepdims=True)) # 防止数值溢出

return exp_x / np.sum(exp_x, axis=-1, keepdims=True)

class SimpleSelfAttention:

def __init__(self, d_model):

self.d_model = d_model # 词向量维度

# 初始化QKV变换矩阵(实际应用中会通过训练优化)

self.W_q = np.random.randn(d_model, d_model) * 0.01

self.W_k = np.random.randn(d_model, d_model) * 0.01

self.W_v = np.random.randn(d_model, d_model) * 0.01

def forward(self, x):

# x: 输入序列,形状为[seq_len, d_model](seq_len=序列长度)

seq_len = x.shape[0]

# 1. 生成QKV向量

Q = np.dot(x, self.W_q) # [seq_len, d_model]

K = np.dot(x, self.W_k) # [seq_len, d_model]

V = np.dot(x, self.W_v) # [seq_len, d_model]

# 2. 计算注意力得分(Q与K的相似度)

scores = np.dot(Q, K.T) # [seq_len, seq_len],scores[i,j]代表第i个词与第j个词的关联度

# 3. 缩放得分(避免维度过高导致softmax后权重两极分化)

scores = scores / np.sqrt(self.d_model)

# 4. 计算注意力权重(归一化到0-1)

attn_weights = softmax(scores) # [seq_len, seq_len],权重和为1

# 5. 加权整合Value(按关联度提取关键信息)

output = np.dot(attn_weights, V) # [seq_len, d_model]

return output, attn_weights

# 测试:处理简单序列(假设每个词已转化为5维向量)

x = np.random.randn(4, 5) # 4个词,每个词5维向量

attn = SimpleSelfAttention(d_model=5)

output, weights = attn.forward(x)

print("注意力权重矩阵(每行代表一个词的关注分布):")

print(weights.round(3)) # 可看到每个词对其他词的关注程度- 工程化实现:缩放点积注意力(PyTorch 版)

实际应用中,自注意力需处理批量数据(多句子并行)和掩码(如屏蔽未来词),以下是工业界常用的 PyTorch 实现:

import torch

import torch.nn as nn

import math

class ScaledDotProductAttention(nn.Module):

def __init__(self):

super().__init__()

def forward(self, Q, K, V, mask=None):

"""

Args:

Q: [batch_size, num_heads, seq_len_q, d_k](批量大小,注意力头数,查询序列长度,每个头的维度)

K: [batch_size, num_heads, seq_len_k, d_k]

V: [batch_size, num_heads, seq_len_v, d_v](seq_len_k=seq_len_v)

mask: [batch_size, 1, seq_len_q, seq_len_k](掩码,用于屏蔽无效位置,如padding或未来词)

Returns:

output: [batch_size, num_heads, seq_len_q, d_v](注意力输出)

attn_weights: [batch_size, num_heads, seq_len_q, seq_len_k](注意力权重)

"""

d_k = Q.size(-1)

# 1. 计算点积得分

scores = torch.matmul(Q, K.transpose(-2, -1)) # [batch_size, num_heads, seq_len_q, seq_len_k]

# 2. 缩放(关键步骤,避免d_k过大导致scores过大,softmax后权重集中在少数词)

scores = scores / math.sqrt(d_k)

# 3. 应用掩码(屏蔽的位置设为-1e9,softmax后权重趋近于0)

if mask is not None:

scores = scores.masked_fill(mask == 0, -1e9)

# 4. 计算注意力权重并加权Value

attn_weights = torch.softmax(scores, dim=-1) # 按K的维度归一化

output = torch.matmul(attn_weights, V) # 加权整合Value

return output, attn_weights3、多头注意力:并行化的"多视角理解"

自注意力虽能捕捉全局关联,但单一注意力头只能关注 “一种语义关系”(如仅关注转折关系);而多头注意力(Multi-Head Attention) 通过并行设置多个注意力头,让模型从 “多视角” 理解文本,大幅提升语义捕捉能力。

- 设计理念:用 “分工协作” 提升理解深度

人类理解一句话时,会同时关注 “语法关系”(如主谓宾)、“语义关系”(如因果、转折)、“情感倾向”(如褒贬)等多个维度;多头注意力正是模仿这一过程 —— 每个注意力头独立学习一种 “关注维度”,比如:

- 头 1:专注捕捉语法结构(如 “电影” 与 “精彩” 的主谓关系);

- 头 2:专注捕捉逻辑关系(如 “虽然” 与 “但” 的转折关系);

- 头 3:专注捕捉情感评价(如 “无聊” 的负面、“精彩” 的正面);

最后将所有头的结果整合,得到更全面的语义表示。

- 工作机制:“拆分 - 并行 - 合并” 的三步流程

多头注意力的核心是 “将 QKV 按头拆分,独立计算后再合并”,确保每个头的关注点不重叠,具体流程如下(结合 PyTorch 代码解读):

class MultiHeadAttention(nn.Module):

def __init__(self, d_model=512, num_heads=8):

super().__init__()

self.d_model = d_model # 总词向量维度(需能被num_heads整除)

self.num_heads = num_heads # 注意力头数(Transformer默认8头)

self.d_k = d_model // num_heads # 每个头的维度(512//8=64)

# 1. 初始化QKV的线性变换层(所有头共享变换,但拆分后独立计算)

self.W_q = nn.Linear(d_model, d_model) # 将词向量映射为Q(总维度不变)

self.W_k = nn.Linear(d_model, d_model) # 映射为K

self.W_v = nn.Linear(d_model, d_model) # 映射为V

self.W_o = nn.Linear(d_model, d_model) # 合并多头结果的输出层

# 引入缩放点积注意力模块

self.attention = ScaledDotProductAttention()

def forward(self, Q, K, V, mask=None):

batch_size = Q.size(0) # 批量大小(如一次处理32个句子)

# 2. 第一步:线性变换 + 按头拆分(关键操作)

# Q原形状:[batch_size, seq_len_q, d_model] → 拆分后:[batch_size, num_heads, seq_len_q, d_k]

Q = self.W_q(Q).view(batch_size, -1, self.num_heads, self.d_k).transpose(1, 2)

K = self.W_k(K).view(batch_size, -1, self.num_heads, self.d_k).transpose(1, 2)

V = self.W_v(V).view(batch_size, -1, self.num_heads, self.d_k).transpose(1, 2)

# 解释:transpose(1,2)将“头数”维度提前,确保每个头可并行计算

# 3. 第二步:多个头并行计算注意力(每个头独立输出结果)

# 每个头的输出形状:[batch_size, 1, seq_len_q, d_k] → 所有头合并:[batch_size, num_heads, seq_len_q, d_k]

attn_output, attn_weights = self.attention(Q, K, V, mask)

# 4. 第三步:合并多头结果(恢复为原维度)

# 先将“头数”维度后置:[batch_size, seq_len_q, num_heads, d_k]

# 再拼接所有头:[batch_size, seq_len_q, num_heads*d_k] = [batch_size, seq_len_q, d_model]

attn_output = attn_output.transpose(1, 2).contiguous().view(batch_size, -1, self.d_model)

# 最后通过线性层整合信息,输出最终结果

output = self.W_o(attn_output) # [batch_size, seq_len_q, d_model]

return output, attn_weights

# 测试:模拟输入(32个句子,每个句子10个词,每个词512维向量)

Q = torch.randn(32, 10, 512)

K = V = Q # 自注意力中Q=K=V(同一序列)

multi_attn = MultiHeadAttention(d_model=512, num_heads=8)

output, weights = multi_attn.forward(Q, K, V)

print("多头注意力输出形状:", output.shape) # 输出:torch.Size([32, 10, 512])(与输入维度一致)

print("注意力权重形状:", weights.shape) # 输出:torch.Size([32, 8, 10, 10])(8个头,每个头10×10权重矩阵)- 核心价值:效率与效果的双重提升

多头注意力的优势不仅在于 “多视角理解”,还在于并行化效率:多个头的计算可在 GPU 上同步进行,无需像 RNN 那样串行等待;同时,每个头的维度(d_k)仅为总维度(d_model)的 1/num_heads,大幅降低了单头的计算复杂度(计算量与 num_heads 成反比)。这种 “并行化 + 多视角” 的设计,让 Transformer 在效率和效果上同时超越了 RNN。

三、架构详解:Transformer的工程实现

Transformer 的革命性不仅在于注意力机制的创新,更在于通过 “位置编码、编码器 - 解码器协作、残差连接” 等工程模块的组合,构建了稳定、高效的端到端训练架构。本章将拆解这些核心模块的设计逻辑与实现细节。

1、位置编码:弥补 “无序” 缺陷,给文本 “标上序号”

自注意力机制虽能捕捉全局语义关联,但存在一个致命缺陷:无法感知词的位置信息—— 将 “我吃苹果” 与 “苹果吃我” 输入自注意力,得到的关联权重完全相同,模型无法区分语义差异。位置编码(Positional Encoding)正是为解决这一问题而生,通过向词向量注入位置信息,让模型 “知道每个词的顺序”。

- 问题背景:自注意力的 “位置盲” 困境

自注意力计算时,会将序列中所有词的 QKV 向量全局关联,完全忽略词的输入顺序(如 “我→吃→苹果” 与 “苹果→吃→我” 的 QKV 矩阵无差异)。而语言的语义高度依赖语序(如 “我爱你” 与 “你爱我”),若缺乏位置信息,模型会产生严重的语义理解错误。

- 正弦余弦编码:优雅的位置信息注入方案

Transformer 没有采用 “给每个位置分配唯一 ID” 的简单方案(易导致过拟合、泛化性差),而是设计了正弦余弦位置编码—— 通过周期性的正弦、余弦函数,为不同位置生成独特的 “位置向量”,再与词向量相加,实现位置信息的 “嵌入式注入”。其核心优势在于:

- 泛化性强:可生成任意长度序列的位置编码(不受训练时最大序列长度限制)。

- 可解释性高:相邻位置的编码向量差异小,远距离位置差异大,符合人类对 “语序远近” 的认知。

- 计算高效:无需训练,直接通过公式生成,降低模型参数开销。

- 工程实现:正弦余弦位置编码的 PyTorch 代码

以下代码清晰展示了位置编码的生成逻辑 —— 对序列中每个位置(position),在词向量的偶数维度用正弦函数编码,奇数维度用余弦函数编码,确保每个位置的编码向量唯一:

import torch

import torch.nn as nn

import math

class PositionalEncoding(nn.Module):

def __init__(self, d_model, max_seq_length=5000):

"""

Args:

d_model: 词向量维度(需与Transformer的d_model一致,默认512)

max_seq_length: 预定义的最大序列长度(覆盖大部分应用场景即可)

"""

super().__init__()

# 初始化位置编码矩阵:[max_seq_length, d_model]

pe = torch.zeros(max_seq_length, d_model)

# 生成位置索引:[max_seq_length, 1](每个位置对应一个索引,如0,1,2,...)

position = torch.arange(0, max_seq_length, dtype=torch.float).unsqueeze(1)

# 生成衰减因子:用于控制正弦余弦函数的周期(维度为d_model//2)

# 公式:div_term = 10000^( -2i / d_model ),i为维度索引

div_term = torch.exp(

torch.arange(0, d_model, 2).float() * (-math.log(10000.0) / d_model)

)

# 偶数维度(0,2,4...)用正弦编码,奇数维度(1,3,5...)用余弦编码

pe[:, 0::2] = torch.sin(position * div_term) # 0::2表示步长为2,从0开始

pe[:, 1::2] = torch.cos(position * div_term) # 1::2表示步长为2,从1开始

# 将pe注册为“缓冲参数”(不参与梯度更新,仅作为固定输入)

# 增加batch维度:[1, max_seq_length, d_model],适配批量输入

self.register_buffer('pe', pe.unsqueeze(0))

def forward(self, x):

"""

Args:

x: 输入词向量,形状为[batch_size, seq_len, d_model]

Returns:

x_with_pe: 注入位置信息后的词向量(形状不变)

"""

# 仅取与输入序列长度匹配的位置编码(避免冗余)

seq_len = x.size(1)

x_with_pe = x + self.pe[:, :seq_len] # 词向量与位置向量逐元素相加

return x_with_pe

# 测试:模拟输入(32个句子,每个句子10个词,每个词512维向量)

x = torch.randn(32, 10, 512)

pos_enc = PositionalEncoding(d_model=512)

x_with_pe = pos_enc.forward(x)

print("注入位置编码后的输出形状:", x_with_pe.shape) # 输出:torch.Size([32, 10, 512])(与输入一致)2、编码器 - 解码器结构:协作完成 “输入→输出” 的语义转换

Transformer 的整体架构由 “编码器(Encoder)” 和 “解码器(Decoder)” 两部分堆叠而成,分别负责 “理解输入文本” 和 “生成输出文本”,二者通过 “编码器 - 解码器注意力” 协同工作,典型应用场景为机器翻译(如 “英文→中文”)、文本摘要(如 “长文档→短摘要”)。

- 编码器:多层堆叠的 “语义提取器”

编码器由 N 个相同的 “编码器块(TransformerBlock)” 堆叠而成(原论文中 N=6),每个块包含 “多头自注意力” 和 “前馈神经网络”,核心作用是从输入文本中提取层次化的语义特征—— 类似人类阅读时 “先理解单词→再理解短语→最后理解全文逻辑” 的过程:

- 第一层编码器:聚焦词与词的局部关联(如 “红色” 与 “苹果”);

- 中间层编码器:捕捉短语与句子结构(如 “吃红色苹果” 的主谓宾关系);

- 最后层编码器:输出全局语义表示(如整个句子的 “描述水果” 核心含义)。

所有编码器块的输入输出形状均为 [batch_size, seq_len_input, d_model],确保信息可逐层传递。

- 解码器:带 “因果掩码” 的 “文本生成器”

解码器同样由 N 个相同的 “解码器块” 堆叠而成(原论文中 N=6),每个块在编码器块的基础上,额外增加了 “掩码多头自注意力(Masked Multi-Head Attention)”,核心作用是基于编码器的语义特征,逐词生成输出文本,同时确保 “生成时不提前看到未来的词”(即因果约束)。

- 掩码多头自注意力:通过 “下三角掩码” 屏蔽未来位置的词(如生成第 3 个词时,仅能利用第 1、2 个词的信息),避免模型 “作弊”。例如生成 “我爱吃苹果” 时,生成 “吃” 字只能参考 “我”“爱”,无法参考 “苹果”,符合人类 “逐词书写” 的逻辑。

- 编码器 - 解码器注意力:解码器的关键协作模块 —— 用解码器当前生成的词(如中文 “我”)作为 Query,用编码器输出的输入语义(如英文 “I”)作为 Key 和 Value,实现 “输入语义→输出词” 的精准映射,确保生成内容与输入语义一致。

- 前馈神经网络:每个位置的 “独立语义增强器”

无论是编码器还是解码器,每个注意力模块后都会接一个 “前馈神经网络(Feed-Forward Network, FNN)”,其核心特点是对每个词的语义表示进行独立变换(不依赖其他词),作用是 “增强单个词的语义表达能力”:

- 结构:通常为 “线性层→激活函数(ReLU)→线性层” 的简单结构(原论文中隐藏层维度 d_ff=2048);

- 优势:可并行计算(每个词的变换独立),大幅提升效率;同时通过非线性激活函数,让模型学习更复杂的语义映射(如 “开心”→“愉悦” 的同义词转换)。

3、残差连接与层归一化:保障深层网络的训练稳定性

Transformer 的编码器 / 解码器均为深层结构(原论文中 12 层堆叠),而深层网络易出现 “梯度消失”“训练不稳定” 问题。残差连接(Residual Connection)和层归一化(Layer Normalization)的组合,正是解决这一问题的关键工程设计,确保模型能稳定训练到深层。

- 残差连接:让梯度 “顺畅流动”

残差连接的核心思想是 “将模块的输入直接加到输出上”(即output = module(input) + input),形成 “shortcut 路径”。其作用是:

- 缓解梯度消失:梯度可通过 shortcut 路径直接回传至浅层,避免因 “多层连乘” 导致梯度指数级衰减;

- 加速训练收敛:模型可先学习 “输入→输出” 的残差(即module(input) = output - input),再逐步优化复杂特征,降低学习难度。

- 层归一化:让参数 “稳定更新”

层归一化通过 “对每个样本的每个词向量进行归一化”(使均值为 0、方差为 1),避免因 “部分参数过大导致输出值剧烈波动”(即 “内部协变量偏移” 问题),确保每层的输入分布稳定,参数更新方向一致。

- 工程实现:含残差连接与层归一化的编码器块

以下代码展示了残差连接与层归一化在 “编码器块” 中的具体应用 —— 每个模块(注意力、前馈网络)的输出都先经过 “残差连接 + 层归一化”,再进入下一个模块:

class TransformerBlock(nn.Module):

def __init__(self, d_model=512, num_heads=8, d_ff=2048, dropout=0.1):

"""

Args:

d_model: 词向量维度(与位置编码、注意力模块一致)

num_heads: 注意力头数(默认8)

d_ff: 前馈神经网络隐藏层维度(原论文中2048)

dropout: dropout概率(防止过拟合,默认0.1)

"""

super().__init__()

# 引入多头自注意力模块(第二章实现的MultiHeadAttention)

self.self_attention = MultiHeadAttention(d_model, num_heads)

# 前馈神经网络(独立变换每个位置的语义)

self.feed_forward = nn.Sequential(

nn.Linear(d_model, d_ff), # 升维:[d_model→d_ff]

nn.ReLU(), # 非线性激活

nn.Linear(d_ff, d_model), # 降维:[d_ff→d_model](恢复原维度)

nn.Dropout(dropout) # Dropout防止过拟合

)

# 层归一化模块(每个模块后都需归一化)

self.norm1 = nn.LayerNorm(d_model)

self.norm2 = nn.LayerNorm(d_model)

# Dropout模块(注意力输出后添加,增强泛化性)

self.dropout = nn.Dropout(dropout)

def forward(self, x, mask=None):

"""

Args:

x: 输入向量,形状为[batch_size, seq_len, d_model]

mask: 注意力掩码(如padding掩码,避免关注无效词)

Returns:

x: 编码器块输出(形状不变)

"""

# 第一步:多头自注意力 + 残差连接 + 层归一化

# 残差连接:x(输入) + 注意力输出(避免梯度消失)

attn_output, _ = self.self_attention(x, x, x, mask) # 自注意力:Q=K=V

x = self.norm1(x + self.dropout(attn_output)) # 先残差相加,再层归一化(原论文设计)

# 第二步:前馈神经网络 + 残差连接 + 层归一化

ff_output = self.feed_forward(x) # 前馈网络独立变换

x = self.norm2(x + self.dropout(ff_output)) # 再次残差相加+归一化

return x

# 测试:模拟输入(32个句子,每个句子10个词,每个词512维向量)

x = torch.randn(32, 10, 512)

transformer_block = TransformerBlock(d_model=512, num_heads=8, d_ff=2048)

x_output = transformer_block.forward(x)

print("编码器块输出形状:", x_output.shape) # 输出:torch.Size([32, 10, 512])(与输入一致)- 核心价值:让深层训练成为可能

若无残差连接,12 层堆叠的 Transformer 会因 “梯度连乘衰减” 导致浅层参数几乎无法更新;若无层归一化,每层输出的数值分布会剧烈偏移,导致模型训练发散。二者的组合,使 Transformer 能稳定训练到深层,为后续大模型(如 GPT、BERT)的 “深度堆叠” 奠定了工程基础。

四、重塑NLP:Transformer的实际影响

1、性能突破:各项基准的"屠榜"表现

在 Transformer 诞生前,NLP 模型的性能提升多局限于 “单点优化”;而 Transformer 凭借注意力机制的全局建模能力,在机器翻译、文本生成、语义理解等核心任务中实现 “全面超越”,直接刷新各类权威基准的最优成绩。

|

核心任务 |

Transformer 前 (RNN/CNN 时代,2017 年前) |

Transformer 时代 (2017 年至今) |

|

机器翻译(BLEU 分数) |

1. 英德翻译任务最佳 BLEU 分数:25-28 分。 2. 关键问题:长句翻译语序混乱、语义丢失,翻译质量仅 “可理解” 级 |

1. 原论文表现:英德翻译 BLEU 分数提升至 34.8 分,较前代提升超 20%。 2. 后续优化:英中翻译 BLEU 分数突破 40 分(如 Transformer-XL)。 3. 质量升级:翻译流畅自然,可传递原文语气与文化内涵(谚语、双关语)。 |

|

文本生成 |

1. 核心缺陷:长程依赖失效,生成文本逻辑断裂(如 “我在吃饭→天空很蓝”)、重复冗余(如 “很好很好很好”)。 2. 定位:仅能作为 “工具辅助”,缺乏连贯性与创造性。 |

1. 连贯性提升:通过自注意力全局语义关联,保持内容一致性(如续写科幻小说时,角色、场景、剧情不脱节)。 2. 创造性增强:GPT 系列可生成特定风格内容(诗歌、剧本、代码),支持 “标题→全文” 自动创作(如 “秋日公园游记” 生成完整散文)。 3. 定位:升级为 “创意协作” 工具。 |

|

语义理解(GLUE 基准) |

1. 通用理解能力:综合 GLUE Score 最佳成绩约 72 分。 2. 局限:仅能 “处理文本”,难以深度理解语义关联。 |

1. 首次突破:2018 年 BERT 模型获 80.5 分 GLUE Score,全面超越前代。 2. 后续升级:RoBERTa、ALBERT 等将分数提升至 90 分以上(接近人类水平)。 3. 能力升级:可 “理解文本”,如准确判断 “小明喜欢吃苹果” 与 “苹果是小明爱吃的水果” 为等价关系(自然语言推理任务) |

2、计算效率:并行化带来的训练加速

RNN 的 “序列串行” 计算是效率瓶颈,而 Transformer 的 “并行化设计” 彻底释放了 GPU 的计算潜力,在训练速度、长序列处理、硬件利用率三方面实现突破,为大规模模型训练提供了可行性。

|

计算效率维度 |

RNN(含 LSTM)表现 |

Transformer 表现 |

|

训练时间 |

1. 任务案例(机器翻译:1000 万句对,GPU 为 V100):完成训练需2-3 周。 2. 序列长度影响:序列长度超 50 个词时,训练时间呈线性增长 |

1. 任务案例(同 RNN 任务条件):通过文本并行化 + 批次并行化,仅需2-3 天完成训练。 2. 效率提升:较 RNN 提升超 10 倍。 3. 核心原因:自注意力、前馈网络可并行计算,无需等待前一时刻结果。 |

|

长序列处理能力 |

1. 局限:受梯度消失影响,仅能有效处理50-100 个词的短序列。 2. 长文档处理方式:需 “分段切割”,易丢失上下文关联。 3. 典型缺陷:长文档摘要任务中 “只关注结尾信息” |

1. 基础能力:早期模型支持512 个词序列,通过 “位置编码 + 注意力权重动态分配” 实现长序列建模。 2. 优化突破:Longformer、Reformer 等用 “稀疏注意力” 将最大序列长度扩展至4096-16384 个词。 3. 长文档处理优势:可直接处理 5000 字论文、短篇小说,长文档摘要能基于全文逻辑生成。 |

|

GPU 利用率 |

1. 核心问题:串行计算导致 GPU 利用率低于 30%,大量计算单元闲置。 2. 成本案例(1 亿参数 NLP 模型):需消耗1000 GPU 小时(1 块 GPU 运行 1000 小时) |

1. 利用率提升:通过多头并行(多头注意力)、批次并行(前馈网络),GPU 利用率达70%-90%。 2. 成本优势(同 1 亿参数模型):仅需300-400 GPU 小时,硬件成本降低超 50%。 3. 价值:为百亿、千亿参数大模型训练提供经济可行性。 |

3、模型规模化:大模型时代的基石

Transformer 的架构设计具备极强的 “可扩展性”,不仅支持层数、维度的灵活调整,更催生了 “预训练 + 微调” 的范式革命,直接推动 NLP 从 “任务专属模型” 进入 “通用大模型” 时代。

|

模型规模化核心维度 |

关键技术细节 |

价值与影响 |

|

架构可扩展性 |

1. 层数(N): - 简单任务(文本分类):6-8 层编码器 - 复杂任务(机器翻译 / 长文生成):12-24 层 - 超大规模模型(GPT-3):96 层解码器。 2. 词向量维度(d_model): - 基础模型:512-1024 维 - 大模型(GPT-3):12288 维。 3. 注意力头数(num_heads): - 基础模型:8-16 头 - 大模型(PaLM):64 头。 |

实现 “按需配置”,兼顾不同场景需求: - 适配移动端轻量模型(如 DistilBERT,参数仅为 BERT 的 40%) - 支撑超大规模模型(如 GPT-3,1750 亿参数) - 平衡性能与资源消耗,灵活应对简单到复杂任务 |

|

预训练范式(BERT/GPT) |

1. 前 Transformer 时代: - 任务专属训练,每个任务需从零训练 - 数据利用率低、泛化性差。 2. Transformer 时代 “预训练 + 微调” 流程: - 预训练:用海量无标注文本(维基百科、互联网语料)训练通用模型,学习语法、语义、常识 - 微调:用少量标注数据适配具体任务(情感分析、问答)。 |

1. 知识迁移:预训练模型可迁移通用语言知识,大幅降低标注数据依赖(如情感分析标注数据从 10 万条降至 1 万条仍保高准确率)。 2. 范式革命: - BERT(双向 Transformer)成为语义理解 “基础模型” - GPT(单向 Transformer)成为文本生成 “标杆模型” - 奠定现代 NLP 技术框架。 |

|

零样本 / 少样本学习 |

1. 触发条件:Transformer 模型规模达百亿、千亿级参数,涌现 “涌现能力”。 2. 核心能力: - 零样本学习:无需微调,通过自然语言指令完成未训练任务(如 “总结文本”“英译中”) - 少样本学习:给 1-10 个任务示例,性能进一步提升。 3. 案例: - GPT-3 零样本完成生成 SQL、写产品说明书、解数学题 - PaLM(5400 亿参数)零样本翻译性能接近传统微调模型。 |

1. 打破任务限制:彻底摆脱 “任务专属训练” 束缚,模型可灵活应对多类任务。 2. 向通用 AI 迈进:实现 “指令驱动” 的灵活能力,减少对特定任务训练数据的依赖 3. 核心支撑:Transformer 架构对大规模参数的高效支撑,是涌现能力的基础。 |

Transformer 的影响并非单一技术突破,而是从 “性能、效率、规模” 三个维度全面重构了 NLP:

- 性能上,实现从 “碎片化处理” 到 “全局语义理解” 的跨越;

- 效率上,通过并行化释放 GPU 潜力,降低大规模训练成本;

- 规模上,催生预训练范式与大模型,让 NLP 从 “任务驱动” 转向 “能力驱动”。

可以说,没有 Transformer,就没有今天的 ChatGPT、文心一言等大模型,更不会有 NLP 技术在智能对话、内容创作、企业服务等领域的广泛应用 ——Transformer 不仅是一次架构革新,更是 NLP 进入 “大模型时代” 的 “奠基石”。

五、实战演示:从零理解注意力机制

1、可视化注意力权重

注意力机制的核心是 “动态分配关注权重”,但权重本身是抽象的数值矩阵。通过热力图可视化注意力权重,能直接观察模型如何关联文本中的不同词,尤其适合理解 “指代关系”“语义关联” 等核心能力。

- 核心目标:以 “指代消解” 任务为例(如判断 “it” 指代 “animal” 还是 “street”),通过可视化注意力权重,验证模型是否能正确捕捉词间关联。

- 完整代码实现(基于 Hugging Face Transformers)

我们将使用预训练的 BERT 模型(简化版),通过output_attentions=True获取注意力权重,再用seaborn绘制热力图。代码中包含关键步骤注释与结果分析:

# 1. 安装依赖库(首次运行需执行)

# !pip install torch transformers seaborn matplotlib

# 2. 导入必要模块

import torch

import seaborn as sns

import matplotlib.pyplot as plt

from transformers import BertTokenizer, BertModel

# 3. 加载预训练模型与分词器(选择轻量版BERT,适合演示)

tokenizer = BertTokenizer.from_pretrained("bert-base-uncased") # 分词器:将文本转为模型可识别的ID

model = BertModel.from_pretrained("bert-base-uncased", output_attentions=True) # 开启注意力权重输出

model.eval() # 切换为评估模式,避免训练时的随机 dropout

def visualize_attention(text, model, tokenizer, layer_idx=-1, head_idx=0):

"""

可视化指定层、指定注意力头的权重热力图

Args:

text: 输入文本(如指代消解句子)

model: 预训练Transformer模型(如BERT)

tokenizer: 对应的分词器

layer_idx: 选择哪一层的注意力(-1表示最后一层,通常语义关联最强)

head_idx: 选择哪一个注意力头(BERT默认12头,不同头关注不同关联)

"""

# 步骤1:文本预处理(分词、转为张量)

inputs = tokenizer(

text,

return_tensors="pt", # 返回PyTorch张量

add_special_tokens=True # 添加BERT的特殊token([CLS]开头,[SEP]结尾)

)

input_ids = inputs["input_ids"] # 文本对应的ID序列

tokens = tokenizer.convert_ids_to_tokens(input_ids[0]) # ID转回词(用于热力图标签)

# 步骤2:模型前向传播,获取注意力权重

with torch.no_grad(): # 关闭梯度计算,加快速度并避免内存占用

outputs = model(**inputs) # 模型输出包含last_hidden_state、attentions等

attentions = outputs.attentions # 所有层的注意力权重,形状:(num_layers, batch_size, num_heads, seq_len, seq_len)

# 步骤3:提取目标层、目标头的注意力权重

# 简化维度:去除batch维度(仅1个样本),取指定层和头

attention_weights = attentions[layer_idx][0][head_idx].detach().numpy() # 形状:(seq_len, seq_len)

# attention_weights[i][j] 表示:第i个词对第j个词的关注程度(值越大,关联越强)

# 步骤4:绘制热力图

plt.figure(figsize=(12, 10)) # 设置图的大小

ax = sns.heatmap(

attention_weights,

xticklabels=tokens, # x轴标签:输入文本的词

yticklabels=tokens, # y轴标签:输入文本的词

cmap="YlOrRd", # 配色方案(红色表示权重高,黄色表示权重低)

annot=True, # 显示具体权重数值(可选,便于精确分析)

fmt=".2f" # 数值格式:保留2位小数

)

plt.title(f"Attention Weights (Layer: {layer_idx}, Head: {head_idx})", fontsize=14)

plt.xlabel("Key (被关注的词)", fontsize=12)

plt.ylabel("Query (关注的词)", fontsize=12)

plt.xticks(rotation=45) # 旋转x轴标签,避免重叠

plt.yticks(rotation=0)

plt.tight_layout() # 自动调整布局,避免标签被截断

plt.show()

# 5. 实战示例:测试指代消解任务

if __name__ == "__main__":

# 输入文本:判断"it"指代"the animal"还是"the street"

text = "The animal didn't cross the street because it was too tired"

# 可视化最后一层、第0个注意力头的权重

visualize_attention(text, model, tokenizer, layer_idx=-1, head_idx=0)- 结果分析:模型如何 “看懂” 指代关系?

运行代码后,观察热力图中 “it”(对应 token 为 “it”)所在行的权重分布:

- 若 “it” 行对应 “animal” 的列权重显著高于 “street”(如 “it→animal” 权重 0.8,“it→street” 权重 0.1),说明模型正确捕捉到 “it” 指代 “animal”;

- 这验证了注意力机制的核心价值:无需人工设计规则,模型可自动学习词间的语义关联,而这正是 Transformer 理解文本的关键。

- 提示:尝试更换head_idx(如 1、2),会发现不同注意力头关注不同关联(如有的头关注语法结构,有的头关注语义指代)。

2、简化版Transformer实现

真实 Transformer 架构复杂(如包含编码器 - 解码器、掩码机制),但核心模块可简化为 “词嵌入 + 位置编码 + Transformer 块 + 输出层”。下面实现的MiniTransformer仅保留核心逻辑,适合快速理解 Transformer 的端到端流程,可用于文本分类、简单文本生成等任务。

- 核心设计思路:

简化版 Transformer 仅保留编码器结构(无解码器),模块间通过 “嵌入→位置编码→多层 Transformer 块→输出” 的流程传递信息,同时复用前文实现的PositionalEncoding和TransformerBlock(需确保代码可复用)。

- 完整代码实现(基于 PyTorch)

代码包含模块详解、参数说明与使用示例,确保可直接运行:

# 1. 导入依赖模块(需先实现PositionalEncoding和TransformerBlock)

import torch

import torch.nn as nn

import math

from typing import Optional

# 复用第三章实现的位置编码模块

class PositionalEncoding(nn.Module):

def __init__(self, d_model: int, max_seq_length: int = 5000):

super().__init__()

pe = torch.zeros(max_seq_length, d_model)

position = torch.arange(0, max_seq_length, dtype=torch.float).unsqueeze(1)

div_term = torch.exp(torch.arange(0, d_model, 2).float() * (-math.log(10000.0) / d_model))

pe[:, 0::2] = torch.sin(position * div_term)

pe[:, 1::2] = torch.cos(position * div_term)

self.register_buffer('pe', pe.unsqueeze(0)) # (1, max_seq_length, d_model)

def forward(self, x: torch.Tensor) -> torch.Tensor:

# x: (batch_size, seq_len, d_model)

seq_len = x.size(1)

return x + self.pe[:, :seq_len] # 词嵌入 + 位置编码

# 复用第三章实现的Transformer块(简化版,仅保留自注意力和前馈网络)

class TransformerBlock(nn.Module):

def __init__(self, d_model: int, num_heads: int, d_ff: int, dropout: float = 0.1):

super().__init__()

# 多头自注意力(简化:直接使用PyTorch内置模块)

self.self_attn = nn.MultiheadAttention(

embed_dim=d_model,

num_heads=num_heads,

dropout=dropout,

batch_first=True # 输入形状为(batch_size, seq_len, d_model)

)

# 前馈网络:Linear → ReLU → Linear

self.feed_forward = nn.Sequential(

nn.Linear(d_model, d_ff),

nn.ReLU(),

nn.Linear(d_ff, d_model),

nn.Dropout(dropout)

)

# 层归一化与Dropout

self.norm1 = nn.LayerNorm(d_model)

self.norm2 = nn.LayerNorm(d_model)

self.dropout = nn.Dropout(dropout)

def forward(self, x: torch.Tensor, mask: Optional[torch.Tensor] = None) -> torch.Tensor:

# 自注意力 + 残差连接 + 层归一化

attn_output, _ = self.self_attn(x, x, x, attn_mask=mask) # Q=K=V

x = self.norm1(x + self.dropout(attn_output))

# 前馈网络 + 残差连接 + 层归一化

ff_output = self.feed_forward(x)

x = self.norm2(x + self.dropout(ff_output))

return x

# 2. 实现简化版Transformer(MiniTransformer)

class MiniTransformer(nn.Module):

"""

简化版Transformer:仅含编码器,适用于文本分类、序列标注等任务

Args:

vocab_size: 词汇表大小(如10000,表示有10000个不同的词)

d_model: 词嵌入维度(需与Transformer块的d_model一致,建议256/512)

num_heads: 注意力头数(需能整除d_model,如d_model=512时,num_heads=8)

num_layers: Transformer块的堆叠层数(建议2-4层,层数越多能力越强但计算成本越高)

d_ff: 前馈网络隐藏层维度(通常为d_model的4倍,如d_model=512时,d_ff=2048)

max_seq_length: 最大序列长度(防止位置编码越界)

dropout: Dropout概率(防止过拟合)

"""

def __init__(

self,

vocab_size: int,

d_model: int = 512,

num_heads: int = 8,

num_layers: int = 3,

d_ff: int = 2048,

max_seq_length: int = 512,

dropout: float = 0.1

):

super().__init__()

# 模块1:词嵌入(将词ID转为d_model维向量)

self.token_embedding = nn.Embedding(

num_embeddings=vocab_size,

embedding_dim=d_model,

padding_idx=0 # 假设0是padding token,嵌入向量不更新

)

# 模块2:位置编码(注入位置信息)

self.pos_encoding = PositionalEncoding(d_model=d_model, max_seq_length=max_seq_length)

# 模块3:堆叠多个Transformer块

self.transformer_layers = nn.ModuleList([

TransformerBlock(

d_model=d_model,

num_heads=num_heads,

d_ff=d_ff,

dropout=dropout

) for _ in range(num_layers)

])

# 模块4:输出层(根据任务调整,此处以文本分类为例,输出类别概率)

self.output_layer = nn.Linear(d_model, 2) # 假设分类任务为二分类(如情感分析:正面/负面)

# 其他:Dropout层(可选,增强泛化性)

self.dropout = nn.Dropout(dropout)

def forward(self, x: torch.Tensor, mask: Optional[torch.Tensor] = None) -> torch.Tensor:

"""

前向传播流程

Args:

x: 输入词ID序列,形状为(batch_size, seq_len)

mask: 注意力掩码(可选,用于屏蔽padding或未来词),形状为(seq_len, seq_len)

Returns:

logits: 输出类别 logits,形状为(batch_size, num_classes)(此处num_classes=2)

"""

# 步骤1:词嵌入 → 位置编码 → Dropout

x = self.token_embedding(x) # (batch_size, seq_len) → (batch_size, seq_len, d_model)

x = self.pos_encoding(x) # 注入位置信息,形状不变

x = self.dropout(x) # 随机失活,防止过拟合

# 步骤2:通过多层Transformer块

for layer in self.transformer_layers:

x = layer(x, mask=mask) # 每层输出形状仍为(batch_size, seq_len, d_model)

# 步骤3:池化(文本分类需将序列向量转为单向量,此处用"[CLS]位置向量"或"全局平均池化")

# 简化:取序列第一个位置(假设为[CLS])的向量作为整个序列的表示

x_cls = x[:, 0, :] # (batch_size, seq_len, d_model) → (batch_size, d_model)

# 步骤4:输出层(二分类logits)

logits = self.output_layer(x_cls) # (batch_size, d_model) → (batch_size, 2)

return logits

# 3. 实战示例:初始化MiniTransformer并测试前向传播

if __name__ == "__main__":

# 超参数设置(根据需求调整)

vocab_size = 10000 # 假设词汇表大小为10000

d_model = 512

num_heads = 8

num_layers = 3

d_ff = 2048

# 初始化模型

mini_transformer = MiniTransformer(

vocab_size=vocab_size,

d_model=d_model,

num_heads=num_heads,

num_layers=num_layers,

d_ff=d_ff

)

# 模拟输入:batch_size=2,seq_len=10(2个样本,每个样本10个词ID)

x = torch.randint(1, vocab_size, (2, 10)) # 词ID从1开始(0为padding)

# 前向传播

logits = mini_transformer(x)

# 输出结果分析

print("输入形状:", x.shape) # 输出:torch.Size([2, 10])

print("输出logits形状:", logits.shape) # 输出:torch.Size([2, 2])(2个样本,每个样本2个类别logits)

print("输出logits:", logits)

# 后续可添加损失函数(如CrossEntropyLoss)和优化器(如AdamW)进行训练- 关键说明与扩展建议:

- 模块复用:PositionalEncoding和TransformerBlock直接复用前文实现,确保代码一致性;

- 任务适配:若需用于文本生成,需添加解码器模块(参考第三章解码器结构),并使用因果掩码;若需多分类,只需修改output_layer的输出维度(如 10 分类则改为nn.Linear(d_model, 10));

- 训练提示:实际训练时需添加数据加载(如处理文本数据集)、损失计算、梯度下降等步骤,可基于 PyTorch 的DataLoader和Optimizer实现;

- 简化目的:MiniTransformer去除了真实 Transformer 的部分复杂设计(如编码器 - 解码器注意力、稀疏注意力),但保留核心逻辑,适合作为学习入门的 “最小可行模型”。

六、超越NLP:Transformer的泛化应用

Transformer 的核心价值不仅在于革新 NLP,更在于其 “序列建模 + 注意力机制” 的通用框架可适配任意具备 “关联结构” 的数据 —— 无论是图像的像素块、多模态的文本与图像,还是科学计算中的蛋白质序列,Transformer 都能通过灵活改造,成为解决跨领域问题的核心工具。本章将解析其在计算机视觉、多模态学习、科学计算三大领域的突破应用。

1、计算机视觉:Vision Transformer(ViT)—— 让 “看图像” 像 “读文本” 一样简单

在 Transformer 出现前,计算机视觉(CV)的核心技术是 CNN(卷积神经网络),依赖 “局部卷积核” 提取图像特征。而 Vision Transformer(ViT,2020 年提出)首次证明:无需卷积操作,仅用 Transformer 的注意力机制,就能在图像任务上达到甚至超越 CNN 的性能,彻底打破了 “CV 依赖 CNN” 的固有认知。

|

核心维度 |

具体细节描述 |

|

图像→序列 token 的核心适配思路 |

1. 图像分块:将 224×224×3(RGB)等输入图像,分割为 16×16 像素的均等图像块,共生成 (224/16)×(224/16)=196 个块。 2. 块嵌入:每个 16×16×3 的图像块(含 768 个像素值),通过线性层映射为 768 维 “图像块 token”,形成长度 196 的序列。 3. 添加类别 token:在序列开头加入可学习的 “[CLS] token”(借鉴 BERT),用于图像分类任务,序列长度变为 197。 4. 位置编码:注入 “图像块位置编码”,保留图像块的空间位置关系,确保模型感知块的排列顺序。 |

|

ImageNet 性能表现(“逆袭” CNN) |

1. 基础版 ViT(ViT-B/16):Top-1 准确率达 83.1%,较同期顶尖 CNN 模型(如 ResNet-50,准确率约 79.0%)提升超 4 个百分点。 2. 大尺度 ViT(ViT-L/16、ViT-H/14):通过扩大参数规模(8600 万→6.3 亿)+“预训练 + 微调” 范式,Top-1 准确率突破 88.5%,超越同期所有 CNN 模型。 3. 优势场景:高分辨率图像(如 1024×1024)任务中,可捕捉全局像素关联(如 “猫爪 - 猫头” 关联),而 CNN 受卷积核大小限制,全局建模能力较弱。 |

|

技术影响(CV 与 NLP 架构统一) |

1. 打破领域壁垒:此前 CV 依赖 CNN、NLP 依赖 RNN/Transformer,ViT 证明 Transformer 可作为两大领域的通用架构,共享框架降低跨领域开发成本。 2. 推动 CV 技术迭代:后续衍生模型(Swin Transformer、MAE)优化空间建模能力,使 Transformer 在目标检测、图像分割等复杂 CV 任务中全面超越 CNN,成为现代 CV 主流架构。 |

2、多模态学习:CLIP、DALL-E—— 打通文本与图像的 “语言壁垒”

多模态学习(如文本 - 图像、语音 - 文本)的核心挑战是 “跨模态语义对齐”(即让模型理解 “‘红色苹果’的文本” 与 “红色苹果的图像” 是同一语义)。Transformer 的注意力机制天然擅长 “关联不同类型数据”,催生了 CLIP(文本 - 图像检索)、DALL-E(文本生成图像)等革命性模型。

|

对比维度 |

CLIP(Contrastive Language-Image Pre-training) |

DALL-E |

|

提出背景 |

OpenAI 2021 年提出,聚焦 “文本 - 图像双向检索与对齐” |

OpenAI 2021 年提出,聚焦 “文本指令驱动的图像生成” |

|

核心架构 |

双编码器架构(无解码器): 1. 文本编码器:基于 Transformer 单向编码器(类似 GPT),输出 512 维文本向量。 2. 图像编码器:基于 ViT 图像编码器,输出 512 维图像向量。 |

编码器 - 解码器架构: 1. 编码器:Transformer 编码器,将文本指令编码为语义向量。 2. 解码器:Transformer 解码器,基于语义向量生成图像。 |

|

核心训练方式 |

对比学习预训练:用 4 亿对 “文本 - 图像” 数据训练,使匹配对(如 “猫文本 - 猫图像”)向量相似度高,不匹配对(如 “猫文本 - 狗图像”)相似度低 |

生成式预训练:通过海量 “文本 - 图像” 对学习 “文本语义→图像像素” 的映射关系,生成过程用因果掩码保证空间连贯性 |

|

核心能力 |

1. 双向检索:文本检索图像(输入 “红色日落” 返回相关图像)、图像检索文本(输入猫图像返回 “a cat”)。 2. 零样本分类:未训练 “熊猫” 类别,输入熊猫图像 +“panda” 文本可正确匹配。 |

1. 文本生成图像:输入 “戴礼帽持伞的企鹅” 生成对应图像,基础分辨率 256×256(DALL-E 2 达 1024×1024)。 2. 创新生成:生成 “穿西装办公的章鱼” 等现实不存在但逻辑合理的图像。 3. 细节理解:可生成 “左红右蓝的椅子”,精准匹配文本细节 |

|

关键技术亮点 |

跨模态注意力实现文本 - 图像语义对齐,零样本能力突破任务专属训练限制 |

因果掩码确保图像像素空间连贯性,Transformer 解码器支持高精度、高创意的图像生成,超越传统 GAN 模型 |

3、科学计算:AlphaFold2—— 用 Transformer 破解 “蛋白质结构预测” 难题

科学计算领域的许多问题本质是 “序列建模”(如蛋白质氨基酸序列、DNA 序列、气象数据序列)。Transformer 的长序列建模能力,在蛋白质结构预测等领域实现了 “从不可能到可能” 的突破,其中最具代表性的是 DeepMind 的 AlphaFold2(2020 年)。

|

核心维度 |

具体内容描述 |

|

问题背景:蛋白质结构预测的 “百年难题” |

1. 功能与结构的关系:蛋白质功能由 “氨基酸序列” 决定的 “3D 空间结构” 直接决定(如酶的催化功能依赖特定空间构象)。 2. 实验解析瓶颈:传统方法(X 射线晶体学)解析结构需数月至数年,成本极高,自然界已发现超 1 亿种蛋白质,实验解析的不足 10 万种,缺口巨大。 3. 核心挑战:从 “线性氨基酸序列”(20 种氨基酸组成的长序列)预测 “3D 空间结构”(氨基酸残基坐标),涉及复杂物理化学相互作用,传统模型(基于物理规则)预测精度极低。 |

|

AlphaFold2 的 Transformer 解决方案 |

1. 序列编码与注意力机制: - 输入:蛋白质氨基酸序列(如长度 1000 的序列)、同源蛋白质序列(进化相关,辅助预测); - 编码器:用 Transformer 编码器处理序列,通过 “自注意力” 捕捉氨基酸长程关联(如第 10 个与第 500 个氨基酸的相互作用),“交叉注意力” 融合同源序列信息。 2. 结构生成模块: - 解码器:基于 Transformer 解码器,将序列向量逐步转化为 3D 结构坐标,融入物理规则(氨基酸距离约束、化学键角度限制)确保合理性; - 迭代优化:通过 25 轮等多轮迭代降低预测误差。 |

|

性能与影响:改变生命科学研究范式 |

1. 竞赛性能突破:2020 年 CASP14 竞赛中,预测结构与实验解析结构的平均误差(RMSD)仅 0.96Å(1Å=0.1 纳米,接近原子级精度),远超此前最佳模型(误差约 4Å)。 2. 实际应用价值: - 已解析超 2 亿种蛋白质结构(如人类基因组蛋白质、新冠病毒刺突蛋白); - 为疾病研究(蛋白质结构导向药物设计)、农业育种(优化作物抗逆蛋白质)提供关键工具。 3. 范式转变:推动生命科学从 “实验驱动” 向 “计算 + 实验” 双轮驱动转变。 |

|

通用启示:Transformer 的序列建模泛化性 |

证明 Transformer 的核心能力是 “处理任意具备关联结构的序列数据”,而非仅局限于自然语言: - 文本→词序列的语义关联、图像→块序列的空间关联、蛋白质→氨基酸序列的相互作用关联,均能通过注意力机制捕捉; - 为 Transformer 在更多科学计算领域(如 DNA 序列分析、气象数据预测)的应用提供核心理论支撑。 |

七、结语:架构进化的启示

展望未来,Transformer 并非终点:当模型规模逼近算力极限,当长序列处理仍面临效率瓶颈,下一次架构突破或许藏在 “稀疏注意力的极致优化”“多模态统一建模的深层融合”,或是 “结合物理规则与数据驱动的混合架构” 中。但无论技术如何迭代,理解 Transformer 的核心逻辑 —— 对关联结构的精准捕捉、对并行效率的极致追求、对多领域的泛化适配 —— 都是我们把握当前 AI 技术脉络的基础。它不仅是解锁 ChatGPT、GPT-4 等大模型的钥匙,更是帮助我们预见未来技术方向、参与下一轮 AI 革命的关键。唯有深入理解这份架构进化的启示,才能在技术浪潮中不迷失方向,真正成为 AI 发展的见证者与推动者。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)