简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文分析了RTX4090魔改48GB显存的技术路线,并探讨了RTX5090魔改128GB显存的可行性。RTX4090通过PCB背面加装12颗GDDR6X显存颗粒和VBIOS固件改造实现48GB容量,其成功验证了英伟达显卡的硬件复用设计。而RTX5090要实现128GB需突破32Gb GDDR7颗粒量产和显存控制器兼容性两大技术壁垒,目前仅理论可行。文章还预测了魔改技术对产业链的影响,包括加速GDD

摘要: 本文深入探讨了深度神经网络训练中的两项关键技术——层归一化(Layer Normalization)和残差连接(Residual Connection)。首先分析了深度网络面临的梯度消失/爆炸和内部协变量偏移问题,然后详细解析了层归一化的数学原理和实现方式,包括自定义实现及与其他归一化方法的比较。最后介绍了残差连接的基本结构和实现,展示了其如何与层归一化协同工作来稳定深度模型训练,提升网络

摘要 本文深入探讨了大型语言模型的量化技术,分析了其核心原理与实现方法。量化通过将浮点参数转换为低精度整数,显著降低了模型内存占用和计算开销,使大模型在消费级硬件上的部署成为可能。文章系统介绍了量化方法分类,包括训练后量化(PTQ)和量化感知训练(QAT),并提供了详细的代码实现示例。量化技术可减少75%内存占用,提升推理速度,降低能耗,同时保持模型精度,为大模型的实际应用提供了重要解决方案。

开源与闭源:大型语言模型发展的双轨路径 摘要:当前大型语言模型发展形成开源与闭源两大阵营。闭源模型以商业公司为主导,注重技术保护和商业变现,在通用能力、推理性能等方面保持领先;开源模型则依托社区协作,在数据安全、定制开发方面具有优势。两者在技术架构、商业模式、应用场景等方面呈现明显差异:闭源适合快速原型开发和技术前沿需求,开源更适配数据敏感和深度定制场景。未来可能出现技术融合趋势,形成互补共生的生

当前大型语言模型(LLM)市场呈现多元化发展态势,国际主流模型包括Anthropic的Claude系列、Google的Gemini和Meta的开源LLaMA系列;国内优秀模型则有阿里巴巴的通义千问、百度的文心一言和清华智谱GLM。此外,Mistral、零一万物等新兴模型以及代码生成、学术研究等专业领域模型也各具特色。用户应根据使用场景(如日常对话、代码开发、中文业务等)和技术需求(性能、成本、开源

大语言模型是基于深度学习的AI系统,通过海量文本训练获得语言理解和生成能力。核心架构经历了从Transformer到GPT、LLaMA系列的演进,参数量从1亿级发展到万亿级。关键技术包括自注意力机制、位置编码和强化学习优化。训练分为预训练(无监督学习)、有监督微调和人类反馈强化学习三阶段。现代大模型具备文本生成、代码编写、逻辑推理等能力,并持续向多模态方向发展。模型优化方向包括架构创新(如LLaM

这篇技术文章系统解析了大语言模型(LLM)领域的高级核心概念。内容涵盖参数高效微调(PEFT)、人类反馈强化学习(RLHF)等训练优化技术,混合专家模型(MoE)等架构创新,量化与推测解码等推理优化方法,以及多模态学习、评估基准和安全对齐等扩展领域。文章通过对比表格、流程图和分类说明等方式,深入浅出地介绍了这些前沿技术的原理、优势和应用场景,为读者构建了完整的LLM知识框架。这些术语不仅代表了当前

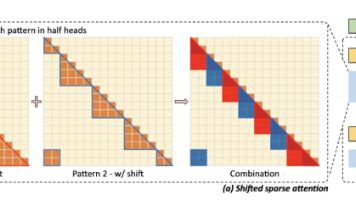

摘要 大型语言模型的上下文长度扩展面临计算复杂度、内存消耗和信息衰减三大挑战。传统Transformer的自注意力机制存在O(n²)复杂度,导致长序列处理困难。突破性技术如FlashAttention采用分块计算降低内存访问开销,线性注意力机制则通过近似计算将复杂度降至O(n)。这些创新使模型能处理百万token级上下文,为长文档理解、复杂推理等任务开辟了新可能。未来,高效注意力机制与硬件优化的结

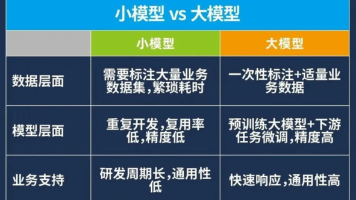

文章摘要: 本文对比了传统AI与大模型的核心范式差异。传统AI依赖特征工程和多阶段手工处理,需领域专家设计特征且迁移困难;大模型则通过预训练实现端到端学习,利用海量数据自动提取特征并具备跨任务泛化能力。传统方法受限于特征表达瓶颈和标注数据需求,而大模型通过统一架构支持多任务处理,实现零样本学习和提示工程。这种范式转变使AI开发从专业密集型转向数据驱动型,大幅提升了模型的通用性和应用效率。(149字

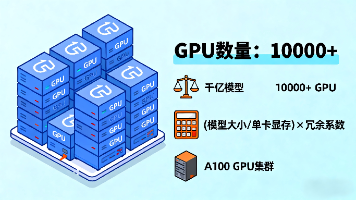

千亿参数大模型训练算力需求分析 本文系统分析了训练千亿参数大模型(如GPT-3、LLaMA 2)的算力需求。关键点包括: 内存需求:FP16精度的千亿参数模型基础存储需200GB,训练时总内存需求达500-700GB,包括参数、梯度、优化器状态和激活值。 计算复杂度:基于DeepMind公式,训练计算量≈6×参数数量×训练tokens,千亿模型训练需约1.8×10^20 FLOPs。 GPU配置: