【强化学习】强化学习算法分类

强化学习算法是机器学习的重要分支,通过智能体与环境的交互学习最优决策策略。本文系统介绍了强化学习算法的分类体系:按学习方式分为基于模型和无模型两类;按策略优化方式分为基于价值、基于策略及Actor-Critic三类。重点分析了各类代表性算法(如DQN、PPO、DDPG等)的原理特点,并详细阐述了其在机器人控制、自动驾驶、游戏AI和推荐系统等领域的典型应用场景。文章最后展望了强化学习算法在理论创新和

目录

一、强化学习算法是什么?

强化学习算法,作为机器学习领域的关键分支,是一类独特的算法统称。其核心机制是智能体(Agent)在动态环境中持续探索与行动,依据环境反馈的奖励或惩罚信号,逐步学习并优化自身决策策略,以实现长期累积奖励的最大化。这一过程恰似人类在生活中不断尝试新事物,依据结果的好坏来调整后续行动。

以机器人学习行走为例,机器人便是智能体,它所处的物理空间构成了环境。起初,机器人对如何行走毫无头绪,只能随机尝试各种动作组合,如腿部的不同屈伸角度、移动步伐的大小等。若某个动作使其成功前进且保持平衡,它就会获得正奖励;若导致摔倒或停滞不前,则会得到负奖励。通过大量的尝试与反馈,机器人逐渐学会优化动作,最终掌握稳定高效的行走方式。

在游戏 AI 领域,强化学习算法同样大放异彩。例如在围棋、象棋这类策略性游戏中,AI 智能体将棋盘视为环境,每一步落子就是一个动作。智能体通过不断与环境交互,即与对手对弈,根据棋局胜负结果获取奖励信号。若赢得比赛,获得正奖励;反之则是负奖励。在长期的训练过程中,AI 智能体能够学习到各种复杂的策略,从大量的对弈数据中挖掘出最优的落子决策,从而达到甚至超越人类棋手的竞技水平 。在复杂的即时战略游戏如《星际争霸》中,AI 智能体需要同时处理资源采集、基地建设、兵种训练与战斗指挥等多方面任务,通过强化学习算法,它能根据游戏局势实时调整策略,做出最优决策。

二、按学习方式分类

2.1 基于模型的强化学习算法

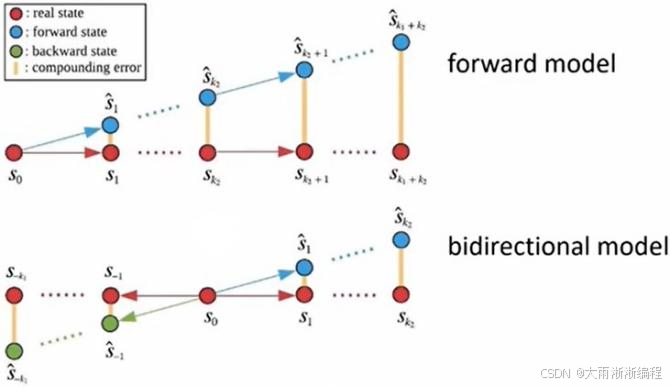

基于模型的强化学习算法,致力于构建一个对环境进行模拟的模型。智能体通过与真实环境的交互,不断学习和更新这个环境模型,使其能够尽可能准确地预测在不同状态下采取不同动作后,环境可能产生的状态转移以及给予的奖励。以 Dyna-Q 算法为例,它巧妙地将无模型的 Q - learning 与基于模型的规划相结合 。在 Dyna-Q 算法中,智能体在真实环境中执行动作获取反馈(状态转移和奖励)后,不仅会像 Q - learning 一样更新 Q 值表,还会利用这些经验更新内部的环境模型。随后,算法会从已访问过的状态 - 动作对中随机抽取样本,利用模型预测奖励和下一个状态,再通过 Q - learning 更新 Q 值表 。这就如同一个人在探索新城市时,每到一个地方就记录下从这个地方前往其他地方的路线和所需时间(构建环境模型),之后不仅可以根据实际走过的路线优化出行计划(直接学习),还能通过回忆之前记录的信息,在脑海中模拟不同出行方案(规划),从而找到更优的路线。

这类算法的优点在于数据利用效率高,因为智能体可以通过模型在 “脑海” 中进行推演和规划,减少与真实环境的交互次数,从而降低成本和风险。同时,基于模型的算法具有更强的可解释性,环境模型能直观地展示智能体对环境的理解。然而,它也存在明显的缺点。一方面,构建和维护环境模型的计算成本较高,需要消耗大量的时间和资源。另一方面,模型误差容易累积,一旦模型对环境的预测出现偏差,随着时间的推移和决策步骤的增加,这些误差可能会不断放大,导致智能体的决策越来越偏离最优解。

2.2 无模型的强化学习算法

无模型的强化学习算法,不依赖于对环境进行显式建模,而是让智能体直接从与环境交互所产生的数据中学习最优策略或价值函数。Q - Learning、SARSA 是其中的典型算法。Q - Learning 通过不断更新 Q 值表来寻找最优策略,其核心更新公式为\(Q(s_t, a_t) \leftarrow Q(s_t, a_t) + \alpha \left[ r_{t+1} + \gamma \max_{a'} Q(s_{t+1}, a') - Q(s_t, a_t) \right]\),其中\(\alpha\)是学习率,\(\gamma\)是折扣因子 。它假设智能体在每个状态下都选择能使未来累积奖励最大化的动作,通过不断试错来逼近最优策略。SARSA 则是一种在线策略算法,它的更新依赖于当前策略生成的动作序列,更新公式为\(Q(st,at) \leftarrow Q(st,at) + \alpha[rt + \gamma Q(st + 1,at + 1) - Q(st,at)]\),其中\(at + 1\)是根据当前策略选择的下一动作 。

无模型算法在复杂环境下展现出强大的适应性,因为它无需预先了解环境的具体模型,能够在未知环境中通过不断探索和试错来学习。同时,这类算法灵活性高,能快速适应环境的动态变化。但它也存在一些不足。由于缺乏对环境的整体认知,无模型算法在学习过程中需要进行大量的尝试,样本效率较低,学习速度相对较慢。在面对高维状态和动作空间时,其计算复杂度会急剧增加,导致算法难以收敛,甚至可能陷入局部最优解。

三、按策略优化方式分类

3.1 基于价值的强化学习算法

基于价值的强化学习算法,核心在于通过学习状态 - 动作对的价值函数(通常用 Q 值函数表示)来寻找最优策略。在这种框架下,智能体在每个状态下,通过比较不同动作的 Q 值,选择具有最大 Q 值的动作,以期望获得长期累积奖励的最大化。以深度 Q 网络(DQN)为例,它巧妙地将深度学习与 Q - learning 相结合,用于处理高维状态空间的强化学习问题 。

在 DQN 中,使用深度神经网络来逼近 Q 值函数。网络的输入是状态,输出是每个可能动作对应的 Q 值。训练过程中,通过经验回放(Experience Replay)机制,将智能体与环境交互产生的(状态 s、动作 a、奖励 r、下一个状态 s')四元组存储在经验池中,训练时随机采样小批量数据进行学习,打破数据间的时间相关性,提高训练稳定性 。同时,引入目标网络,其参数定期从主网络复制,在计算目标 Q 值时提供稳定参考,减少训练波动 。在 Atari 游戏中,智能体需要处理高维的图像状态信息,DQN 通过卷积神经网络将图像作为输入,自动提取特征并估计 Q 值,从而指导智能体做出决策,实现从像素输入到动作输出的端到端学习。

DQN 在处理高维状态空间时具有显著优势,能够自动学习状态特征,无需手动设计特征工程 。然而,它在连续动作空间上存在局限,因为动作空间是连续的,无法直接枚举所有动作来计算 Q 值。为解决这一问题,通常需要将连续动作空间离散化,但这会导致精度损失,并且当动作空间维度较高时,离散化后的动作数量会呈指数级增长,使得计算复杂度急剧增加。

3.2 基于策略的强化学习算法

基于策略的强化学习算法,直接对策略函数进行优化,而不是像基于价值的算法那样间接通过价值函数来推导策略。这类算法的策略函数通常用\(\pi(a|s)\)表示,即给定状态 s 时采取动作 a 的概率分布。以近端策略优化(PPO)、信赖域策略优化(TRPO)为例,它们都是通过优化策略函数,使得智能体在与环境交互过程中获得的累计奖励期望最大化。

PPO 通过限制新策略与旧策略之间的差异,来保证策略更新的稳定性。它引入了裁剪目标函数(clipped objective),当新策略与旧策略在某状态下选择动作的概率比值超出一定范围时,对目标函数进行裁剪,避免策略更新过大导致性能下降 。TRPO 则通过 KL 散度约束策略更新步长,确保每次更新都在一个信任域(trust region)内,使得策略更新更加稳定 。在机器人运动控制任务中,机器人的动作空间通常是连续的,如关节的角度、速度等。PPO 和 TRPO 可以直接学习到连续动作的概率分布,使机器人能够根据环境状态做出更加平滑、自然的动作决策,相比基于价值的算法在处理连续动作空间时具有天然优势。

基于策略的算法在处理连续动作空间和高维动作空间时表现出色,能够直接输出动作的概率分布,避免了基于价值算法在连续动作空间中面临的离散化问题。然而,这类算法也存在一些缺点。训练过程中,基于策略的算法通常需要大量的样本才能收敛,训练效率相对较低。由于策略梯度的估计存在方差,在学习过程中容易出现波动,导致训练不稳定,需要仔细调整超参数来平衡探索与利用。

3.3 Actor-Critic 算法

Actor-Critic 算法巧妙地结合了基于价值和基于策略的方法,旨在同时优化策略函数(Actor 部分)和价值函数(Critic 部分)。其中,Actor 负责根据当前状态选择动作,Critic 则评估这些动作的价值,为 Actor 提供策略调整的反馈,指导其优化策略。以深度确定性策略梯度(DDPG)、软演员 - 评论家(SAC)为例,它们在复杂任务中展现出强大的性能。

在 DDPG 中,Actor 网络输出的是确定性的动作,而非概率分布。Critic 网络则用于估计动作价值函数(Q 值函数),通过计算 TD 误差(时间差分误差)来评估当前策略下动作的优劣,进而指导 Actor 网络更新策略 。SAC 则引入了熵正则化项,在优化策略时不仅考虑最大化累积奖励,还考虑增加策略的熵,即鼓励策略具有一定的随机性,以提高探索能力,从而在复杂环境中更有效地学习到最优策略 。在自动驾驶场景中,车辆需要根据复杂的路况(如交通流量、道路状况、其他车辆的行驶状态等)做出决策,包括加速、减速、转向等动作。DDPG 和 SAC 可以利用 Critic 网络评估不同决策的价值,指导 Actor 网络生成合理的驾驶策略,使车辆能够在复杂多变的环境中安全、高效地行驶。

Actor-Critic 算法在复杂任务中具有明显优势,它结合了价值函数和策略函数的优点,能够更高效地学习到最优策略。然而,这类算法的实现相对复杂,需要同时训练 Actor 和 Critic 两个网络,并且在训练过程中需要仔细平衡两者的更新,否则容易出现过估计和探索不足等问题。由于 Critic 网络的估计误差可能会传播到 Actor 网络的更新中,导致策略优化出现偏差,需要采用一些技巧(如目标网络、双 Q 网络等)来提高算法的稳定性和收敛性 。

四、不同分类算法的应用场景

强化学习算法在不同领域展现出独特的优势和适应性,下面我们来探讨不同类型算法在机器人控制、自动驾驶、游戏、推荐系统等领域的具体应用。

4.1 机器人控制领域

在机器人控制领域,基于策略的强化学习算法,如近端策略优化(PPO)算法应用广泛。以机器人的复杂动作控制任务为例,如机器人的行走、抓取物体等,这些动作往往涉及连续的动作空间,需要精确的控制。PPO 算法能够直接学习连续动作的策略,通过与环境的交互,不断优化自身策略,使得机器人能够根据不同的环境状态做出准确、平滑的动作决策。在机器人行走过程中,面对不同的地形(如平坦地面、斜坡、崎岖路面等),PPO 算法可以实时调整机器人关节的角度、速度等参数,使机器人保持稳定的行走姿态 。基于模型的强化学习算法在机器人控制中也有应用。当机器人需要在已知环境中执行任务时,如在工厂的固定生产线上作业,基于模型的算法可以通过构建环境模型,提前规划机器人的动作序列,减少实际的探索次数,提高任务执行效率。

4.2 自动驾驶领域

在自动驾驶领域,Actor - Critic 算法,如深度确定性策略梯度(DDPG)算法发挥着重要作用。自动驾驶汽车需要在复杂多变的路况下做出实时决策,包括加速、减速、转向等。DDPG 算法结合了基于策略和基于价值的方法,能够处理连续动作空间,并且通过 Critic 网络对 Actor 网络的策略进行评估和指导,使得自动驾驶汽车能够根据当前的路况(如交通流量、道路状况、其他车辆的行驶状态等),学习到最优的驾驶策略 。在遇到前方车辆突然减速的情况时,DDPG 算法可以快速计算出合适的减速幅度和时机,保证车辆行驶的安全和舒适性 。基于价值的强化学习算法,如深度 Q 网络(DQN)算法,在自动驾驶的某些子任务中也有应用。例如在简单的驾驶场景模拟中,DQN 算法可以通过学习不同状态下的动作价值,实现车辆的基本行驶控制,如在固定路线上保持一定速度行驶、按照交通规则进行简单的转向等。

4.3 游戏领域

在游戏领域,基于模型的强化学习算法和无模型的强化学习算法都有广泛应用。以围棋、象棋等策略性游戏为例,基于模型的算法可以通过构建棋局模型,分析不同落子位置对棋局走势的影响,从而制定出更具战略性的下棋策略 。而在一些复杂的即时战略游戏如《星际争霸》中,无模型的强化学习算法,如 Q - Learning 及其扩展算法,能够让游戏 AI 在不断与环境(对手和游戏地图等)交互的过程中,通过试错学习,逐步掌握游戏的各种策略,如资源采集、基地建设、兵种训练与战斗指挥等 。在游戏初期,AI 可能会随机尝试不同的资源分配和兵种组合方式,根据游戏结果(胜负)获得奖励反馈,逐渐调整策略,最终找到适合不同游戏场景的最优策略。

4.4 推荐系统领域

在推荐系统领域,基于价值的强化学习算法常用于优化推荐策略。以电商推荐系统为例,将用户的浏览历史、购买记录等作为状态,将推荐的商品作为动作,通过学习不同状态下推荐不同商品所获得的用户反馈(如点击率、购买转化率等)作为奖励,来优化推荐策略。通过不断更新 Q 值表,使得推荐系统能够根据用户的实时状态,推荐出最有可能吸引用户的商品 。在用户浏览某类商品页面时,推荐系统可以根据 Q 值选择最相关的其他商品进行推荐,提高用户的购买转化率。一些结合了深度学习的强化学习算法,如基于深度 Q 网络(DQN)的推荐算法,能够更好地处理高维的用户和商品特征数据,通过神经网络自动学习特征之间的复杂关系,从而实现更精准的推荐。

五、总结与展望

强化学习算法作为人工智能领域的关键技术,其分类丰富多样,每种分类下的算法都各具特色。按学习方式可分为基于模型和无模型的强化学习算法;按策略优化方式又可细分为基于价值、基于策略以及 Actor - Critic 算法 。这些算法在机器人控制、自动驾驶、游戏、推荐系统等众多领域都有着广泛且深入的应用,为解决复杂的实际问题提供了强大的工具和有效的解决方案。

展望未来,强化学习算法有望在理论研究和实际应用中取得更加丰硕的成果。在理论层面,如何进一步提高算法的样本效率、稳定性和收敛速度,依然是研究的重点和难点。随着深度学习的不断发展,将强化学习与其他先进的机器学习技术(如迁移学习、元学习、生成对抗网络等)进行有机结合,有望创造出更强大、更智能的算法模型 。在实际应用方面,强化学习将在更多领域发挥重要作用,推动各行业的智能化变革。例如,在医疗领域,强化学习算法可用于优化治疗方案、疾病预测和药物研发;在能源领域,可应用于能源分配、智能电网控制和可再生能源管理;在金融领域,可用于风险评估、投资决策和高频交易等 。

强化学习算法的发展前景广阔,充满无限可能。希望本文能为大家在强化学习算法的学习道路上提供有益的帮助,激发大家对这一领域的探索热情。如果你对强化学习算法感兴趣,不妨深入研究相关文献,尝试动手实践,相信你会在这个充满挑战与机遇的领域中收获颇丰。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)