Transformer架构深度解析:大模型开发必备知识点(收藏)

本文系统介绍了Transformer神经网络架构的核心模块及其PyTorch实现。作为现代大模型的基础,Transformer通过多头注意力机制建立词间全局依赖,摆脱了传统循环结构的限制。文章详细解析了输入嵌入层(含位置编码)、自注意力层、前馈网络层等关键组件,以及残差连接和层归一化两项提升训练稳定性的技术。每个模块都配有数学公式说明和PyTorch实现代码,其中位置编码采用正弦余弦函数实现词序感

1 Transformer 结构

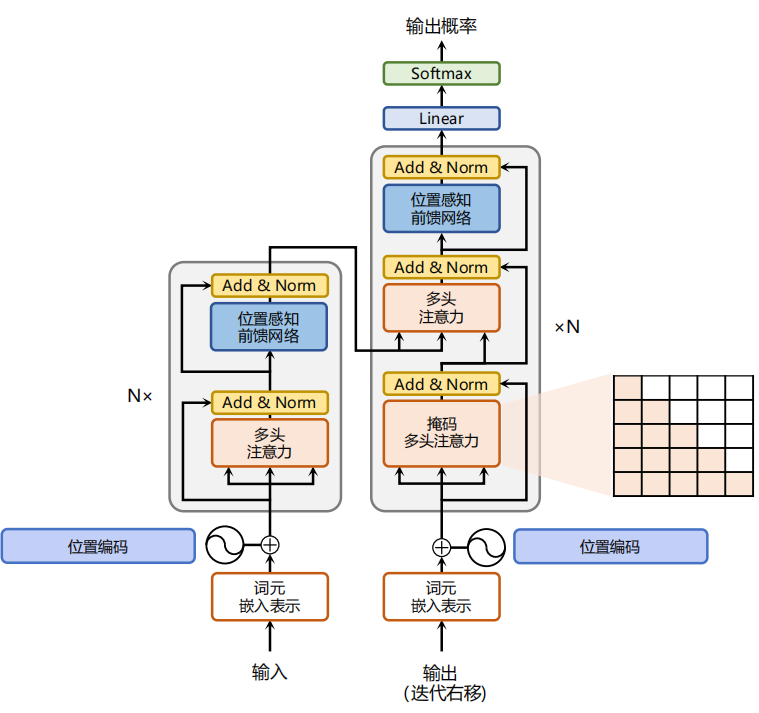

Transformer是Google于2017年提出的神经网络架构,完全基于注意力机制建模序列全局依赖,是现代大模型的基础。它由编码器和解码器组成,每个块包含多头注意力层、前馈网络层、残差连接和层归一化。通过词嵌入和位置编码表示输入,自注意力机制建立词间依赖关系,残差连接和层归一化提升训练稳定性。本文详细介绍了各模块的功能和PyTorch实现代码,是理解大模型原理的重要基础。

-

注意力层

采用多头注意力机制整合上下文语义。多头注意力通过并行运行多个独立注意力机制,从多维度捕获输入序列的信息。该机制允许直接建模序列中任意两个词之间的依赖关系,摒弃传统循环结构,有效解决长程依赖问题。

-

位置感知前馈网络层

通过全连接层对序列中每个词的表示进行复杂的非线性变换。

-

残差连接

对应图中的 Add 部分,是连接注意力层和前馈网络层输入与输出的直连通路,促进信息流动,提升模型优化效率。

-

层归一化

对应图中的 Norm 部分,对注意力层和前馈网络层的输出序列进行归一化处理,进一步稳定模型优化过程。

接下来依次介绍各个模块的具体功能和实现代码:

2 嵌入表示层

在处理输入文本序列时,Transformer 首先会通过输入嵌入层(Input Embedding)将每个单词映射为对应的向量表示。与以往循环结构不同,Transformer 并不依赖顺序建模,因此序列中天然缺乏单词之间的相对位置信息。为了让模型在编码上下文语义之前能够感知词序,需要在词嵌入中加入位置编码(Positional Encoding)。

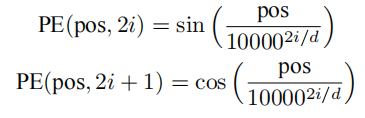

为了得到不同位置所对应的编码,Transformer 结构使用不同频率的正余弦函数,如下所示:

具体来说,序列中每个单词的位置都会生成一个位置向量,并与其词向量相加,再送入后续网络层。训练过程中,模型会逐渐学会利用这部分位置信息。

Transformer 使用不同频率的正弦和余弦函数来计算位置编码,其中 pos 表示单词在序列中的位置,2i 与 2i+1 代表奇数位置和偶数位置,d 表示编码的总维度。这样做有两个好处:

- 正弦和余弦函数的取值范围在 [−1, +1],与原始词嵌入相加后不会显著偏离,从而保留了单词的语义信息。

- 由于三角函数的线性关系,第

pos + k个位置的编码可以由第pos个位置的编码线性表示,这意味着位置编码中自然包含了单词之间的距离信息。

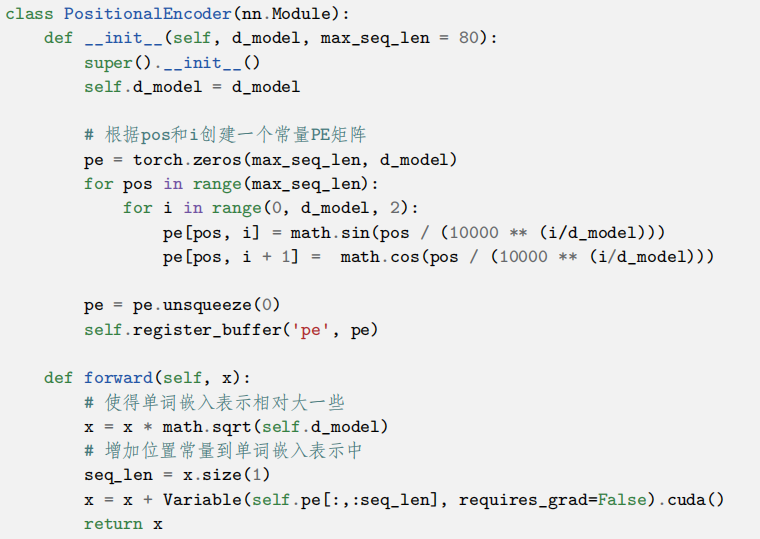

使用 PyTorch 实现的位置编码参考代码如下:

3 注意力层

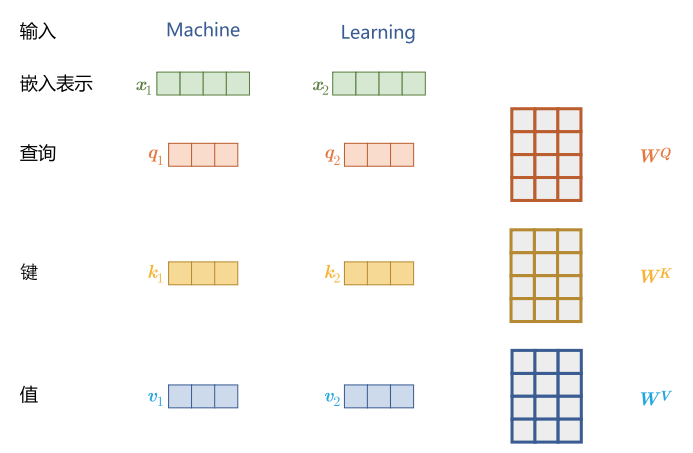

自注意力机制(Self-Attention)是 Transformer 模型中的核心运算,广泛应用于源语言的编码和目标语言的生成过程。它的主要作用是建立序列中任意两个单词之间的依赖关系。

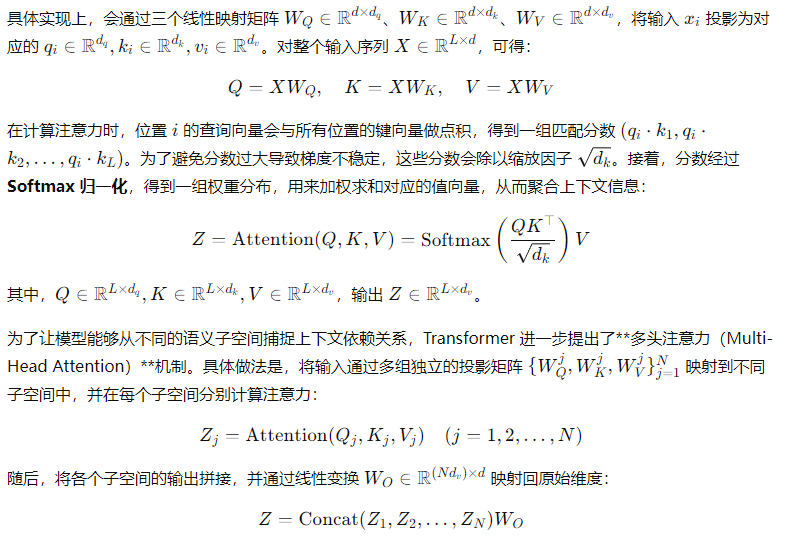

首先,输入的每个单词通过词向量嵌入与位置编码相加后得到表示 xi∈Rd(Rd为嵌入矩阵)。为了捕捉上下文的依赖信息,Transformer 在每个单词的表示中引入三个关键向量:查询(Query, Qi)、键(Key, Ki)和值(Value, Vi)。它们反映了当前单词在计算表示时,对序列中其他单词应当分配多少注意力权重。

由此可见,自注意力机制使模型能够识别不同输入部分的重要性,而不受距离的影响,从而能够捕捉输入句子中的长距离依赖关系和复杂关系。

使用 PyTorch 实现的自注意力层参考代码如下:

classMultiHeadAttention(nn.Module):

4 前馈层

前馈层接收自注意力子层的输出作为输入,并通过一个带有 ReLU 激活函数的两层全连接网络对输入进行更复杂的非线性变换。实验证明,这一非线性变换会对模型最终的性能产生重要的影响。

计算公式 为:

FFN(x) = ReLU(xW1 + b1)W2 + b2

其中(xW1 + b1)表示上一层前馈子层的计算结果。实验结果表明,增大前馈子层隐状态的维度有利于提高最终翻译结果的质量,因此,前馈子层隐状态的维度一般比自注意力子层要大。

classFeedForward(nn.Module):

5 残差连接与层归一化

由 Transformer 结构构建的网络通常规模庞大,编码器和解码器都由多层堆叠的基本 Transformer 块组成。由于每一层内部都包含复杂的非线性映射,训练过程往往比较困难。为提升训练的稳定性,研究人员在 Transformer 块中引入了残差连接(Residual Connection)和层归一化(Layer Normalization)两项技术。

其中,残差连接通过在子层的输入与输出之间添加一条直接的捷径,使得输入能够绕过复杂的非线性变换直接传递到输出。这一机制能够有效缓解深层网络中的梯度消失问题,从而保证训练的可优化性。

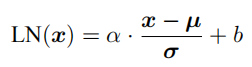

另一方面,层归一化用于保证每一层输入与输出的数值分布稳定在合理范围内。其计算方式为:

其中,μ和 σ 分别表示输入的均值和标准差,用于将数据归一化到均值为 0、方差为 1 的标准分布;α和 b是可学习参数,用于恢复模型所需的表示能力。层归一化不仅能减少训练中的数值不稳定,还能加快收敛速度。

classNorm(nn.Module):

以上就是transformer各模块的代码示意,可见pytorch封装度非常高,使用pytorch可以轻松实现。

读者福利大放送:如果你对大模型感兴趣,想更加深入的学习大模型**,那么这份精心整理的大模型学习资料,绝对能帮你少走弯路、快速入门**

如果你是零基础小白,别担心——大模型入门真的没那么难,你完全可以学得会!

👉 不用你懂任何算法和数学知识,公式推导、复杂原理这些都不用操心;

👉 也不挑电脑配置,普通家用电脑完全能 hold 住,不用额外花钱升级设备;

👉 更不用你提前学 Python 之类的编程语言,零基础照样能上手。

你要做的特别简单:跟着我的讲解走,照着教程里的步骤一步步操作就行。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

现在这份资料免费分享给大家,有需要的小伙伴,直接VX扫描下方二维码就能领取啦😝↓↓↓

为什么要学习大模型?

数据显示,2023 年我国大模型相关人才缺口已突破百万,这一数字直接暴露了人才培养体系的严重滞后与供给不足。而随着人工智能技术的飞速迭代,产业对专业人才的需求将呈爆发式增长,据预测,到 2025 年这一缺口将急剧扩大至 400 万!!

大模型学习路线汇总

整体的学习路线分成L1到L4四个阶段,一步步带你从入门到进阶,从理论到实战,跟着学习路线一步步打卡,小白也能轻松学会!

大模型实战项目&配套源码

光学理论可不够,这套学习资料还包含了丰富的实战案例,让你在实战中检验成果巩固所学知识

大模型学习必看书籍PDF

我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

大模型超全面试题汇总

在面试过程中可能遇到的问题,我都给大家汇总好了,能让你们在面试中游刃有余

这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

👉获取方式:

😝有需要的小伙伴,可以保存图片到VX扫描下方二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最适合零基础的!!

更多推荐

已为社区贡献13条内容

已为社区贡献13条内容

所有评论(0)