大模型应用开发面试指南:LangChain与LlamaIndex核心知识点详解

本文是一份全面的大模型应用开发面试资料,重点介绍了LangChain和LlamaIndex两大框架的核心概念与应用。详细解释了LangChain的六大核心组件、LCEL优势、Agent执行流程及RAG实现方法,同时对比了LlamaIndex作为数据层专家的特点。文档还涵盖了文档切分策略、RAG效果评估及ReAct框架实现等实用技术,为开发者提供构建大模型应用的完整知识体系和面试准备指南。

本文是一份全面的大模型应用开发面试资料,重点介绍了LangChain和LlamaIndex两大框架的核心概念与应用。详细解释了LangChain的六大核心组件、LCEL优势、Agent执行流程及RAG实现方法,同时对比了LlamaIndex作为数据层专家的特点。文档还涵盖了文档切分策略、RAG效果评估及ReAct框架实现等实用技术,为开发者提供构建大模型应用的完整知识体系和面试准备指南。

1. 什么是LangChain?它的核心设计理念是什么?

答案:

LangChain是一个用于开发由大语言模型驱动的应用程序的框架。它的核心设计理念是通过“可组合性”将多个模块链接在一起,构建复杂而强大的应用。

-

•

核心价值:它简化了与大模型交互的流程,并提供了与外部数据源、工具(API、函数)和内存集成的标准化接口。

-

•

类比:就像

React用于构建用户界面一样,LangChain是用于构建大模型应用界面的工具链。

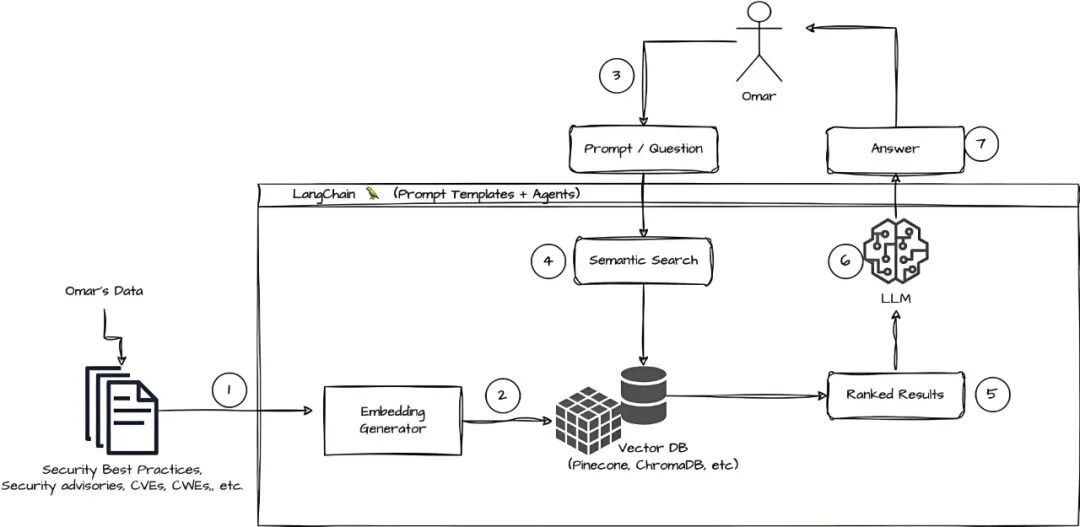

▲LangChain如何作为连接LLM与外部世界(数据、工具)的桥梁和协调中心

2. 请解释LangChain中的6个核心概念:Models, Prompts, Indexes, Memory, Chains, Agents。

答案:

-

Models (模型): 与各种大语言模型交互的抽象层,如ChatGPT、LLaMA等。提供了

LLM(文本进-文本出)和ChatModels(消息进-消息出)两种接口。 -

Prompts (提示): 管理、优化和模板化提示词的模块。包括

PromptTemplate、FewShotPromptTemplate等,允许动态注入上下文和用户输入。 -

Indexes (索引): 用于处理外部数据的工具,主要用于文档的检索。常与

Retrieval模块结合,构成RAG应用的核心。 -

Memory (记忆): 在链或代理的多次调用之间持久化状态(如对话历史)。有

ConversationBufferMemory、ConversationSummaryMemory等多种形式。 -

Chains (链): 核心思想。将多个组件(或多个LLM调用)按预定顺序链接起来,完成一个特定任务。

LCEL (LangChain Expression Language)是构建链的声明式方式。 -

Agents (代理): 更高级的“链”。由LLM作为大脑,动态决定执行一系列

Tools(工具)的步骤和顺序,以完成用户复杂的请求(如“今天天气如何?然后用英文总结一下”)。

3. 什么是LCEL?它有什么优势?请写一个简单的例子。

答案:

LCEL(LangChain Expression Language)是一种声明式的、可组合的语法,用于轻松地构建和部署链。

- 优势:

-

•

统一接口: 所有LCEL对象都实现了

Runnable接口,具有统一的invoke,batch,stream,astream方法。 -

•

自动流输出: 无需额外代码即可实现 token 的流式传输。

-

•

强大的并行: 使用

batch可以并行处理多个输入。 -

•

可靠性: 内置故障重试、回退机制。

示例:

from langchain_core.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

from langchain_core.output_parsers import StrOutputParser

# 使用 LCEL 声明一个链:Prompt -> Model -> OutputParser

chain = (

ChatPromptTemplate.from_messages([("system", "你是一个助手"), ("user", "{input}")])

| ChatOpenAI(model="gpt-3.5-turbo")

| StrOutputParser()

)

# 调用链

result = chain.invoke({"input": "你好吗?"})

print(result)

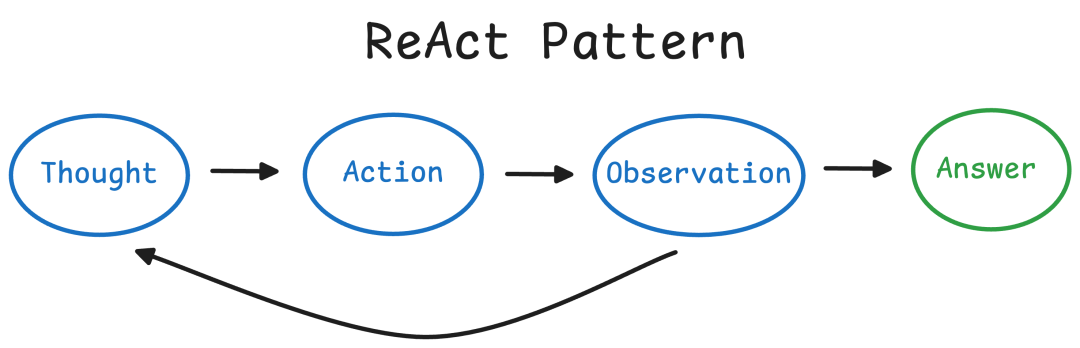

4. 请详细解释Agent的执行流程(使用ReAct框架举例)。

答案:

Agent的执行是一个循环过程,其核心是 “思考 -> 行动 -> 观察”(ReAct框架)。

-

用户输入: 用户提出一个复杂问题,例如“What was the high temperature in SF yesterday in Fahrenheit?”。

-

Agent初始化: 将问题、可用工具列表和ReAct指令模板组合成初始提示,发送给LLM。

-

循环开始:

-

•

Step 1: Think - LLM根据当前信息思考下一步该做什么。它会输出一个

Thought:,例如“I need to find the weather for yesterday in SF.” -

•

Step 2: Act - LLM决定使用哪个工具(

Action)以及输入是什么(Action Input)。例如Action: weather_search,Action Input: San Francisco, yesterday。

-

工具执行: LangChain调用指定的

weather_search工具,并获取结果(Observation:),例如“High: 65°F, Low: 52°F”。 -

信息整合: 将

Thought,Action,Observation加入到新的提示上下文中,再次发送给LLM。 -

循环判断: LLM根据现有信息判断是否已经得到最终答案。如果已经得到,则输出

Final Answer: 65°F;如果还需要更多信息,则回到Step 1继续循环。

▲ReAct工作流程

5. 什么是RAG?如何在LangChain中实现一个基本的RAG流程?

答案:

****RAG (Retrieval-Augmented Generation): 检索增强生成。通过在生成答案前先从外部知识库中检索相关信息,并将其作为上下文提供给LLM,从而让LLM生成更准确、更符合事实的答案,并减少幻觉。

- 在LangChain中的实现步骤:

-

加载文档 (Document Loading): 使用

TextLoader,WebBaseLoader等加载源文档。 -

文档切分 (Splitting): 使用

RecursiveCharacterTextSplitter将长文档切分为小的、有重叠的块(Chunks)。 -

向量化嵌入 (Embedding): 使用

OpenAIEmbeddings等模型将文本块转换为向量(Vector Embeddings)。 -

存储索引 (Indexing): 将向量存储在向量数据库(VectorStore)中,如Chroma, Pinecone,并创建索引。

-

检索 (Retrieval): 用户提问时,将问题也向量化,并从向量库中检索出最相关的

k个文本块。 -

生成 (Generation): 将检索到的文本块作为上下文,与原始问题组合成一个增强的提示(Prompt),发送给LLM生成最终答案。

代码示例:

from langchain_community.document_loaders import WebBaseLoader

from langchain_text_splitters import RecursiveCharacterTextSplitter

from langchain_openai import OpenAIEmbeddings, ChatOpenAI

from langchain_chroma import Chroma

from langchain_core.prompts import ChatPromptTemplate

from langchain.chains import create_retrieval_chain

# 1. 加载 & 2. 切分

loader = WebBaseLoader("https://example.com/article")

docs = loader.load()

text_splitter = RecursiveCharacterTextSplitter(chunk_size=1000, chunk_overlap=200)

splits = text_splitter.split_documents(docs)

# 3. 嵌入 & 4. 存储

embeddings = OpenAIEmbeddings()

vectorstore = Chroma.from_documents(documents=splits, embedding=embeddings)

retriever = vectorstore.as_retriever()

# 5. & 6. 组成RAG链

llm = ChatOpenAI(model="gpt-3.5-turbo")

prompt = ChatPromptTemplate.from_template(

"""请根据以下上下文回答問題:

{context}

问题:{input}"""

)

rag_chain = create_retrieval_chain(retriever, llm, prompt)

result = rag_chain.invoke({"input": "文章的主要观点是什么?"})

6. LlamaIndex的核心价值是什么?它与LangChain的主要区别在哪?

答案:

核心价值: LlamaIndex是专门为LLM应用的数据层而设计的框架。它擅长高效地将私有或领域的特定数据与LLM连接起来,是构建RAG应用的专家和利器。它的口号是“为你的数据提供LLM接口”。

主要区别:

| 特性 | LlamaIndex | LangChain |

|---|---|---|

| 焦点 | 数据连接与检索 (RAG专家) | 应用编排与代理 (通用型框架) |

| 核心功能 | 数据索引、高级查询、结构化数据提取 | 链、代理、工具、内存管理 |

| 设计哲学 | 提供强大、开箱即用的数据管道 | 提供高度灵活、可组合的底层组件 |

| 关系 | 可以作为LangChain的一个组件(LlamaIndexRetriever) |

包含并集成多种数据检索方式 |

简单说:如果你想快速、深度地构建一个以数据检索为核心的RAG应用,LlamaIndex更强大。如果你需要构建一个包含多种步骤(如调用API、逻辑判断、记忆)的复杂代理,LangChain更合适。 两者经常结合使用。

7. 解释LlamaIndex中的核心组件:Nodes, Indexes, Engines。

答案:

-

Nodes: 是

Document对象的基本构建块。一个Node包含一段文本及其元数据。文档在被索引前会被解析和切分为多个Nodes。 -

Indexes: 是核心数据结构,用于组织

Nodes以便LLM高效查询。最常见的索引是向量存储索引 (Vector Store Index)。 -

Engines: 为查询索引提供接口。不同类型的索引有不同的引擎。例如:

-

•

Query Engine: 是查询索引的高级抽象,接受自然语言查询并返回响应。 -

•

Chat Engine: 支持多轮、有状态的对话,内置了聊天历史管理。

8. LlamaIndex有哪些高级查询/检索模式?

答案:

除了简单的“问-答”检索,LlamaIndex提供了多种强大模式:

-

•

子查询 (Sub-Queries): 将一个复杂问题分解为多个子问题,逐一查询后再综合答案。

-

•

多步查询 (Multi-Step Queries): 类似于子查询,但步骤间可以传递和迭代信息。

-

•

假设查询 (Hypothetical Queries): 给定一个查询,让LLM生成假设性的文档/答案,然后用这些假设文档去优化真正的检索。(

HyDE) -

•

基于时间的查询: 对具有时间戳的文档进行检索,优先返回最新的信息。

-

•

结构化数据提取: 从非结构化文本中提取出结构化的信息(如JSON格式)。

9. 在RAG中,文档切分(Chunking)为什么重要?有哪些策略?

答案:

重要性:

-

•

LLM有上下文窗口限制,必须将长文档切块。

-

•

切分的大小和质量直接影响检索精度。块太大,会包含无关信息;块太小,可能会丢失关键上下文。

-

•

合理的重叠(Overlap)可以避免句子或段落被割裂,保持语义完整性。

-

策略:

-

•

固定大小分块: 最简单,但可能割裂语义。

-

•

递归分块: 按字符递归地尝试不同分隔符(如

\n\n,\n, ),直到达到理想块大小。这是最常用的策略。 -

•

语义分块: 使用嵌入模型计算句子相似度,在语义变化处进行切分。(更高级但更复杂)

-

•

专用分块: 对于代码(按函数/类)、Markdown(按标题)等特定格式有专用分块器。

10. 如何评估和提升RAG应用的效果?

答案:

-

•

评估指标:

-

•

检索精度: 检索到的上下文是否与问题相关?(Hit Rate, MRR@k, NDCG@k)

-

•

生成质量: 答案是否准确、相关、流畅?(可以通过LLM-as-a-judge或人工评估)

-

•

真实性: 答案是否减少了幻觉?

提升策略:

-

•

优化检索:

-

•

调整分块大小和重叠。

-

•

尝试不同的嵌入模型(如

text-embedding-3-large)。 -

•

使用重排序(Re-Ranker)模型对检索结果进行精排,提升Top结果的准确性。

-

•

使用混合搜索(Hybrid Search),结合关键词(稀疏向量)和语义(稠密向量)检索。

-

•

优化生成:

-

•

优化提示工程,改进上下文的使用方式。

-

•

让模型在无法从上下文中找到答案时回答“我不知道”。

-

•

优化索引:

-

•

确保源数据质量高、干净。

-

•

为文档添加高质量的元数据(如标题、日期),便于元数据过滤查询。

11. 什么是ReAct框架?如何在LangChain中实现一个自定义Tool?

答案:

-

•

ReAct框架:

Reason+Act。它指导LLM在解决问题时进行推理(生成思考轨迹)并行动(调用工具)。详见第4题。 -

•

实现自定义Tool:

需要定义一个继承

BaseTool的类,并实现_run同步方法和/或_arun异步方法。

from langchain.tools import BaseTool

from typing import Optional

class CustomCalculatorTool(BaseTool):

name = "calculator"

description = "Useful for when you need to calculate a math problem"

def _run(self, query: str) -> str:

"""同步执行工具的方法"""

try:

# 这里应该是安全的计算逻辑,例如使用eval不安全,此处仅为示例

return str(eval(query))

except:

return"计算错误"

async def _arun(self, query: str) -> str:

"""异步执行工具的方法(可选)"""

raise NotImplementedError("此工具不支持异步调用")

# 在Agent中初始化并使用

tools = [CustomCalculatorTool()]

agent = initialize_agent(tools, llm, agent="react-docstore", verbose=True)

agent.run("What is 15 raised to the power of 2?")

随着大模型的持续火爆,各行各业纷纷开始探索和搭建属于自己的私有化大模型,这无疑将催生大量对大模型人才的需求,也带来了前所未有的就业机遇。**正如雷军所说:“站在风口,猪都能飞起来。”**如今,大模型正成为科技领域的核心风口,是一个极具潜力的发展机会。能否抓住这个风口,将决定你是否能在未来竞争中占据先机。

那么,我们该如何学习大模型呢?

人工智能技术的迅猛发展,大模型已经成为推动行业变革的核心力量。然而,面对复杂的模型结构、庞大的参数量以及多样的应用场景,许多学习者常常感到无从下手。作为一名热心肠的互联网老兵,我决定把宝贵的AI知识分享给大家。

为此,我们整理了一份全面的大模型学习路线,帮助大家快速梳理知识,形成自己的体系。我已将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

一、大模型全套的学习路线

大型预训练模型(如GPT-3、BERT、XLNet等)已经成为当今科技领域的一大热点。这些模型凭借其强大的语言理解和生成能力,正在改变我们对人工智能的认识。为了跟上这一趋势,越来越多的人开始学习大模型,希望能在这一领域找到属于自己的机会。

L1级别:启航篇 | 极速破界AI新时代

- AI大模型的前世今生:了解AI大模型的发展历程。

- 如何让大模型2C能力分析:探讨大模型在消费者市场的应用。

- 行业案例综合分析:分析不同行业的实际应用案例。

- 大模型核心原理:深入理解大模型的核心技术和工作原理。

L2阶段:攻坚篇 | RAG开发实战工坊

- RAG架构标准全流程:掌握RAG架构的开发流程。

- RAG商业落地案例分析:研究RAG技术在商业领域的成功案例。

- RAG商业模式规划:制定RAG技术的商业化和市场策略。

- 多模式RAG实践:进行多种模式的RAG开发和测试。

L3阶段:跃迁篇 | Agent智能体架构设计

- Agent核心功能设计:设计和实现Agent的核心功能。

- 从单智能体到多智能体协作:探讨多个智能体之间的协同工作。

- 智能体交互任务拆解:分解和设计智能体的交互任务。

- 10+Agent实践:进行超过十个Agent的实际项目练习。

L4阶段:精进篇 | 模型微调与私有化部署

- 打造您的专属服务模型:定制和优化自己的服务模型。

- 模型本地微调与私有化:在本地环境中调整和私有化模型。

- 大规模工业级项目实践:参与大型工业项目的实践。

- 模型部署与评估:部署和评估模型的性能和效果。

专题集:特训篇

- 全新升级模块:学习最新的技术和模块更新。

- 前沿行业热点:关注和研究当前行业的热点问题。

- AIGC与MPC跨领域应用:探索AIGC和MPC在不同领域的应用。

掌握以上五个板块的内容,您将能够系统地掌握AI大模型的知识体系,市场上大多数岗位都是可以胜任的。然而,要想达到更高的水平,还需要在算法和实战方面进行深入研究和探索。

- AI大模型学习路线图

- 100套AI大模型商业化落地方案

- 100集大模型视频教程

- 200本大模型PDF书籍

- LLM面试题合集

- AI产品经理资源合集

以上的AI大模型学习路线,不知道为什么发出来就有点糊,高清版可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

二、640套AI大模型报告合集

这套包含640份报告的合集,全面覆盖了AI大模型的理论探索、技术落地与行业实践等多个维度。无论您是从事科研工作的学者、专注于技术开发的工程师,还是对AI大模型充满兴趣的爱好者,这套报告都将为您带来丰富的知识储备与深刻的行业洞察,助力您更深入地理解和应用大模型技术。

三、大模型经典PDF籍

随着人工智能技术的迅猛发展,AI大模型已成为当前科技领域的核心热点。像GPT-3、BERT、XLNet等大型预训练模型,凭借其卓越的语言理解与生成能力,正在重新定义我们对人工智能的认知。为了帮助大家更高效地学习和掌握这些技术,以下这些PDF资料将是极具价值的学习资源。

四、AI大模型商业化落地方案

AI大模型商业化落地方案聚焦于如何将先进的大模型技术转化为实际的商业价值。通过结合行业场景与市场需求,该方案为企业提供了从技术落地到盈利模式的完整路径,助力实现智能化升级与创新突破。

希望以上内容能对大家学习大模型有所帮助。如有需要,请微信扫描下方CSDN官方认证二维码免费领取相关资源【保证100%免费】。

祝大家学习顺利,抓住机遇,共创美好未来!

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)