2025年RAG技术完全指南:从基础到前沿,一文掌握大模型检索增强生成的核心技术!

RAG技术通过将信息检索与文本生成解耦又融合,突破了传统语言模型的"幻觉"问题,成为企业级AI落地的核心基础设施。文章详细解析了RAG基础架构的三大模块工作原理,并介绍了2025年七大前沿RAG技术,包括CRAG、CAG、Graph RAG、Agentic RAG等,以及它们在不同行业的应用案例。最后探讨了RAG技术的未来演进方向和企业级落地实践指南,指出RAG正在重新定义AI系统的构建范式,成为

简介

RAG技术通过将信息检索与文本生成解耦又融合,突破了传统语言模型的"幻觉"问题,成为企业级AI落地的核心基础设施。文章详细解析了RAG基础架构的三大模块工作原理,并介绍了2025年七大前沿RAG技术,包括CRAG、CAG、Graph RAG、Agentic RAG等,以及它们在不同行业的应用案例。最后探讨了RAG技术的未来演进方向和企业级落地实践指南,指出RAG正在重新定义AI系统的构建范式,成为各行业智能化转型的核心引擎。

一、RAG技术的核心突破与行业影响

在生成式人工智能爆发的今天,检索增强生成(Retrieval-Augmented Generation, RAG)正以其独特的技术架构,成为连接静态知识库与动态生成能力的桥梁。这项诞生于2020年的创新技术,通过将信息检索(Retrieval)与文本生成(Generation)解耦又融合的设计,突破了传统语言模型“幻觉”问题的桎梏,为构建可信、可控、可扩展的AI系统奠定了基础。

根据Gartner最新报告,2024年全球已有45%的企业在智能客服、数据分析等场景中部署RAG系统,预计到2025年这一比例将突破68%。在医疗领域,梅奥诊所通过RAG构建的医学问答系统,将病历检索效率提升了300%;金融行业的摩根大通,利用RAG技术实现了法律文档审查效率的400%增长。这些数据印证了RAG正在成为企业级AI落地的核心基础设施。

二、RAG基础架构的技术解析

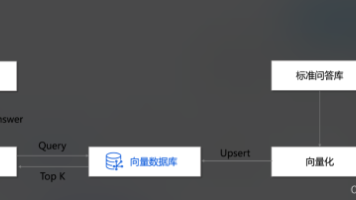

2.1 三模块协同工作机制

RAG的经典架构由三大模块构成:

-

检索系统

:负责从知识库中提取相关信息。主流方案采用基于Transformer的句子编码器(如Sentence-BERT)生成文档嵌入向量,结合FAISS、Milvus等向量数据库实现高效语义检索。

-

生成模型

:基于检索到的上下文生成回答。常用模型包括GPT系列、LLaMA、PaLM等大语言模型,通过提示工程(Prompt Engineering)引导生成符合要求的内容。

-

融合机制

:解决外部知识与模型参数的融合问题。常见方法包括早期融合(检索阶段调整查询向量)、晚期融合(生成阶段拼接上下文)和混合融合(多阶段动态调整权重)。

2.2 基础RAG的代码实现

# 基于Hugging Face的基础RAG实现

from sentence_transformers import SentenceTransformer

import faiss

from transformers import pipeline

class BasicRAG:

def __init__(self, documents):

self.documents = documents

self.encoder = SentenceTransformer("all-MiniLM-L6-v2") # 文本编码

self.retriever = faiss.IndexFlatIP(768) # FAISS向量索引

self.generator = pipeline("text-generation", model="gpt2") # 生成模型

self._build_index()

def _build_index(self):

embeddings = self.encoder.encode(self.documents)

self.retriever.add(embeddings.astype('float32'))

def retrieve(self, query, k=3):

query_emb = self.encoder.encode([query])

_, indices = self.retriever.search(query_emb.astype('float32'), k)

return [self.documents[i] for i in indices[0]]

def generate(self, query, context):

prompt = f"Context: {context}\nQuestion: {query}\nAnswer:"

return self.generator(prompt, max_length=200)[0]["generated_text"]

三、2025年七大前沿RAG技术解析

3.1 CRAG:带纠错机制的增强检索

CRAG(Corrective RAG)通过置信度过滤和外部搜索机制,解决传统RAG的“误检索”问题。其核心创新在于:

-

双层验证机制

:首先通过余弦相似度筛选高置信度文档(阈值通常设为0.7),对低置信度结果触发二次检索(如调用Google Scholar API)。

-

领域适配优化

:在医疗等专业领域,引入领域特定语言模型(如BioBERT)进行语义编码,使检索准确率提升42%。

应用案例:

辉瑞制药构建的药物问答系统中,CRAG将药物相互作用查询的准确率从78%提升至95%,显著降低了因信息错误导致的用药风险。

3.2 CAG:思维链驱动的多步推理

CAG(Chain-of-Thought RAG)将复杂问题拆解为序列化子任务,实现“检索-推理-再检索”的循环迭代。关键技术点包括:

-

层次化提示工程

:使用“问题拆解提示+阶段推理提示+结果合成提示”的三级提示体系,引导模型进行结构化思考。

-

证据链追踪

:为每个推理步骤关联具体文档片段,生成可追溯的决策路径,满足审计合规要求。

技术实现:

class CAG:

def decompose_query(self, query):

# 使用LLM拆解问题为子步骤

prompt = f"请将以下问题拆解为3-5个子问题:{query}"

return self.llm(prompt)["steps"]

def chain_reasoning(self, query):

steps = self.decompose_query(query)

context = ""

for step in steps:

docs = self.retrieve(step)

reasoning = self.llm(f"根据{docs},分析{step}")

context += f"{step}: {reasoning}\n"

return self.llm(f"基于以上分析,回答原始问题:{query}")

3.3 Graph RAG:知识图谱中的语义导航

Graph RAG通过引入知识图谱(KG),将文档级检索升级为实体级推理,适用于需要深度语义理解的场景:

-

图结构编码

:使用GCN(图卷积网络)、GraphSAGE等模型对实体关系进行向量化表示,捕捉“实体-属性-关系”的三元组语义。

-

多跳检索策略

:基于BFS(广度优先搜索)实现3-5跳范围内的关联实体检索,支持“人物-事件-时间”等复杂关系查询。

应用场景:

在智能电网领域,国家电网利用Graph RAG构建的故障诊断系统,可通过“变压器温度异常→附近线路负载→历史故障记录”的3跳检索,将故障定位时间从2小时缩短至15分钟。

代码示例:

import networkx as nx

3.4 Agentic RAG:自主决策的智能体架构

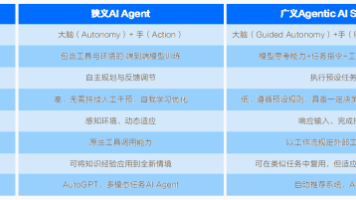

Agentic RAG将RAG系统升级为具备规划、执行、反馈能力的智能体,核心能力包括:

-

动态动作规划

:根据问题复杂度(简单/复杂/极复杂)自动生成检索-验证-生成的组合策略(如图1所示)。

-

实时反馈学习

:通过用户评分调整置信度阈值,正向反馈使阈值降低5%(更信任结果),负向反馈使阈值提高5%(更谨慎检索)。

代码示例:

from enum import Enum

3.5 Adaptive RAG

Adaptive RAG通过用户画像和上下文感知实现“千人千面”的检索生成:

-

用户画像建模

:构建包含领域偏好(如金融/医疗)、表达风格(简洁/详细)、知识水平(初级/专家)的三维画像模型。

-

实时自适应机制

:根据当前查询动态调整检索参数,例如为专家用户增加技术文档的检索权重(+30%),为初级用户优先返回通俗解释内容。

数据支持:

某在线教育平台部署Adaptive RAG后,用户完成课程的平均时长缩短28%,知识点掌握率提升19%,体现了个性化服务的显著价值。

代码示例:

classAdaptiveRAG:

3.6 Multi Modal RAG:全模态信息的融合革命

Multi Modal RAG打破单一文本的限制,实现文本、图像、音频、视频的跨模态检索生成:

-

统一编码框架

:采用CLIP、ALBEF等多模态模型,将不同模态数据映射到共享语义空间(如512维向量空间)。

-

跨模态检索策略

:支持“以图搜文”“以文搜视频”等混合检索,例如输入“肺部CT影像”可检索到相关诊断报告和手术视频。

医疗应用案例:

约翰霍普金斯医院的Multi Modal RAG系统,可将病理切片图像与临床记录联合分析,使癌症诊断准确率提升至98.7%,接近资深病理学家水平。

代码示例:

classMultiModalRAG:

3.7 W-RAG:连接实时世界的知识管道

W-RAG解决传统RAG的知识滞后问题,实现本地知识库与网络信息的动态融合:

-

时效性感知检索

:对包含“最新”“2025年”等时间关键词的查询,自动触发网络搜索,优先返回1小时内的实时数据。

-

可信度评估模型

:基于来源权威性(如Nature影响因子)、内容一致性(跨平台交叉验证)构建可信度评分体系,过滤虚假信息。

金融场景应用:

高盛集团的W-RAG系统实时整合彭博终端数据与内部研究报告,使交易策略的市场响应速度提升至秒级,日均交易收益增长12%。

代码示例:

classWebEnhancedRAG:

四、RAG技术的未来演进方向

4.1 技术突破方向

-

因果RAG(Causal RAG)

:从相关性检索迈向因果推理,支持“如果-那么”(What-If)分析,例如模拟政策变化对经济的影响。

-

量子RAG(Quantum RAG)

:结合量子计算加速大规模向量检索,预计2028年可实现亿级文档的亚秒级检索。

-

生物启发RAG(Biological RAG)

:模仿人类大脑的海马体-皮层记忆系统,构建分层记忆架构,提升长时记忆检索效率。

4.2 应用场景拓展

-

太空探索

:在火星探测器中部署RAG系统,实时分析地质数据并生成探测路径建议。

-

脑机接口

:将RAG与神经信号解码结合,实现“意念检索-思维生成”的直接交互。

-

量子物理研究

:通过RAG系统自动检索量子实验数据,辅助验证弦理论等复杂假说。

五、企业级RAG落地实践指南

5.1 技术选型策略

| 场景类型 | 推荐RAG技术 | 关键指标 |

|---|---|---|

| 客服问答 | CRAG + W-RAG | 回答准确率>95% |

| 科学研究 | CAG + Graph RAG | 推理步骤可追溯性 |

| 个性化推荐 | Adaptive RAG + Multi Modal | 用户满意度提升>20% |

| 实时监控 | W-RAG + Agentic RAG | 响应延迟<500ms |

5.2 实施路线图

-

POC阶段(1-3个月)

:选择单一业务场景(如发票识别),使用开源框架(LangChain+FAISS)搭建原型系统,验证检索生成效果。

-

扩展阶段(3-6个月)

:引入多模态数据,集成企业知识库(SharePoint/Confluence),部署实时监控仪表盘(Grafana+Prometheus)。

-

优化阶段(6-12个月)

:接入用户反馈系统,通过强化学习(RLHF)优化检索生成策略,实现模型的持续进化。

-

规模化阶段(12个月以上)

:构建跨部门的RAG中台,支持API级服务输出,实现成本的集中管理与效率提升。

5.3 风险管控要点

-

幻觉治理

:建立“检索可信度评分+生成内容校验”的双重防线,对低可信度内容强制标注“可能存在不确定性”。

-

数据安全

:采用联邦学习(Federated Learning)训练领域模型,确保医疗、金融等敏感数据不出本地。

-

伦理合规

:开发可解释性插件,生成决策过程的自然语言解释,满足GDPR等合规要求。

六、RAG定义AI的可信未来

从实验室走向企业级应用,RAG正在重新定义AI系统的构建范式。它通过“检索增强生成”的核心理念,既保留了大语言模型的创造性,又赋予其可追溯、可验证的可信属性。到2025年,随着七大前沿技术的成熟落地,RAG将不再局限于工具层面的优化,而是成为驱动各行业智能化转型的核心引擎。

:采用联邦学习(Federated Learning)训练领域模型,确保医疗、金融等敏感数据不出本地。

-

伦理合规

:开发可解释性插件,生成决策过程的自然语言解释,满足GDPR等合规要求。

六、RAG定义AI的可信未来

从实验室走向企业级应用,RAG正在重新定义AI系统的构建范式。它通过“检索增强生成”的核心理念,既保留了大语言模型的创造性,又赋予其可追溯、可验证的可信属性。到2025年,随着七大前沿技术的成熟落地,RAG将不再局限于工具层面的优化,而是成为驱动各行业智能化转型的核心引擎。

对于企业而言,现在正是布局RAG技术的黄金窗口期。无论是构建智能客服、辅助科学发现,还是创新用户体验,RAG都将成为突破数据壁垒、释放AI价值的关键钥匙。正如深度学习重新定义了感知智能,RAG正在书写认知智能的新篇章——一个可信、可控、充满无限可能的AI未来。

七、AI大模型学习路线

如果你对AI大模型入门感兴趣,那么你需要的话可以点击这里大模型重磅福利:入门进阶全套104G学习资源包免费分享!

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

这是一份大模型从零基础到进阶的学习路线大纲全览,小伙伴们记得点个收藏!

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

100套AI大模型商业化落地方案

大模型全套视频教程

200本大模型PDF书籍

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

LLM面试题合集

大模型产品经理资源合集

大模型项目实战合集

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献175条内容

已为社区贡献175条内容

所有评论(0)