猫头虎推荐:人类通向AGI之路 史上最重磅的20篇论文你值得学习

回顾过去十几年的研究历程,我们可以看到AI技术从基础研究到实际应用的不断演进。这些里程碑式的论文不仅是科学研究的成果,更是商业应用的指南,为AI技术的快速发展奠定了坚实的基础。展望未来,随着更多新技术和新方法的出现,AI将在各个领域实现颠覆性飞跃。从专注于单一任务的模型到多模态通用助手,AI的未来充满了无限可能。关注猫头虎技术团队,持续获取AI领域的最新动态,和我们一起探索未来的科技之路!

猫头虎推荐:人类通向AGI之路 史上最重磅的20篇论文你值得学习

👋 大家好,我是猫头虎,今天我们为大家带来一篇穿越时空的AI研究大作!这篇文章将带你领略过去15年推动人工智能(AI)发展的20篇经典论文,这些论文不仅在学术界激起千层浪,更启发了无数创业者和科技公司,推动了今天AI技术的蓬勃发展。

近年来,随着ChatGPT的横空出世,AI技术几乎无处不在。但你知道吗?这些令人瞩目的成果背后,是多年研究与探索的累积。今天我们将带你回顾这段不凡的历程,一起探索人工智能通向AGI(通用人工智能)的道路。

一、AI领域的四波浪潮 🌊

在过去的15年里,人工智能经历了四次主要的研究浪潮,每一波浪潮都在推动AI达到新的高度。这些浪潮不仅在学术界掀起波澜,更在产业界激起涟漪,推动了创新的前行。

1. 模型架构的改进

自2010年代以来,人工智能模型架构的进步推动了重大突破和初创企业的创新。其中,2012年AlexNet的深度卷积神经网络工作,以及2017年Transformer模型的提出,彻底改变了自然语言处理领域。

- 2012年:《ImageNet Classification with Deep Convolutional Neural Networks》(Geoffrey Hinton 等)

- 论文链接:https://papers.nips.cc/paper_files/paper/2012/hash/c399862d3b9d6b76c8436e924a68c45b-Abstract.html

- 简介:这篇论文是深度学习领域的里程碑,展示了具有五个卷积层的深度卷积神经网络 (CNN) 在ImageNet数据集上的卓越表现,推动了GPU在深度学习中的应用。

2. 开发人员生产力的提升

过去十年,工具和框架取得了重大进步,显著提高了开发人员的工作效率,这对于初创企业的发展至关重要。里程碑包括2015年的TensorFlow和2018年的Hugging Face Transformers库。

- 2015年:《TensorFlow: A system for large-scale machine learning》(Martín Abadi 等)

- 论文链接:https://scholar.google.com/citations?view_op=view_citation&hl=en&user=NMS69lQAAAAJ&citation_for_view=NMS69lQAAAAJ:JqN3CTdJtl0C

- 简介:TensorFlow对机器学习开发人员的生产力产生了重大影响,简化了开发流程,使大规模模型的训练更加高效。

3. 任务表现的优化

过去十年中,几篇关键论文极大地提高了人工智能在执行复杂任务时的效率和多样性。无监督学习、联合学习、检索增强生成等技术的引入,使得模型在知识密集型任务中表现更为出色。

- 2017年:《Attention Is All You Need》(Ashish Vaswani 等)

- 论文链接:https://arxiv.org/abs/1706.03762

- 简介:Transformer架构的开山之作,彻底改变了序列传导模型的设计,推动了自然语言处理的革命。

4. 计算优化

新的优化技术如dropout和批量归一化,提高了模型的性能和稳定性。2020年的OpenAI论文则强调了计算资源的增加如何显著提升模型性能。

- 2020年:《Scaling Laws for Neural Language Models》(Jared Kaplan 等)

- 论文链接:https://arxiv.org/pdf/2001.08361

- 简介:本文探讨了模型大小、数据量、计算资源和性能之间的关系,为优化大型语言模型的训练资源分配提供了指导。

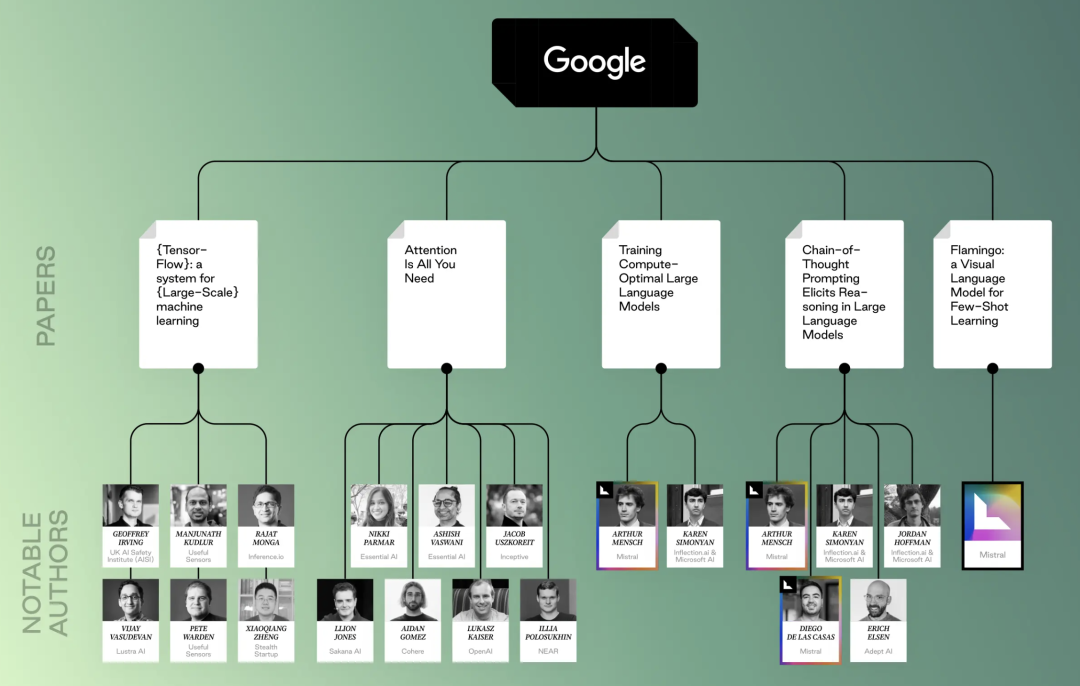

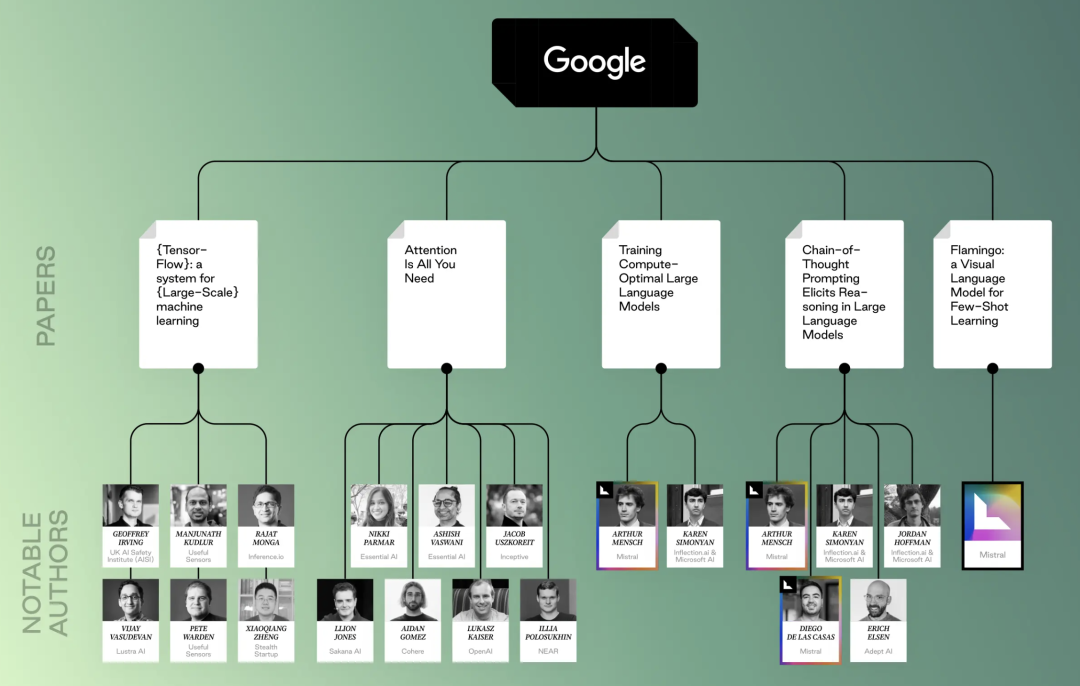

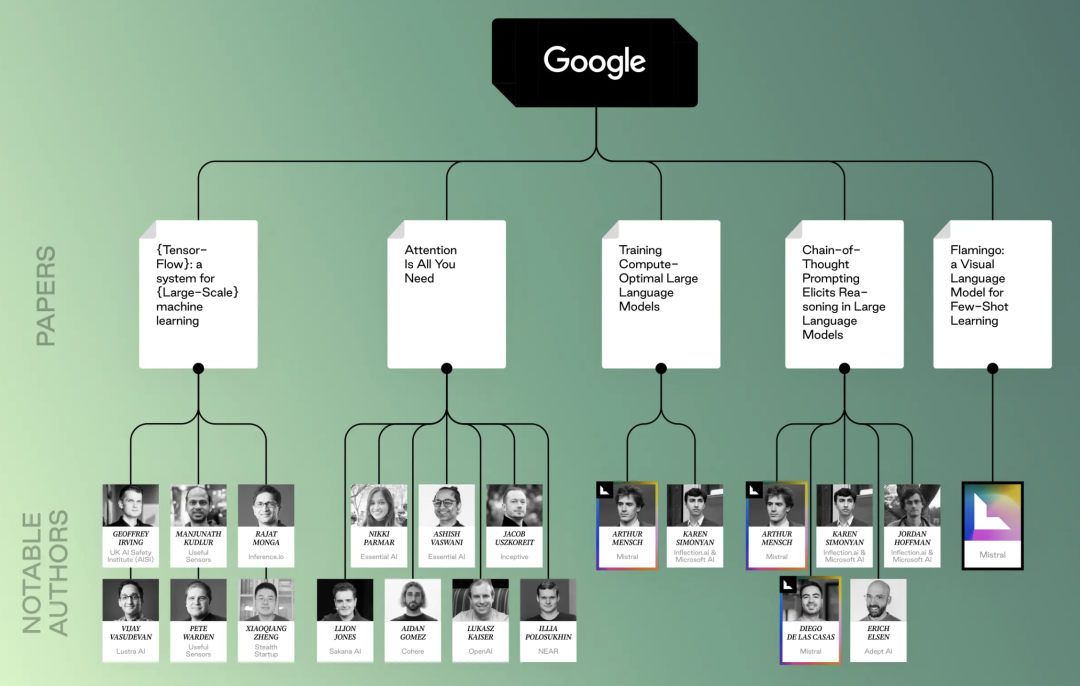

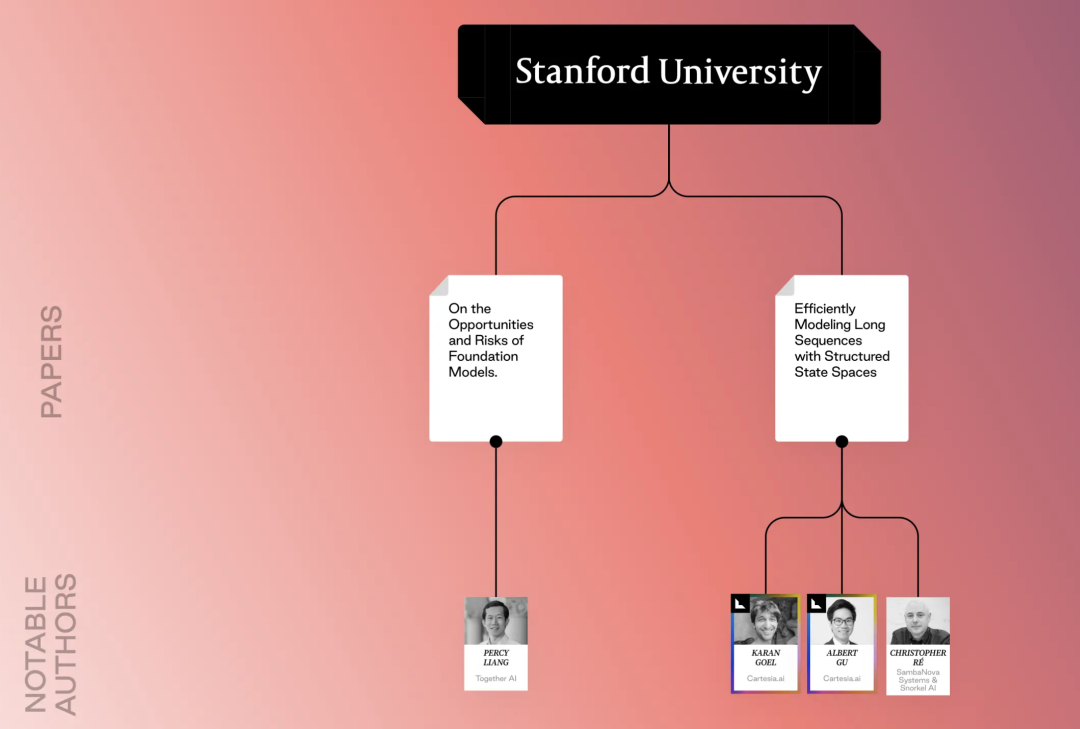

二、人工智能研究谱系 🧬

在理解这些研究时,分析其背后的研究谱系可以帮助我们更好地掌握AI的演进路径。以下是一些代表性机构的研究成果展示:

这些研究不仅代表了人工智能领域的学术前沿,还在商业应用中发挥了重要作用,成为推动技术进步的基石。

三、早期突破:奠定AI生态的基石 🏗️

这些早期的论文通过介绍已成为初创企业发展和后续研究基础的框架、模型和方法,为今天的AI生态系统奠定了坚实基础。以下是一些值得收藏的经典之作:

经典论文推荐

- 2012年:《ImageNet Classification with Deep Convolutional Neural Networks》(Geoffrey Hinton 等)

- 2016年:《Neural Machine Translation by Jointly Learning to Align and Translate》(Dzmitry Bahdanau 等)

- 2017年:《Attention Is All You Need》(Ashish Vaswani 等)

- 2019年:《Roberta: A robustly optimized bert pretraining approach》(Yinhan Liu 等)

这些论文的贡献不仅在学术界具有深远影响,也在实际应用中帮助AI技术快速落地。

四、最新进展:通向未来的AI 🌐

2020年以后,AI的研究速度加快,技术的应用更加广泛。以下是一些近年来的重要论文,这些研究为AI的进一步发展奠定了坚实的基础:

-

2020年:《Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks》(Patrick Lewis 等)

- 论文链接:https://arxiv.org/abs/2005.11401

- 简介:提出了RAG模型,通过结合检索和生成技术,显著提升了知识密集型任务的性能。

-

2022年:《Llama: Open and efficient foundation language models》(Hugo Touvron 等)

- 论文链接:https://scholar.google.com/citations?view_op=view_citation&hl=fr&user=tZGS6dIAAAAJ&citation_for_view=tZGS6dIAAAAJ:roLk4NBRz8UC

- 简介:Llama模型在各种NLP任务上实现了卓越的性能,并且极大地提高了训练效率。

五、经典论文解析:奠基AI未来的突破点 🛠️

在过去的十多年里,这些经典论文不仅为我们今天所享受的人工智能技术奠定了基础,更为未来AI的发展指明了方向。下面,我们详细解析几篇具有代表性的论文:

1. 2012年:《ImageNet Classification with Deep Convolutional Neural Networks》

- 作者:Geoffrey Hinton, Ilya Sutskever, Alex Krizhevsky

- 论文链接:https://papers.nips.cc/paper_files/paper/2012/hash/c399862d3b9d6b76c8436e924a68c45b-Abstract.html

- 简介:被誉为“深度学习时代的起点”,这篇论文介绍了AlexNet,一个由五个卷积层组成的深度神经网络,并在ImageNet竞赛中取得了前所未有的成功。它展示了深度卷积神经网络(CNN)在大规模图像识别中的强大能力,并开启了使用GPU进行深度学习训练的潮流。

2. 2015年:《TensorFlow: A system for large-scale machine learning》

- 作者:Martín Abadi 等

- 论文链接:https://scholar.google.com/citations?view_op=view_citation&hl=en&user=NMS69lQAAAAJ&citation_for_view=NMS69lQAAAAJ:JqN3CTdJtl0C

- 简介:TensorFlow是由Google开发的一个开源软件库,用于机器学习和深度学习应用。它使得开发人员可以定义机器学习模型而无需编写底层的数值计算代码,极大地提高了开发效率,并支持跨平台的部署。

3. 2017年:《Attention Is All You Need》

- 作者:Ashish Vaswani, Noam Shazeer, Niki Parmar, Jacob Uszkoreit, Llion Jones, Aidan Gomez, Lukasz Kaiser, Illia Polosukhin

- 论文链接:https://arxiv.org/abs/1706.03762

- 简介:提出了Transformer模型,这是第一个完全基于注意力机制的神经网络架构,不依赖于传统的卷积或循环神经网络。Transformer大幅提升了自然语言处理任务的效率和效果,并成为后续许多大型语言模型(如BERT和GPT)的基础。

4. 2019年:《Roberta: A robustly optimized bert pretraining approach》

- 作者:Yinhan Liu, Myle Ott, Naman Goyal, Jingfei Du, Mandar Joshi, Danqi Chen, Omer Levy, Mike Lewis, Luke Zettlemoyer, Veselin Stoyanov

- 论文链接:https://scholar.google.com/citations?view_op=view_citation&hl=en&user=dOad5HoAAAAJ&citation_for_view=dOad5HoAAAAJ:YsMSGLbcyi4C

- 简介:Roberta是对BERT模型的优化版本,通过增加训练时间、数据量和更好的超参数设置,Roberta在多项自然语言处理任务中显著提高了性能。这篇论文对语言模型的预训练方法提出了新的见解,并进一步巩固了BERT家族模型在NLP领域的主导地位。

5. 2020年:《Retrieval-Augmented Generation for Knowledge-Intensive NLP Tasks》

- 作者:Patrick Lewis, Ethan Perez, Aleksandra Piktus, Fabio Petroni, Vladimir Karpukhin, Naman Goyal, Heinrich Küttler, Mike Lewis, Wen-tau Yih, Tim Rocktäschel, Sebastian Riedel, Douwe Kiela

- 论文链接:https://arxiv.org/abs/2005.11401

- 简介:RAG模型结合了检索和生成模型的优势,解决了知识密集型NLP任务中的瓶颈问题。通过检索相关文档并生成高质量的文本,RAG模型在问答和文本生成等任务上表现出了卓越的性能。

六、展望未来:AI的无限可能 🚀

随着这些基础研究的不断深入和扩展,人工智能的未来充满了无限的可能。以下是近年来的一些重要突破,这些研究不仅展示了AI在特定领域中的卓越表现,更为跨领域的应用提供了基础:

1. 2022年:《Llama: Open and efficient foundation language models》

- 作者:Hugo Touvron, Thibaut Lavril, Gautier Izacard, Xavier Martinet, Marie-Anne Lachaux, Timothée Lacroix, Baptiste Rozière, Naman Goyal, Eric Hambro, Faisal Azhar, Aurelien Rodriguez, Armand Joulin, Edouard Grave

- 论文链接:https://scholar.google.com/citations?view_op=view_citation&hl=fr&user=tZGS6dIAAAAJ&citation_for_view=tZGS6dIAAAAJ:roLk4NBRz8UC

- 简介:Llama系列语言模型在保持高效性能的同时,减少了计算成本和资源需求。这一突破为更多中小型企业和研究机构进入AI领域提供了机会。

2. 2023年:《Multimodal Foundation Models: From Specialists to General-Purpose Assistants》

- 作者:Chenyu Wang, Weixin Luo, Qianyu Chen, Haonan Mai, Jindi Guo, Sixun Dong, Xiaohua (Michael) Xu, Chengxin Li, Lin Ma, Shenhua Gau

- 论文链接:https://arxiv.org/abs/2309.10020

- 简介:多模态基础模型能够同时处理视觉和语言任务,代表了AI从单一领域专家向通用助手的进化方向。这种多模态能力为开发能够处理复杂多样任务的智能系统奠定了基础。

3. 2024年:《Video Generation Models as World Simulators》

- 作者:Sora

- 论文链接:https://openai.com/index/video-generation-models-as-world-simulators/

- 简介:Sora的这篇论文探讨了视频生成模型作为世界模拟器的潜力,这种模型可以模拟真实世界中的场景变化,具有广泛的应用前景,包括虚拟现实、游戏开发和自动驾驶等领域。

这些最新的研究不仅为我们展示了AI的强大潜力,也为未来的技术进步提供了坚实的理论基础。无论是在基础研究还是在实际应用中,这些论文都将继续引领AI领域的创新潮流。

七、总结与展望 📚

回顾过去十几年的研究历程,我们可以看到AI技术从基础研究到实际应用的不断演进。这些里程碑式的论文不仅是科学研究的成果,更是商业应用的指南,为AI技术的快速发展奠定了坚实的基础。

展望未来,随着更多新技术和新方法的出现,AI将在各个领域实现颠覆性飞跃。从专注于单一任务的模型到多模态通用助手,AI的未来充满了无限可能。

关注猫头虎技术团队,持续获取AI领域的最新动态,和我们一起探索未来的科技之路!

更多推荐

已为社区贡献130条内容

已为社区贡献130条内容

所有评论(0)