简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

摘要:本文介绍了在信创环境下使用瀚高数据库的实践方法。作者详细演示了通过Docker安装瀚高数据库的全过程,包括镜像加载、容器启动和数据库创建。文章重点讲解了如何将瀚高数据库与Kettle工具集成,包括插件安装、驱动程序配置、转换设计等关键步骤,并展示了将瀚高数据库作为Kettle资源仓库的具体实现方法。该教程为Java开发者在国产数据库环境下的数据集成工作提供了实用指导。

摘要:Java小金刚分享使用PDI(Kettle)连接达梦数据库的经验。测试发现Kettle 9.2能正常连接达梦资源库,但9.4版本登录失败。通过使用DmJdbcDriver18.jar驱动和自研达梦插件,成功创建46张资源库表(关键数量)。特别提醒:Kettle 9.3版本存在兼容性问题,可能导致只生成25张表而无法使用。建议使用9.2/9.4/9.5版本,并注意插件配置细节(如资源库描述避免

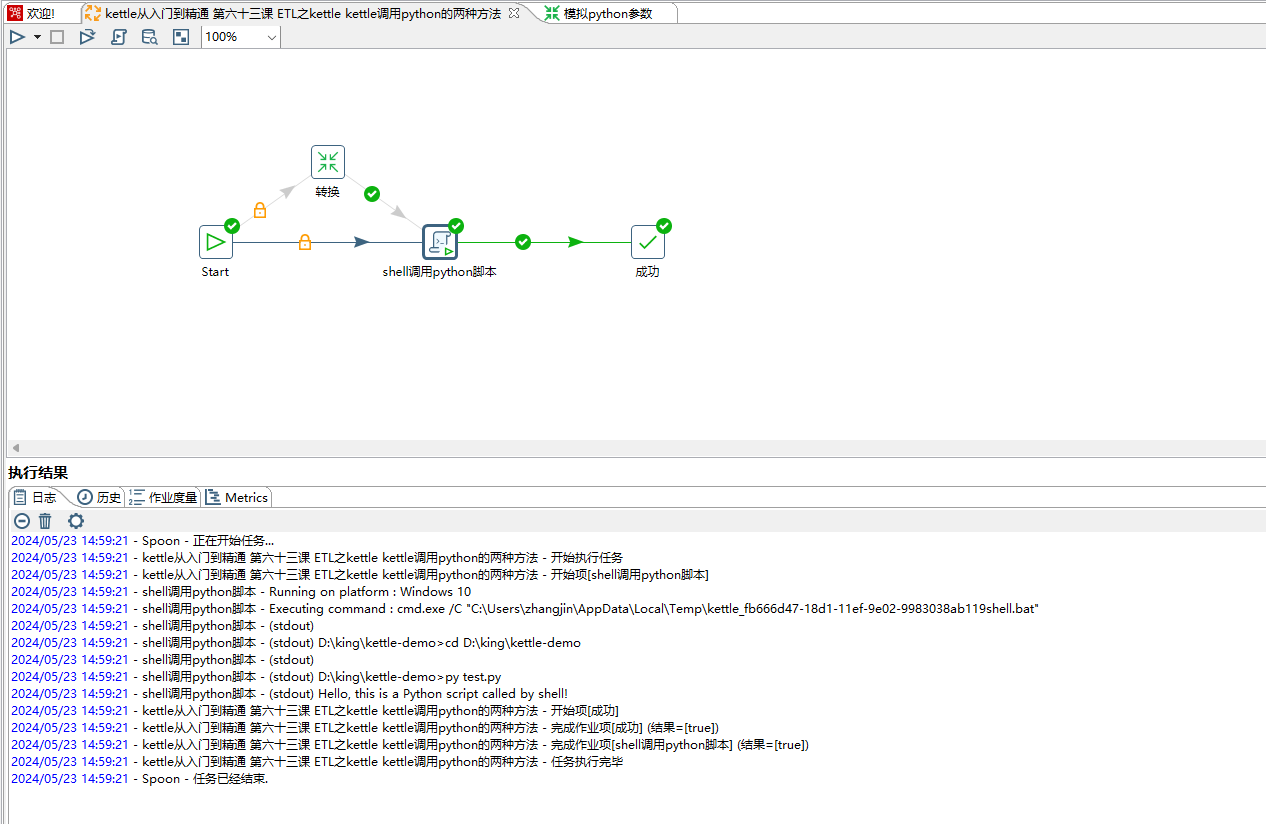

此处是将python脚本暴露http服务接口,然后在kettle中使用http步骤进行调用。这里不在详细介绍,可以参考之前的http调用文章。kettle中不能直接调用python脚本,可以通过shell脚本和http进行调用pyton服务。最下面的参数可以设置传递给python脚本参数,如设置V1参数。也可以上一步骤的结果作为参数传递给python脚本。# 在这里编写Python脚本的主要逻辑。

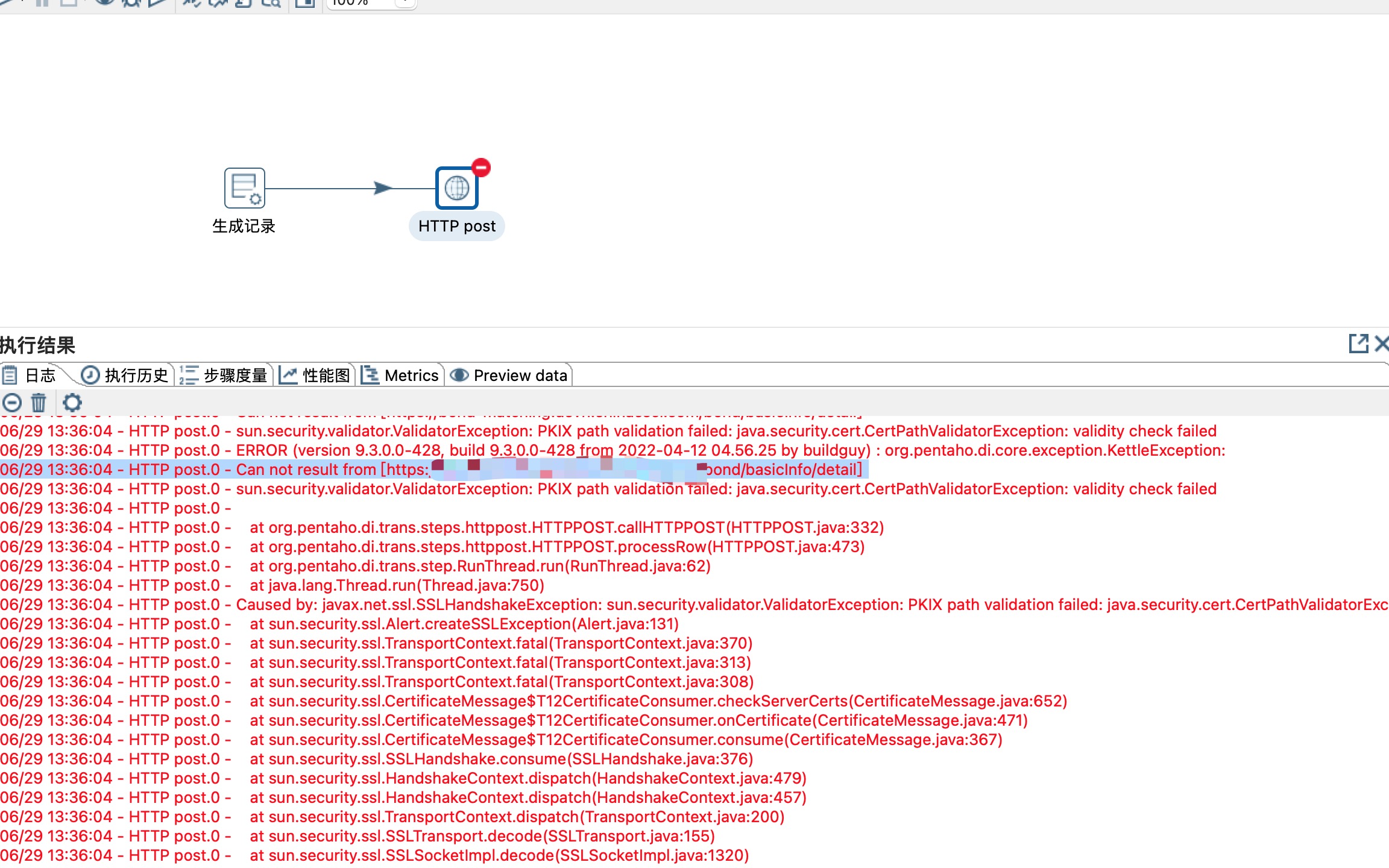

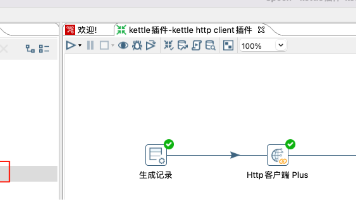

1、在使用kettle调用接口的时候不可避免要调用http或者https接口,调用http接口kettle可以正常工作,但是遇到https接口的时候kettle就会提示证书有误,无法正常调用接口,今天咱们一起通过自研插件的方式来解决这个问题。自研插件需要有一定的java基础,git上有比较多的例子,本次不讲解如何开发组件,这里介绍下如何使用自研http/htts插件的使用。resultField:

《Java小金刚分享WebSpoon部署方案》摘要:拥有10年互金行业经验的Java技术专家分享两种WebSpoon部署方案。1)Docker部署:提供现成镜像文件,解决网络下载问题,特别适合跨平台需求;2)Tomcat免配置版:预打包解决常见问题如汉化失败等,提供完整启动指南。作者指出WebSpoon9.0存在稳定性问题,建议优先使用Docker方式,并分享了MySQL8连接技巧及插件适配经验。

场景:kettle调用https接口,跳过校验SSL。(有些公司内部系统之间的https的接口是没有SSL校验这一说,无需使用用证书的)解决方案:自定义插件或者自定义jar包通过javascript调用https接口。//这里注意参数body如果是json字符串的话,这里自动转换为对象了,1)将自定义jar放到lib目录下。//索引这里要重新转换为字符串。

摘要:本文演示了使用自研kettle插件解决HTTPS接口调用问题。首先通过OpenSSL生成自签名证书,搭建Python Flask HTTPS服务;然后将kettle-httpclient-plugin插件放入Kettle目录,设计包含Http客户端Plus步骤的流程。调用HTTPS接口时遇到SSL证书验证错误,通过勾选useSSL选项成功绕过验证。该插件还支持二进制文件下载和重试功能,为Ke

摘要:本文演示了使用自研插件解决Kettle调用HTTPS POST接口时出现的SSL证书验证问题。通过OpenSSL生成自签名证书,使用Python搭建HTTPS测试接口。在Kettle中安装HttpPostPlus插件后,只需勾选useSSL选项即可成功绕过SSL验证调用接口,同时解决了中文乱码问题。该插件还支持二进制文件下载和重试等功能,完美解决了HTTPS接口调用中的常见问题。(148字)

2)中间是开发层,在开发阶段我们接触最多的就是通过spoon进行开发,通过Spoon.bat或者spoon.sh即可启动客户端,开发文件调试之前要先保存,开发阶段可以选择保存到本地,保存之后的文件后缀名有两种:转换文件后缀名是ktr,job文件后缀名是kjb。4)通过spoon研发好的kettle文件,部署到测试环境之后,可以通过命令行工具(pan/kitchen),或者通过Carte服务进行部署

kettle可以通过javascript代码调用外部jar。1、将外部jar放到lib目录下,重启spoon。static方法也可以采用new 方式进行调用。3、调用外部非static方法。2、调用外部static方法。